【ZSIMPWIN算法优化秘籍】:解锁最佳拟合的参数调整技巧

发布时间: 2024-12-15 12:29:06 阅读量: 5 订阅数: 6

电子商务之价格优化算法:遗传算法:遗传算法参数调整与优化实践.docx

参考资源链接:[ZSimpWin数据拟合教程:快速上手与操作详解](https://wenku.csdn.net/doc/1p6tib9bs7?spm=1055.2635.3001.10343)

# 1. ZSIMPWIN算法概述

在数据科学和机器学习领域,算法模型是核心工具,它们帮助我们从海量数据中提炼信息、发现规律并预测未来。ZSIMPWIN算法以其独特的特征与高效的性能,在特定应用场景中展现出卓越的潜力。本章旨在为您提供ZSIMPWIN算法的基础知识,简要介绍其起源、主要特点及其在行业中的应用概况。

## 1.1 ZSIMPWIN算法的起源与发展

ZSIMPWIN算法是近年来在优化理论领域中出现的一种新算法,它结合了统计学原理与计算智能,特别适用于处理大规模和非线性优化问题。它的名字ZSIMPWIN,是"Zero-Sum Imperfect Parallel Worlds Interference Network"的缩写,反映了算法在处理多变量干扰中的创新方法。

## 1.2 算法的核心优势与应用场景

ZSIMPWIN算法最显著的优势在于其快速收敛性和鲁棒性。由于它采用了一种新颖的参数更新策略,使得算法在面对高维和复杂数据集时依然能够高效运行。该算法已成功应用于金融模型预测、物联网数据分析和复杂网络优化等多个领域。

## 1.3 阅读本文的预期收获

通过本章的阅读,读者将对ZSIMPWIN算法有一个全面的理解,了解其背后的原理和它在解决现实世界问题中的潜力。后续章节将深入探讨算法的数学原理、实践应用以及优化技巧,使读者不仅能够掌握算法的使用,还能够进行适当的调整和优化,以满足特定需求。

# 2. 理解ZSIMPWIN算法的数学原理

## 2.1 算法的基础理论

### 2.1.1 参数估计的基本概念

在统计学和机器学习中,参数估计是指使用样本数据对总体分布的未知参数进行估计的过程。ZSIMPWIN算法依赖于精确的参数估计来构建数学模型,以预测和解释数据中的模式和趋势。这种方法在各种工程、金融和科学研究中都有广泛应用。参数估计通常分为点估计和区间估计两大类。点估计是指从样本数据中得出单一值来估计总体参数,而区间估计则是给出一个范围,该范围以一定的置信水平包含总体参数。

### 2.1.2 优化问题的数学模型

优化问题,特别是在ZSIMPWIN算法中,通常涉及寻找最佳参数集以最小化或最大化一个目标函数。目标函数,也称为代价函数或损失函数,在算法的上下文中衡量模型与数据之间的不一致程度。在数学上,优化问题可以形式化地表示为:

minimize f(x)

其中x是参数向量,f是目标函数,我们的目标是在可行的参数空间中找到一个x,使得f(x)尽可能小(对于最小化问题)。ZSIMPWIN算法通过迭代过程逐渐调整参数x,从而逼近目标函数的局部或全局最小值。

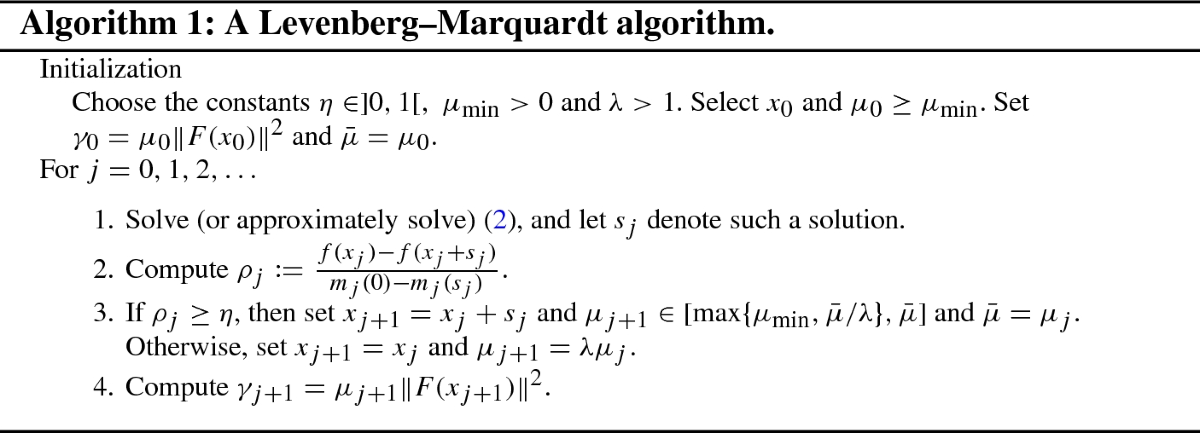

## 2.2 算法的关键步骤

### 2.2.1 初始化参数的策略

初始化参数是实现ZSIMPWIN算法的关键步骤之一。良好的参数初始化可以加速算法的收敛并提高最终解的质量。在实际操作中,初始化策略可以包括:

- 随机初始化:从一个预定义的分布中随机抽取参数值。

- 规则初始化:根据数据或问题特定的启发式规则设置初始参数值。

- 先验知识:利用已有的领域知识或先前的实验结果来确定参数初始值。

选择合适的初始化策略依赖于问题的性质和可用的信息。在某些情况下,可能需要结合多种策略以获得最优的初始化效果。

### 2.2.2 拟合过程中的目标函数

在算法执行过程中,目标函数扮演着指导参数更新的角色。ZSIMPWIN算法中的目标函数可能涉及多个变量和复杂结构,通常具有以下形式:

f(x) = Σ [真实数据点 - 模型预测点]^2 + 正则化项

其中Σ表示求和,正则化项用于防止过拟合。在拟合过程中,目标函数需要不断更新以反映最新的参数估计结果。通过最小化目标函数,算法可以逐步逼近最优解。

### 2.2.3 收敛判定和迭代更新机制

为了确保ZSIMPWIN算法的正确执行,必须有一个明确的收敛判定标准以及与之配套的迭代更新机制。收敛判定通常基于目标函数值或参数变化量的变化幅度。当这些值低于某个预设阈值时,算法可以停止迭代。迭代更新机制则详细描述了如何根据目标函数的梯度信息或其他启发式规则来更新参数值。

一般情况下,迭代更新可以表示为:

x_new = x_old - η * ∇f(x_old)

其中η是学习率,∇f(x_old)是目标函数在x_old处的梯度。学习率决定了参数更新的步长,而梯度则提供了更新的方向。通过恰当调整学习率和更新规则,可以显著影响算法的收敛速度和结果质量。

在下面的小节中,我们将通过数学公式和代码实现,进一步深入探讨初始化策略、目标函数的具体实例以及迭代更新的详细流程。这将为我们理解ZSIMPWIN算法的运作机制提供更清晰的视角。

# 3. ZSIMPWIN算法的实践应用

## 3.1 参数调整的实践经验

### 3.1.1 数据预处理技巧

在应用ZSIMPWIN算法之前,数据预处理是至关重要的一步。良好的数据预处理可以有效提高算法性能,减小误差,加快收敛速度。

- **数据清洗**:首先需要检查数据集中的缺失值、异常值,并进行合理的填充或删除。缺失值可能会扭曲算法的学习过程,而异常值可能会导致模型过拟合。

- **特征选择**:接下来是特征选择,保留与目标变量关系最紧密的特征,以减少数据维度并避免模型复杂度过高。

- **归一化处理**:不同的特征往往具有不同的量纲和数值范围,归一化(或标准化)这些特征可以防止数据分布对算法性能的影响。

- **数据增强**:根据需要,可能需要生成更多的数据样本来丰富数据集,这对于小数据集尤其重要。

```python

# 以Python为例,展示数据预处理的一个简单流程

import pandas as pd

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 加载数据

data = pd.read_csv('data.csv')

# 数据清洗

data = data.dropna() # 删除包含缺失值的行

# 特征选择

selected_features = ['feature1', 'feature2']

data = data[selected_featu

```

0

0