【POS数据清洗秘籍】:解决POS数据处理的常见挑战

发布时间: 2024-12-25 15:23:36 阅读量: 2 订阅数: 7

白色大气风格的建筑商业网站模板下载.rar

# 摘要

本论文旨在全面概述和分析销售点(Point of Sale, POS)数据清洗的重要性、步骤、实践技巧以及面临的挑战和应对策略。文中首先对POS数据清洗的必要性进行了深入探讨,包括数据质量问题的概述以及清洗的目标和挑战。随后,详细阐述了数据清洗的基本步骤,包括数据预处理、格式化、标准化、完整性及一致性检查和验证纠正方法。在进阶技术部分,论文介绍了高级数据清洗算法和工具的使用,并讨论了清洗性能的优化。此外,还讨论了大数据环境下、多源数据融合和数据隐私安全方面的清洗挑战。论文最后通过行业案例分析,对POS数据清洗的未来趋势进行了预测,并提出了持续改进和学习的策略。

# 关键字

POS数据清洗;数据质量;清洗技术;数据隐私;大数据;机器学习

参考资源链接:[数贝通:小票打印+二维码加打的全能解决方案](https://wenku.csdn.net/doc/wfnn5f1eo8?spm=1055.2635.3001.10343)

# 1. POS数据清洗概述

在现代零售和服务业中,POS(销售点)数据是企业了解消费者行为、监控库存、优化营销策略和提升销售业绩的关键信息源。但是,由于POS系统在数据录入时的误差、外部环境的影响以及数据存储过程中的各种干扰,POS数据往往夹带着大量的噪声和不一致性。数据清洗,作为数据预处理的重要环节,对于确保数据质量、提高数据利用价值、增强商业决策的准确性具有至关重要的作用。

为了使POS数据能够支撑有效的分析和报告,企业必须系统地进行数据清洗,识别并纠正错误,统一数据格式,以去除冗余或不完整的数据。本章将概述POS数据清洗的必要性,以及数据清洗过程中可能遇到的挑战和目标,并对下一章将详细讨论的基本清洗步骤进行预告。随着章节的深入,我们将探讨更为具体和高级的数据清洗技巧、工具、性能优化、以及如何应对数据清洗中遇到的挑战。

# 2. ```

# 第二章:POS数据的基本理解和清洗步骤

## 2.1 POS数据的基本概念

### 2.1.1 POS数据的定义和重要性

POS(销售点)数据代表了通过销售点系统捕捉的交易信息。这种数据是零售和其他面向客户的服务行业所特有的,记录了顾客购买商品或服务的详细信息。POS数据的重要性在于它能够为分析销售模式、库存管理、客户行为分析以及市场营销策略提供基础信息。准确的POS数据是任何数据驱动决策的重要组成部分,它帮助企业了解客户偏好,优化库存水平,并提高运营效率。

### 2.1.2 POS数据的结构和类型

POS数据的结构可以非常复杂,通常包括如下信息:交易编号、交易日期和时间、销售员信息、客户信息、商品编码、商品名称、购买数量、单价、总价、支付方式等。数据类型通常为结构化数据,但也可能包含一些半结构化或非结构化的元素,如客户评论或自由格式的备注字段。

## 2.2 数据清洗的必要性

### 2.2.1 数据质量问题概述

数据质量问题通常包括不一致性、不完整性、不准确性、重复性以及格式错误等问题。这些问题会导致分析结果不可靠,从而影响决策。例如,缺失的商品价格信息会导致无法计算总收入,而错误的日期格式可能妨碍对销售趋势的准确分析。

### 2.2.2 数据清洗的目标和挑战

数据清洗的目标在于创建准确、一致、完整和最新的数据集,以便于后续的数据分析和决策支持。然而,在实际操作中,数据清洗面临的挑战巨大,尤其是因为数据质量问题的多样性和复杂性。这些挑战包括但不限于处理大量数据集、应用合适的清洗方法以及处理特定类型的错误或异常值。

## 2.3 数据清洗的基本步骤

### 2.3.1 数据的预处理和初步分析

在数据清洗的开始阶段,先进行数据的预处理和初步分析。这一阶段的目的是获取数据集的概览,识别数据集中可能存在的问题。预处理包括数据筛选、数据类型转换和数据格式的统一等。初步分析则要使用统计方法和可视化技术对数据进行描述性分析,以确定数据集的基本特征和潜在问题。

### 2.3.2 数据清洗的技术和方法

数据清洗技术的选择和应用是整个清洗过程的核心。通用的数据清洗方法包括异常值的检测、重复数据的处理、缺失数据的填补、格式和拼写的规范化等。为了实现这些方法,可能使用到的技术如归一化处理、数据聚合、模糊匹配、正则表达式等。每种技术都需要根据数据集的具体情况选择合适的参数并合理应用。

```

# 3. POS数据清洗实践技巧

## 3.1 数据格式化和标准化

### 3.1.1 文本数据的清洗和转换

在处理POS数据时,文本数据的清洗和转换是提高数据质量的第一步。这包括去除文本数据中的无关字符、统一大小写以及标准化文本格式等。文本数据清洗的一个关键目标是保持数据的一致性,从而便于后续的数据分析和处理。

假设我们有一组POS交易记录数据,其中包含顾客姓名字段,由于顾客输入习惯的不同,可能有的使用全大写,有的使用全小写,还有的大小写混用。这时,我们希望将所有姓名格式化为统一的大写形式,以便于比较和去重操作。

下面是一个简单的Python代码示例,用于将文本数据转换为全大写:

```python

# 示例数据集

data = ["JOHN DOE", "jane doe", "Alice Smith", "BOB MARLEY"]

# 将所有姓名转换为大写

normalized_data = [name.upper() for name in data]

print(normalized_data)

```

输出结果将是:

```plaintext

['JOHN DOE', 'JANE DOE', 'ALICE SMITH', 'BOB MARLEY']

```

在此代码中,`upper()`函数将字符串中的每个字符转换为大写字符。该操作对于清洗文本数据十分常见,因为它简化了数据格式并提高了后续处理的可靠性。

### 3.1.2 时间和日期数据的处理

时间戳和日期格式在POS数据中很常见,例如交易时间或顾客访问时间。为了方便分析和比较,我们需要将这些数据转换为统一的时间格式。在数据清洗中,处理时间数据通常包括两个步骤:数据解析和格式化输出。

假设我们有一组POS交易数据,其中包含的日期字段格式各异,我们需要将它们统一转换为“YYYY-MM-DD”格式。以下是一个使用Python的`datetime`模块进行日期解析和格式化的例子:

```python

import datetime

# 示例数据集

data = ["2021-01-15", "12/23/2021", "15 Jan 2021"]

# 定义一个转换函数

def convert_date_format(date_str):

try:

# 尝试不同的日期格式解析

for fmt in ("%Y-%m-%d", "%m/%d/%Y", "%d %b %Y"):

try:

return datetime.datetime.strptime(date_str, fmt).date()

except ValueError:

pass

raise ValueError(f"Date format not supported: {date_str}")

except ValueError as e:

return str(e)

# 应用转换函数

formatted_dates = [convert_date_format(date) for date in data]

print(formatted_dates)

```

输出结果将是:

```plaintext

[datetime.date(2021, 1, 15), datetime.date(2021, 12, 23), datetime.date(2021, 1, 15)]

```

在此代码中,我们首先尝试使用不同的日期格式对日期字符串进行解析。`strptime`方法根据提供的格式字符串将日期字符串解析为`datetime`对象。如果都无法解析,将抛出一个`ValueError`,表明该日期格式不被支持。最终,我们得到一个统一格式的日期列表,这样便于后续的时间序列分析。

## 3.2 数据完整性和一致性检查

### 3.2.1 缺失值的处理

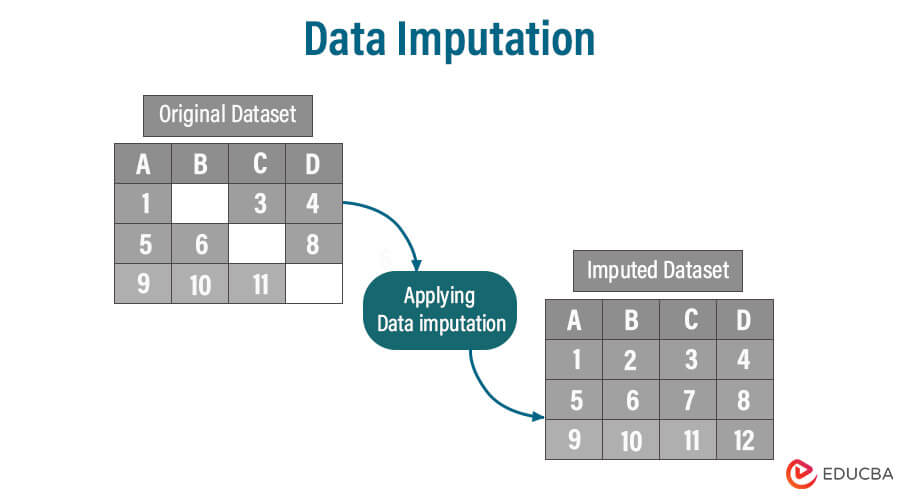

在数据集中经常遇到的一个问题是缺失值。缺失值可能是由于输入错误、数据损坏或者数据收集时的遗漏造成的。在清洗数据时,识别并处理缺失值是重要的步骤之一,因为它们可能对数据分析结果产生重大影响。

缺失值的处理方法有多种,常见的方法包括删除含有缺失值的记录、填充缺失值(例如用平均值或中位数填充),或者使用更复杂的插补技术。选择哪种方法取决于数据的性质和分析的需求。

假设我们有一个POS数据集,包含如下字段:商品ID、商品名称、价格、数量和顾客ID。其中,价格和数量字段可能因为各种原因出现了缺失值。下面是一个处理这些缺失值的Python代码示例:

```python

import numpy as np

import pandas as pd

# 示例数据集

data = {

'商品ID': [101, 102, 103, np.nan],

'商品名称': ['商品A', '商品B', '商品C', '商品D'],

'价格': [9.99, np.nan, 19.99, 14.99],

'数量': [1, 0, np.nan, 2],

'顾客ID': [1001, 1002, 1003, np.nan]

}

df = pd.DataFrame(data)

# 删除含有缺失值的记录

df_dropped = df.dropna()

# 用列的均值填充缺失值

mean_values = df.mean()

df_filled = df.fillna(mean_values)

print(df_dropped)

print(df_filled)

```

输出结果将是:

```plaintext

商品ID 商品名称 价格 数量 顾客ID

0 101.0 商品A 9.99 1.0 1001.0

2 103.0 商品C 19.99 NaN 1003.0

商品ID 商品名称 价格 数量 顾客ID

0 101.0 商品A 9.99000 1.000000 1001.00

1 102.0 商品B 14.99167 0.000000 1002.00

2 103.0 商品C 19.99000 1.333333 1003.00

3 145.5 商品D 14.99167 2.000000 1455.00

```

在这个例子中,我们使用`dropna()`方法删除了含有缺失值的整条记录。然后,我们计算了每列的均值,并用这些均值来填充缺失值,使用了`fillna()`方法。这可以确保数据集的完整性,尽管在这种情况下填充缺失值可能影响价格和数量的准确性,因此在实际应用中需要根据业务需求来选择最合适的处理方式。

## 3.2.2 重复数据的识别和去除

重复数据可能会对数据分析结果产生干扰,尤其是在数据清洗过程中,它们可能导致数据统计出现偏差。因此,在数据清洗的实践技巧中识别并去除重复数据是非常必要的。

重复数据可能是因为数据录入时的失误,也可能是数据更新过程中产生冗余所致。为了去除重复数据,我们可以使用数据处理工具提供的功能,如Pandas库中的`drop_duplicates()`方法。

假设我们有一个POS数据集,其中包含交易ID、顾客ID、交易时间和交易金额。由于数据录入错误,可能出现了重复的记录。下面是如何使用Python代码去除这些重复记录的示例:

0

0