高效数据库查询的秘密:SQLAlchemy查询构建器实用技巧

发布时间: 2024-10-09 23:16:15 阅读量: 96 订阅数: 37

Python数据库操作:SQLAlchemy教程

# 1. SQLAlchemy查询构建器入门

SQLAlchemy是Python编程语言中最流行的ORM(对象关系映射)库之一。它的目标是提供一个完整的工具集来处理关系数据库。在本章中,我们将介绍如何使用SQLAlchemy的查询构建器来执行数据库操作。首先,我们从安装和配置数据库连接开始,然后逐步介绍如何构建简单的查询,以及如何使用ORM进行数据模型定义。

## 1.1 安装SQLAlchemy

安装SQLAlchemy相对简单,推荐使用pip包管理器安装:

```shell

pip install sqlalchemy

```

一旦安装完成,我们就可以开始探索SQLAlchemy的查询构建器功能了。

## 1.2 创建基本查询

构建一个查询通常从创建一个`Session`对象开始,然后使用该会话对象来访问数据库:

```python

from sqlalchemy import create_engine, MetaData, Table, select

# 创建数据库引擎

engine = create_engine('sqlite:///example.db')

# 创建会话

metadata = MetaData()

my_table = Table('my_table', metadata, autoload_with=engine)

session = engine.connect()

# 使用select来创建查询

query = select([my_table])

result = session.execute(query)

# 遍历结果

for row in result:

print(row)

```

以上代码展示了如何连接数据库、创建会话,以及构建并执行一个基本的查询来检索数据。

在接下来的章节,我们将深入学习SQLAlchemy的ORM模型,并探讨如何用它来定义复杂的数据库结构和关系。这将为深入理解和使用SQLAlchemy奠定基础。

# 2. 深入理解SQLAlchemy的ORM模型

### 2.1 ORM模型基本概念

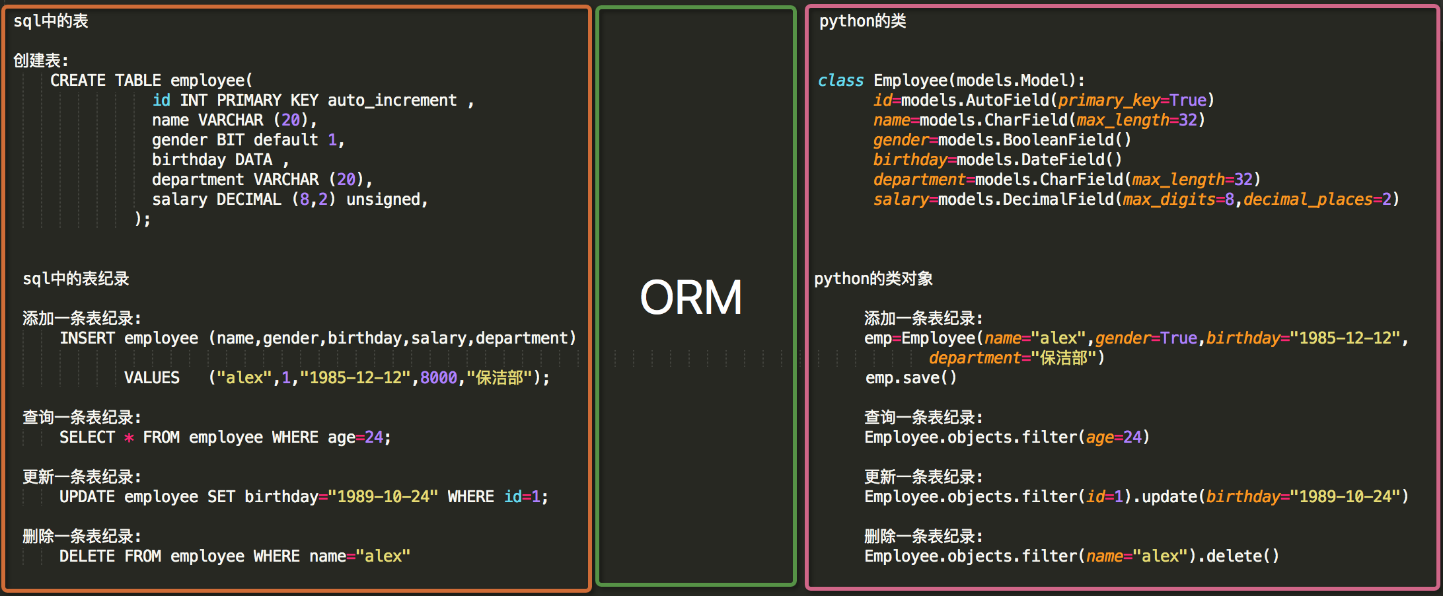

#### 2.1.1 ORM与原生SQL的区别

在传统的数据库操作中,开发人员通常需要手动编写SQL语句来执行数据的增删改查操作,这不仅繁琐而且容易出错。ORM(Object-Relational Mapping)技术提供了一种方式,通过映射关系让数据库中的表与程序中的对象对应起来,从而通过操作对象来间接操作数据库。这在很大程度上提高了开发效率,降低了出错的概率。

使用SQLAlchemy这样的ORM框架,可以极大地简化数据库交互代码。相比于原生SQL,ORM的主要优点包括:

- **抽象层次高**:不再需要编写具体的SQL语句,而是通过编程语言的语法进行数据库操作。

- **类型安全**:代码中直接使用的是类和对象,数据类型的问题在编译时就能够被捕捉,而不需要等到运行时。

- **代码复用性增强**:对象和关系映射减少了冗余代码的编写,便于维护和扩展。

- **数据库独立性**:同一套ORM代码可以在不同的数据库之间迁移使用,而原生SQL代码的可移植性较差。

不过,ORM的性能通常不如直接编写原生SQL,尤其是在复杂查询和大数据量操作时。此外,对于一些特定的数据库操作,可能还是需要编写原生SQL来满足需求。

#### 2.1.2 ORM模型的生命周期

ORM模型的生命周期开始于定义一个模型类,并通过SQLAlchemy映射到数据库的表结构。以下是ORM模型的典型生命周期:

1. **类定义**:定义一个Python类,并使用SQLAlchemy的声明式基类或Mapper API来映射到数据库的表。

2. **对象状态管理**:创建对象实例后,这些实例将处于不同的状态,如“干净”(没有修改过)、“脏”(已修改过)或者“删除”(待删除)。

3. **会话管理**:将对象实例添加到Session中,通过Session来管理对象的生命周期。Session负责追踪所有实例的状态,并在提交时将变更持久化到数据库。

4. **数据操作**:通过会话执行各种操作,如添加、修改或删除对象。

5. **事务处理**:提交会话时,将同步对象状态到数据库,并且可以进行事务处理,包括回滚和提交。

6. **生命周期结束**:当会话关闭时,所有待处理的更改都会被写入数据库,或者当对象不再需要时从会话中删除。

理解ORM模型的生命周期对于编写高效、稳定的ORM代码至关重要。能够更好地管理资源,避免内存泄漏等问题。

### 2.2 定义ORM模型和表关系

#### 2.2.1 创建模型类

创建模型类是构建ORM模型的基础。在SQLAlchemy中,我们使用`declarative_base`来创建一个基类,然后继承这个基类来定义模型。

```python

from sqlalchemy.ext.declarative import declarative_base

from sqlalchemy import Column, Integer, String

Base = declarative_base()

class User(Base):

__tablename__ = 'users'

id = Column(Integer, primary_key=True)

name = Column(String)

fullname = Column(String)

nickname = Column(String)

def __repr__(self):

return "<User(name='%s', fullname='%s', nickname='%s')>" % (self.name, self.fullname, self.nickname)

```

以上代码定义了一个`User`模型类,它映射到了`users`表,并包含了四个字段。`__tablename__`属性指定了映射的数据库表名,`Column`定义了列的类型。

#### 2.2.2 指定表间关系和约束

关系映射是ORM框架中的重要功能,它能够表达表与表之间的关系,如一对多、多对一、一对一等。SQLAlchemy提供了多种方式来定义这些关系。

```python

class Address(Base):

__tablename__ = 'addresses'

id = Column(Integer, primary_key=True)

email_address = Column(String, nullable=False)

user_id = Column(Integer, ForeignKey('users.id'))

user = relationship("User", back_populates="addresses")

User.addresses = relationship("Address", order_by=Address.id, back_populates="user")

```

在这个例子中,我们定义了一个`Address`模型类,并且通过`ForeignKey`指定了与`User`表的关系。`relationship`函数创建了从`User`到`Address`的关系。`back_populates`参数允许反向查询,通过`user.addresses`可以获取到一个用户的所有地址。

### 2.3 模型查询和会话管理

#### 2.3.1 会话的创建与管理

会话管理是ORM模型中非常关键的一环,它负责追踪实例的状态,并将更改同步到数据库。SQLAlchemy使用`sessionmaker`创建会话工厂,通过会话工厂来管理会话的生命周期。

```python

from sqlalchemy.orm import sessionmaker

from sqlalchemy import create_engine

engine = create_engine('sqlite:///mydatabase.db')

Session = sessionmaker(bind=engine)

session = Session()

```

这段代码首先创建了一个SQLAlchemy引擎,并用`sessionmaker`创建了一个会话工厂。然后,可以通过这个工厂来创建具体的会话对象。

#### 2.3.2 模型查询基础操作

SQLAlchemy的查询操作非常灵活,能够处理各种数据库操作需求。创建会话后,就可以使用会话对象来查询数据库了。

```python

# 查询所有用户

users = session.query(User).all()

# 查询特定用户

specific_user = session.query(User).filter_by(name='John Doe').first()

# 添加用户

new_user = User(name='John Doe', fullname='John Doe', nickname='jdoe')

session.add(new_user)

# 删除用户

user_to_delete = session.query(User).get(1)

session.delete(user_to_delete)

# 提交更改

***mit()

```

以上展示了基本的查询和数据操作方法,其中`filter_by`用于筛选满足特定条件的数据,`get`用于获取具有特定主键的单个对象。通过会话的`commit`方法,可以将所做的更改持久化到数据库。

通过本章节的介绍,我们已经了解了SQLAlchemy的ORM模型的基本概念和表关系的定义方法,同时掌握了如何创建会话以及进行基本的模型查询和数据操作。这些知识点是使用SQLAlchemy进行数据库交互的基础,也是深入学习ORM框架的重要起点。在接下来的章节中,我们将继续探索更高级的查询构建技巧,以及如何通过SQLAlchemy优化查询性能。

# 3. SQLAlchemy查询构建技巧

## 3.1 基本查询操作

### 3.1.1 条件查询

在SQLAlchemy中,条件查询是最基本的查询方式之一。它允许用户通过特定的条件来过滤结果集。这个过程类似于在原生SQL语句中使用`WHERE`子句。我们可以通过构建一个会话对象,然后调用`query()`方法开始构建查询。之后,我们可以利用过滤器(filter)和过滤条件(filter_by)来添加具体的查询条件。

```python

from sqlalchemy import create_engine, MetaData, Table, select, and_, or_

from sqlalchemy.orm import sessionmaker

# 创建数据库引擎和会话

engine = create_engine('sqlite:///example.db')

Session = sessionmaker(bind=engine)

session = Session()

# 定义查询条件

condition = and_(User.name == 'Alice', User.age > 30)

# 执行查询

query_result = session.query(User).filter(condition).all()

# 遍历查询结果

for user in query_result:

print(user.name, user.age)

```

在上面的代码中,`and_`函数用于构建多条件组合,而`filter()`方法则是将条件应用到查询上。这种方式与直接写SQL语句的`WHERE`子句相似,但更加安全,因为SQLAlchemy会自动处理SQL注入问题。

### 3.1.2 排序和分组

除了条件过滤外,SQLAlchemy也支持对查询结果进行排序和分组。排序可以通过`order_by`方法实现,而分组则可以通过`group_by`方法实现。在处理复杂的数据分析时,这两种操作尤为重要。

```python

# 排序操作

sorted_results = session.query(User).order_by(User.age.desc()).all()

# 分组操作

from sqlalchemy.sql import func

grouped_results = session.query(

User.department,

func.count('*').label('num_employees')

).group_by(User.department).all()

```

在这个例子中,`order_by(User.age.desc())`表示按照年龄降序排列查询结果。`group_by`结合了聚合函数`func.count`来计算每个部门的员工数量。

## 3.2 复杂查询构造

### 3.2.1 联合查询与子查询

SQLAlchemy支持通过联合查询和子查询来组合多张表的数据。联合查询可以使用`join`方法来实现,它允许在两个表之间根据某个条件连接。子查询则通常用`subquery`方法来创建,它可以构建复杂的查询逻辑,并嵌入到另一个查询中。

```python

# 联合查询示例

join_query = session.query(Address, User).join(User).filter(User.name == 'Alice').all()

# 子查询示例

from sqlalchemy import exists

subq = session.query(User.id).filter(User.age > 18)

main_query = session.query(User).filter(exists(subq))

```

上面的联合查询代码中,`join(User)`方法将用户表和地址表通过用户表连接起来,根据条件过滤出特定用户的信息。子查询示例中,我们构建了一个子查询`subq`来找出所有年龄大于18岁的用户ID,然后在主查询`main_query`中使用`exists`来过滤出符合条件的用户。

### 3.2.2 多表连接操作

多表连接是复杂查询中不可或缺的一部分。SQLAlchemy提供了`outerjoin`方法来实现外连接,当需要处理可能不匹配的记录时这一点非常有用。

```python

# 外连接查询示例

outer_join_query = session.query(User, Address).outerjoin(Address, User.address_id == Address.id).all()

```

在这个例子中,`outerjoin`方法将用户表和地址表连接起来,并包括了那些没有地址的用户记录。这种方式在处理一对多关系时非常有效。

## 3.3 性能优化和查询缓存

### 3.3.1 查询缓存的使用

在处理大量数据时,查询缓存可以显著提高性能。SQLAlchemy允许使用特定的缓存策略,比如声明式缓存和查询缓存,来优化性能。声明式缓存是通过定义缓存区域来实现的,而查询缓存则是基于单个查询级别的。

```python

from sqlalchemy import cache

# 声明式缓存示例

@cache区域('my_cache')

class User(Base):

# 类定义

# 查询缓存示例

query_result = session.query(User).filter(User.name == 'Alice').options(

load_only(User.name)

).all()

```

在这段代码中,使用了声明式缓存装饰器`cache`来标记某个类定义(例如User类),以便将其实例的查询结果缓存起来。查询缓存则是通过`options`方法应用到单个查询上。

### 3.3.2 性能监控与调优

性能监控是确保应用性能的关键步骤,SQLAlchemy提供了一些工具和方法来帮助开发者进行性能监控和调优。其中,最常用的就是日志记录和性能分析工具。

```python

from sqlalchemy import create_engine

from sqlalchemy.engine import logging

# 开启日志记录

engine = create_engine('sqlite:///example.db')

logger = logging.getLogger('sqlalchemy.engine')

logger.setLevel(***)

# 使用SQLAlchemy的性能分析工具

from sqlalchemy import event

from sqlalchemy.engine import Engine

@event.listens_for(Engine, "before_cursor_execute")

def before_cursor_execute(conn, cursor, statement, parameters, context, executemany):

print("SQL: {}".format(statement))

# 在会话中执行查询并观察输出

session = Session()

session.query(User).all()

```

通过监听器`event.listens_for`,我们可以在执行SQL语句之前打印出来,这对于性能监控和调试非常有用。对于性能调优,开发者需要对慢查询进行分析,并可能需要对索引进行优化,或者重构查询逻辑。

以上是SQLAlchemy查询构建技巧的详细介绍,每个技巧都包含了基础操作、复杂查询构建、性能优化和缓存等核心知识,从浅入深地引导读者逐步掌握SQLAlchemy的查询构建方法,并强调了在实际应用中性能监控和调优的重要性。

# 4. SQLAlchemy进阶实战技巧

## 4.1 构建动态查询

### 4.1.1 表达式语言和函数构建器

SQLAlchemy 的表达式语言(Expression Language)是其核心特性之一,它允许开发者编写可读性强的查询语句,而不必直接编写SQL字符串。这种语言不仅支持简单的查询构建,还能够处理复杂的查询,如嵌套查询、条件组合、聚合操作等。构建器模式(Builder pattern)在SQLAlchemy中得到广泛应用,允许开发者通过链式调用构建查询。

动态查询的构建通常依赖于条件表达式,我们可以根据不同的业务需求动态地添加查询条件。SQLAlchemy的函数构建器提供了一系列的SQL函数来帮助我们实现这一点,例如`func.lower()`、`func.count()`等。

**示例代码**:

```python

from sqlalchemy import func

session.query(func.count(User.id)).filter(User.age > 18).all()

```

**代码解释**:

上述代码展示了如何使用SQLAlchemy的函数构建器来执行一个统计成年人数的查询。我们首先从`sqlalchemy`模块中导入`func`,这允许我们访问SQL函数。然后,我们通过`session.query()`方法创建查询,并在其中调用`func.count()`来指定我们想要对`User.id`字段进行计数。最后,我们使用`filter()`方法添加了一个过滤条件,仅计算年龄大于18岁的用户数量。

### 4.1.2 事件监听和动态查询构建

除了基本的查询构建外,SQLAlchemy还提供了事件监听机制,允许开发者在特定的生命周期事件发生时执行自定义逻辑。对于动态查询构建来说,这可以是一个非常有用的特性,因为它允许我们根据运行时的条件或者事件来修改查询。

事件监听主要通过`sqlalchemy.event`模块来实现,我们可以使用`listen_for()`装饰器来监听类级别的事件,或者使用`event.listens_for()`函数来监听实例级别的事件。

**示例代码**:

```python

from sqlalchemy import event

from sqlalchemy.orm import Session

from myapp.models import User

@event.listens_for(Session, 'before_commit')

def before_commit(session):

# 在事务提交前检查是否有未成年用户

未成年用户数量 = session.query(User.id).filter(User.age < 18).count()

if 未成年用户数量 > 0:

raise Exception('存在未成年用户,不能提交事务')

# 使用会话

session = Session()

try:

# ... 执行数据库操作

***mit()

except Exception as e:

print(e)

```

**代码解释**:

在这个例子中,我们使用了`event.listens_for()`来监听`Session`对象的`before_commit`事件。每当事务提交之前,都会执行`before_commit`函数。在该函数内部,我们进行了一次动态查询来检查数据库中是否存在未成年用户。如果存在,则抛出异常来阻止事务提交。

## 4.2 扩展SQLAlchemy功能

### 4.2.1 插件和扩展的添加

SQLAlchemy本身提供了一套强大的数据映射和数据库操作工具,但在实际应用中,我们可能需要额外的插件或扩展来满足特定的需求。SQLAlchemy的设计允许以模块化的方式添加插件和扩展,这使得框架可以适应各种不同的应用场景。

插件和扩展可以通过多种方式添加到SQLAlchemy项目中,如直接集成到代码库中、使用PyPI安装第三方包,或编写自定义代码来实现特定功能。

**示例代码**:

```python

# 安装第三方扩展Flask-SQLAlchemy

pip install Flask-SQLAlchemy

# Flask应用配置

from flask import Flask

from flask_sqlalchemy import SQLAlchemy

app = Flask(__name__)

app.config['SQLALCHEMY_DATABASE_URI'] = 'sqlite:///example.db'

db = SQLAlchemy(app)

# 定义模型

class User(db.Model):

id = db.Column(db.Integer, primary_key=True)

name = db.Column(db.String(50), nullable=False)

```

**代码解释**:

上例展示了如何将Flask-SQLAlchemy插件添加到Flask应用中。首先,我们通过pip安装Flask-SQLAlchemy模块。然后,在Flask应用配置中,我们创建了一个`SQLAlchemy`实例,并将其绑定到Flask应用。这样,我们就可以在Flask应用中使用SQLAlchemy的ORM功能了。

### 4.2.2 自定义操作和表达式

SQLAlchemy允许开发者创建自定义的数据库操作和表达式。这在处理特定数据库函数或需要在查询中插入特定逻辑时尤为有用。自定义表达式通过继承`sqlalchemy.sql.expression.ColumnElement`类或使用`***piler`编译器插件来实现。

自定义表达式的创建,往往涉及到`expression`模块中的`text()`函数。我们可以使用这个函数来插入原始的SQL语句片段。

**示例代码**:

```python

from sqlalchemy.sql.expression import text

class UpperText(text):

type = String()

@compiles(UpperText, 'sqlite')

def compile_upper_text(element, compiler, **kw):

return "UPPER({})".format(compiler.process(element.clauses[0]))

# 使用自定义表达式

session.query(UpperText('SELECT mycol FROM mytab')).all()

```

**代码解释**:

上述示例中,我们首先定义了一个`UpperText`表达式类,它继承自`text`,并指定了返回的列类型。然后,我们使用`@compiles`装饰器来定义如何将该表达式编译成适用于SQLite数据库的SQL。这个自定义表达式在查询时可以像其他SQLAlchemy表达式一样使用。

## 4.3 实际案例分析

### 4.3.1 复杂数据库交互案例

在实际开发中,我们经常遇到需要同时操作多个表、执行复杂的查询逻辑或实现特定的业务规则的情况。SQLAlchemy的灵活性使其成为处理这些复杂交互的理想选择。下面,我们将分析一个涉及到多表连接和复杂业务逻辑的案例。

假设我们有一个电商平台的数据库模型,它包含用户、订单和产品三个表。我们的任务是找出那些在特定时间段内购买了特定产品类别的所有用户的ID。

**示例代码**:

```python

# 假设已经定义了User, Order, Product模型并且建立了关联

from sqlalchemy import and_

users_with_purchases = (

session.query(User.id)

.join(Order)

.join(Product)

.filter(

and_(

Product.category == 'Electronics',

Order.date >= '2023-01-01',

Order.date <= '2023-01-31'

)

)

.distinct()

).all()

```

**代码解释**:

在这段代码中,我们使用了SQLAlchemy的`join()`方法来连接`User`, `Order`, `Product`模型。通过链式调用`filter()`方法,我们添加了多个查询条件,用来筛选特定时间段内购买了特定产品类别的订单。使用`distinct()`是为了避免查询结果中出现重复的用户ID。这段代码展示了SQLAlchemy在处理复杂数据库交互时的强大能力。

### 4.3.2 性能优化案例研究

性能优化是数据库操作中的一个重要方面,尤其是在处理大量数据或实时查询时。SQLAlchemy提供了许多工具来帮助开发者优化查询性能,例如查询缓存、懒加载、索引优化等。

下面我们将分析一个性能优化的案例,其中涉及到一个基于用户行为的数据分析查询。

**示例代码**:

```python

# 假设我们有一个行为表Action,记录了用户的点击、购买等行为

from sqlalchemy import func

# 添加索引来加快查询速度

session.execute(text("CREATE INDEX action_user_id_idx ON Action(user_id)"))

# 查询所有最近一周内点击次数超过5次的用户

recent_actions = (

session.query(

Action.user_id,

func.count(Action.user_id).label('click_count')

)

.filter(Action.date >= (now() - timedelta(days=7)))

.group_by(Action.user_id)

.having(func.count(Action.user_id) > 5)

.all()

)

```

**代码解释**:

在这个例子中,我们首先通过原生SQL创建了一个索引,这是性能优化的一个重要步骤,特别是当涉及到大量的group by和聚合操作时。然后,我们使用SQLAlchemy的查询API来构建一个查询,找出最近一周内点击次数超过5次的用户。通过在`filter`和`having`中添加适当的条件,我们确保查询的高效执行。

通过这个案例,我们可以看到SQLAlchemy如何通过结合高级查询功能和底层优化技术,来提高查询性能并满足复杂的业务需求。

# 5. 最佳实践和常见问题解决

随着数据库的复杂性增加,数据迁移和问题排查变得至关重要。本章节将深入探讨数据库迁移的最佳实践,以及如何诊断和解决常见的数据库性能问题。

## 5.1 数据库迁移和版本控制

在应用程序的发展过程中,数据库架构也需要随之变化。有效的数据库迁移能够确保数据的完整性,同时降低系统升级时的风险。

### 5.1.1 数据库模式的迁移

数据库模式的迁移包括添加或删除列、索引、表以及修改数据类型等。SQLAlchemy利用迁移工具,如Alembic,可以创建一个可追踪迁移历史的版本控制环境。

以下是一个使用Alembic进行数据库迁移的简单例子:

```python

# Alembic迁移脚本示例

"""添加新列到用户表"""

from alembic import op

import sqlalchemy as sa

# revision标识号,确保每次迁移都是唯一的

revision = '***ab'

down_revision = 'abcdef123456'

branch_labels = None

depends_on = None

def upgrade():

# 添加新列

op.add_column('users', sa.Column('age', sa.Integer))

def downgrade():

# 移除新列

op.drop_column('users', 'age')

```

使用Alembic时,需要配置好数据库连接并初始化环境:

```shell

alembic init alembic

alembic revision --autogenerate -m "添加年龄字段"

alembic upgrade head

```

### 5.1.2 Alembic工具的使用

Alembic 工具不仅能够追踪迁移历史,还能生成迁移脚本,并将其应用到数据库。它与SQLAlchemy紧密集成,可以自动检测模型的变化,并生成相应的迁移脚本。

执行迁移时,重要的是要保证迁移脚本的正确性和对业务逻辑的影响最小化。例如,修改表结构前要确保相关业务逻辑已经处理好兼容性问题。

## 5.2 常见问题和解决方案

在使用SQLAlchemy进行数据库操作时,开发者经常会遇到各种问题,了解并掌握这些问题的解决方法对于提高开发效率和维护性至关重要。

### 5.2.1 查询构建常见错误排查

查询构建时的一个常见错误是忘记添加必要的过滤条件,这可能会导致返回大量不期望的数据。排查这类问题通常涉及到检查SQL语句的生成逻辑和参数绑定。

```python

# 查询构建示例

from sqlalchemy import create_engine, Table, MetaData, select

engine = create_engine('sqlite:///example.db')

metadata = MetaData(bind=engine)

users = Table('users', metadata, autoload=True)

# 漏掉过滤条件

query = select([users]).where(users.c.name == 'John Doe')

results = connection.execute(query).fetchall()

# 正确的过滤条件

query_correct = select([users]).where(users.c.name == 'John Doe' and users.c.age > 30)

results_correct = connection.execute(query_correct).fetchall()

```

在上面的示例中,缺少了重要的`age > 30`条件,这会导致获取到所有名为'John Doe'的用户记录,而不是我们期望的限制条件下的记录。

### 5.2.2 性能问题的诊断与解决

数据库性能问题可能来源于多个方面,如索引不当、查询计划不佳或硬件资源限制。使用SQLAlchemy时,通常利用其内置的日志记录和性能分析工具来诊断问题。

```python

from sqlalchemy import exc

from sqlalchemy.engine import logging

# 开启SQLAlchemy的SQL日志记录

logger = logging.getLogger('sqlalchemy.engine')

logger.setLevel(***)

handler = logging.StreamHandler()

logger.addHandler(handler)

# 模拟一个性能不佳的查询

try:

with engine.connect() as conn:

result = conn.execute(select([users]).where(users.c.name == 'John Doe'))

for row in result:

print(row)

except exc.SQLAlchemyError as e:

print(f"发生错误:{e}")

```

通过以上代码,我们可以看到SQLAlchemy内部执行的SQL语句及其性能信息。

## 5.3 总结和展望

### 5.3.1 技巧汇总和最佳实践

在开发过程中,最佳实践是确保数据库操作稳定、高效和可维护的关键。在本章节中,我们详细探讨了数据库迁移和版本控制的技巧,以及常见问题的排查和解决方法。

### 5.3.2 SQLAlchemy的未来趋势

随着大数据和云计算的发展,SQLAlchemy将会不断演进以适应新的数据库架构和运行环境。开发者将需要掌握更多先进的数据处理技术来充分利用SQLAlchemy提供的强大功能。

通过本章节内容的学习,我们希望你能够具备诊断和优化SQLAlchemy数据库操作的能力,并且在未来的开发实践中应用所学的最佳实践。

0

0