奇异值分解(SVD):机器学习性能提升的关键步骤解析

发布时间: 2025-02-03 02:22:59 阅读量: 27 订阅数: 17

# 摘要

奇异值分解(SVD)作为线性代数中强大的工具,被广泛应用于机器学习、数据压缩、推荐系统和自然语言处理等众多领域。本文首先概述了SVD的基本概念和数学原理,包括其线性代数背景、几何解释以及与特征值分解的联系。接着,深入探讨了SVD在机器学习中的具体应用,如数据降维、推荐系统构建和文本处理。此外,本文还提供了一些SVD实践中的算法选择、性能优化策略和实战案例分析。最后,文章展望了SVD在高维数据分析中的应用和与其他技术的融合,以及未来发展的潜在方向。

# 关键字

奇异值分解(SVD);数据降维;推荐系统;自然语言处理;算法优化;高维数据分析

参考资源链接:[同济大学数学科学学院工程数学线性代数PPT资料](https://wenku.csdn.net/doc/2vc0wzbapz?spm=1055.2635.3001.10343)

# 1. 奇异值分解(SVD)概述

奇异值分解(SVD)是线性代数中一种重要的矩阵分解技术,它在数据分析、机器学习、信号处理等领域扮演着核心角色。SVD可以将任何复杂的矩阵拆分为三个简单的矩阵乘积形式,揭示了数据内在的结构特征。通过分解,SVD不仅简化了问题,还强化了对数据特征的理解,因此它被广泛应用于各种数据处理场景。在本章中,我们将简要介绍SVD的基本概念和它在多个领域的应用前景。

# 2. SVD的数学原理与理论基础

### 2.1 SVD的线性代数背景

在深入探讨奇异值分解(SVD)的应用之前,理解其数学原理和理论基础是至关重要的。本章将从线性代数的角度展开,介绍SVD的核心概念。

#### 2.1.1 向量空间和基的变换

在数学中,一个向量空间是由向量构成的集合,这些向量遵循特定的运算法则。在SVD的上下文中,向量空间通常是由数据矩阵的行或列形成的。当进行基变换时,实质上是在换一种方式来表示这些数据,而这些表示方式可以揭示数据的不同结构特征。

假设我们有矩阵A,其代表的数据点在某原始空间中。使用SVD,我们可以找到一组新的基向量,这组基向量可以更好地描述数据的变异,或者说是数据的特征。这一过程可以看作是将原始空间中的数据映射到一个重新排序和可能降维的新空间中。

#### 2.1.2 矩阵的奇异值分解定义

数学上,对于任意一个m×n的矩阵A,其SVD定义为:

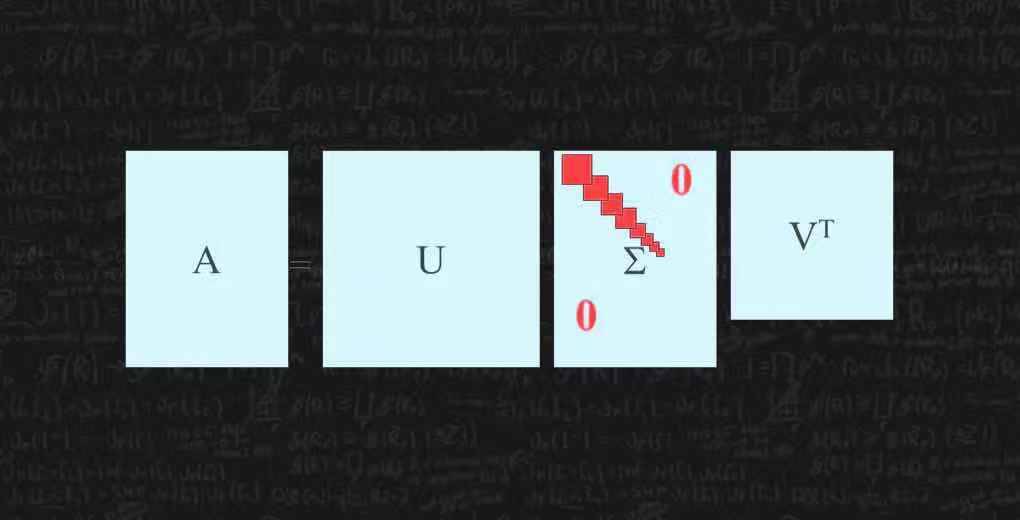

\[ A = U\Sigma V^T \]

其中,U和V是正交矩阵(即 \( U^TU = V^TV = I \)),它们的列向量被称作左奇异向量和右奇异向量。而Σ是主对角线上元素为非负实数的对角矩阵,这些对角线元素被称作奇异值,通常按照从大到小的顺序排列。SVD的几何意义可以理解为在多维空间中,通过旋转和缩放对数据进行重构的过程。

### 2.2 SVD的几何解释

奇异值分解不仅仅是矩阵的一种数学操作,它还对应于一系列的几何变换,这些变换对于理解数据的内在结构非常有帮助。

#### 2.2.1 奇异值与数据的空间特性

每个奇异值表示了数据矩阵在对应方向上的“长度”或“尺度”。最大的奇异值对应于数据变化最大的方向,而最小的奇异值则对应于数据变化最小的方向。在几何上,奇异值的大小描述了数据在相应方向上的“拉伸”程度。

在实际应用中,这种性质可以被用来识别和解释数据中的主要模式,例如,在图像压缩应用中,我们可以删除那些较小的奇异值,从而减少数据的信息量,同时尽量保留图像的关键特征。

#### 2.2.2 奇异向量的角色和意义

奇异向量提供了数据在各个方向上的基。右奇异向量(V中的列向量)揭示了原始数据空间的基向量,而左奇异向量(U中的列向量)则揭示了经过A变换后数据空间的基向量。

这些基向量可以帮助我们理解数据的结构,例如,在数据降维的应用中,右奇异向量可用于确定新的特征空间,而左奇异向量则描述了新特征空间中的数据点。

### 2.3 SVD与特征值分解的关系

SVD与特征值分解在矩阵分析中都有着非常重要的地位,二者之间有着紧密的联系。

#### 2.3.1 特征值与奇异值的关系

虽然SVD和特征值分解有着不同的数学形式和应用,但它们之间存在某些相似之处。特别地,如果一个方阵(例如\(A^TA\)或\(AA^T\))是正定的,那么它将有与SVD中相同的奇异值,但对应的特征向量与SVD的左右奇异向量不同。

#### 2.3.2 特征向量与奇异向量的对比

特征向量描述了矩阵在特定方向上的延伸或压缩情况,而奇异向量描述的是矩阵作用下数据空间的基变换。特征向量通常用于描述线性变换的局部属性,而奇异向量则提供了一个全局视角,描述了矩阵整体作用的结果。

总结来说,特征值分解侧重于方阵的内在特性分析,而SVD侧重于描述矩阵对整个空间的变换效果。

以上内容我们详细探讨了奇异值分解(SVD)的数学原理和理论基础。在下一章中,我们将进一步了解SVD在机器学习中的具体应用,以及如何利用SVD进行数据降维、构建推荐系统和处理自然语言数据。

# 3. SVD在机器学习中的应用

SVD在机器学习领域拥有广泛的应用,从数据预处理到推荐系统,再到自然语言处理,无一不彰显其重要性。本章节将深入探讨SVD在机器学习中如何发挥其独特作用,并通过实例分析来展示其应用价值。

## 3.1 数据降维和压缩

### 3.1.1 主成分分析(PCA)与SVD

主成分分析(PCA)是数据降维的一种常用方法,而SVD在PCA的实现过程中起着关键作用。通过SVD,可以有效地找到数据的主成分,即数据中的最大方差方向。这可以通过将数据矩阵分解为三个矩阵的乘积来完成,即 UΣV^T,其中Σ是对角矩阵,包含了数据方差的大小,即奇异值。

在实际操作中,可以通过以下步骤来实现PCA:

1. 对数据矩阵进行中心化处理。

2. 计算中心化后数据的协方差矩阵。

3. 应用SVD分解协方差矩阵得到U, Σ, V。

4. 根据需要保留的主成分数量,选择Σ中的前k个最大的奇异值,并构建新的矩阵Σ_k。

5. 将Σ_k与U和V的对应部分相乘,得到降维后的数据。

### 3.1.2 用SVD进行数据压缩的策略

在数据压缩中,SVD可以帮助去除噪声和冗余信息,保留最重要的特征。SVD基于的是数据内部的结构和变化,奇异值的大小代表了数据在对应奇异向量方向上的变化程度。因此,删除一些较小的奇异值并不会丢失太多重要的信息。

具体的数据压缩策略如下:

1. 对原始数据矩阵执行SVD分解,得到U, Σ, V。

2. 根据数据压缩比例来设定一个阈值,仅保留Σ矩阵中大于该阈值的奇异值。

3. 构建新的Σ'矩阵,仅包含选定的奇异值。

4. 通过U和V的对应部分与Σ'相乘,得到压缩后的数据。

5. 为了重构原始数据,可以将压缩后的矩阵与V和U的转置矩阵相乘。

这种策略可以显著降低数据的存储需求和处理时间,同时尽可

0

0