【R语言sf包全能攻略】:5大技巧提升空间数据分析效率

发布时间: 2024-11-09 14:03:28 阅读量: 228 订阅数: 26

使用R语言提取村庄年均气候和地形数据(包含详细的完整的程序和数据)

# 1. R语言sf包简介与安装

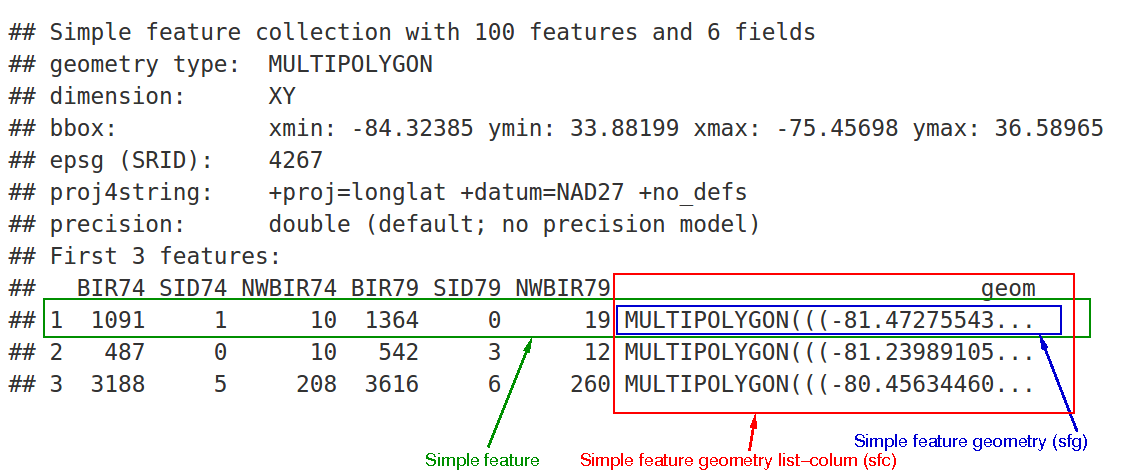

## 1.1 R语言sf包概述

`sf`(Simple Features)包是R语言中用于处理地理空间数据的最新标准。它提供了一系列用于创建、操作、查询和可视化地理空间矢量数据的功能,极大地简化了传统地理空间分析流程。`sf`与R语言的其它包如`dplyr`和`ggplot2`等无缝集成,使得地理空间数据处理更加高效和直观。

## 1.2 安装sf包

在R语言环境中安装`sf`包非常简单,可以通过以下命令进行安装:

```r

install.packages("sf")

```

安装完成后,可以通过`library(sf)`来加载包。安装前建议检查R环境是否支持C++11标准,因为`sf`包在编译时需要此支持。此外,为了更好地处理地理空间数据,通常还会需要安装如`rgdal`、`rgeos`等其它空间数据处理包。

## 1.3 sf包功能概览

`sf`包主要提供以下几大功能类别:

- 读取和写入多种格式的空间数据。

- 空间数据的属性和几何操作。

- 空间关系的计算(如距离、包含、相邻等)。

- 可视化空间数据,与`ggplot2`结合使用非常强大。

- 提供与PostGIS等数据库的连接能力。

在后续章节中,我们将逐一详细讲解如何使用sf包处理空间数据,包括数据的读取、操作、分析与可视化等。

# 2. 空间数据读取与处理

空间数据是地理信息系统(GIS)和空间分析的基础,正确地读取与处理这些数据对于进一步的分析至关重要。本章节将详细介绍如何使用R语言中的sf包来读取和处理空间数据,包括数据的读取、基础操作、数据清洗和准备工作。

## 2.1 空间数据的读取

### 2.1.1 从常见格式加载空间数据

空间数据通常以特定的格式存储,如Shapefile、GeoJSON、KML等。sf包提供了多种函数来读取这些常见格式的数据。在sf包中,`st_read()`函数可以读取多种格式的空间数据。

```r

library(sf)

data_path <- system.file("shape/nc.shp", package="sf")

nc <- st_read(data_path)

```

上述代码读取了sf包内置的北卡罗来纳州的Shapefile格式数据。`system.file()`函数用于获取包内数据的路径,`st_read()`函数则执行了数据的读取操作。

### 2.1.2 数据格式转换与集成

在处理复杂的空间数据时,可能需要将不同格式的数据整合在一起。sf包提供了一系列转换函数,例如`st_as_sf()`和`st_as_text()`,用于在不同空间数据格式之间转换。

```r

# 将普通数据框转换为sf对象

df <- data.frame(x = 1:3, y = c(4,5,4))

geometry <- st.points(matrix(c(1,4, 2,5, 3,4), ncol = 2))

geo_df <- st_as_sf(df, geometry = geometry)

# 将sf对象转换为文本格式

text_representation <- st_as_text(geo_df)

```

`st_as_sf()`函数将普通的R数据框(data.frame)转换成sf对象,同时接受一个几何类型(geometry)作为参数。`st_as_text()`函数将sf对象转换为文本格式,便于查看和进一步处理。

## 2.2 空间数据的基本操作

### 2.2.1 空间数据的查看与验证

加载空间数据后,第一步是查看和验证数据。sf包提供了`st_layers()`、`st几何类型()`和`st_dimensions()`等函数来查看数据的层、几何类型和维度信息。

```r

# 查看数据的各层信息

st_layers(data_path)

# 查看数据的几何类型

st_geometry_type(nc)

# 查看数据的维度信息

st_dimensions(nc)

```

这些函数帮助用户理解数据的结构和内容,为后续的数据处理打下基础。

### 2.2.2 空间数据的子集化和过滤

在空间数据集过于庞大时,通常需要进行子集化和过滤。sf包的`st_subset()`和`st_filter()`函数可用于这些目的。

```r

# 根据条件子集化数据

subset_data <- st_subset(nc, AREA > 0.1)

# 根据其他空间对象过滤数据

buffer_data <- st_filter(nc, st_buffer(subset_data, dist = 0.1))

```

`st_subset()`函数根据非空间的条件对数据进行子集化,而`st_filter()`函数则根据空间关系进行过滤。

### 2.2.3 空间数据的坐标系统转换

空间数据的坐标系统(CRS)是影响分析准确性的重要因素。sf包的`st_crs()`函数用于获取和设置空间数据的坐标系统。

```r

# 获取数据的CRS

nc_crs <- st_crs(nc)

# 转换数据的CRS到WGS84

nc_wgs84 <- st_transform(nc, crs = 4326)

```

`st_crs()`函数既可以用来查看数据的CRS信息,也可以用来设置新的CRS。`st_transform()`函数则用于执行CRS转换。

## 2.3 空间数据的清洗与准备

### 2.3.1 缺失值和异常值处理

在空间数据集中,可能包含缺失值和异常值,需要进行清洗。sf包与R语言其他数据处理工具配合使用,可以有效地处理这些问题。

```r

# 查找并处理缺失值

nc[is.na(nc)] <- median(nc, na.rm = TRUE)

# 查找并处理异常值

outliers <- boxplot.stats(nc$AREA)$out

nc_no_outliers <- nc[nc$AREA %in% outliers, ]

nc[nc$AREA %in% outliers, ] <- median(nc$AREA, na.rm = TRUE)

```

这些代码演示了如何使用R语言的基础函数来处理空间数据集中的缺失值和异常值。

### 2.3.2 空间数据的投影和标准化

空间数据的标准化,尤其是投影转换,对于确保不同数据集间的一致性和兼容性至关重要。sf包的`st_transform()`函数可以轻松实现这一点。

```r

# 将数据投影到统一的坐标系统

nc统一投影 <- st_transform(nc, crs = "+proj=longlat +datum=WGS84")

```

`st_transform()`函数实现了空间数据从当前坐标系统到目标坐标系统的转换,这里使用了WGS84坐标系统。

以上便是关于空间数据读取与处理的详细内容,接下来将介绍如何对空间数据进行可视化,以及在可视化过程中的各种技巧和方法。

# 3. 空间数据可视化技巧

空间数据可视化是地理信息系统(GIS)中的一个重要组成部分,它允许我们以直观的方式理解数据的分布和模式。在这一章节中,我们将深入探讨如何使用R语言的`sf`包进行空间数据可视化,包括基础地图绘制、高级可视化技术以及交互式空间数据展示的技巧。

## 3.1 基础地图绘制

基础地图绘制为探索性数据分析提供了直观的起点。在本小节中,我们将学习如何使用`sf`包绘制地图,并添加标签和图例。

### 3.1.1 图层绘制与色彩填充

绘制空间数据的首要步骤是将数据转换为`sf`对象。接下来,我们将使用`ggplot2`包中的`geom_sf`函数来绘制这些数据。例如,绘制一个简单的州界地图。

```r

library(sf)

library(ggplot2)

# 读取空间数据

states <- st_read("path/to/state_boundaries.shp")

# 绘制地图

ggplot(data = states) +

geom_sf(fill = "white", color = "black")

```

在此代码中,`geom_sf`函数用于绘制`sf`对象。`fill`参数设置了图层填充颜色,而`color`参数设置了边界线颜色。这只是一个基础例子,实践中可以根据需要调整填充颜色、边界线粗细等属性。

### 3.1.2 标签与图例的添加

为了增加地图的信息含量,我们通常需要添加标签和图例。标签可以帮助我们识别地图上的特定区域或点,而图例则解释了不同颜色或符号代表的含义。

```r

ggplot(data = states) +

geom_sf(aes(fill = NAME)) + # 使用NAME字段作为填充

scale_fill_viridis_d() + # 使用Viridis色彩方案

geom_sf_label(aes(label = NAME)) + # 添加标签

labs(fill = "State Name") # 添加图例标题

```

在上述代码中,`aes`函数用于映射`sf`对象中的字段到图形属性。`scale_fill_viridis_d`函数添加了一个预设的色彩方案,而`geom_sf_label`则用于添加标签。`labs`函数用于添加或修改图例标题。

## 3.2 高级可视化技术

基础地图绘制往往不足以展现数据的复杂性。本小节将探讨使用高级可视化技术来提升数据表达的层次。

### 3.2.1 地图的分层和颜色渐变

在某些情况下,我们需要在同一地图上展示多个图层,或者使用颜色渐变来表示数据的连续性。`geom_sf`函数可以处理多个`sf`对象,并且`scale_fill_gradient`函数允许我们创建颜色渐变效果。

```r

# 假设我们有一个表示人口密度的sf对象

population_density <- st_read("path/to/population_density.shp")

# 绘制基础地图和人口密度图层

ggplot() +

geom_sf(data = states) +

geom_sf(data = population_density, aes(fill = density)) +

scale_fill_gradient(low = "blue", high = "red")

```

在这段代码中,`population_density`是我们要展示的第二个图层,其中`density`字段被映射到颜色渐变。低值和高值使用了蓝色和红色来表示。

### 3.2.2 空间关联的可视化方法

在空间数据分析中,可视化空间关联性是非常重要的。这可以通过符号大小、颜色深浅或图层的半透明度来实现。例如,我们可以使用点的大小来表示某地区的人口数量。

```r

# 假设我们有一个表示城市人口的sf对象

cities <- st_read("path/to/cities.shp")

# 绘制城市位置,并根据人口大小调整点的大小

ggplot() +

geom_sf(data = states) +

geom_sf(data = cities, aes(size = population)) +

scale_size_continuous(name = "Population") +

theme_minimal()

```

在此代码中,`aes(size = population)`将城市大小映射到人口数量上,`scale_size_continuous`用于调整点的大小范围,以便更好地展示不同城市间的人口差异。

## 3.3 交互式空间数据展示

随着web技术和交互式界面的普及,交互式地图变得越来越受欢迎。本小节将介绍如何创建交互式地图,并探讨其在空间数据分析中的应用。

### 3.3.1 交互式地图的创建与应用

`plotly`包提供了将静态`ggplot2`图形转换为交互式图形的功能。这允许用户通过鼠标悬停、缩放等交互方式来探索数据。

```r

library(plotly)

# 创建ggplot2图形对象

g <- ggplot(data = states) +

geom_sf(aes(fill = NAME), color = NA) +

scale_fill_viridis_d()

# 使用plotly包创建交互式图形

ggplotly(g)

```

在这里,`ggplotly`函数将`ggplot2`对象`g`转换为一个交互式图形。用户可以通过多种交互手段来获取更多信息,从而有助于深入分析。

### 3.3.2 动态数据展示技巧

动态展示数据是交互式可视化的一个高级特性,例如,利用`gganimate`包实现时间序列的空间数据动画。

```r

library(gganimate)

# 假设我们有一个随时间变化的城市人口sf对象

cities_time <- st_read("path/to/cities_time.shp")

# 创建一个动态的动画图层

ggplot(cities_time) +

geom_sf(aes(size = population)) +

scale_size_continuous(name = "Population") +

theme_minimal() +

transition_time(time) +

labs(title = "Time: {frame_time}")

```

在这段代码中,`transition_time`函数将时间字段映射到动画过渡,而`labs`函数用于在图形中添加动态标题。

## 表格:颜色渐变映射示例

| 数据范围 | 颜色低值 | 颜色高值 |

| -------------- | -------- | -------- |

| 人口密度低 | 蓝色 | 绿色 |

| 人口密度中等 | 黄色 | 橙色 |

| 人口密度高 | 红色 | 紫色 |

## 流程图:创建交互式地图流程

```mermaid

graph LR

A[开始] --> B[创建ggplot2地图图形]

B --> C[使用ggplotly转换为交互式图形]

C --> D[增强交互性]

D --> E[结束]

```

在本章节的介绍中,我们介绍了`sf`包在空间数据可视化方面的多种技巧和方法。接下来,我们将继续探讨空间数据分析的核心技巧,以及如何将这些技巧应用于实际问题的解决过程中。

# 4. 空间数据分析核心技巧

在深入探讨R语言sf包如何应用于复杂的空间数据分析之前,首先需要对空间关系的计算与分析有一个清晰的理解。这些核心技巧包括空间邻接关系的识别、空间权重矩阵的构建,以及空间统计方法如空间自相关分析和空间回归模型等。此外,真实案例的应用以及从数据探索到结果解释的全流程展示,对理解sf包在空间数据分析中的实际作用至关重要。

## 4.1 空间关系的计算与分析

空间数据的本质在于它涉及物体之间的空间关系。在分析空间数据时,一个关键步骤是识别这些空间关系并据此进行计算。

### 4.1.1 空间邻接关系的识别

空间邻接关系描述了两个地理特征是否相邻,这对于理解空间分布模式至关重要。sf包提供了函数来判断多边形对象之间的邻接关系。

```r

# 加载sf包和必要数据

library(sf)

data("us_states", package = "spData")

# 创建一个空间邻接矩阵

nb <- st_networks(us_states)$nb

adj_matrix <- as(nb, "dgCMatrix")

# 查看邻接矩阵的部分内容

print(adj_matrix[1:5, 1:5])

```

上述代码首先加载了sf包和美国各州数据集,接着使用`st_networks`函数和邻接列表创建了一个空间邻接矩阵,并将其转换成稀疏矩阵格式以方便查看。

### 4.1.2 空间权重矩阵的构建

空间权重矩阵是用于空间自相关分析的关键组成部分。sf包可以方便地从地理对象生成空间权重矩阵,其中每个元素通常包含距离或邻接信息。

```r

# 构建空间权重矩阵

w <- st_weights(nb)

print(w[1:5, 1:5])

```

`st_weights`函数根据邻接列表生成空间权重矩阵,此矩阵可以用于进一步的空间统计分析。

## 4.2 空间统计方法

空间统计方法是空间数据分析的核心,它考虑了地理位置的相互影响。

### 4.2.1 空间自相关分析

空间自相关分析可以揭示空间分布的模式,例如是否存在聚集、离散或随机分布。sf包支持多种空间自相关度量方法,如莫兰指数(Moran's I)和吉尔伯特指数(Getis-Ord Gi*)。

```r

# 使用莫兰指数进行空间自相关分析

moran_result <- st_moran(usa_states, listw = w)

print(moran_result)

```

`st_moran`函数接受地理对象和空间权重矩阵作为输入,并返回莫兰指数的计算结果。

### 4.2.2 空间回归模型

空间回归模型能够在模型中纳入空间关系,从而提供对空间数据更为准确的分析。sf包与spatialreg包结合使用,可以轻松实现空间回归分析。

```r

# 进行空间滞后模型分析

lag_model <- lagsarlm(formula, data = usa_states, listw = w)

summary(lag_model)

```

上述代码展示了如何利用`lagsarlm`函数构建一个空间滞后模型,其中`formula`是你的回归模型公式,`data`是数据集,`listw`是空间权重矩阵。

## 4.3 空间数据分析案例

通过实际案例分析,我们可以进一步理解sf包在空间数据分析中的应用。

### 4.3.1 空间数据分析的真实案例应用

真实案例可以展示sf包如何用于空间数据的处理、分析和解释。案例可以是疾病分布的地理分析、交通流量的空间建模等。

```r

# 加载案例数据

case_data <- read.csv("path_to_case_data.csv")

case_data_sf <- st_as_sf(case_data, coords = c("long", "lat"), crs = 4326)

# 分析步骤

# 1. 空间数据读取

# 2. 数据清洗与预处理

# 3. 空间关系计算与分析

# 4. 空间统计方法应用

# 5. 结果解释与可视化展示

```

在该案例中,我们首先读取了案例数据,然后使用`st_as_sf`函数将其转换为sf对象。随后,我们按照前文介绍的步骤进行了分析。

### 4.3.2 从数据探索到结果解释的全流程

为了全面理解空间数据分析的整个流程,我们需要对案例数据从初步探索到最终结果解释进行详细说明。这将包括数据的可视化探索、空间关系的计算、统计方法的应用以及结果的解释。

```mermaid

graph LR

A[数据探索] --> B[数据预处理]

B --> C[空间关系计算]

C --> D[统计方法应用]

D --> E[结果解释]

E --> F[可视化展示]

```

通过流程图,我们可以清晰地看到从数据探索到可视化展示的整个步骤。每个步骤都紧密相连,构成了空间数据分析的完整链条。

以上内容涵盖了空间数据分析的核心技巧,包括了空间关系的计算与分析、空间统计方法的应用,以及如何将这些技巧应用到实际案例中。通过实际案例的全流程分析,我们可以更好地理解sf包在空间数据处理和分析中的强大功能。

# 5. sf包在各领域的应用示例

在本章节中,我们将探讨sf包在不同领域中的实际应用,以展示其在空间数据处理和分析方面的多功能性。我们将通过具体应用示例,详细了解sf包如何在地理信息系统、城市规划与管理、以及环境科学等领域发挥其强大的空间数据处理能力。

## 5.1 地理信息系统中的应用

sf包可以极大地简化地理信息系统的操作流程,特别是在地图制作与编辑、空间数据的管理与查询方面。

### 5.1.1 地图制作与编辑

sf包允许用户以向量形式创建和编辑地图,这对于地理信息系统的地图制作来说至关重要。

```r

library(sf)

# 创建一个简单多边形对象

simple_polygon <- st_polygon(list(rbind(c(0,0), c(1,0), c(1,1), c(0,1), c(0,0))))

# 将其转换为sf对象

polygonSFML <- st_sfc(simple_polygon, crs = 4326)

# 绘制地图

plot(polygonSFML, col = 'blue')

```

上面的代码创建了一个蓝色填充的简单多边形sf对象,并使用plot函数将其绘制成地图。crs参数用于定义空间参考系统,确保地图的准确性。

### 5.1.2 空间数据的管理与查询

空间数据的管理不仅涉及数据结构的维护,还包括数据的查询和检索。

```r

# 假设我们有一个包含多个多边形的sf对象

polygons <- st_multipolygon(list(

list(rbind(c(0,0), c(2,0), c(2,2), c(0,2), c(0,0))),

list(rbind(c(1,1), c(2,1), c(2,2), c(1,2), c(1,1)))

# 将多边形转换为sf对象

polygonsSFML <- st_sfc(polygons, crs = 4326)

# 查询第一个多边形

first_polygon <- polygonsSFML[1, ]

plot(first_polygon, col = 'green')

```

这里我们创建了一个包含两个多边形的sf对象,并查询并绘制了第一个多边形。这展示了如何管理包含多个实体的空间数据集,并进行简单查询。

## 5.2 城市规划与管理

在城市规划与管理中,空间数据用于分析城市结构、模拟城市发展等,sf包提供了强大的分析工具。

### 5.2.1 城市数据的空间分析

城市数据的空间分析通常需要识别特定区域内的模式和趋势,sf包能够实现这些分析。

```r

# 加载城市规划相关的sf对象

city_data <- st_read("path/to/city_data.shp")

# 分析特定区域的人口密度

population_density <- city_data$population / st_area(city_data)

# 将人口密度添加到sf对象中

city_data$population_density <- population_density

# 绘制人口密度地图

plot(city_data['population_density'], pal = 'Reds')

```

此段代码演示了如何读取城市规划数据、计算人口密度,并将其可视化。通过这样的分析,规划者可以更好地理解人口分布并据此制定政策。

### 5.2.2 城市发展规划的空间模拟

空间模拟是城市规划的一个重要组成部分,可以帮助规划者在实施之前预览项目可能带来的变化。

```r

# 创建一个模拟区域

simulation_area <- st_polygon(list(

rbind(c(1,1), c(5,1), c(5,5), c(1,5), c(1,1))

)) %>% st_sfc(crs = 4326)

# 将模拟区域投影到城市数据上

simulation <- st_intersection(city_data, simulation_area)

# 设计新的发展规划(示例:增加公园)

simulation$new_park <- rnorm(nrow(simulation), mean = 1000, sd = 200)

# 可视化新的发展规划

plot(simulation['new_park'], main = "New Park Development Plan")

```

这段代码使用了模拟区域来展示如何在现有城市数据集上叠加新的规划元素,如新建公园,并将其可视化。

## 5.3 环境科学中的应用

在环境科学领域,sf包能够处理复杂的空间数据集,对生态系统和环境风险进行评估。

### 5.3.1 生态保护区域的划分

划分生态保护区域是防止生态退化和生物多样性丧失的重要措施。

```r

# 假定有一个物种分布的sf对象

species_distribution <- st_read("path/to/species_distribution.shp")

# 识别物种密集的区域以确定保护区域

protection_area <- species_distribution %>%

st_buffer(1000) %>% # 创建缓冲区

group_by(species) %>%

summarise(protection = st_union(geometry)) # 合并相邻区域

# 绘制生态保护区域

plot(protection_area['species'], key.pos = 1, key.width = lcm(5))

```

这段代码利用物种分布数据创建了缓冲区,并将相邻的物种密集区域合并为一个保护区域。其结果可用于制定保护政策和措施。

### 5.3.2 环境风险评估的空间分析

环境风险评估有助于识别和减轻潜在的环境威胁。

```r

# 加载污染数据的sf对象

pollution_data <- st_read("path/to/pollution_data.shp")

# 分析河流污染程度

pollution_level <- pollution_data$pollutant_level / st_area(pollution_data)

# 将污染程度添加到sf对象中

pollution_data$pollution_level <- pollution_level

# 根据污染程度高亮显示地图

plot(pollution_data[which.max(pollution_data$pollution_level), 'pollution_level'], key.pos = 4, key.width = lcm(5))

```

此代码段演示了如何利用空间数据评估河流污染程度,并将结果可视化,以便于进行风险评估和管理。

通过上述应用示例,我们可以看出sf包在地理信息系统、城市规划、以及环境科学等多个领域中的多样性和实用性。sf包通过R语言的强大统计和可视化能力,为各领域的空间数据分析带来了极大的便利。

0

0