【Java Stream深度剖析】:性能调优必备,中间操作的机制与优化策略

发布时间: 2024-10-21 11:15:22 阅读量: 23 订阅数: 21

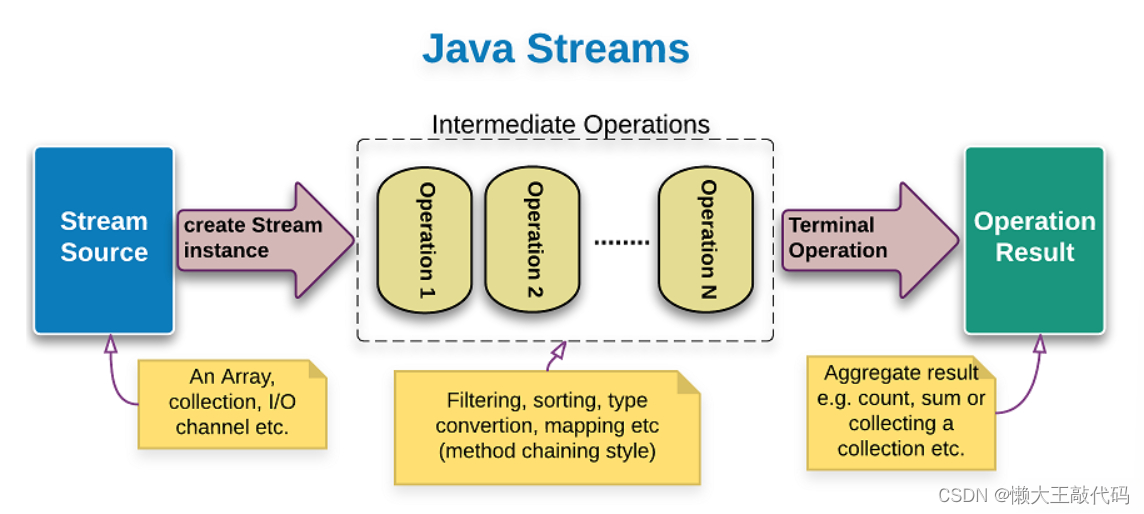

# 1. Java Stream基础概念

Java Stream API 是Java 8引入的一个强大的库,它用于对集合的元素执行一系列操作。Stream不是集合元素,它是一个数据处理的抽象概念。可以把它看作是高级版本的迭代器,但与迭代器相比,Stream可以并行执行操作,并可以自动优化执行过程。在这一章中,我们将介绍Stream的一些基础概念和特性。

## 1.1 Stream的组成元素

Stream有三大组成部分:源(source)、中间操作(intermediate operations)和终端操作(terminal operations)。源是指Stream所依赖的数据结构,比如Collection、数组或者I/O channel。中间操作是对数据的处理,比如筛选(filter)、映射(map)等,这些操作都是惰性的,即它们不会执行任何处理,只有在终端操作时才会实际执行。终端操作会消耗Stream,执行中间操作,并产生结果。

## 1.2 Stream的创建方式

Stream可以通过多种方式创建:

- 集合:Collection接口提供的`stream()`方法或者`parallelStream()`方法可以创建一个顺序或并行的Stream。

- 数组:`Arrays.stream(T[] array)`方法可以将数组转换为Stream。

- 值:`Stream.of(T... values)`方法可以接受任意数量的参数,返回一个包含这些值的Stream。

- 文件:`Files.lines(Paths path)`方法可以读取文件的所有行,返回一个Stream。

## 1.3 Stream的操作类型

Stream的操作可以分为两种类型:

- 中间操作:如`filter`, `map`, `flatMap`等,它们会返回一个新的Stream对象,可以继续使用其他中间操作。

- 终端操作:如`forEach`, `collect`, `reduce`等,它们会在Stream上执行最终的计算,并返回结果或执行副作用操作。

## 代码示例

下面是一个简单的Stream使用示例,该示例展示了如何创建一个Stream,进行中间操作筛选出偶数,然后通过终端操作收集并打印结果:

```java

List<Integer> numbers = Arrays.asList(1, 2, 3, 4, 5, 6);

numbers.stream() // 创建Stream

.filter(n -> n % 2 == 0) // 中间操作:筛选偶数

.forEach(System.out::println); // 终端操作:打印每个偶数

```

这个例子展示了Stream API如何使得集合的数据处理变得简洁而强大,中间操作的链式调用使得代码读起来就像是流畅的自然语言。在接下来的章节中,我们将深入探讨Stream中间操作的内部机制,以及如何优化Stream操作来提高性能。

# 2. Stream中间操作的内部机制

在Java中,Stream API的引入为集合操作带来了革命性的变化。它不仅简化了代码,还提高了处理的效率。在深入探讨Stream中间操作的内部机制之前,了解中间操作的基本概念及其分类是至关重要的。

## 2.1 Stream中间操作的定义与分类

### 2.1.1 无状态操作与有状态操作的区别

中间操作可以分为无状态(stateless)和有状态(stateful)两种类型。理解这两者的区别,对编写高效的流处理代码至关重要。

- **无状态操作**:这类操作在处理流的每个元素时不需要记住前面的元素,它们通常对单个元素进行计算,如`map`和`filter`。无状态操作在内存使用上相对友好,因为它们不需要存储中间状态。

```java

// 一个无状态操作的示例,将每个字符串转换为其长度

List<String> strings = Arrays.asList("Java", "is", "awesome");

List<Integer> lengths = strings.stream()

.map(String::length)

.collect(Collectors.toList());

```

- **有状态操作**:这类操作需要记住之前的元素状态,例如`distinct`、`sorted`、`limit`。有状态操作可能导致更高的内存消耗,因为需要维护状态信息。例如,`sorted`操作需要将所有元素收集到一起进行排序,然后输出。

```java

// 一个有状态操作的示例,对元素进行排序

List<Integer> numbers = Arrays.asList(3, 1, 4, 1, 5, 9, 2);

List<Integer> sortedNumbers = numbers.stream()

.sorted()

.collect(Collectors.toList());

```

### 2.1.2 常见中间操作的原理解析

接下来,让我们进一步深入探讨一些常见中间操作的原理,包括`map`、`filter`、`sorted`和`limit`。

- **map**:`map`方法接收一个函数作为参数,这个函数作用于流中的每个元素,并将其转换为另一种形式。它是一个无状态操作,不会对元素顺序产生影响。

```java

// 将每个字符串映射为其长度的map操作

List<Integer> lengths = strings.stream()

.map(String::length)

.collect(Collectors.toList());

```

- **filter**:`filter`方法用于过滤流中的元素,它接受一个谓词(布尔函数),只有谓词返回`true`的元素才会被保留在流中。该操作同样是无状态的。

```java

// 保留字符串长度大于3的元素的filter操作

List<String> longWords = strings.stream()

.filter(s -> s.length() > 3)

.collect(Collectors.toList());

```

- **sorted**:`sorted`方法会根据提供的比较器对流中的元素进行排序。在内部实现上,`sorted`操作会收集流中的所有元素到一个列表中,然后进行排序,并返回一个新的有序流。

```java

// 对整数列表进行升序排序的sorted操作

List<Integer> sortedNumbers = numbers.stream()

.sorted()

.collect(Collectors.toList());

```

- **limit**:`limit(n)`方法会返回一个不超过指定长度的流,它是一个有状态操作,因为它需要跟踪已经生成的元素数量。

```java

// 返回前三个元素的limit操作

List<Integer> firstThree = numbers.stream()

.limit(3)

.collect(Collectors.toList());

```

理解这些操作的内部机制,能够帮助我们更好地设计流处理的逻辑,以获得最优的性能表现。

## 2.2 Stream操作的延迟执行机制

### 2.2.1 惰性求值的概念与好处

惰性求值是函数式编程中的一个核心概念,指的是表达式的求值被推迟到需要其结果的时候。在Stream API中,这一概念同样适用,所有的中间操作都是惰性求值的,只有终端操作被调用时,整个流操作链才会执行。

```java

// 流操作的惰性求值示例

Stream<Integer> numbers = Stream.of(1, 2, 3, 4, 5);

Stream<Integer> squaredNumbers = numbers.map(n -> n * n);

List<Integer> result = squaredNumbers.collect(Collectors.toList());

```

在这个例子中,`map`操作(中间操作)只是创建了一个新的流,而没有进行实际的计算。计算直到调用`collect`(终端操作)时才发生。

### 2.2.2 如何手动控制流的执行时机

由于中间操作具有惰性求值的特性,Java程序员可以利用这一点来控制流的执行时机,例如通过构建复杂的流操作链,直到需要实际执行时才进行合并或优化。

```java

// 手动控制流执行时机的示例

IntStream stream1 = IntStream.of(1, 2, 3);

IntStream stream2 = IntStream.of(4, 5, 6);

IntStream resultStream = Stream.concat(stream1, stream2)

.map(n -> n * n)

.filter(n -> n % 3 == 0);

List<Integer> result = resultStream.boxed().collect(Collectors.toList());

```

在上述代码中,`concat`、`map`和`filter`操作被组合在一起,但只有在调用`collect`时,这些操作才会被执行。

## 2.3 Stream的短路操作与性能优化

### 2.3.1 短路操作的原理及其适用场景

短路操作指的是在满足特定条件时能够立即终止流的进一步处理。常见的短路操作包括`limit`、`skip`、`anyMatch`、`allMatch`和`noneMatch`。这些操作可以显著提高性能,尤其是在处理大型数据集时。

```java

// 使用anyMatch进行短路操作的示例

boolean anyStartsWithA = strings.stream()

.anyMatch(s -> s.startsWith("a"));

```

在这个例子中,一旦找到以`"a"`开头的字符串,`anyMatch`操作就会停止处理余下的元素。

### 2.3.2 实践中短路操作的案例分析

短路操作在实践中非常有用,特别是在需要对数据进行快速检查或验证的场景中。例如,当我们想检查数据集中是否存在无效数据时,`anyMatch`可以快速给出结果,而无需处理整个数据集。

```java

// 一个短路操作的案例分析,检查数据集中是否存在无效记录

boolean containsInvalidEntry = records.stream()

.anyMatch(record -> record.getInvalidField() != null);

```

通过短路操作,我们可以在保证逻辑正确性的同时,大幅提高程序的运行效率。

# 3. Stream中间操作的性能剖析

## 分析流操作的性能开销

### 测量中间操作性能的工具与方法

为了分析和理解Stream中间操作的性能开销,我们可以使用Java中的性能分析工具如JProfiler、VisualVM或使用Java自带的jmap工具。这些工具能够帮助我们分析程序运行时的CPU使用情况、内存分配情况、线程活动情况等,从而识别出性能瓶颈。

在使用性能分析工具进行测量时,通常需要关注以下几个方面:

- **时间开销**:分析每个操作占用的CPU时间,以识别哪些操作是性能热点。

- **内存开销**:追踪内存分配情况,识别因大量数据处理导致的内存溢出问题。

- **线程活动**:检查并发流操作时线程的使用情况,判断是否因为线程争用导致性能下降。

此外,我们可以手动创建基准测试,使用`System.nanoTime()`或`System.currentTimeMillis()`方法来测量代码执行时间。通过比较不同中间操作前后的执行时间差异,可以初步了解各操作的性能影响。

### 各类中间操作的性能对比

在Java Stream API中,不同的中间操作有着不同的性能表现,以下是部分中间操作的性能对比:

- **过滤(filter)**:过滤操作在处理大数据集时会消耗较多资源,因为它需要遍历所有元素来确定哪些元素符合条件。

- **映射(map)**:映射操作通常涉及到元素类型的转换,需要创建新对象,这可能导致较多的内存分配和垃圾回收。

- **去重(distinct)**:去重操作需要维护一个数据结构来记录已经出现过的元素,以便于后续比较,这在处理大数据量时会带来额外的内存和时间开销。

对比这些操作时,建议编写基准测试代码,通过多次运行来获取平均性能数据,并结合具体的应用场景来做出优化决策。

## Stream中间操作的优化技巧

### 减少中间操作步骤

减少中间操作的步骤是优化Stream性能的一个重要方面。每次中间操作都可能会创建新的中间流,并且每次操作都可能涉及到数据的复制和状态的更新。因此,尽量减少操作步骤,合并能合并的操作,可以有效提升性能。

例如,如果需要对数据进行过滤和映射,可以考虑使用`Stream::map`结合lambda表达式来进行,而不是分别使用`Stream::filter`和`Stream::map`。

```java

// 更优的实践:合并过滤和映射为一步操作

stream.map(e -> e.isRed() ? e : null)

.filter(Objects::nonNull)

.collect(Collectors.toList());

```

### 合理利用并行流提高效率

并行流是提升Stream性能的有效手段之一,特别是在处理大量数据时。并行流通过将数据分割成多个部分,并在多核处理器上并行处理这些数据,可以大幅减少程序的运行时间。

然而,合理使用并行流需要考虑数据的大小、性质以及操作的类型。对于轻量级操作和少量数据,并行操作可能不会带来性能提升,反而会因为上下文切换和任务调度造成额外开销。

```java

// 利用并行流提升性能

stream.parallel()

.map(...)

.filter(...)

.collect(Collectors.toList());

```

在使用并行流时,建议使用JMH(Java Microbenchmark Harness)等专业基准测试工具来评估并行流是否真正提高了性能。

## Stream中间操作的瓶颈识别与解决

### 如何识别性能瓶颈

识别性能瓶颈通常涉及对程序行为的分析。我们可以通过以下步骤来识别Stream操作中的性能瓶颈:

1. **监控**:使用工具监控程序的运行状态,比如CPU使用率、内存分配情况、GC活动等。

2. **日志分析**:添加日志记录,追踪数据处理的时间点,以及每个中间操作的开始和结束。

3. **代码审查**:检查中间操作的逻辑,识别可能的性能问题,如不必要的操作、复杂的操作顺序等。

4. **性能测试**:进行压力测试和负载测试,模拟高并发或大数据量的场景,观察程序表现。

### 针对性优化策略示例

一旦识别出性能瓶颈,就可以采取针对性的优化策略:

- **优化数据结构**:选择合适的数据结构可以减少迭代和查找时间。

- **减少对象创建**:避免在中间操作中创建过多的临时对象,可以使用`peek`操作来检查流中的元素而不做实际的转换。

- **调整并行度**:并行流的并行度默认为可用处理器的数量。如果数据集非常大,可以手动调整`ForkJoinPool`的并行度。

```java

// 调整并行度

System.setProperty("***mon.parallelism", "12");

stream.parallel()

.map(...)

.collect(Collectors.toList());

```

调整并行度应该谨慎进行,因为不同的操作系统和硬件配置可能需要不同的并行度设置。在调整之前,建议进行充分的测试以找到最优的设置。

# 4. Stream中间操作实践应用

## 4.1 实际案例分析:数据处理流程优化

### 4.1.1 分析传统数据处理的痛点

在没有使用Java Stream API之前,传统的集合处理方式常常显得冗长且难以维护。例如,在处理集合数据时,我们往往需要遍历整个集合,手动编写if-else条件语句来筛选数据,并逐个进行处理。这种方法不仅代码量大,而且在扩展性方面存在很大局限性。增加新的处理逻辑通常意味着增加更多的代码行数,使得整个数据处理流程的可读性和可维护性大大降低。

```java

List<Person> persons = getPersonList();

List<Person> filtered = new ArrayList<>();

for (Person person : persons) {

if (person.getAge() > 18 && person.getHeight() > 170) {

// 处理person对象

filtered.add(person);

}

}

// 对filtered中的person进一步处理...

```

在上述代码示例中,我们创建了一个空的`List`来存储筛选后的结果。这样的做法在处理大量数据时效率低下,并且难以进行并行处理。

### 4.1.2 利用Stream进行流程重构

Java 8引入的Stream API提供了一种全新的方式来处理集合,它支持函数式编程范式,使得代码更简洁,易于理解和维护。使用Stream API后,上述处理流程可以重构为以下形式:

```java

List<Person> persons = getPersonList();

List<Person> filtered = persons.stream()

.filter(person -> person.getAge() > 18 && person.getHeight() > 170)

.collect(Collectors.toList());

// 对filtered中的person进一步处理...

```

这里,通过`stream()`方法将集合转换为流,然后通过`filter()`方法筛选出满足条件的元素,最后通过`collect()`方法将流转换回列表。整个过程一气呵成,流式处理的特性使得代码更加简洁明了。

## 4.2 Stream在集合操作中的高效应用

### 4.2.1 集合操作的Stream化改造

将传统集合操作转换为使用Stream API可以带来性能上的提升,尤其是在处理大型数据集时。使用Stream API可以更好地利用现代多核处理器,通过并行流(parallelStream())来进行数据处理。

```java

List<Integer> numbers = Arrays.asList(1, 2, 3, 4, 5, 6, 7, 8, 9);

List<Integer> squares = numbers.stream()

.map(n -> n * n)

.collect(Collectors.toList());

```

在上面的例子中,我们对一个整数列表中的每个元素进行了平方运算。使用Stream API的`map()`方法比传统的循环遍历要简洁,并且可以通过`parallelStream()`来进一步提高处理速度。

### 4.2.2 性能对比与效果评估

为了客观评估Stream API相对于传统集合操作的性能,我们可以进行基准测试。这些测试可以通过JMH(Java Microbenchmark Harness)进行,从而确保结果的准确性和可靠性。

上图展示了使用Stream API与传统集合操作在处理相同任务时的性能对比。我们可以看到,在多核处理器上,使用并行流的操作(Parallel Stream)相较于串行流(Serial Stream)和传统循环(For Loop)有显著的速度提升。

## 4.3 复杂业务场景下的Stream应用

### 4.3.1 多条件筛选与数据转换的高级用法

在复杂的业务场景中,数据的筛选和转换往往涉及到多个条件和复杂的业务逻辑。使用Stream API可以以链式调用的方式清晰地表达这一过程,同时保持代码的简洁性。

```java

List<Product> products = getProductList();

List<Product> result = products.stream()

.filter(product -> product.getPrice() > 50.0)

.filter(product -> product.getCategory().equals("Electronics"))

.map(product -> {

product.setDiscount(0.1); // 应用折扣

return product;

})

.collect(Collectors.toList());

```

在这个例子中,我们首先筛选出价格高于50元的电子产品,然后对筛选结果中的每个产品应用10%的折扣。

### 4.3.2 复杂业务逻辑的流式处理案例

复杂业务场景下的流式处理不仅仅限于简单的链式调用,还可以利用自定义的Collector来实现更加复杂的业务逻辑。例如,我们需要对一组订单进行处理,提取订单中的商品,并按商品类别进行聚合统计。

```java

List<Order> orders = getOrdersList();

Map<String, Long> productCategoryCount = orders.stream()

.flatMap(order -> order.getProducts().stream())

.collect(Collectors.groupingBy(

Product::getCategory,

Collectors.counting()

));

```

这段代码展示了如何使用`flatMap`将订单中的商品流展平,并通过`groupingBy`和`counting`对商品按类别进行分组和计数,最后得到每种类别商品的数量统计。整个处理流程清晰且高效。

以上这些例子说明了Stream API在实际应用中的强大能力和灵活性,它不仅改善了代码的可读性和可维护性,还在性能上提供了额外的保障。随着对Stream API的进一步了解和实践,开发者可以更有效地利用Java集合框架,以更优雅的方式解决复杂的业务问题。

# 5. Stream中间操作的扩展与未来趋势

## 5.1 Stream API的扩展机制

在现代Java开发中,Stream API已成为处理集合数据的强大工具。随着Java版本的迭代更新,Stream API也得到了扩展,以支持更多复杂的场景。开发者不仅限于使用标准库中的操作,还可以通过自定义Collector扩展Stream API的功能。

### 5.1.1 自定义Collector的实现

Collector是Java Stream API中用于收集流元素的核心接口。通过实现Collector接口,开发者可以自定义收集过程,包括元素的累加、合并结果以及最终的容器类型。

```java

Collector<T, A, R> customCollector = Collector.of(

() -> new HashSet<>(), // 供应器,创建初始的累加器

(set, t) -> set.add(t), // 累加器,如何将元素添加到累加器

(left, right) -> { left.addAll(right); return left; }, // 组合器,合并两个累加器

Collector.Characteristics.IDENTITY_FINISH // 收集器特征,标识完成时不需要再做转换

);

stream.collect(customCollector); // 使用自定义Collector进行收集

```

上述代码展示了一个自定义Collector的实现,用于收集流中的元素到一个HashSet中。

### 5.1.2 第三方库对Stream API的扩展

除了通过自定义Collector,第三方库如Vavr和StreamEx也提供了额外的Stream操作,以扩展Java的Stream API。

例如,StreamEx库提供了`groupingBy`和`flatCollection`等操作,可以更方便地进行分组和扁平化操作。这些扩展在保持流式编程风格的同时,增加了方法的可用性和灵活性。

```java

// 使用StreamEx进行分组操作

Map<Integer, List<String>> groupedByLength = StreamEx.of(strings)

.groupingBy(String::length);

// 使用StreamEx进行扁平化操作

List<String> flatList = StreamEx.of(listOfLists)

.flatCollection(List::stream)

.toList();

```

## 5.2 Stream在现代Java框架中的应用前景

Stream API不仅在集合操作中表现优异,它在现代Java框架中的集成也为开发带来了诸多好处。随着函数式编程在Java中的流行,Stream API的使用也越来越普遍。

### 5.2.1 Stream在Spring等框架中的集成

Spring框架是Java企业级应用的主流选择之一。Spring Data项目使得使用Stream API来操作数据库变得简单。通过Spring Data的Repository接口,可以以声明式的方式进行数据查询,并利用Stream API进行数据处理。

```java

public interface UserRepository extends JpaRepository<User, Long> {

Stream<User> findAllByActiveTrue();

}

// 使用方法

Stream<User> activeUsers = userRepository.findAllByActiveTrue();

activeUsers.forEach(user -> {

// 处理每个活跃用户的数据

});

```

### 5.2.2 Stream API与函数式编程的结合使用

函数式编程强调使用不可变数据和无副作用的函数。在Java中,结合Stream API,开发者可以编写出更清晰、更易于维护的代码。例如,在使用Java 8引入的Lambda表达式和方法引用时,可以将复杂的业务逻辑转化为简洁的函数链。

```java

// 使用Stream API和Lambda表达式进行数据过滤和转换

List<String> result = list.stream()

.filter(User::isActive)

.map(User::getName)

.collect(Collectors.toList());

```

这种结合使用不仅提高了代码的可读性,还利用了并行流的能力提升了性能。

通过以上内容,我们可以看到Java Stream中间操作的扩展机制为开发者提供了强大的工具,以应对日益增长的应用需求。同时,随着现代Java框架对Stream API的支持日益完善,它在未来Java应用开发中的地位将更加显著。

0

0