OpenWrt R9 Docker性能监控与日志分析:稳定运行的保障

发布时间: 2024-12-19 16:57:22 阅读量: 8 订阅数: 5

# 摘要

本文首先介绍了OpenWrt R9环境下Docker的基本概念、优势以及其独特应用场景。随后,深入探讨Docker性能监控的理论基础,涵盖性能监控的重要性、关键指标和监控工具方法。文章接着详细阐述了Docker日志的构成、分析目的与方法,并对比了日志管理工具。接着,文章通过实践案例展示了如何在OpenWrt R9环境下实现Docker性能监控及日志分析,包括监控工具的配置、性能数据的解读和安全性考量。最后,本文探讨了监控与日志管理的进阶应用,包括容器化监控服务的搭建、日志监控与分析的自动化流程,以及集成监控与日志分析的未来趋势。本文旨在为OpenWrt R9环境下Docker的性能监控和日志管理提供全面的理论与实践指导。

# 关键字

OpenWrt R9;Docker;性能监控;日志分析;系统稳定性;自动化响应

参考资源链接:[OpenWrt R9 Docker 安装配置指南](https://wenku.csdn.net/doc/6461cd585928463033b33a41?spm=1055.2635.3001.10343)

# 1. OpenWrt R9 Docker简介

## 了解OpenWrt R9

OpenWrt R9是一款为嵌入式设备定制的Linux发行版,它具有高度模块化和可定制性。这使得OpenWrt非常适合网络设备如路由器和NAS(网络附加存储)。OpenWrt R9版本专注于性能提升、安全性增强以及新硬件的支持,为高级用户提供了一个强大而灵活的操作平台。

## Docker的基本概念与优势

Docker是一个开源的应用容器引擎,它允许开发者打包他们的应用以及应用的依赖包到一个可移植的容器中,然后发布到任何支持Docker的机器上,这样就实现了应用的快速部署和一致性维护。Docker的优势在于其轻量级、快速启动、高效的资源利用率和强大的移植能力,这使得开发者和系统管理员都能从中受益。

## OpenWrt R9 Docker的独特应用场景

将Docker应用于OpenWrt R9环境中,可以创造出一些独特而强大的应用场景。例如,在具有有限资源的嵌入式设备上运行复杂的网络服务变得可行,同时利用Docker的隔离机制来增强系统的安全性和稳定性。OpenWrt R9的灵活性允许用户在边缘设备上部署Docker容器,这对于物联网(IoT)和远程监控场景特别有价值。

# 2. Docker性能监控的理论基础

## 2.1 性能监控的重要性

### 2.1.1 系统性能的定义

在IT领域,系统性能是一个多维度的概念,通常指的是一个系统运行任务时的效率和稳定性。它可以被量化为响应时间、吞吐量、资源利用率等指标。对Docker容器而言,性能监控还应该包括容器内部进程的性能以及容器对宿主机资源的影响。优良的系统性能意味着可以以最低的成本,提供最快的响应速度和最高的处理能力。

### 2.1.2 监控对系统稳定性的影响

性能监控能够提供数据支持,帮助系统管理员及时发现潜在的系统瓶颈和问题。监控能够使问题在发生之初就被察觉,从而减少系统故障带来的损失。对于Docker容器环境来说,通过监控可以确保容器运行在最佳状态,避免由于资源分配不当或者容器异常导致的服务中断。

## 2.2 性能监控的关键指标

### 2.2.1 CPU与内存使用率

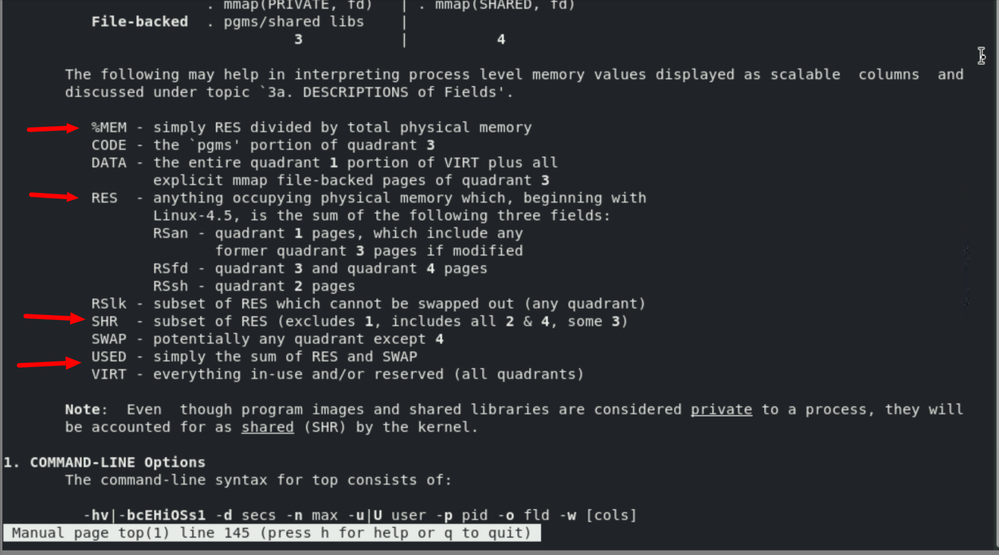

CPU和内存使用率是衡量系统性能的两个核心指标。CPU使用率反映了系统的计算能力是否得到充分使用,而内存使用率则反映了系统是否能够有效地处理数据。在Docker环境下,合理地监控这些指标对容器的性能至关重要。如果容器的CPU使用率持续走高,可能表明有性能瓶颈;内存使用率的异常波动可能暗示内存泄漏或其他内存管理问题。

### 2.2.2 网络IO与磁盘IO

除了CPU和内存使用之外,网络IO和磁盘IO也是性能监控的重要内容。网络IO涉及数据包的发送和接收速率,磁盘IO则关系到数据的读写速度。在Docker容器中,网络和磁盘性能直接影响到容器的服务能力和数据处理效率。例如,网络IO的低效会导致容器间的通信延迟,而磁盘IO的低下则可能影响数据持久化操作。

## 2.3 性能监控工具与方法

### 2.3.1 常用性能监控工具介绍

在Docker环境中,常用的性能监控工具有cAdvisor、Prometheus、Grafana等。cAdvisor可以提供实时的容器性能指标,Prometheus是一个开源的监控和警报工具,而Grafana则用于数据的可视化展示。这些工具可以配合使用,形成一套完整的监控系统,帮助管理员实时监控并分析容器性能。

### 2.3.2 监控数据的收集与分析

监控数据的收集涉及到定期对系统性能指标进行采样。例如,cAdvisor可以实时收集并存储Docker容器的性能数据。在收集完数据之后,需要使用分析工具对数据进行分析,找出性能趋势和异常模式。比如,通过Prometheus的查询语言PromQL,管理员可以编写查询来分析数据和设置警报阈值。

监控数据的分析方法不仅包括传统的统计学方法,还涵盖了机器学习等先进技术。通过使用合适的分析工具和方法,可以实现对复杂系统行为的深入理解和预测。

以上就是Docker性能监控的理论基础概述,接下来我们将深入探讨Docker日志分析的理论基础。

# 3. Docker日志分析的理论基础

在现代IT运维管理中,日志分析是一个重要的环节,它涉及到从各类日志源中提取、监控、分析数据,进而优化系统性能、提高安全性、帮助故障排查等。Docker作为一种轻量级的容器化技术,在广泛应用的同时,也带来了日志管理的新挑战。本章节将从Docker日志的基础知识出发,探讨日志管理的目的与方法,并介绍目前流行的日志管理工具,为读者建立起一个完整的Docker日志分析理论基础。

## 3.1 Docker日志的构成与分类

### 3.1.1 容器日志与系统日志的区别

Docker容器运行在宿主机的操作系统之上,与传统的系统运行环境不同,因此它拥有独特的日志机制。容器日志记录了容器内应用程序的运行情况,而系统日志则通常记录宿主机层面的操作和事件。

容器日志的收集通常需要特别的注意,因为容器的生命周期可能是短暂的,并且容器有可能在不同的宿主机之间迁移。这导致了容器日志的分散性、短暂性和可移动性。不同于传统的系统日志,容器日志可能需要在多个宿主机间进行同步。

### 3.1.2 日志级别和格式

日志级别是指日志记录时的重要程度,常见的日志级别包括Debug、Info、Warning、Error和Critical等。使用不同的日志级别可以帮助开发者和运维人员根据日志的严重性过滤和响应信息。

日志格式则是指日志信息的组织形式。Docker支持多种日志驱动程序,允许用户根据需要生成不同格式的日志,例如JSON格式提供了结构化的日志信息,便于日后的自动化分析。

## 3.2 日志分析的目的与方法

### 3.2.1 日志的目的与重要性

日志分析的主要目的是通过监控和审查日志信息,来识别系统运行中的问题,如性能瓶颈、安全威胁、故障诊断等。此外,日志也是审计和合规性的重要依据。

良好的日志管理有助于及时发现并修复问题,提高系统稳定性和可用性,增强安全防护能力,避免数据丢失和系统故障。

### 3.2.2 日志分析的基本方法

常见的日志分析方法包括但不限于:

- **手动分析**:运维人员直接通过日志文件进行阅读和搜索,适用于小型系统和非频繁的故障排查。

- **自动化分析**:使用日志管理工具和脚本自动化日志的收集、解析和告警,适用于大规模和高复杂度的系统。

- **可视化工具**:通过图表和仪表板展示日志信息,帮助用户直观理解日志数据。

- **机器学习分析**:利用机器学习技术预测和诊断潜在的问题,这在大规模的分布式系统中非常有用。

## 3.3 日志管理工具介绍

### 3.3.1 ELK栈在Docker日志管理中的应用

ELK栈是目前广泛使用的一套日志解决方案,由Elasticsearch、Logstash和Kibana三个主要组件构成。它为Docker日志管理提供了强大的数据收集、处理和展示能力。

- **Elasticsearch**:是一个实时的分布式搜索分析引擎,它可以存储、搜索并分析大量日志数据。

- **Logstash**:用于收集、处理和转发日志数据。Logstash能够从多种来源收集日志,并将它们处理成结构化的格式。

- **Kibana**:是一个可视化分析工具,它能够通过图表和仪表板对Elasticsearch中的数据进行展示。

通过结合Docker的原生日志驱动,ELK栈可以高效地管理和分析Docker容器的日志数据。

### 3.3.2 其他日志管理工具对比

除了ELK之外,还有其他一些流行的日志管理工具,例如:

- **Fluentd**:类似于Logstash,是一个开源数据收集器,用Ruby编写,专注于数据输入输出的统一。它与Docker结合紧密,支持多种日志格式,并且拥有丰富的插件生态系统。

- **Graylog**:提供了一个集中式日志管理平台,它具有易于使用的界面和强大的搜索功能,特别适合大规模日志数据的管理。

- **Syslog**:是传统的日志收集和管理协议,适用于Unix和类Unix系统。虽然它的功能相对基础,但在一些特定场景下仍有所应用。

以上介绍了Docker日志分析的理论基础,包括日志的构成、分类、分析的目的与方法,以及当前流行的日志管理工具。接下来的章节将深入探讨如何在OpenWrt R9上实践性能监控和日志分析。

# 4. OpenWrt R9 Docker性能监控实践

## 4.1 实现性能监控的步骤

### 4.1.1 配置系统监控工具

在OpenWrt R9上部署Docker后,引入性能监控是保障系统稳定运行的关键。首先,我们需要选择合适的系统监控工具。常见的监控工具有Prometheus、cAdvisor、Nagios等。我们选择Prometheus作为示例,因为它与容器化环境的集成性较好,并且它支持强大的查询语言PromQL。

安装Prometheus非常简单,只需在OpenWrt R9上执行以下命令:

```bash

opkg update

opkg install prometheus

```

安装完成后,需要配置Prometheus的`prometheus.yml`文件,添加Docker和系统监控的相关配置。

```yaml

scrape_configs:

- job_name: 'docker'

static_configs:

- targets: ['localhost:9090']

- job_name: 'system'

static_configs:

- targets: ['localhost:9100']

```

以上配置定义了两个任务,一个是用于监控Docker的`docker`任务,另一个是用于监控系统性能的`system`任务。

### 4.1.2 设置监控警报与阈值

仅仅收集监控数据还不够,我们还需要设置警报机制,以便在性能指标超过阈值时及时采取行动。Prometheus提供了Alertmanager组件用于警报管理。

首先,安装Alertmanager:

```bash

opkg install alertmanager

```

然后,在Alertmanager的配置文件中定义警报规则:

```yaml

route:

receiver: 'webhook'

receivers:

- name: 'webhook'

webhook_configs:

- url: 'http://<your_webhook_endpoint>'

```

在Prometheus的配置文件中引用Alertmanager:

```yaml

alerting:

alertmanagers:

- static_configs:

- targets:

- localhost:9093

```

最后,定义警报规则。例如,当Docker容器的CPU使用率超过80%时触发警报:

```yaml

groups:

- name: docker_alerts

rules:

- alert: HighDockerCpuUsage

expr: sum(rate(container_cpu_usage_seconds_total{image!=""}[5m])) by (name) * 100 > 80

for: 2m

labels:

severity: page

annotations:

summary: High CPU usage on Docker container {{ $labels.name }}

```

这些配置将确保当监控到Docker容器的CPU使用率超过阈值时,Prometheus会通过Alertmanager发送警报。

## 4.2 性能监控数据的解读

### 4.2.1 监控数据的可视化展示

将监控数据可视化是理解系统运行状况的最直观方式。Grafana是配合Prometheus使用最为广泛的可视化工具。在OpenWrt R9上安装Grafana,首先执行以下命令:

```bash

opkg install grafana

```

接下来,配置Grafana连接到Prometheus实例。

打开Grafana的配置文件`grafana.ini`,设置数据源:

```ini

[datasources]

datasources = [

{

"name": "Prometheus",

"type": "prometheus",

"url": "http://localhost:9090",

"access": "proxy",

}

]

```

重启Grafana服务后,即可在Grafana界面中创建仪表板并添加面板,利用PromQL查询语言展示各种监控数据。

### 4.2.2 性能瓶颈的诊断与优化

通过监控工具我们可以获取到系统的实时运行数据,但如何解读这些数据,进而找到潜在的性能瓶颈呢?

首先,应持续监控资源使用情况,包括CPU、内存、磁盘IO和网络IO。当遇到异常高峰时,可以使用以下PromQL查询语句来诊断:

```promql

sum(rate(container_cpu_usage_seconds_total{container_name!="POD", image!=""}[5m])) by (container_name)

```

此查询显示了所有容器在最近5分钟内的CPU使用率。如果某些容器的CPU使用率持续过高,那么可能需要对这些容器进行优化,例如通过优化应用程序代码、调整容器资源配额或扩展到更多容器进行负载分摊。

## 4.3 安全性考量与最佳实践

### 4.3.1 监控数据的安全管理

监控数据的安全性是不容忽视的问题。由于监控系统会收集大量的运行时数据,这些数据可能包含敏感信息。因此,必须对监控数据进行加密处理,并限制访问权限。

在Prometheus配置中启用TLS,并为Alertmanager启用身份验证机制。Grafana也应该设置强密码和权限控制,以防止未授权访问。

### 4.3.2 性能监控的维护与更新

性能监控系统需要定期的维护和更新,以适应系统和环境的变化。随着OpenWrt R9 Docker环境的升级和扩展,监控配置可能需要随之调整。

定期检查监控系统的日志文件,确认没有出现错误信息。同时,检查警报设置是否仍然适用,并根据需要进行调整。

为了简化维护工作,可以编写自动化脚本,定期执行检查命令并发送状态报告。当监控系统发现异常时,脚本还可以自动通知维护人员采取措施。

以上是我们在OpenWrt R9上实现Docker性能监控的实践步骤。通过系统的监控工具配置、监控数据的解读以及安全性考量,我们可以有效地管理Docker环境的性能问题,并保持系统的稳定运行。

# 5. OpenWrt R9 Docker日志分析实践

## 5.1 设置和管理Docker日志

### 5.1.1 配置Docker日志输出

Docker的默认日志记录驱动是`json-file`,它会将日志输出到本地文件系统。为了更好地管理和分析日志,我们可能需要更改默认设置,以支持日志轮转、压缩和远程传输等功能。

首先,了解当前Docker的日志配置:

```bash

$ docker info | grep -i logging

Logging Driver: json-file

```

如果你想改变日志驱动到`journald`(推荐在使用systemd的系统上),可以这样操作:

```bash

$ echo '{

"log-driver": "journald"

}' | sudo tee /etc/docker/daemon.json

$ sudo systemctl restart docker

```

请注意,对`daemon.json`的任何更改都需要重启Docker服务才能生效。

### 5.1.2 日志轮转与保留策略

在处理大量日志时,日志轮转是一种常见的做法,它将日志文件分割成更小的部分,并且有助于维护磁盘空间。让我们看看如何在Docker中配置日志轮转。

例如,要配置`json-file`驱动使用日志轮转,你可以创建一个目录并挂载到Docker容器:

```bash

$ mkdir -p /var/lib/docker/containers/{container-id}/logs

```

然后在`/etc/docker/daemon.json`中添加:

```json

{

"log-driver": "json-file",

"log-opts": {

"max-size": "10m",

"max-file": "3"

}

}

```

这个配置将使得每个容器的日志文件最大为10MB,并且只保留最新的3个文件。

## 5.2 日志分析工具的部署与使用

### 5.2.1 Logstash、Filebeat的配置与应用

为了更深入地分析日志,通常会结合使用如Logstash、Filebeat等工具。这里我们将介绍如何部署Filebeat来收集Docker日志,并使用Logstash进行处理。

#### Filebeat配置

Filebeat是轻量级的日志数据发送者,它可以监控指定的日志文件或位置,并将数据转发到Elasticsearch或Logstash进行进一步处理。

首先,下载并配置Filebeat:

```bash

$ curl -L -O https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-oss-7.9.3-amd64.deb

$ sudo dpkg -i filebeat-oss-7.9.3-amd64.deb

$ sudo filebeat modules enable docker

$ sudo filebeat setup -e

```

接下来,编辑Filebeat配置文件(`/etc/filebeat/filebeat.yml`),设置Docker日志输入:

```yaml

filebeat.inputs:

- type: docker

enabled: true

containers Beats:

enabled: true

var.paths: ["/var/lib/docker/containers/*/*-json.log"]

```

#### Logstash配置

Logstash用于收集、处理和转发日志数据。

在Logstash配置文件中(`/etc/logstash/conf.d/docker.conf`),设置一个管道来处理Filebeat发送的日志:

```conf

input {

beats {

port => 5044

}

}

filter {

json {

source => "message"

}

if [log][level] {

mutate {

convert => [ "[log][level]", "string"]

}

if [log][level] == "error" {

mutate {

add_field => { "[@metadata][color]" => "red" }

}

} else {

mutate {

add_field => { "[@metadata][color]" => "green" }

}

}

}

}

output {

if [@metadata][color] == "red" {

elasticsearch {

hosts => ["localhost:9200"]

index => "docker-logs-error-%{+yyyy.MM.dd}"

}

} else {

elasticsearch {

hosts => ["localhost:9200"]

index => "docker-logs-%{+yyyy.MM.dd}"

}

}

}

```

完成配置后,启动Logstash服务。

## 5.3 日志分析与故障排查

### 5.3.1 利用日志进行故障定位

日志是故障排查的宝贵资源。利用配置好的日志分析工具,我们可以快速找到错误信息。

在本例中,Filebeat将Docker容器的日志发送到Logstash,后者将它们转发到Elasticsearch,并在Kibana中可视化展示。假设我们正在寻找与特定容器相关的错误信息,可以在Kibana的Discover界面通过日志记录的容器ID进行搜索:

```

log.container.id:"<container-id>"

```

Kibana将显示该容器的实时日志流,我们可以查看特定时间的错误信息并定位故障。

### 5.3.2 日志分析在安全事件响应中的作用

在安全事件响应中,日志分析至关重要,因为它可以帮助我们确定是否有未授权的行为或安全漏洞。

例如,可以设置一个警报,当发现日志中的关键安全事件时触发,例如:

```bash

if [log][level] == "warning" and [log][message] contains "Possible exploit detected" {

alert {

send_to => ["security-alerts"]

}

}

```

在这里,任何包含“Possible exploit detected”的警告级别日志都会被发送到指定的安全警报队列中,进一步触发安全团队的响应措施。

通过以上章节,我们介绍了如何在OpenWrt R9环境下的Docker容器中设置和管理日志,以及如何部署和使用日志分析工具。我们还探讨了如何利用日志进行故障排查和安全事件响应。在实际操作过程中,日志管理是一个持续的过程,需要不断调整和优化以满足不断变化的监控和故障排查需求。

# 6. OpenWrt R9 Docker监控与日志管理进阶应用

## 6.1 容器化监控服务的搭建

在深入探讨容器化监控服务的搭建之前,首先要明确容器化带来的好处。它不仅能够提高资源利用率,简化部署流程,而且还能通过隔离机制提升监控服务的稳定性和安全性。接下来,我们会一步步了解监控服务的容器化部署过程以及面临的挑战和解决策略。

### 6.1.1 监控服务的容器化部署

构建一个监控服务的容器化过程包括选择合适的容器镜像,定义容器运行的环境和配置,以及设置容器与宿主机或其他容器之间的网络连接。以下是一个使用Prometheus和Grafana搭建监控服务的示例步骤:

1. **选择镜像**:首先选择Prometheus和Grafana的官方Docker镜像。

2. **编写Docker Compose文件**:通过Docker Compose定义一个服务栈,其中包含Prometheus服务和Grafana服务。

3. **设置持久化存储**:配置数据卷以持久化Prometheus的监控数据和Grafana的配置。

4. **部署与启动**:执行`docker-compose up -d`命令来启动整个服务栈。

```yaml

version: '3.5'

services:

prometheus:

image: prom/prometheus

volumes:

- prometheus_data:/prometheus

networks:

- monitoring

grafana:

image: grafana/grafana

volumes:

- grafana_data:/var/lib/grafana

ports:

- 3000:3000

networks:

- monitoring

volumes:

prometheus_data:

grafana_data:

networks:

monitoring:

driver: bridge

```

### 6.1.2 管理容器化监控服务的挑战与对策

容器化监控服务虽有许多优势,但也存在挑战,如容器的快速启动和停止可能导致监控服务的连续性问题,以及容器网络的复杂性增加了监控配置的难度。以下是一些解决策略:

- **服务连续性**:通过Kubernetes或其他容器编排平台,使用持久化存储卷确保数据不因容器重启而丢失。

- **网络管理**:利用网络命名空间和网络策略,确保容器间通信安全且高效。

- **自动化运维**:编写自动化脚本或使用CI/CD工具链,保证监控服务能自动部署和升级。

## 6.2 日志监控与分析的自动化

日志监控与分析的自动化可以极大提高问题发现和响应的速度,尤其在大规模的容器化环境中。自动化监控与分析流程对于确保系统稳定运行和快速故障定位至关重要。

### 6.2.1 自动化日志收集流程

自动化日志收集的实现往往依赖于一套日志收集系统,其可以是集中式的,也可以是分布式架构,例如ELK栈或Fluentd+InfluxDB+Grafana。以下为一个使用Filebeat和Logstash进行日志收集的基本流程:

1. **配置Filebeat**:在需要监控日志的容器内运行Filebeat代理,将日志数据发送至Logstash服务器。

2. **设置Logstash**:配置Logstash服务器以接收Filebeat传来的日志,进行解析和过滤,然后存储到数据库或直接可视化展示。

3. **可视化与警报**:利用Kibana或其他工具对解析后的日志数据进行分析,并设置警报机制以通知运维团队。

### 6.2.2 基于日志事件的自动化响应

为了实现基于日志事件的自动化响应,可以将日志分析系统与事件管理工具或自动化运维工具(如Ansible)相结合。这样,一旦检测到特定的错误或异常,系统就可以自动执行预设的任务:

- **错误检测**:在分析系统中定义异常日志模式。

- **触发器配置**:设置触发器以响应这些模式。

- **自动响应**:触发器激活后,通过发送命令到容器编排平台或执行自动化脚本来自动修复问题或通知相关人员。

## 6.3 集成监控与日志分析的未来趋势

随着技术的发展,监控和日志分析领域也在不断创新。未来的发展方向不仅将包括更高效的工具和策略,还会涉及智能化和跨系统的集成。

### 6.3.1 结合AI的日志分析前景

人工智能(AI)技术,特别是机器学习(ML),有潜力显著提升日志分析的效率和准确性。通过AI模型学习正常系统行为和潜在的故障模式,日志分析工具可以变得更加智能,甚至能够预测和识别之前未曾见过的异常模式。这将有助于减少误报,并且优化问题响应时间。

### 6.3.2 跨系统监控与日志整合的方向

随着微服务架构和分布式系统的普及,监控和日志数据的整合变得更加复杂。因此,未来的监控与日志分析工具需要能够处理来自不同源的数据,并提供统一的视图。一个潜在的解决方案是使用开放标准和协议(如OpenTelemetry),以及开发通用的数据模型,这样不同的工具就可以轻松地交换和解析监控数据。

通过这些方法,系统管理员和开发者可以更轻松地整合来自不同来源的数据,从而进行更全面的监控与分析。这将大大增强对系统整体健康的理解,提高故障排查的效率,并加快创新的节奏。

0

0