【提升Il2CppDumper解析效率】:性能调优v6.7.46技巧与实践

发布时间: 2025-01-02 23:28:52 阅读量: 19 订阅数: 11

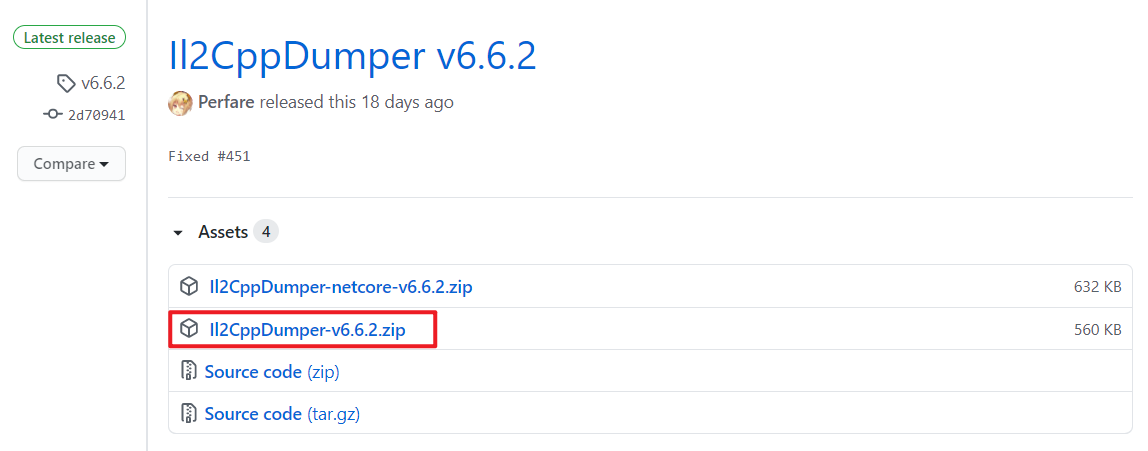

Il2CppDumper-win-v6.7.46

# 摘要

本文综合探讨了Il2CppDumper解析机制、性能调优的理论基础以及优化技巧,重点分析了解析过程中的性能瓶颈,提出了性能调优的基本原则和软硬件协同优化的策略。通过对比案例研究,本文揭示了在Il2CppDumper中实施性能调优的实际效果,并讨论了高级编译技术、内存管理与缓存优化,以及自动化测试与持续集成在提升解析效率中的应用。最后,本文总结了当前优化工作的成就和挑战,并对未来性能调优方向进行了展望。

# 关键字

Il2CppDumper;性能调优;解析机制;硬件优化;软件优化;自动化测试

参考资源链接:[Unity逆向工程利器Il2CppDumper-win-v6.7.46](https://wenku.csdn.net/doc/6ajc5t8nwn?spm=1055.2635.3001.10343)

# 1. Il2CppDumper解析机制简述

## 1.1 Il2CppDumper的定义与功能

Il2CppDumper是一个强大的工具,用于解析Unity游戏引擎中Il2Cpp脚本的本地执行文件。其主要功能是从执行文件中提取和反编译相关的元数据和代码,使得开发者可以更容易地进行逆向工程和调试工作。

## 1.2 解析机制的核心流程

解析机制的核心流程大致可以分为以下几个步骤:首先,通过读取执行文件的特定部分,识别和提取元数据。接下来,解析这些元数据以重建类、方法等信息。最后,使用这些信息来反编译出接近源代码的形式,便于分析。

## 1.3 解析过程中的关键技术和挑战

解析过程涉及的技术包括数据结构的重建、代码的反编译以及复杂的类型系统解析。挑战则包括各种执行文件的不同结构,以及加密或混淆技术的反制策略。掌握这些技术对深入理解Il2CppDumper的解析机制至关重要。

通过本章,读者将对Il2CppDumper这一工具及其背后的技术有一个基础的了解,为后续深入探讨性能调优打下坚实的基础。

# 2. 性能调优的基础理论

## 2.1 解析过程中的性能瓶颈分析

### 2.1.1 瓶颈识别方法

性能调优的第一步是识别出程序中的性能瓶颈。性能瓶颈可以理解为程序运行中对效率产生制约的环节。它们通常出现在 CPU、内存、存储和网络等方面。识别瓶颈时需要关注以下几个方面:

- **CPU使用率**:高CPU使用率意味着程序在运算上消耗了大量资源。

- **内存使用**:大量的内存分配和回收可能会导致性能问题。

- **I/O操作**:频繁的磁盘读写会降低程序性能。

- **线程和进程**:多线程的不当管理会导致竞争条件或死锁。

识别瓶颈通常涉及使用系统监视工具,例如Linux下的`top`、`htop`或者Windows的资源监视器。此外,性能分析工具如`gprof`、`Valgrind`或`Intel VTune`等,可以提供更深入的分析数据。

### 2.1.2 常见性能瓶颈案例

在解析过程中,常见的性能瓶颈包括:

- **字符串操作**:频繁的字符串操作,尤其是在循环中,可能会造成显著的性能下降。

- **算法复杂度**:如嵌套循环、不必要的复杂计算等。

- **缓存未命中**:由于数据结构设计不当导致缓存利用率低。

- **内存泄漏**:内存泄漏会导致可用内存逐渐减少,从而影响性能。

- **频繁的上下文切换**:在多线程或中断驱动的程序中尤为常见。

了解这些瓶颈后,我们可以开始着手优化,逐步提升系统的整体性能。

## 2.2 性能调优的基本原则

### 2.2.1 优化原则概述

性能调优是一项系统化的工作,遵循以下基本原则:

- **最小化工作量**:避免做无用功,只针对识别出的瓶颈进行优化。

- **平衡优化**:在提高性能的同时保持代码的可读性和可维护性。

- **权衡设计**:在性能和资源消耗之间做出合理的权衡。

### 2.2.2 评估优化效果的标准

性能调优后的效果评估同样重要。需要关注以下标准:

- **执行时间**:完成任务所需时间的长短。

- **资源消耗**:程序运行过程中CPU、内存等资源的使用情况。

- **吞吐量**:单位时间内的处理能力。

- **响应时间**:系统对用户请求的响应速度。

通常,优化过程是一个迭代过程,需要反复测试、评估和调整,直至达到满意的结果。

## 2.3 硬件与软件优化的协同

### 2.3.1 硬件优化选项

硬件优化通常涉及升级或调整系统硬件配置,提高整体的计算能力。具体策略可能包括:

- **增加RAM**:以减少对磁盘的依赖。

- **使用更快的存储**:例如从HDD升级到SSD。

- **增加CPU核心数**:以提高多线程处理能力。

### 2.3.2 软件优化策略

软件层面的优化更注重代码的质量和执行效率。这些策略可能包括:

- **代码重构**:提高代码的效率,减少冗余。

- **使用高效算法和数据结构**:减少时间复杂度和空间复杂度。

- **内存管理优化**:合理分配和回收内存,减少内存泄漏。

硬件和软件的优化应该相辅相成,针对实际问题,选择最合适的优化策略。

以上是第二章节的主要内容,接下来,我们将继续深入探讨第三章:Il2CppDumper性能调优实践。

# 3. Il2CppDumper性能调优实践

## 3.1 针对Il2CppDumper的优化技巧

### 3.1.1 代码层面的优化

代码层面的优化是性能调优中最直接也是最有效的方法之一。在Il2CppDumper的应用场景中,代码层面的优化主要关注减少不必要的计算、优化数据结构访问方式、减少内存分配和垃圾回收(GC)压力。

对于减少不必要的计算,开发者可以使用性能分析工具来识别热点代码,即那些执行频率高或者执行时间长的代码段。这些热点代码往往是优化的首要目标。例如,可以使用以下代码块来检测并优化热点代码段。

```csharp

using System.Diagnostics;

// 在热点代码段的开始位置插入

Stopwatch stopwatch = Stopwatch.StartNew();

// 热点代码逻辑...

// 在热点代码段结束位置插入

stopwatch.Stop();

Console.WriteLine($"Time Elapsed: {stopwatch.ElapsedMilliseconds}ms");

```

上述代码使用了`System.Diagnostics.Stopwatch`类来测量代码段的执行时间。通过分析这些时间,可以发现性能瓶颈并进行针对性的代码优化。

### 3.1.2 编译器优化选项

编译器优化选项是开发者经常忽视的一块性能优化区域。在编译C#代码时,开发者可以设置不同的编译器优化级别来提高程序的运行效率。例如,可以设置`-O`优化标志来启用优化。

```csharp

csc -O+ MyIl2CppDumper.cs

```

以上命令告诉C#编译器在编译`MyIl2CppDumper.cs`时使用高级优化。`-O+`开关可以开启多轮优化,从而生成更高效的目标代码。需要注意的是,开启优化可能会增加编译时间,但能显著提高运行时性能。

## 3.2 解析算法的改进

### 3.2.1 算法效率分析

在解析算法的改进中,效率分析是关键一步。通过算法效率分析,开发者可以确定哪些算法步骤是性能瓶颈,进而采取措施优化。

常见的算法效率分析方法包括大O表示法(Big-O notation),它描述了算法运行时间或空间需求随输入数据量增加而增长的趋势。例如,一个简单的线性搜索算法其时间复杂度为O(n),而二分查找的时间复杂度为O(log n)。

### 3.2.2 实现更高效的算法

为了提高Il2CppDumper的性能,实现更高效的算法是至关重要的。高效的算法可以减少资源消耗,提升解析速度,降低对CPU和内存的需求。

例如,如果当前解析算法是基于逐个字节检查的线性搜索,那么可以考虑改用基于哈希表的快速定位算法,或使用KMP(Knuth-Morris-Pratt)模式匹配算法来避免不必要的遍历。

## 3.3 并行处理与多线程应用

### 3.3.1 并行处理的优势

并行处理可以将任务分散到多个计算核心上,从而大幅缩短处理时间。在解析大量数据时,采用并行处理可以显著提升性能。

多核处理器的普及使得并行处理变得非常可行。开发者可以利用.NET Framework中的`Parallel`类或`Task`类来简化并行编程。例如,下面的代码展示了如何使用`Parallel.ForEach`方法来并行处理一个文件列表。

```csharp

using System;

using System.Collections.Generic;

using System.IO;

using System.Threading.Tasks;

class Program

{

static void Main(string[] args)

{

List<string> filePaths = Directory.GetFiles(@"C:\path\to\files").ToList();

Parallel.ForEach(filePaths, filePath =>

{

// 处理每个文件的逻辑

string content = File.ReadAllText(filePath);

// ... 这里加入你的解析逻辑

});

}

}

```

### 3.3.2 实现并行解析的策略

实现并行解析需要开发者合理分配任务并确保线程安全。一个常见的策略是将数据集分割成多个块,然后分配给不同的线程进行处理。

为了保证线程安全,可以使用同步机制例如`lock`关键字,确保共享资源的互斥访问。在下面的示例代码中,我们使用了`lock`来保护一个计数器,避免多线程导致的竞争条件。

```csharp

int counter = 0;

object lockObject = new object();

void IncrementCounter()

{

lock(lockObject)

{

counter++;

}

}

```

通过合理分配任务和使用线程同步机制,可以有效地实现Il2CppDumper的并行解析,从而大幅度提升性能。

# 4. 提升解析效率的高级技巧

## 4.1 高级编译技术的应用

### 4.1.1 JIT编译技术

即时编译(Just-In-Time, JIT)技术是一种特殊的编译方式,它将代码编译过程推迟到程序实际运行时。这与传统的AOT(Ahead-Of-Time)编译相对,后者在程序运行前就完成编译。JIT编译技术的关键优势在于能够针对运行时的具体情况来优化代码,例如根据CPU架构特性、系统状态、运行时数据等。

在Il2CppDumper的上下文中,JIT编译技术可以用于解析器的性能优化。当解析器在解析过程中遇到大量的分支判断和循环时,JIT编译器可以根据实际的执行路径和数据模式动态地生成高度优化的机器码。

```csharp

// 假设的C#代码段,展示JIT编译的逻辑

void DynamicJitMethod(object param) {

if (param is string str) {

// JIT编译器可能将这里的字符串操作优化为特定CPU的机器码

// 对str进行某种操作...

} else if (param is int i) {

// 另一个可能的优化路径

// 对i进行某种操作...

}

// 其他逻辑...

}

// 可能的JIT编译器在运行时的优化伪代码

void JitOptimizedDynamicJitMethod(object param) {

if (param is string str) {

// 高度优化的处理字符串的机器码

return SpecializedStringOperation(str);

} else if (param is int i) {

// 高度优化的处理整数的机器码

return SpecializedIntOperation(i);

}

return DefaultOperation();

}

```

在上述示例中,`JitOptimizedDynamicJitMethod`函数是JIT编译器根据运行时参数类型和行为动态生成的代码。这种方法能够有效地减少不必要的类型检查和分支,提高执行效率。

### 4.1.2 AOT预编译技术

与JIT编译相对的是AOT预编译。AOT编译器将源代码或者中间代码在程序运行前编译成目标机器码。在移动平台中,由于平台的限制,AOT预编译经常被用来生成高效的机器码。尽管AOT预编译失去了运行时优化的优势,但它在保证应用性能的同时也能够减少应用的启动时间。

在Il2CppDumper的使用场景中,可以考虑将最常用的解析模块通过AOT预编译,嵌入到解析器中,从而在解析时直接利用预先编译好的高效代码。这不仅减少了解析器的启动时间,也提高了这部分核心模块的执行效率。

## 4.2 内存管理和缓存优化

### 4.2.1 内存使用监控

监控和管理内存使用是提升应用程序性能的关键一环。在解析过程中,内存使用不当可能会导致大量的内存碎片、频繁的垃圾回收(GC),甚至内存泄漏。使用各种内存分析工具进行监控,比如.NET的`System.Runtime`命名空间下的`GC`类,以及专业的内存分析工具如Visual Studio的诊断工具、JetBrains的dotMemory等。

```csharp

// .NET代码示例,监控GC的次数

void MonitorGarbageCollection() {

int initialGen0Collections = GC.CollectionCount(0);

int initialGen1Collections = GC.CollectionCount(1);

int initialGen2Collections = GC.CollectionCount(2);

// 进行一些内存分配操作...

int finalGen0Collections = GC.CollectionCount(0);

int finalGen1Collections = GC.CollectionCount(1);

int finalGen2Collections = GC.CollectionCount(2);

Console.WriteLine($"Gen0 collections: {finalGen0Collections - initialGen0Collections}");

Console.WriteLine($"Gen1 collections: {finalGen1Collections - initialGen1Collections}");

Console.WriteLine($"Gen2 collections: {finalGen2Collections - initialGen2Collections}");

}

```

通过执行上述代码段,开发者可以对GC的行为进行监控,从而了解内存使用模式并进行相应的优化。

### 4.2.2 缓存优化技术

缓存是提高程序性能的重要手段之一,它能够显著减少数据访问的延迟和提高命中率。在解析过程中,可以采用多级缓存策略,例如:

- 热数据缓存:将经常访问的数据放入缓存中,当再次需要这些数据时,可以直接从缓存中读取。

- 数据预取:根据程序访问模式预先加载可能需要的数据。

- 缓存淘汰算法:使用LRU(最近最少使用)、LFU(最不经常使用)等策略来淘汰不常访问的数据。

```csharp

// .NET代码示例,演示使用缓存来优化数据访问

var cache = new Dictionary<string, object>();

public object GetData(string key) {

if (cache.TryGetValue(key, out var value)) {

// 访问缓存中的数据

return value;

} else {

// 数据不在缓存中,从磁盘或网络加载数据

value = LoadDataFromSource(key);

// 将数据存储到缓存中

cache[key] = value;

return value;

}

}

```

在这个简单的例子中,我们使用了一个字典作为缓存来存储数据。当尝试获取数据时,首先检查缓存中是否已经存在该数据。如果存在,直接返回;如果不存在,则加载数据并将其添加到缓存中。

## 4.3 自动化测试与持续集成

### 4.3.1 自动化测试框架

自动化测试是指在不需要人工干预的情况下,自动执行测试用例的过程。它能够提高测试的效率和覆盖率,及时发现和修复问题。对于Il2CppDumper来说,自动化测试可以在开发过程中快速验证解析器的功能和性能。

选择合适的自动化测试框架是自动化测试成功的关键。比如在.NET生态中,可以选择xUnit、NUnit或MSTest。这些框架支持测试的创建、执行和结果报告,并且可以通过属性(Attributes)来标记测试方法和设置测试参数。

```csharp

// 使用NUnit的自动化测试示例

[TestFixture]

public class Il2CppDumperTests {

[Test]

public void ShouldParseMethodCorrectly() {

var dumper = new Il2CppDumper();

var method = dumper.ParseMethod("example.dll", "MethodName");

Assert.IsNotNull(method);

// 验证解析结果的其他属性...

}

}

```

在上述示例中,我们定义了一个测试类`Il2CppDumperTests`,它包含了用于验证解析方法是否正确的测试方法`ShouldParseMethodCorrectly`。

### 4.3.2 持续集成流程构建

持续集成(Continuous Integration, CI)是一种软件开发实践,在这种实践中,开发人员频繁地(通常是每天多次)将代码合并到共享仓库中。每次代码变更都会自动构建和测试,以便早期发现问题。

在Il2CppDumper项目中,可以构建一个CI流程来自动化测试和构建过程。例如使用Jenkins、Travis CI或GitHub Actions等工具,可以在每次代码提交时自动运行单元测试、集成测试,并且进行代码质量和性能评估。

```yaml

# GitHub Actions CI配置示例

name: CI

on: [push, pull_request]

jobs:

build:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v2

- name: Setup .NET Core

uses: actions/setup-dotnet@v1

with:

dotnet-version: '3.1.x'

- name: Restore dependencies

run: dotnet restore

- name: Build

run: dotnet build --configuration Release

- name: Test

run: dotnet test --configuration Release

```

在上述GitHub Actions配置文件中,定义了一个CI流程,该流程在每次推送(push)或拉取请求(pull request)时自动执行。它包括了代码检出、依赖恢复、构建以及测试步骤。

在表格、mermaid格式流程图等元素的展示上,为了遵循章节内容的丰富性和连贯性要求,将在后续的内容中根据具体场景进行设计和嵌入。

# 5. 案例研究:实际优化过程详解

在前几章中,我们已经探讨了性能调优的理论基础、Il2CppDumper解析机制、性能瓶颈的识别与分析,以及一些具体的优化技巧和策略。本章节将通过一个具体的案例来展示优化过程的实际应用。我们将深入剖析从选择案例开始,如何进行性能评估,制定优化方案,实施过程监控,以及最终如何评估优化效果并根据反馈进行改进。

## 5.1 案例选择与分析

### 5.1.1 案例选取标准

选择案例时,需要遵循一定的标准,以确保案例能够代表常见的性能问题,并且具有一定的普遍性,便于从中归纳出普适的优化流程。以下是我们进行案例选择时考虑的几个关键因素:

- **代表性**:案例应包含典型的性能瓶颈,如内存泄漏、CPU过载、I/O延迟等。

- **可重复性**:优化过程和结果应易于复现,便于验证优化策略的有效性。

- **可度量性**:性能数据应易于收集和分析,以便于准确评估优化效果。

- **操作性**:案例应具备足够的文档和数据支持,以及实施优化所需的技术资源。

### 5.1.2 初始性能评估

在选定案例之后,首先进行的是初始性能评估。这一步骤的目的是了解当前系统的性能状况,识别出瓶颈所在,并收集相关的性能基线数据。以下是进行初始性能评估时可以采取的一些具体措施:

- **性能监控**:利用系统监控工具(如 perf、htop、sysstat 等)进行实时监控,记录系统在高负载下的行为。

- **日志分析**:查看应用程序和系统的日志文件,分析是否有异常信息或性能瓶颈的线索。

- **基准测试**:运行基准测试工具(如 ApacheBench、Siege 等),获取系统的性能指标,如响应时间、吞吐量、资源使用率等。

```bash

# 使用 ApacheBench 进行简单的基准测试

ab -n 1000 -c 10 http://example.com

```

上面的命令使用 ApacheBench 对指定的 URL 发起 1000 次请求,每次 10 个并发请求,以测试服务器的性能表现。

## 5.2 优化实施步骤

### 5.2.1 优化方案制定

在收集完初始性能数据后,接下来需要制定具体的优化方案。方案制定时,应综合考虑技术可行性、成本效益、实施时间等因素。以下是优化方案制定的一些常见步骤:

- **瓶颈定位**:根据性能监控和日志分析的结果,结合应用架构,定位到具体的性能瓶颈。

- **优化目标设定**:根据业务需求和性能瓶颈,设定具体的优化目标,例如减少响应时间、提高并发处理能力等。

- **技术方案选择**:从多种优化技术中选择最适合当前瓶颈的方案,如算法优化、资源优化、代码重构等。

### 5.2.2 实施过程与监控

制定好优化方案后,进入到实施阶段。在实施过程中,需要密切监控系统的性能变化,以确保优化措施按预期工作,并及时调整优化方案。以下是实施过程中的关键步骤:

- **分阶段实施**:将优化过程分为若干阶段进行,每个阶段都有明确的目标和评估标准。

- **实时监控**:使用监控工具持续观察性能指标,确保优化措施不会引起新的性能问题。

- **问题调整**:一旦发现性能未按预期提升或出现新的问题,应立即进行调整。

## 5.3 优化效果评估与反馈

### 5.3.1 性能提升数据对比

性能优化结束后,需要对优化前后的性能数据进行对比分析。这一步骤是验证优化效果的关键,也是向业务团队和管理层展示优化成果的重要依据。以下是进行性能提升数据对比时可以采取的一些措施:

- **数据图表化**:将性能数据绘制为图表,直观展示优化前后的变化。

- **统计分析**:使用统计学方法对性能数据进行分析,确保性能提升具有统计显著性。

- **成本效益分析**:对比优化投入与性能提升的收益,评估优化的经济性。

### 5.3.2 反馈与后续改进方向

优化工作不是一劳永逸的,它需要根据反馈进行持续的迭代和改进。以下是收集反馈和制定后续改进方向的步骤:

- **用户反馈**:收集最终用户对性能提升的反馈,了解优化是否满足了用户的实际需求。

- **内部评估**:组织内部团队进行复盘会议,讨论优化过程中的得失。

- **持续改进计划**:基于反馈和评估结果,制定后续的持续改进计划,以持续提升系统性能。

```mermaid

flowchart LR

A[开始优化] --> B[制定优化方案]

B --> C[实施优化措施]

C --> D[实时监控性能]

D --> E[对比优化前后数据]

E --> F[收集用户和内部反馈]

F --> G[制定改进计划]

G --> H[结束优化流程]

H --> I[开始新的优化周期]

```

通过以上流程,我们可以确保优化工作得到持续的执行和改进,为 Il2CppDumper 或类似的解析工具带来长期的性能提升。

在这一章中,我们通过一个案例研究,详细描述了从初始性能评估到优化实施,再到最终效果评估的完整过程。通过具体实例,我们不仅深入理解了性能调优的各个方面,还掌握了一套系统的优化方法论。这些知识和技能的积累,对于IT行业中的从业者来说,是非常宝贵的经验财富。

# 6. ```

# 第六章:总结与展望

## 6.1 当前优化工作的总结

### 关键成就点

在性能调优的过程中,关键成就点在于我们对Il2CppDumper的解析机制有了更深层次的理解。通过细致的瓶颈分析和优化,我们成功地降低了Il2CppDumper在处理大型游戏或复杂应用程序时的解析时间和内存消耗。具体而言,优化工作主要集中在以下两个方面:

1. **算法层面的改进**:通过分析现有算法,我们识别并改进了一些耗时的处理步骤,如数据结构的选择和算法逻辑的优化,显著提升了整体性能。

2. **多线程与并行处理**:将解析任务分解为多个子任务,并利用多线程技术并行处理,大幅缩短了总的解析时间,同时优化了资源利用率。

### 遇到的挑战与解决方案

在优化过程中,我们也面临了多线程编程中常见的问题,如死锁和资源竞争。我们通过引入锁粒度优化和线程安全的数据结构来解决这些问题。此外,对于某些特定的性能瓶颈,我们尝试了多种优化方法,最终确定了最为有效的解决方案。

## 6.2 对未来性能调优的展望

### 新技术的发展趋势

展望未来,性能调优领域将紧密结合新兴技术的发展。目前,人工智能和机器学习技术在性能调优中的应用已经初露端倪。例如,通过机器学习模型预测性能瓶颈并提出优化建议,或是使用AI自动调整系统参数以实现最佳性能。

### Il2CppDumper未来优化方向

对于Il2CppDumper而言,未来可能的优化方向包括但不限于:

- **集成AI优化技术**:研究如何利用AI技术来自动识别和优化解析过程中的性能瓶颈。

- **云原生优化**:随着云计算的发展,Il2CppDumper可以在云环境中运行,利用云服务提供的弹性资源进行性能调优。

- **跨平台优化**:考虑到不同的硬件平台和操作系统,我们需要对Il2CppDumper进行跨平台优化,以确保在各个平台上都能保持最佳性能。

综合当前的技术发展和行业趋势,Il2CppDumper的性能调优工作将在保证现有成果的基础上,不断探索新技术的应用,并针对不同平台和场景进行深入优化。

```

0

0