MapReduce作业调优秘籍:细节决定招聘数据清洗成败

发布时间: 2025-01-08 23:03:20 阅读量: 6 订阅数: 7

MapReduce在招聘数据清洗中的综合应用案例

# 摘要

MapReduce作为一种分布式计算模型,广泛应用于大数据处理领域。本文首先概述了MapReduce作业调优的基本概念和核心理论,包括Map阶段和Reduce阶段的工作机制、任务调度的关键因素,以及性能评估和瓶颈分析方法。随后,详细探讨了Map和Reduce阶段的优化策略,参数调整技巧,并通过招聘数据清洗案例来说明调优策略的应用。进阶技巧章节深入分析了高级配置项、与Hadoop生态组件的联动,以及在大数据框架下的调优。最后,通过复杂场景下的案例分析,总结MapReduce作业调优的实践经验,并展望了其未来发展趋势。本文旨在为大数据处理提供有效的MapReduce调优参考,以提高数据处理效率和系统性能。

# 关键字

MapReduce;作业调优;性能分析;数据清洗;大数据;Hadoop生态

参考资源链接:[MapReduce招聘数据清洗应用案例分析](https://wenku.csdn.net/doc/7bpgi9riij?spm=1055.2635.3001.10343)

# 1. MapReduce作业调优概述

MapReduce是分布式计算领域的基石,而作业调优是提高其性能的关键。在大数据处理场景中,MapReduce作业调优关注的是如何在保证任务正确完成的基础上,尽可能地减少执行时间和资源消耗。本章节将对作业调优的必要性和一般方法进行概述,为读者提供MapReduce优化的整体认知框架。我们从理解MapReduce作业调优的含义出发,进而探讨其对于企业数据处理能力提升的重要性,最终揭示优化的潜在价值和应用前景。通过这一章节的学习,读者可以对后续章节中介绍的具体优化技巧和实践案例有一个清晰的预览,为深入理解后续复杂内容打下坚实基础。

# 2. MapReduce的核心理论

### 2.1 MapReduce工作原理

#### 2.1.1 Map阶段的工作机制

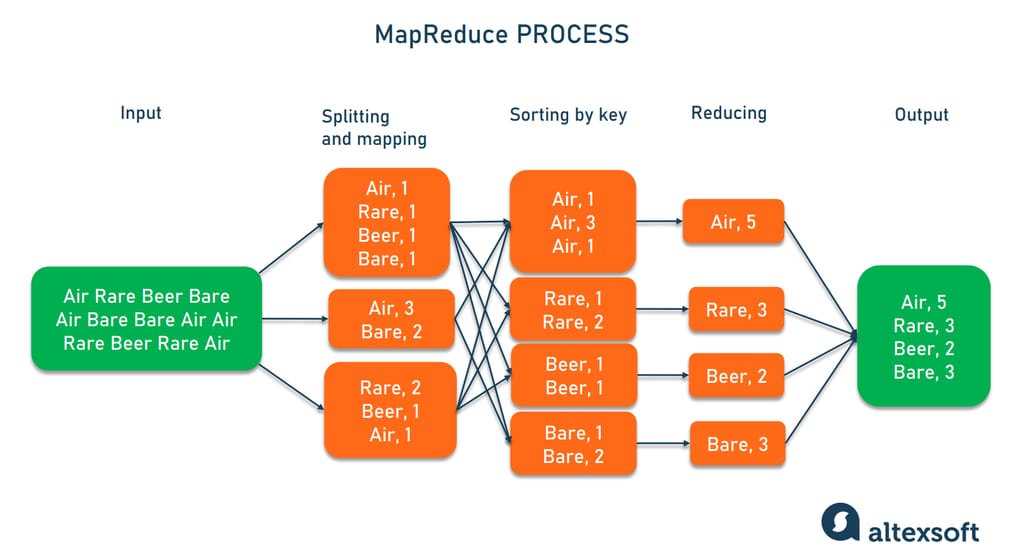

MapReduce模型的核心可以概括为两个阶段:Map阶段和Reduce阶段。Map阶段是数据处理的初始步骤,其主要职责是对输入的键值对(key-value pair)进行处理,将相同键(key)的数据聚集起来,并输出为中间键值对。

```java

public class WordCountMap extends Mapper<LongWritable, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 分割每行文本数据

String[] words = value.toString().split("\\s+");

// 遍历单词并输出

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

```

在上述代码中,Map函数对文本文件中的每一行进行处理,将其分割成单词,并对每个单词输出一个键值对。键(key)是单词本身,值(value)是数字1。

Map阶段的工作机制:

1. 输入数据分割:输入文件被分割成若干个小块,每个小块由一个Map任务处理。

2. 数据解析:Map任务对输入数据进行解析,将其转换为键值对。

3. 应用逻辑处理:对键值对进行处理,应用Map函数逻辑,将键值对转换为中间键值对。

4. 排序和分组:系统会对中间键值对进行排序,相同键的键值对会被分组在一起,以便于后续的Reduce阶段处理。

#### 2.1.2 Reduce阶段的数据处理流程

Reduce阶段接收Map阶段输出的中间键值对,并进行合并和处理,最终输出用户需要的结果。在这个阶段,所有具有相同键的中间值将被处理,以生成最终的键值对输出。

```java

public class WordCountReduce extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

// 对所有的value进行累加

for (IntWritable val : values) {

sum += val.get();

}

// 输出最终结果

context.write(key, new IntWritable(sum));

}

}

```

在上述代码中,Reduce函数对具有相同键的中间值进行累加操作,并输出每个单词的出现次数。

Reduce阶段的数据处理流程:

1. 收集和排序:系统首先会从所有Map任务中收集中间键值对,并对它们按照键进行排序。

2. 分组:具有相同键的键值对会被分组,形成一个值的列表。

3. Reduce操作:对每个键对应的值列表应用Reduce函数,生成最终的键值对结果。

4. 输出:最终结果通常会输出到HDFS或其他存储系统中。

### 2.2 MapReduce的任务调度

#### 2.2.1 任务调度的关键因素

在MapReduce框架中,任务调度是其核心功能之一,它负责将输入数据分配给Map任务和Reduce任务,以及监控任务的执行状态。任务调度的关键因素包括任务分配、资源分配、任务依赖、容错机制等。

- 任务分配:MapReduce的任务调度器需要将任务合理地分配给可用的资源,确保集群的负载均衡。

- 资源分配:资源管理器(如YARN中的ResourceManager)负责资源分配,包括内存、CPU和存储资源。

- 任务依赖:任务调度需要考虑任务之间的依赖关系,Map任务完成后,才能启动Reduce任务。

- 容错机制:MapReduce通过任务备份等机制实现容错,当某一个任务失败时,会重新调度该任务。

#### 2.2.2 任务调度策略与优化

为了提高MapReduce作业的执行效率,任务调度策略需要进行优化。常见的优化策略包括:

- 提前调度Map任务:在Reduce阶段开始之前尽可能多地完成Map任务。

- 数据本地性优化:优先在存储数据的节点上执行任务,以减少网络传输。

- 动态资源分配:根据当前作业的运行状态动态调整资源分配,以适应变化的工作负载。

### 2.3 MapReduce的性能分析

#### 2.3.1 性能评估指标

MapReduce作业的性能评估是调优过程中的关键步骤。性能评估的主要指标包括:

- 吞吐量:单位时间内处理的数据量。

- 响应时间:从作业提交到完成所需的时间。

- CPU和I/O使用率:评估资源使用情况的指标。

- 网络带宽使用:网络数据传输量的测量。

#### 2.3.2 性能瓶颈诊断与分析

性能瓶颈的诊断与分析可以通过以下方法进行:

- 日志分析:分析日志文件,寻找作业执行中的错误或警告信息。

- 资源监控:使用YARN的ResourceManager或操作系统工具监控资源使用情况。

- MapReduce性能计数器:使用MapReduce框架内置的性能计数器来监控任务执行情况。

通过这些方法,我们可以发现并解决性能瓶颈问题,进一步提高MapReduce作业的执行效率。

# 3. MapReduce作业调优实践技巧

## 3.1 Map阶段的优化策略

### 3.1.1 输入数据的优化处理

在MapReduce的Map阶段,输入数据的优化处理是提高作业效率的第一步。数据的优化涉及数据的预处理、数据格式的规范化以及数据分区策略的调整。数据预处理可以减少Map阶段的无效处理,例如去除噪声和不完整的数据记录。规范化数据格式可以提高数据处理的效率,例如使用更紧凑的数据编码,减少存储和网络传输中的数据量。

数据分区策略的调整是MapReduce作业调优中的一个关键步骤。合理的数据分区可以保证数据被均匀地分配到不同的Map任务中,从而避免某些Map任务处理时间过长而成为瓶颈。

```java

// 示例代码:实现一个简单的自定义数据分区策略

public class CustomPartitioner extends Partitione

```

0

0