双色球预测的线性回归到多元回归分析:一步步走向Python数据分析高手

发布时间: 2024-12-19 21:26:03 阅读量: 10 订阅数: 7

Python数据分析之双色球基于线性回归算法预测下期中奖结果示例

# 摘要

本文全面探讨了双色球预测与数据分析的理论与实践,从线性回归和多元回归的基础理论出发,深入分析了其在双色球预测中的应用。通过Python语言的实践案例,本文阐述了如何构建和优化预测模型,包括数据预处理、特征工程、模型选择和训练、以及模型评估与迭代。同时,文章还探讨了数据可视化技术和机器学习在数据分析中的拓展应用,并对未来大数据分析和深度学习在预测分析中的发展趋势进行了展望。

# 关键字

双色球预测;数据分析;线性回归;多元回归;Python;机器学习

参考资源链接:[Python数据分析之双色球基于线性回归算法预测下期中奖结果示例](https://wenku.csdn.net/doc/6401ac0acce7214c316ea688?spm=1055.2635.3001.10343)

# 1. 双色球预测与数据分析基础

## 1.1 双色球与数据分析的关系

双色球作为一项广受关注的彩票游戏,吸引众多彩民尝试分析开奖数据以预测未来走势。数据分析在这里扮演着重要角色,通过对历史开奖记录的深入挖掘,可以揭示数据背后可能的规律性特征。尽管彩票结果本质上是随机的,但应用合适的数据科学方法,我们可以尝试构建预测模型来辅助决策。

## 1.2 数据收集的挑战和解决方案

准确预测双色球号码,首先面临的是数据收集问题。有效的数据收集要求我们从权威渠道获取准确的开奖历史数据。在这个基础上,进行数据清洗和格式化,确保数据质量。对于缺失值或异常值,需要采用合理的方法进行处理,以提高数据分析的准确性。

## 1.3 数据分析的基本原则

在进行双色球预测分析时,数据分析的基本原则包括:

- **探索性数据分析(EDA)**:通过可视化和统计分析初步了解数据的特征。

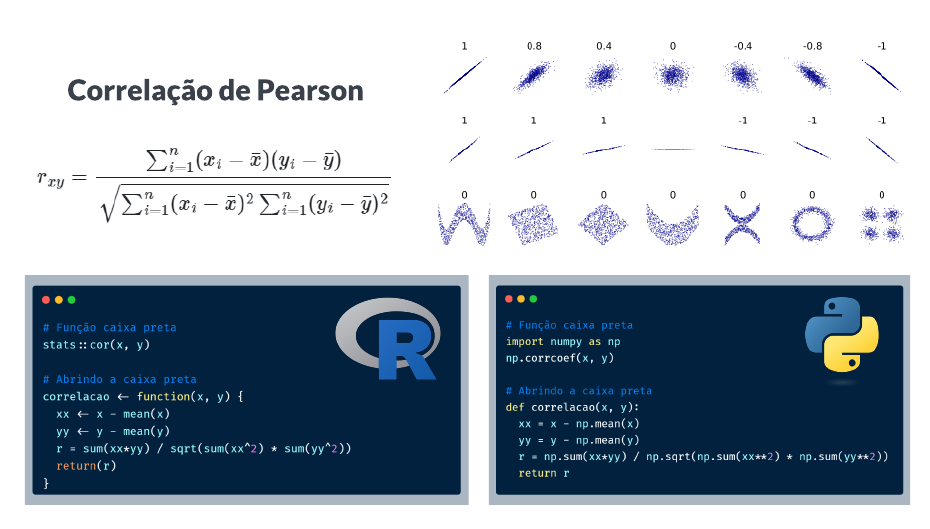

- **相关性分析**:探究不同号码之间的关联性,挑选可能影响结果的因素。

- **假设检验**:构建假设并使用统计检验来评估预测模型的有效性。

双色球预测与数据分析相结合,不仅可以提供一种有趣的实操场景,同时也能锻炼数据科学思维和实践技能。

# 2. 线性回归分析

## 2.1 线性回归理论基础

### 2.1.1 线性回归模型简介

线性回归是统计学中应用最为广泛的预测分析方法之一。它旨在建立一个或多个自变量与因变量之间的线性关系模型。在双色球预测的场景下,我们可以把历史开奖数据的各个特征(如开奖号码的分布、频率、前几期的开奖结果等)作为自变量,将我们希望预测的某一期的开奖结果作为因变量。通过线性回归模型,我们能够根据历史数据推导出预测模型,并进一步应用到新的数据上进行预测。

### 2.1.2 线性回归的数学原理

线性回归的核心是找到一个线性方程式,使得该方程式能够最好地描述自变量和因变量之间的关系。这个线性方程式通常写作:

\[ y = \beta_0 + \beta_1x_1 + \beta_2x_2 + ... + \beta_nx_n + \epsilon \]

其中,\(y\)是因变量,\(x_1, x_2, ..., x_n\)是自变量,\(\beta_0, \beta_1, ..., \beta_n\)是回归系数,\(\epsilon\)代表误差项。回归系数的估计通常采用最小二乘法,其目标是最小化所有数据点的误差平方和。通过这种方法,我们能够得到一个具体的模型,用来描述变量之间的关系。

## 2.2 线性回归的Python实践

### 2.2.1 使用scikit-learn实现线性回归

Python的scikit-learn库提供了简洁易用的API来进行线性回归分析。下面是一个简单的示例代码,展示了如何使用scikit-learn实现线性回归模型:

```python

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

import numpy as np

# 假设X是特征矩阵,y是目标向量

X = np.array([[1, 2], [2, 3], [3, 4], [4, 5]])

y = np.array([5, 6, 7, 8])

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建线性回归模型实例

model = LinearRegression()

# 训练模型

model.fit(X_train, y_train)

# 预测测试集结果

y_pred = model.predict(X_test)

# 评估模型

mse = mean_squared_error(y_test, y_pred)

print(f"Mean Squared Error: {mse}")

```

在上述代码中,我们首先导入了必要的库,然后创建了特征矩阵`X`和目标向量`y`。通过`train_test_split`函数划分了训练集和测试集。之后,我们实例化了`LinearRegression`模型,并使用训练集数据对其进行了训练。最后,我们在测试集上进行预测,并计算了模型的均方误差(MSE),作为模型性能的评估。

### 2.2.2 模型评估与验证方法

模型评估和验证是确保模型泛化能力的关键步骤。在Python中,除了计算MSE之外,我们还可以采用以下方法进行模型评估:

- R-squared(R²):表示模型预测值和实际值之间的相关系数,其值越接近1,说明模型的拟合效果越好。

- Adjusted R-squared:R-squared的一个改进版本,对变量数量的增加进行了惩罚,更适用于多个特征的情况。

- F-test(F检验):用于测试模型中至少有一个系数不为零的假设,从而判断模型是否整体上对数据有统计学意义。

### 2.2.3 特征选择与模型调优

在构建线性回归模型时,特征选择和模型调优是提高模型性能的重要环节。我们可以使用以下方法进行特征选择和模型调优:

- 向前选择(Forward Selection):逐步增加特征到模型中,直到添加新特征无法显著提高模型性能为止。

- 向后消除(Backward Elimination):从一个包含所有特征的模型开始,逐步剔除不重要的特征。

- 正则化方法(如Lasso和Ridge回归):通过给回归系数添加惩罚项,能够有效控制模型复杂度,并防止过拟合。

下面是一个使用Ridge回归进行模型调优的示例代码:

```python

from sklearn.linear_model import Ridge

from sklearn.model_selection import GridSearchCV

# Ridge回归模型实例

ridge_model = Ridge()

# 使用交叉验证进行模型调优

parameters = {'alpha': [0.01, 0.1, 1, 10, 100]}

ridge_grid = GridSearchCV(ridge_model, parameters, scoring='neg_mean_squared_error', cv=5)

ridge_grid.fit(X_train, y_train)

# 输出最佳参数和最佳得分

print(f"Best parameters: {ridge_grid.best_params_}")

print(f"Best score: {-ridge_grid.best_score_}")

```

在这段代码中,我们使用了`GridSearchCV`来进行网格搜索,尝试不同的`alpha`值来找到最佳的Ridge回归模型参数。`scoring`参数设置为负均方误差(neg_mean_squared_error),这是因为`GridSearchCV`默认寻找得分最高的模型,而`Ridge`模型的`score`方法返回的是负均方误差值。

经过以上步骤,我们可以构建并优化线性回归模型,最终应用于双色球预测的实际问题。通过理解模型的理论基础,并掌握Python中的实践操作,我们可以逐步提升预测的准确性和模型的稳健性。

# 3. 多元回归分析

## 3.1 多元回归理论基础

### 3.1.1 多元回归模型概念

多元回归分析是统计学中的一种方法,用于研究两个或多个自变量(独立变量)与因变量(依赖变量)之间的关系。在双色球预测的背景下,自变量可能是历史开奖数据中的多个特征,如不同期数的中奖号码、开奖时间等,而因变量是最终的预测结果,如下一期的中奖号码出现的概率分布。

多元回归模型的一般形式可以表示为:

\[ y = \beta_0 + \beta_1x_1 + \beta_2x_2 + ... + \beta_nx_n + \epsilon \]

其中,\(y\) 是因变量,\(x_1, x_2, ..., x_n\) 是自变量,\(\beta_0\) 是截距项,\(\beta_1, \beta_2, ..., \beta_n\) 是各个自变量的系数,\(\epsilon\) 是误差项,代表了模型未能捕捉到的随机误差。

### 3.1.2 多元回归模型的数学表述

在数学上,多元回归模型可以通过最小二乘法来估计回归系数。基本思想是找到一组系数,使得所有观测值与模型预测值之间的残差平方和最小。这可以通过以下公式来表示:

\[ \min_{\beta} \sum_{i=1}^{n}(y_i - (\beta_0 + \sum_{j=1}^{p}\beta_jx_{ij}))^2 \]

上述公式中,\(n\) 表示样本数量,\(p\) 表示自变量的数量,\(y_i\) 是第 \(i\) 个样本的因变量值,\(x_{ij}\) 是第 \(i\) 个样本的第 \(j\) 个自变量值。

## 3.2 多元回归的Python实践

### 3.2.1 构建多元回归模型

要使用Python构建多元回归模型,我们可以借助scikit-learn库。以下是构建模型的步骤和示例代码:

1. 准备数据集,确保自变量和因变量已经正确赋值。

2. 划分数据

0

0