流处理框架大比拼:Flink与Spark Streaming选型攻略

发布时间: 2024-12-27 10:19:04 阅读量: 9 订阅数: 10

大数据处理神器:Fire框架开源源码,助力Spark与Flink任务高效开发

# 摘要

流处理框架作为大数据实时处理的关键技术,近年来得到快速发展。本文首先介绍了流处理框架的基本概念和发展历程,然后深入解析了Flink的核心技术,包括其数据处理模型、API编程模型和性能优化策略。接着,文章对Spark Streaming进行了深入探讨,分析了其数据处理架构、编程接口和性能调优方法。本文还进行了Flink与Spark Streaming的对比分析,从功能特性、性能效率、生态系统和社区支持等方面进行了评估。最后,文章探讨了如何根据业务需求选择流处理框架,并通过实际案例展示了流处理框架在不同应用场景中的应用。本文旨在为流处理框架的选择和应用提供理论指导和实践参考。

# 关键字

流处理框架;Flink;Spark Streaming;数据处理模型;性能优化;实时性要求

参考资源链接:[Apache Kafka与MapR Streams推动实时流处理新设计](https://wenku.csdn.net/doc/6475a507d12cbe7ec319c222?spm=1055.2635.3001.10343)

# 1. 流处理框架的基本概念和发展

流处理作为一种实时数据处理方式,在大数据技术中占据着举足轻重的地位。它使得应用程序能够以较低的延迟处理连续的数据流,对于需要快速响应的场景至关重要。随着技术的进步,流处理框架经历了从简单的流式计算到复杂的数据处理的演变。

## 1.1 流处理框架的起源

流处理框架起源于早期的简单消息队列处理,如Apache Kafka的消费者模型,之后发展成为具有复杂状态管理和精确时间控制的系统。例如,Apache Storm引入了实时计算的概念,它能够以极低的延迟处理无限的数据流。

## 1.2 流处理的发展里程碑

随着时间的推移,流处理框架不断发展和完善,出现了以Apache Flink和Spark Streaming为代表的现代流处理系统。这些框架支持更复杂的计算模型,如事件时间和状态管理,并提供了高度优化的执行引擎来处理大规模数据集。

## 1.3 流处理框架的现代应用

现代流处理框架被广泛应用于实时分析、监控系统、物联网、金融服务等多个领域。它们能够帮助企业和组织快速从数据流中获取洞察,并作出及时决策。本章节将对流处理框架的演进及其核心概念进行详细介绍,为后续章节中对特定框架的深入解析打下基础。

# 2. Flink核心技术解析

## 2.1 Flink的数据处理模型

### 2.1.1 Flink的时间概念和事件时间

Apache Flink中关于时间的理解是流处理的核心之一,它提供了三种时间概念:处理时间(Processing Time)、事件时间(Event Time)和摄入时间(Ingestion Time)。处理时间是最简单的概念,指的是数据进入流处理器的时间。事件时间则是数据生成时的时间戳,这通常记录在数据本身,是事件实际发生的顺序。摄入时间是Flink特有的概念,是指事件被流处理器读取并开始处理的时间。

Flink的事件时间依赖于水印(Watermarks)来处理乱序事件,并提供窗口(Window)操作来聚合事件。为了理解水印的作用,考虑一个实际的流处理场景,比如一个消息流包含了连续的传感器数据,其中传感器可能因为网络波动导致数据延时。在事件时间模式下,Flink通过水印来追踪事件的时间戳,并决定何时将数据推进窗口进行计算。如果水印时间到达了某个窗口的结束时间,即使尚有早于结束时间的事件到来,也会触发窗口函数进行计算。

```java

WatermarkStrategy.forBoundedOutOfOrderness(Duration.ofSeconds(20))

.withTimestampAssigner((event, timestamp) -> event.getEventTime());

```

在这段代码中,我们定义了一个水印策略,该策略允许最多20秒的事件时间乱序。`withTimestampAssigner`用于指定如何从事件中提取时间戳。这种处理方式极大地提升了流处理的灵活性和准确性,特别是在应对网络延迟和不规则数据到达的情况下。

### 2.1.2 Flink的状态管理和容错机制

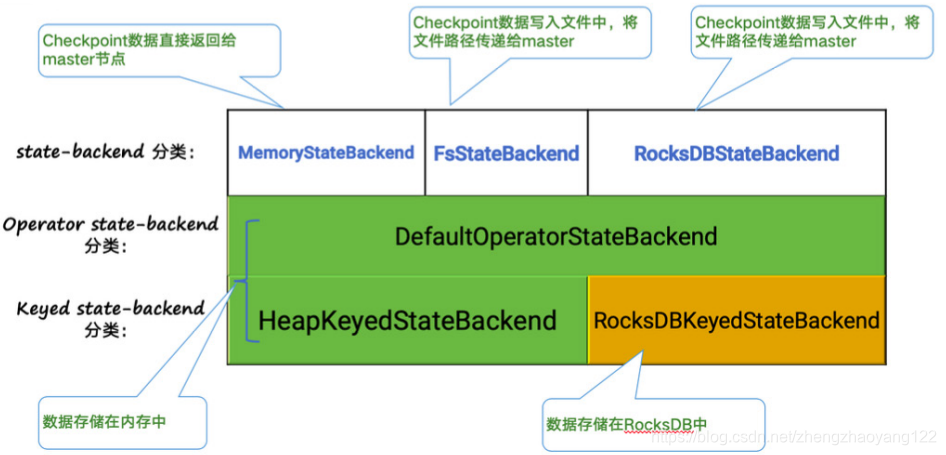

状态管理是任何流处理系统中的核心组件,特别是在需要准确处理复杂业务逻辑和保证容错的情况下。Flink通过其状态后端(State Backend)和检查点机制(Checkpointing)来实现状态的持久化和容错。

Flink提供了丰富的状态管理接口,允许开发者在不同级别上管理状态,包括Keyed State和Operator State。Keyed State与特定的键(key)关联,而Operator State则与算子(operator)关联。Flink通过周期性地执行检查点操作来确保状态的一致性。一旦发生故障,Flink可以从最近的成功检查点恢复,保证了精确一次(exactly-once)的状态一致性。

```java

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.enableCheckpointing(10000); // Checkpoint every 10 seconds

env.setStateBackend(new RocksDBStateBackend("file:///path/to/rocksdb/checkpoints"));

```

在这段代码中,我们首先启用了检查点机制,并设置了10秒的间隔,然后配置了RocksDB作为状态后端用于状态的持久化。RocksDB是一种高效的嵌入式键值存储系统,它特别适合处理大数据量的随机读写操作。因此,Flink选用RocksDB作为状态后端,以便在提供高可用性和高吞吐量的同时,有效管理状态。

## 2.2 Flink的API和编程模型

### 2.2.1 DataStream API

DataStream API是Flink处理实时数据流的主要API,它提供了一系列操作来转换和处理流数据。DataStream API是一种低级API,允许用户以函数式编程风格操作数据流,并使用丰富的转换操作,例如`map`、`flatMap`、`filter`、`reduce`等。

在DataStream API中,用户可以定义自己的业务逻辑,并将其应用于流数据。例如,一个常见的数据转换流程可能包括从源读取数据、应用转换操作,最后将结果写入外部系统。下面的代码展示了一个简单例子,它从一个socket读取文本数据,并过滤掉空行。

```java

DataStream<String> text = env.socketTextStream("localhost", 9999);

DataStream<String> filtered = text.filter(line -> !line.isEmpty());

filtered.writeAsText("outputPath");

env.execute("Filter Empty Lines Example");

```

在这个例子中,我们首先创建了一个`DataStream`来表示从本地主机的9999端口接收的文本流。然后我们使用`filter`操作来过滤掉空行,并将结果写入到一个指定的路径。最后,我们调用`execute`来启动流处理作业。

### 2.2.2 DataSet API

与DataStream API对应的是DataSet API,后者用于批处理,即处理有界数据集。尽管Flink的主要特色是流处理,但其底层的执行模型同样支持批量计算。DataSet API提供了丰富的批处理操作,例如`map`、`reduce`、`join`等,并允许对静态数据集进行高效处理。

DataSet API的设计理念类似于DataStream API,使得用户可以以几乎相同的方式编写流处理和批处理程序。通过这种方式,Flink提供了一致的编程模型,无论数据是有界还是无界。

### 2.2.3 Table & SQL API

Flink还提供了一个高级API,即Table API和SQL,用于对数据流和批数据进行声明式查询。Table API允许用户以链式调用的方式组合数据操作,并直接在表上执行查询。结合SQL,Flink可以执行标准的SQL查询,并提供了丰富的SQL函数库。

Table API和SQL API为数据分析师和熟悉SQL的用户提供了一种直观且易于理解的数据操作方式。它抽象了底层的计算细节,允许用户专注于数据的逻辑处理。下面是一个简单的SQL查询示例,它查询了一个数据表并找出其中的Top N条记录。

```java

// 假设有一个Table对象叫做inputTable,其中包含了某数据流的动态数据

Table topK = inputTable.groupBy("key")

.select("key, value.sum as sumValue")

.orderBy("sumValue

```

0

0