【Python JSON处理的艺术】:深入simplejson.decoder的8大高级用法

发布时间: 2024-10-14 00:00:22 阅读量: 55 订阅数: 39

【Python源码】simplejson:Python 的 JSON 编码、解码器

# 1. Python JSON处理基础

Python提供了丰富的库来处理JSON数据,其中最常用的莫过于内置的`json`库。然而,对于处理大型JSON文件或需要更高效解析的场景,`simplejson`库则显得更为出色。在本章中,我们将从基础开始,了解如何使用Python内置的`json`库处理JSON数据,包括编码与解码的基本方法,以及如何将这些知识应用到实际开发中。

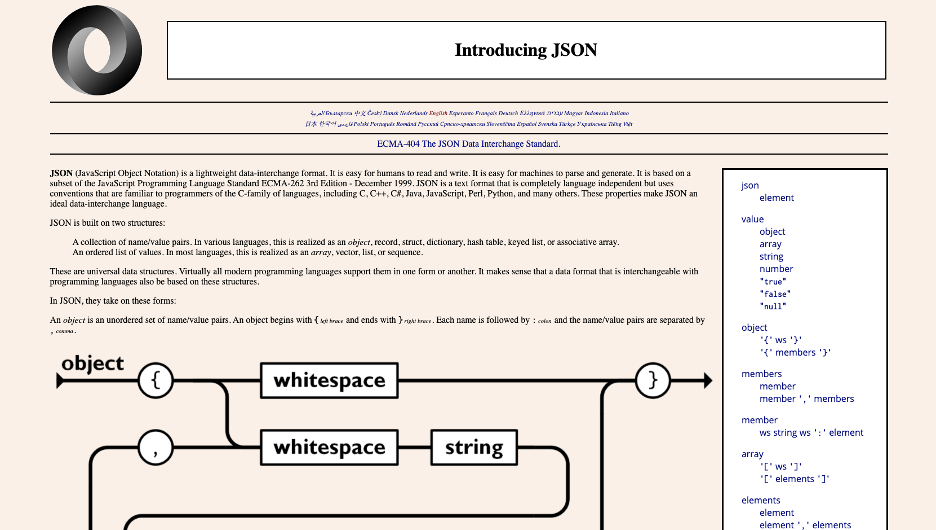

## 1.1 JSON数据编码与解码

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。Python中的`json`库可以让我们轻松地编码(将Python对象转换为JSON格式)和解码(将JSON格式转换回Python对象)。

```python

import json

# Python对象转换为JSON格式的字符串

python_object = {'name': 'John', 'age': 30, 'city': 'New York'}

json_string = json.dumps(python_object)

print(json_string) # 输出: {"name": "John", "age": 30, "city": "New York"}

# JSON格式的字符串转换回Python对象

python_object_from_json = json.loads(json_string)

print(python_object_from_json) # 输出: {'name': 'John', 'age': 30, 'city': 'New York'}

```

在上述代码中,`json.dumps()`函数用于将Python对象编码为JSON格式的字符串,而`json.loads()`函数则用于将JSON格式的字符串解码为Python对象。这两种基本的操作是处理JSON数据的起点,为后续更复杂的数据处理打下基础。

# 2. simplejson.decoder核心功能解析

## 2.1 解析JSON数据的基本方法

### 2.1.1 使用simplejson.load()解析文件

在Python中处理JSON数据时,`simplejson`库提供了一个非常方便的接口来从文件中加载JSON数据。`simplejson.load()`函数可以直接读取JSON格式的文件,并将其内容转换为Python的数据结构。

```python

import simplejson

# 打开JSON文件

with open('data.json', 'r', encoding='utf-8') as f:

# 使用simplejson.load()函数解析JSON文件

data = simplejson.load(f)

# 打印解析后的数据结构

print(data)

```

在上面的代码示例中,我们首先导入了`simplejson`模块。然后使用`with open()`语句以读取模式打开一个名为`data.json`的文件。这个文件包含了JSON格式的数据。`simplejson.load(f)`函数读取文件对象`f`中的内容,并将其解析为Python的数据结构,例如字典或列表。最后,我们打印出解析后的数据以验证其内容。

### 2.1.2 使用simplejson.loads()解析字符串

除了从文件中加载JSON数据外,`simplejson`还提供了一个函数`simplejson.loads()`,用于解析JSON格式的字符串。这在处理动态生成的JSON数据或从网络请求中获取JSON数据时非常有用。

```python

import simplejson

# 定义一个JSON格式的字符串

json_str = '{"name": "John", "age": 30, "city": "New York"}'

# 使用simplejson.loads()函数解析JSON字符串

data = simplejson.loads(json_str)

# 打印解析后的数据结构

print(data)

```

在这个例子中,我们定义了一个包含JSON数据的字符串`json_str`。`simplejson.loads(json_str)`函数将这个字符串解析为Python的数据结构。我们再次打印出解析后的数据来查看其内容。

### 2.1.1 使用simplejson.dump()和simplejson.dumps()

除了加载JSON数据,`simplejson`库还可以用来将Python数据结构转换成JSON格式的字符串或写入文件。这在需要将数据序列化为JSON格式以便于存储或传输时非常有用。

```python

import simplejson

# 定义一个字典

data = {"name": "John", "age": 30, "city": "New York"}

# 将字典转换为JSON格式的字符串

json_str = simplejson.dumps(data)

# 打印转换后的JSON字符串

print(json_str)

# 将字典写入文件

with open('data.json', 'w') as f:

simplejson.dump(data, f)

```

在这个示例中,我们首先导入了`simplejson`模块,并定义了一个包含用户信息的字典`data`。使用`simplejson.dumps(data)`函数将字典转换为JSON格式的字符串并打印出来。接着,我们使用`with open()`语句以写入模式打开一个名为`data.json`的文件,并使用`simplejson.dump(data, f)`函数将字典写入该文件。

通过本章节的介绍,我们可以了解到`simplejson`库提供了多种方法来处理JSON数据,无论是从文件中加载JSON数据、解析JSON字符串,还是将Python数据结构转换成JSON格式。这些基本的解析和序列化功能为我们在后续章节中学习更高级的JSON处理技术打下了坚实的基础。

在本章节中,我们重点介绍了`simplejson.load()`和`simplejson.loads()`两个函数的使用方法,它们分别用于从文件中加载和从字符串中解析JSON数据。同时,我们也展示了`simplejson.dumps()`和`simplejson.dump()`两个函数的用法,它们用于将Python数据结构转换为JSON格式的字符串或写入文件。这些函数是`simplejson`库的核心功能之一,它们使得处理JSON数据变得简单而高效。

# 3. 自定义JSON编码与解码

在本章节中,我们将深入探讨如何在使用Python进行JSON数据处理时实现自定义的编码器和解码器。这一能力对于处理复杂数据结构以及特定业务逻辑非常关键。我们将从何时需要自定义编码器和解码器开始,逐步深入到如何实现它们的细节。

## 3.1 创建自定义编码器

### 3.1.1 何时需要自定义编码器

在处理JSON数据时,我们可能会遇到一些特殊的数据类型或者复杂的对象结构,这些通常无法通过标准的JSON编码方式直接转换。例如,Python中的`datetime`对象、自定义的类实例或者包含文件句柄等资源的数据结构。这些情况下,我们需要定义自己的编码器来告诉`simplejson`如何将这些特殊对象转换为JSON格式。

### 3.1.2 实现自定义编码器

为了创建一个自定义编码器,我们可以通过继承`JSONEncoder`类并重写其`default`方法来实现。在`default`方法中,我们可以定义如何将自定义对象编码为JSON格式。

```python

import json

from datetime import datetime

class CustomJSONEncoder(json.JSONEncoder):

def default(self, obj):

if isinstance(obj, datetime):

# 将datetime对象转换为ISO格式的字符串

return obj.isoformat()

elif hasattr(obj, '__json_encoder__'):

# 如果对象有自定义的编码器方法

return obj.__json_encoder__()

# 调用父类的default方法处理其他情况

return json.JSONEncoder.default(self, obj)

# 使用自定义编码器

data = {

'timestamp': datetime.now(),

'custom': CustomObject() # 假设CustomObject是我们需要编码的自定义类

}

json_data = json.dumps(data, cls=CustomJSONEncoder)

print(json_data)

```

在上面的代码中,我们定义了一个`CustomJSONEncoder`类,它能够处理`datetime`对象和自定义的`CustomObject`类。`default`方法首先检查对象类型,如果是`datetime`,则转换为ISO格式字符串;如果是自定义类,尝试调用其`__json_encoder__`方法进行编码;否则,调用父类的`default`方法。

## 3.2 创建自定义解码器

### 3.2.1 何时需要自定义解码器

自定义解码器的需求较少,通常出现在需要将JSON数据反序列化为特定的Python对象时。例如,如果JSON数据来源于外部API,并且我们希望将某些特定字段自动转换为Python对象,而不是默认的字典或列表,这时就需要自定义解码器。

### 3.2.2 实现自定义解码器

自定义解码器的实现涉及到继承`JSONDecoder`类并重写其`object_hook`方法。`object_hook`方法会在每次解析出一个JSON对象时被调用,我们可以在这个方法中修改解析后的对象。

```python

class CustomJSONDecoder(json.JSONDecoder):

def object_hook(self, obj):

for key, value in obj.items():

if key == 'timestamp':

# 将ISO格式的时间字符串转换为datetime对象

obj[key] = datetime.fromisoformat(value)

return obj

# 使用自定义解码器

json_data = '{"timestamp": "2023-04-01T12:00:00", "custom": {}}'

data = json.loads(json_data, cls=CustomJSONDecoder)

print(data)

```

在上面的代码中,我们定义了一个`CustomJSONDecoder`类,它在解析JSON时会检查每个键值对。如果键是`timestamp`,则将对应的值从ISO格式的时间字符串转换为`datetime`对象。

### 参数说明

- `datetime.fromisoformat(value)`: 这是一个Python标准库中的函数,用于将ISO格式的时间字符串转换为`datetime`对象。

### 代码逻辑解读

- `object_hook`方法接收一个字典对象`obj`作为参数,这个字典代表了JSON解析过程中的一个对象。

- `for key, value in obj.items()`: 遍历字典中的每个键值对。

- `if key == 'timestamp'`: 检查键是否是我们需要特殊处理的`timestamp`。

- `datetime.fromisoformat(value)`: 如果键是`timestamp`,则调用`datetime.fromisoformat`将字符串转换为`datetime`对象。

- `return obj`: 返回修改后的字典。

通过本章节的介绍,我们了解了如何在处理JSON数据时创建自定义的编码器和解码器,这对于处理复杂数据结构和特定业务逻辑非常有用。在实际开发中,这些技术可以帮助我们更好地控制数据的序列化和反序列化过程。

# 4. 处理特殊数据类型

在本章节中,我们将深入探讨在使用Python进行JSON处理时,如何处理特殊数据类型,包括复杂的数据结构以及嵌套的JSON结构和二进制数据。这些是日常工作中经常遇到的挑战,掌握它们的处理方法能够显著提升我们的工作效率和代码质量。

## 4.1 处理复杂的数据结构

处理复杂的数据结构是JSON数据处理中的一个重要环节。在本小节中,我们将详细讨论如何处理时间戳和日期以及Python特有的数据类型。

### 4.1.1 处理时间戳和日期

JSON本身并不直接支持时间戳或日期类型,而是以字符串形式表达。在Python中,我们通常使用`datetime`模块来处理日期和时间。当需要将Python中的`datetime`对象转换为JSON格式时,可以使用`simplejson`提供的`default`参数来指定自定义的编码方法。

```python

import datetime

import simplejson

def default_handler(obj):

if isinstance(obj, datetime.datetime):

return obj.isoformat()

return obj

data = {

'timestamp': datetime.datetime.now()

}

json_data = simplejson.dumps(data, default=default_handler)

print(json_data)

```

在上述代码中,`default_handler`函数会检查每个对象是否为`datetime.datetime`类型,如果是,则将其转换为ISO格式的字符串。这样,我们就可以确保时间信息能够正确地被序列化为JSON格式。

### 4.1.2 处理Python特有的数据类型

Python有一些特有的数据类型,如`set`、`frozenset`等,这些类型在JSON中没有直接对应的数据类型。在序列化时,通常需要将它们转换为列表(`list`)或字典(`dict`)等JSON支持的数据类型。

```python

import simplejson

def default_handler(obj):

if isinstance(obj, set):

return list(obj)

return obj

data = {

'my_set': {1, 2, 3}

}

json_data = simplejson.dumps(data, default=default_handler)

print(json_data)

```

在上述代码中,`default_handler`函数将集合(`set`)转换为列表(`list`),使其能够被`simplejson.dumps`正确处理。

### 4.2 高级用法

在处理JSON数据时,我们经常遇到一些高级用法,如嵌套的JSON结构和二进制数据。这些用法需要我们更深入地理解JSON的结构和Python的序列化机制。

#### 4.2.1 处理嵌套的JSON结构

嵌套的JSON结构是实际应用中常见的场景,例如,一个JSON对象中包含另一个JSON对象作为其属性值。在Python中,我们可以通过递归的方式来处理这种嵌套结构。

```python

import simplejson

def encode_json(obj):

if isinstance(obj, dict):

return {k: encode_json(v) for k, v in obj.items()}

elif isinstance(obj, list):

return [encode_json(item) for item in obj]

else:

return obj

data = {

'user': {

'name': 'Alice',

'age': 30,

'profile': {

'email': '***'

}

}

}

json_data = simplejson.dumps(data, default=encode_json)

print(json_data)

```

在上述代码中,`encode_json`函数递归地处理字典和列表类型的对象,确保所有的嵌套结构都能被正确地序列化。

#### 4.2.2 处理JSON中的二进制数据

处理JSON中的二进制数据是另一个高级用法。通常,二进制数据会被转换为Base64编码的字符串。在Python中,我们可以使用`base64`模块来进行这种转换。

```python

import base64

import simplejson

def default_handler(obj):

if isinstance(obj, bytes):

return base64.b64encode(obj).decode('utf-8')

return obj

data = {

'binary_data': b'\x01\x02\x03\x04'

}

json_data = simplejson.dumps(data, default=default_handler)

print(json_data)

```

在上述代码中,`default_handler`函数将二进制数据转换为Base64编码的字符串,使其能够被`simplejson.dumps`正确处理。

在本章节中,我们详细讨论了如何处理特殊的数据结构,包括时间戳和日期以及Python特有的数据类型。此外,我们还探讨了嵌套的JSON结构和二进制数据的处理方法。通过这些知识,我们可以更加高效地处理复杂的JSON数据,并将其应用到实际工作中。

# 5. 性能优化与内存管理

在处理JSON数据时,性能优化和内存管理是两个重要的考量因素,尤其是在处理大型数据集或高并发场景下。本章节将深入探讨如何优化JSON解析性能以及如何进行有效的内存管理。

## 5.1 优化JSON解析性能

优化JSON解析性能是提高应用程序响应速度和处理能力的关键。在本小节中,我们将介绍性能分析工具以及提升解析速度的策略。

### 5.1.1 性能分析工具

为了优化JSON解析性能,首先需要了解当前的性能状况。性能分析工具可以帮助我们识别瓶颈所在,从而有针对性地进行优化。常用的性能分析工具有:

- **cProfile**: Python内置的性能分析工具,可以分析代码的调用时间和次数。

- **line_profiler**: 一个用于分析代码行执行时间的工具,适合对特定函数进行深入分析。

- **memory_profiler**: 分析程序的内存使用情况。

通过这些工具,我们可以获取到函数执行的时间和内存消耗的详细报告,从而找到性能瓶颈。

```python

# 示例代码:使用cProfile进行性能分析

import cProfile

import pstats

def example_function():

# 这里是示例函数,用于展示性能分析

pass

cProfile.run('example_function()', sort='cumulative')

p = pstats.Stats('profile.out')

p.sort_stats('cumulative').print_stats(10)

```

### 5.1.2 提升解析速度的策略

提升JSON解析速度的策略主要包括以下几个方面:

#### *.*.*.* 预解析

预解析是指在解析JSON之前,先进行一次预处理,去除不必要的数据或进行数据格式的简化。

```python

import simplejson

# 示例代码:预解析JSON数据

def preprocess_json(json_data):

# 这里添加预解析的逻辑

return json_data

json_data = preprocess_json(raw_json)

data = simplejson.loads(json_data)

```

#### *.*.*.* 并行解析

对于大型JSON文件,可以考虑使用并行解析来提升速度。Python的`concurrent.futures`模块可以方便地实现这一目标。

```python

import concurrent.futures

import simplejson

def parse_chunk(chunk):

return simplejson.loads(chunk)

def parallel_parse(json_data):

chunks = split_into_chunks(json_data) # 假设这个函数将数据分割成多个块

with concurrent.futures.ThreadPoolExecutor() as executor:

return list(executor.map(parse_chunk, chunks))

```

#### *.*.*.* 缓存解析结果

如果相同的JSON数据需要多次解析,可以考虑将解析结果缓存起来,避免重复解析。

```python

import functools

import simplejson

@functools.lru_cache(maxsize=None)

def parse_and_cache(json_data):

return simplejson.loads(json_data)

# 使用缓存

data = parse_and_cache(raw_json)

```

## 5.2 内存管理技巧

在处理JSON数据时,内存管理同样重要。不当的内存使用可能导致内存泄漏,影响程序的性能和稳定性。

### 5.2.1 理解内存消耗

要进行有效的内存管理,首先需要理解程序的内存消耗情况。Python提供了`memory_profiler`工具来帮助我们分析内存使用。

```python

# 示例代码:使用memory_profiler分析内存消耗

from memory_profiler import memory_usage

def memory_usage_example():

# 这里添加示例代码,分析内存消耗

pass

memory_usage((memory_usage_example,), interval=0.01)

```

### 5.2.2 内存优化实践

#### *.*.*.* 使用生成器

使用生成器可以减少内存消耗,因为它允许逐个处理数据,而不是一次性加载整个数据集。

```python

def generate_items():

# 这里是生成器函数,逐个产生数据项

pass

for item in generate_items():

# 处理每个数据项

pass

```

#### *.*.*.* 对象共享

在处理大型数据结构时,如果多个对象包含相同的数据,可以考虑使用对象共享来减少内存使用。

```python

import copy

shared_data = {'key': 'value'}

obj1 = {'data': shared_data}

obj2 = copy.deepcopy({'data': shared_data})

# obj1和obj2中的data共享内存地址

```

#### *.*.*.* 清理不再使用的对象

及时清理不再使用的对象可以释放内存。Python的`gc`模块可以帮助我们识别和回收不再使用的对象。

```python

import gc

# 示例代码:强制执行垃圾回收

gc.collect()

```

通过本章节的介绍,我们了解了如何使用性能分析工具来诊断JSON解析的性能瓶颈,以及如何通过各种策略来提升解析速度。同时,我们也学习了内存管理的基本技巧,包括使用生成器、对象共享和清理不再使用的对象。这些知识和技巧将帮助我们在处理大型JSON数据集时,保持应用程序的高性能和稳定性。

# 6. 实战案例分析

处理大型JSON文件是每个数据工程师和后端开发人员经常遇到的挑战。随着数据量的增加,传统的加载和解析方法可能会导致内存溢出或性能瓶颈。在本章中,我们将深入探讨处理大型JSON文件的最佳实践,并展示如何在构建RESTful API时进行有效的JSON处理和性能优化。

## 6.1 处理大型JSON文件

### 6.1.1 分块解析技术

处理大型JSON文件时,一次性将其完全加载到内存中可能会导致程序崩溃。分块解析技术允许我们逐步读取和解析JSON文件,从而避免内存溢出。

```python

import json

def chunk_parser(file_path, chunk_size=1024):

with open(file_path, 'r') as ***

***

***

***

***

* 解析块

data = json.loads(chunk)

# 处理数据

process_data(data)

def process_data(data):

# 处理逻辑

print(data)

# 使用示例

chunk_parser('large_file.json')

```

在这个例子中,我们定义了一个`chunk_parser`函数,它将读取指定大小的数据块,并对每个块进行解析和处理。这种方法可以有效控制内存使用,尤其是在处理具有数百万行的大型文件时。

### 6.1.2 大型数据集的内存优化

除了分块解析,我们还可以采取其他措施来优化内存使用。例如,我们可以选择性地解析JSON文件中的特定部分,而不是整个文件。

```python

import json

def selective_parser(file_path, path_to_data):

with open(file_path, 'r') as ***

***

***

***

* 处理逻辑

print(data[path_to_data])

# 使用示例

selective_parser('large_file.json', 'specific/key/path')

```

在这个例子中,`selective_parser`函数只解析包含特定键路径的JSON对象。这种方法可以显著减少内存使用,尤其是在处理具有复杂结构的大型JSON文件时。

## 6.2 构建RESTful API中的JSON处理

### 6.2.1 设计API的数据交互

在构建RESTful API时,数据的交互是核心。正确处理JSON数据可以提高API的可用性和性能。

```python

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/api/data', methods=['POST'])

def handle_data():

data = request.get_json()

# 处理接收到的数据

result = process_data(data)

return jsonify(result), 200

def process_data(data):

# 处理逻辑

return data

if __name__ == '__main__':

app.run(debug=True)

```

在这个Flask应用示例中,我们定义了一个处理POST请求的API端点,它接收JSON数据,处理后返回响应。这种设计允许API灵活地处理各种数据格式,并且易于维护和扩展。

### 6.2.2 优化API性能

为了优化API性能,我们可以采用缓存策略、异步处理和批处理等技术。

```python

import functools

from flask import Flask, request

from cachetools import cached, TTLCache

app = Flask(__name__)

# 创建缓存对象

cache = TTLCache(maxsize=100, ttl=300) # 缓存最多100项,每项有效期300秒

@cached(cache)

def get_cached_data(data_id):

# 模拟数据库查询

return fetch_from_database(data_id)

@app.route('/api/data/<int:data_id>', methods=['GET'])

def get_data(data_id):

data = get_cached_data(data_id)

return jsonify(data), 200

def fetch_from_database(data_id):

# 模拟数据库操作

return {'id': data_id, 'data': 'some data'}

if __name__ == '__main__':

app.run(debug=True)

```

在这个示例中,我们使用了`cachetools`库来缓存API响应。`get_cached_data`函数被装饰为`cached`,它会在首次调用时执行数据库查询,并将结果缓存起来,后续相同的请求将直接从缓存中获取数据。

## 6.3 数据存储与检索

### 6.3.1 使用JSON存储数据

JSON是一种流行的数据存储格式,它易于阅读和维护。在Python中,我们可以使用内置的`json`模块将数据转换为JSON格式并存储。

```python

import json

data = {'name': 'John', 'age': 30, 'city': 'New York'}

# 将数据写入文件

with open('data.json', 'w') as ***

***

* 从文件读取数据

with open('data.json', 'r') as ***

***

```

在这个例子中,我们展示了如何将Python字典写入JSON文件,以及如何从JSON文件中读取数据。

### 6.3.2 从数据库检索JSON数据

从数据库检索JSON数据通常涉及到执行SQL查询,并将结果转换为JSON格式。

```python

import json

import sqlite3

# 连接到数据库

conn = sqlite3.connect('example.db')

cursor = conn.cursor()

# 执行查询

cursor.execute("SELECT * FROM users")

rows = cursor.fetchall()

# 将结果转换为JSON

data = []

for row in rows:

data.append({

'id': row[0],

'name': row[1],

'age': row[2]

})

# 将数据转换为JSON字符串

json_data = json.dumps(data)

print(json_data)

# 关闭数据库连接

cursor.close()

conn.close()

```

在这个例子中,我们从SQLite数据库中检索用户数据,并将其转换为JSON字符串。这种方法可以用于从任何支持SQL的数据库中检索数据。

在本章中,我们通过处理大型JSON文件、构建RESTful API以及数据存储与检索的实战案例,展示了如何在Python中有效地处理JSON数据。这些技术可以帮助开发者在实际应用中提高性能和效率。

0

0