【编码转换大师】:深入理解十进制与十六进制转换的神秘世界

数制转换-C语言程序设计课程设计报告.docx

摘要

本文深入探讨了十进制与十六进制数制之间的转换基础和应用,涵盖了转换的理论解析和实践操作。首先,文章阐述了两种数制的特点和结构,包括它们的数位、权重及运算规则。随后,详细介绍了直接转换方法和编程语言中的应用,并提供具体案例。进一步地,文章深入探讨了十六进制在编码系统中的应用,编码转换的高级技巧以及其对信息安全的影响。最后,通过实践案例分析,展示了十六进制在C语言、Python、JavaScript等编程语言中的应用,包括输入输出、位操作和数据处理等。本文旨在为读者提供一套全面的十进制与十六进制转换知识体系,以提高编程效率和数据处理能力。

关键字

十进制;十六进制;数制转换;编程实践;编码系统;信息安全

参考资源链接:C语言实现十进制到十六进制转换及栈操作

1. 十进制与十六进制转换基础

1.1 转换的必要性与用途

在信息技术领域,计算机系统内部广泛使用二进制进行数据存储和处理。但二进制对于人类来说,阅读和理解并不直观,因此通常会使用十六进制作为中间表示形式,因为其比二进制更加紧凑。在系统编程、网络通信、以及网络安全等众多领域中,十进制与十六进制的转换是不可或缺的基础操作。

1.2 十进制与十六进制的定义

- **十进制(Decimal)**是最常用的数制系统,它基于10个不同的符号(0-9)。

- **十六进制(Hexadecimal)**是一种逢16进1的数制,使用16个基本符号(0-9和A-F)进行计数。

1.3 转换的实际意义

掌握十进制与十六进制的转换技巧,不仅可以提升程序员在进行硬件操作和网络数据解析时的效率,还能加深对计算机内部数据表示方式的理解。在下一章节中,我们将深入探讨这两种数制系统的特点与结构,以及它们之间的转换理论基础。

2. 十进制与十六进制的理论解析

2.1 十进制系统的特点与结构

2.1.1 十进制数位和权重

十进制系统是我们日常生活中最熟悉的数制,其特点是基于10的数制。它由10个数字符号组成,分别是0到9。每一个数位代表该位置上数字的权重值。在十进制系统中,权重从右到左依次为1、10、100、1000等,每向左移动一位,权重增加10倍。

数位和权重的关系可以通过以下公式来表示:

[ (a_n \times 10^n) + (a_{n-1} \times 10^{n-1}) + \ldots + (a_1 \times 10^1) + (a_0 \times 10^0) ]

其中,(a_i) 表示第(i)位上的数字,(n)是该数的最高位数减1。

2.1.2 十进制的运算规则

十进制的运算规则包括加法、减法、乘法和除法。

- 加法运算:从最低位开始,逐位相加,如果相加的结果超过9,则向高位进位。

- 减法运算:从最低位开始,逐位相减,如果减数大于被减数的某一位,则需要从高位借位。

- 乘法运算:每一位数与另一个数相乘,然后将结果相加。

- 除法运算:将被除数除以除数,得到商和余数。

这些基本的运算规则构成了十进制系统的核心,是学习其他数制的基础。

2.2 十六进制系统的特点与结构

2.2.1 十六进制数位和权重

十六进制系统是一种基数为16的数制。它使用0到9的数字和A到F的字母来表示16个可能的值。其中,A到F分别代表了10到15。十六进制的每一位数代表的是16的幂次方的权重,从右向左依次是(16^0, 16^1, 16^2, \ldots)。

例如,十六进制数1A3可以展开为:

[ 1 \times 16^2 + 10 \times 16^1 + 3 \times 16^0 = 256 + 160 + 3 = 419_{(10)} ]

2.2.2 十六进制的运算规则

十六进制的运算规则在概念上与十进制相似,但在操作上有一些不同:

- 加法运算:当两个十六进制数字相加,结果为10到15时,使用A到F表示,并进位。

- 减法运算:在减法中,如果减数大于被减数的某一位,需要从高位借位,如果16不够借,则借1并加16(因为(16-10=6))。

- 乘法运算:乘法规则类似十进制,但需注意结果是否超过15,即超过的话需要转换为相应的十六进制数。

- 除法运算:除法时需要将16进制的每一位进行除法计算,并处理好每一位的结果。

由于每一位表示的值更大,十六进制的运算通常比十进制更快速、简洁。

2.3 转换理论基础

2.3.1 转换中的进位与借位原理

在十进制与十六进制之间转换时,进位与借位原理是理解转换过程的核心。

- 进位:在转换过程中,当一个数位的结果超过了当前数制的最大值,就需要进位到左边的下一位。

- 借位:在减法操作中,如果被减数的某一位小于减数的对应位,就需要从左边的高一位借一个单位(在十六进制中是一个16)。

无论是由十进制转换到十六进制,还是反过来,进位与借位都是必须理解的基本概念。

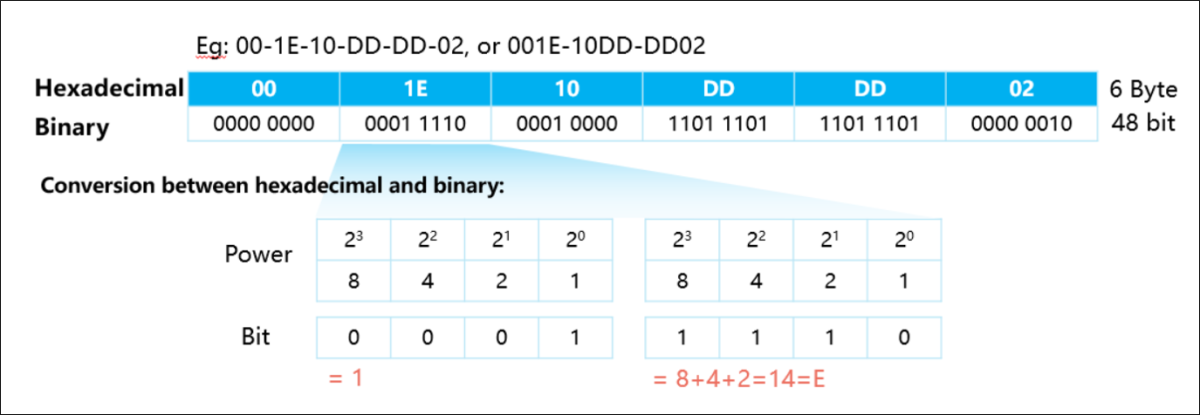

2.3.2 二进制在转换中的桥梁作用

二进制是计算机系统中使用的基础数制,而十六进制与二进制之间存在一种天然的转换桥梁。

- 每一个十六进制数字可以直接转换为一个4位的二进制数字,反之亦然。

- 十六进制的每一位对应二进制的四位,例如十六进制的

1A3对应于二进制的0001 1010 0011。

因此,在进行十进制与十六进制之间的转换时,可以通过先转换为二进制,然后再从二进制转换到目标数制的方法,简化了整个转换过程。

理论解析总结

在深入理解了十进制与十六进制的理论基础之后,我们可以看到,这两种数制都是为了满足人类和计算机处理数据的不同需求而设计。十进制直观且易于人类理解和计算,而十六进制则因其简洁性和高效率而在计算机科学中广泛应用。通过掌握它们的数位和权重、运算规则以及转换原理,我们能够在计算机编程、数据通信和系统分析等多方面应用中更加得心应手。

3. 十进制与十六进制的转换实践

在第二章我们详细讨论了十进制与十六进制转换的理论基础和它们各自的特点与结构,现在我们将深入实践层面,分析如何在程序中进行这两种进制之间的转换。本章将重点介绍转换方法,并探讨如何在实际应用中处理常见的错误以及优化转换效率。

3.1 直接转换方法

3.1.1 十进制转十六进制的算法实现

转换十进制数到十六进制数是一个经常遇到的需求。例如,在计算机科学中,十六进制通常用于表示颜色代码、内存地址等。基本的算法实现通常涉及除基取余法。

- def dec_to_hex(dec_number):

- # 仅支持正整数的转换

- hex_digits = "0123456789ABCDEF"

- hex_number = ""

- while dec_number > 0:

- remainder = dec_number % 16

- hex_number = hex_digits[remainder] + hex_number

- dec_number = dec_number // 16

- return hex_number if hex_number else "0"

上述代码逻辑:

- 定义了十六进制的数字表示,从0到F。

- 通过一个循环,不断地对十进制数进行除以16的操作,并取余数作为新的十六进制数字的一部分。

- 如果余数是十进制的10到15,则对应的十六进制数字是A到F。

- 最后,如果得到的十六进制数为空,则返回"0"。

这个简单的算法可以直接用于将十进制数转换为十六进制表示。

3.1.2 十六进制转十进制的算法实现

相对应地,将十六进制数转换为十进制数同样重要。一个常用的方法是累加乘法,通过将每个十六进制位乘以16的相应次方再相加得到十进制数。

- def hex_to_dec(hex_number):

- hex_digits = {'0': 0, '1': 1, '2': 2, '3': 3, '4': 4, '5': 5, '6': 6, '7': 7, '8': 8, '9': 9, 'A': 10, 'B': 11, 'C': 12, 'D': 13, 'E': 14, 'F': 15}

- decimal = 0

- power = 0

- hex_number = hex_number.upper()

- for digit in reversed(hex_number):

- decimal += hex_digits[digit] * (16 ** power)

- power += 1

- return decimal

代码逻辑:

- 创建一个映射字典

hex_digits来快速查找十六进制数字对应的十进制值。 - 从十六进制数的最后一个字符开始(即最不重要的位),使用

reversed函数逆序处理字符串。 - 计算每个十六进制位的值,并根据其位置(16的幂次方)计算其在十进制中的权重,累加到

decimal变量中。

这个函数将十六进制数正确转换为十进制数。

3.2 程序中的转换应用

3.2.1 编程语言中的转换函数与方法

大多数编程语言都提供了内置的函数或方法来进行进制转换。在这一小节,我们将讨论在Python、C语言和JavaScript中如何进行十进制与十六进制之间的转换。

Python中的转换

在Python中,可以使用int和hex内置函数来进行转换:

- # 十进制转十六进制

- dec_number = 255

- hex_number = hex(dec_number)

- print(f"十进制数 {dec_number} 转换为十六进制是 {hex_number}")

- # 十六进制转十进制

- hex_number = "FF"

- dec_number = int(hex_number, 16)

- print(f"十六进制数 {hex_number} 转换为十进制是 {dec_number}")

输出:

- 十进制数 255 转换为十六进制是 0xff

- 十六进制数 FF 转换为十进制是 255

Python的简洁语法使得进制转换非常直观。

C语言中的转换

在C语言中,可以使用sprintf和sscanf函数来实现转换:

- #include <stdio.h>

- int main() {

- // 十进制转十六进制

- int dec_number = 255;

- char hex_number[5];

- sprintf(hex_number, "%X", dec_number); // 使用大写X

- printf("十进制数 %d 转换为十六进制是 %s\n", dec_number, hex_number);

- // 十六进制转十进制

- sscanf("FF", "%X", &dec_number);

- printf("十六进制数 FF 转换为十进制是 %d\n", dec_number);

- return 0;

- }

JavaScript中的转换

JavaScript提供了toString和parseInt函数来进行进制转换:

- // 十进制转十六进制

- let dec_number = 255;

- let hex_number = dec_number.toString(16).toUpperCase();

- console.log(`十进制数 ${dec_number} 转换为十六进制是 ${hex_number}`);

- // 十六进制转十进制

- let hex_num = "ff";

- dec_number = parseInt(hex_num, 16);

- console.log(`十六进制数 ${hex_num} 转换为十进制是 ${dec_number}`);

这些编程语言中内置的转换函数简化了开发者的操作,使得进制转换在实际编程中变得非常方便。

3.2.2 实际案例分析:数值与颜色代码转换

在前端开发中,颜色代码通常以十六进制格式表示。例如,网页上可能需要将用户输入的十进制数转换为十六进制颜色代码,以便应用到HTML的style属性中。

- function convertRGBtoHex(r, g, b) {

- return "#" + ((1 << 24) + (r << 16) + (g << 8) + b).toString(16).slice(1);

- }

这个函数将RGB值(范围0-255)转换为对应的十六进制颜色代码。通过左移和拼接操作,将RGB值合并为一个整数,并使用toString(16)转换为十六进制字符串。slice(1)用于去除字符串前面的0,因为十六进制的0x000000表示黑色。

3.3 转换中的错误处理与优化

3.3.1 常见错误分析与解决策略

在进制转换过程中可能会遇到的常见错误包括输入超出预期范围、格式错误以及大小写不匹配。要妥善处理这些错误,可以编写错误处理逻辑,确保程序的健壮性。

输入超出预期范围

错误示例:

- # 错误示例:输入超过十六进制表示范围

- hex_number = "10000"

- dec_number = int(hex_number, 16)

解决策略:

- def safe_hex_to_dec(hex_number):

- try:

- return int(hex_number, 16)

- except ValueError:

- print("输入错误:请输入有效的十六进制数。")

- return None

通过使用异常处理,可以在输入无效时返回错误信息,并避免程序崩溃。

格式错误与大小写不匹配

错误示例:

- // 错误示例:格式错误和大小写不匹配

- hex_number = "xyz"

- dec_number = parseInt(hex_number, 16);

解决策略:

- function safeHexToDec(hex_number) {

- if (typeof hex_number === 'string' && /^[0-9A-Fa-f]+$/.test(hex_number)) {

- return parseInt(hex_number, 16);

- } else {

- console.error("输入错误:请输入有效的十六进制数。");

- return null;

- }

- }

使用正则表达式检查输入是否符合十六进制数的格式,确保大小写一致,提高函数的健壮性。

3.3.2 转换效率的优化技巧

进制转换算法的效率对于处理大量数据或者在性能敏感的应用中非常关键。以下是一些优化策略:

- 批量处理:如果需要转换大量数据,可以采用批量处理的方式来减少函数调用的开销。

- 缓存机制:对于重复进行相同转换的情况,可以使用缓存机制存储已转换的结果,避免重复计算。

- 低级优化:对于底层语言(如C语言),可以通过优化算法逻辑减少不必要的计算步骤,或者使用更有效的内存管理方法。

- #include <stdio.h>

- #include <stdlib.h>

- char* dec_to_hex_fast(int dec_number) {

- // 假设这是已经优化的内存分配和转换逻辑

- // 省略具体实现细节

- }

- int main() {

- int large_number = 123456789;

- char* hex_string = dec_to_hex_fast(large_number);

- printf("转换后的十六进制数为: %s\n", hex_string);

- free(hex_string); // 释放分配的内存

- return 0;

- }

此示例代码省略了具体实现细节,但表明了使用优化方法改善性能的方向。实际应用中,应根据具体情况选择适当的优化手段。

表格、流程图、代码块的展示

在这一章节的介绍中,我们提到了表格、流程图和代码块的使用,现在我们将通过一个表格和一个流程图来进一步展示本章节内容的结构和逻辑。

表格:常见编程语言中的进制转换方法

| 编程语言 | 十进制转十六进制函数 | 十六进制转十进制函数 |

|---|---|---|

| Python | hex() | int(x, base=16) |

| C语言 | sprintf(“%X”, num) | sscanf(hex, “%X”, &num) |

| JavaScript | toString(16) | parseInt(hex, 16) |

流程图:十进制转十六进制的转换流程

graph TD

A[开始] --> B[定义十六进制位映射]

B --> C[初始化十六进制字符串为空]

C --> D[循环处理十进制数]

D --> |余数小于10| E[添加'0'-'9'对应字符]

D --> |余数大于等于10| F[添加'A'-'F'对应字符]

E --> G[除16取余并累加到十进制数]

F --> G

G --> |余数为0| H[完成转换,结束循环]

G --> |余数不为0| C

H --> I[返回转换后的十六进制字符串]

该流程图展示了十进制转十六进制转换过程的逻辑步骤。

总结

通过本章的内容,我们了解了十进制与十六进制转换的实践方法。我们介绍了如何在不同的编程语言中使用内置函数或自定义算法进行转换,并分析了错误处理和优化技巧。在实际应用中,这些方法和技巧能够帮助我们高效且准确地完成进制转换任务。

4. 十六进制与编码系统的深入

4.1 十六进制在编码系统中的应用

十六进制与字符编码

在计算机系统中,字符编码用于表示文本中的字符。最常见的字符编码之一是ASCII(美国信息交换标准代码),它使用7位二进制数来表示128个字符。然而,随着计算机技术的发展,需要一种新的编码系统来支持更多字符的表示,特别是非英文字符,这就导致了Unicode的出现。

Unicode提供了一个唯一的字符集合,并为其分配了码点。这些码点经常以十六进制形式表示,如“U+4E2D”表示中文字符“中”。Unicode的UTF-8、UTF-16和UTF-32等变体,都是根据需要使用不同数量的字节来表示字符,而这些字节的表示通常涉及十六进制数。

十六进制在内存和硬盘中的使用

计算机内存和硬盘存储都基于二进制位进行操作。由于十六进制数可以很容易地映射到二进制位,它们常被用来表示内存地址和存储数据。一个字节由8位组成,可以直接用两个十六进制数字表示,如0xFF可以代表二进制的11111111。

在内存管理中,程序员通常会使用十六进制数来表示内存地址或指针值,因为它们既简洁又便于读写。在硬盘存储方面,文件系统的元数据,例如文件分配表(FAT)或索引节点(inode)表,也使用十六进制来记录文件的存储位置和其他属性信息。

graph LR

A[内存地址] -->|以十六进制表示| B[0x00001234]

C[存储数据] -->|以十六进制表示| D[0x4D5A]

E[文件系统元数据] -->|以十六进制表示| F[0x00010000]

4.2 编码转换的高级技巧

编码转换算法的复杂场景应用

在处理国际化应用时,经常需要在不同的编码系统之间进行转换。例如,从数据库中的UTF-8编码的文本转换到网页上的UTF-16编码。这些转换可能需要考虑字符集、字节序(大端或小端)和特殊字符映射等问题。

一个高级的转换技巧是使用现有的库函数,如Python的codecs模块,它提供了一系列编码和解码功能。另一种方法是手动实现转换逻辑,这通常需要对字符编码有深入的理解,以及对字节操作的熟练掌握。

- import codecs

- # 示例:使用codecs模块进行编码转换

- original_text = "你好,世界!"

- encoded_utf8 = original_text.encode('utf-8')

- decoded_unicode = encoded_utf8.decode('utf-8')

- # 转换为UTF-16编码

- encoded_utf16 = codecs.encode(encoded_utf8, 'utf-16')

- print("UTF-8编码:", encoded_utf8)

- print("UTF-16编码:", encoded_utf16)

编码转换的自动化处理工具

自动化处理工具可以帮助开发人员和系统管理员更高效地完成编码转换任务。这些工具通常提供命令行接口(CLI)或图形用户界面(GUI),允许用户指定输入和输出编码,并执行转换。

一个流行的自动化工具是Iconv,它可以处理多种编码转换。在编程中,可以使用Python的subprocess模块来调用Iconv进行转换:

- import subprocess

- input_text = "你好,世界!"

- # 使用Iconv进行编码转换

- process = subprocess.Popen(['iconv', '-f', 'utf-8', '-t', 'utf-16', '-o', 'output.txt', '-'], stdin=subprocess.PIPE)

- # 发送输入文本到Iconv进程

- process.communicate(input=input_text.encode('utf-8'))

4.3 编码转换对信息安全的影响

编码转换在加密中的作用

编码转换在信息安全领域扮演着重要角色,尤其是在加密和解密过程中。现代加密算法如AES(高级加密标准)或RSA往往需要将数据转换为特定格式才能进行加密。例如,一个字符串在加密前可能需要转换为字节序列,而在解密后,需要将其从字节序列转换回字符串。

例如,在Web应用中,可能需要对用户输入的密码进行加密处理。使用十六进制可以表示二进制数据,加密后的密文通常以十六进制字符串的形式存在。这提供了方便的方式存储和传输加密数据。

- from Crypto.Cipher import AES

- # 假设key和nonce是加密密钥和初始化向量

- key = b'This is a key123'

- nonce = b'This is a nonce'

- # 创建一个AES加密器实例

- cipher = AES.new(key, AES.MODE_CTR, nonce=nonce)

- # 待加密的明文

- plain_text = "Hello, World!"

- # 将明文转换为字节序列

- encoded_text = plain_text.encode('utf-8')

- # 加密数据

- encrypted_text = cipher.encrypt(encoded_text)

- # 加密后的数据以十六进制字符串形式展示

- print("加密后的数据:", encrypted_text.hex())

编码转换与网络安全实例分析

在网络安全领域,编码转换的使用可以提高系统的弹性。例如,网络协议栈中的数据包解析,如果能够正确地处理不同编码,就可以防止某些类型的缓冲区溢出攻击。

另一方面,不正确的编码转换可能导致安全漏洞。如果一个系统错误地将用户输入的十六进制数据当作普通文本处理,就可能遭受注入攻击。因此,开发者需要对输入数据进行适当的过滤和校验。

在Web应用中,防止跨站脚本攻击(XSS)的一个常见做法是将用户输入的特殊字符转换为HTML实体,例如将<转换为<。这种技术不仅提高了网页的安全性,也展示了编码转换在实际中的应用。

- <!-- 防止XSS攻击的示例 -->

- <script>

- var userInput = "<script>alert('XSS');</script>";

- // 将特殊字符转换为HTML实体

- document.write("用户输入: " + userInput.replace(/</g, "<"));

- </script>

通过本章节的介绍,我们深入探讨了十六进制与编码系统的应用,高级技巧以及对信息安全的影响。十六进制不仅是计算机科学的基石,而且在实际应用中扮演着至关重要的角色。理解并掌握编码转换的方法,不仅能够提高开发效率,而且有助于提升系统的安全性和可靠性。在下一章中,我们将深入探讨十六进制与编程语言的关系,并通过具体的编程实践,揭示十六进制与编程的紧密联系。

5. 实践案例:十六进制与编程语言

5.1 在C语言中的应用

5.1.1 C语言中十六进制数的输入与输出

在C语言中处理十六进制数值是一种常见的需求,C标准库提供了便捷的方式来进行十六进制数的输入输出。例如,我们可以使用printf和scanf函数来完成这些任务。

- #include <stdio.h>

- int main() {

- unsigned int hexValue = 0x1A3F; // 十六进制数0x1A3F

- printf("The value in hex is: 0x%X\n", hexValue); // 输出: 0x1A3F

- return 0;

- }

在printf中,%X或%x格式占位符用来输出一个无符号整型的十六进制表示。大写的%X会以大写字母形式输出十六进制数字,而小写的%x则会以小写形式输出。在scanf中,%X或%x用来输入十六进制数值。

在十六进制与十进制相互转换时,可以使用strtol(字符串转长整型)函数,其中第三个参数设置为16来指定输入字符串是十六进制格式。

- #include <stdlib.h>

- int main() {

- char hexString[] = "1A3F";

- unsigned int decimalValue;

- decimalValue = strtol(hexString, NULL, 16); // 将十六进制字符串转换为十进制数值

- printf("The decimal value is: %u\n", decimalValue); // 输出: 6719

- return 0;

- }

5.1.2 十六进制与位操作

C语言提供了强大的位操作能力,使得十六进制在二进制层面上的操作变得非常直接。例如,我们可以使用位运算符来操作十六进制数值。

- #include <stdio.h>

- int main() {

- unsigned int a = 0xABCD; // 十六进制数0xABCD

- unsigned int b = 0x1234; // 十六进制数0x1234

- // 位与运算

- printf("a & b = 0x%X\n", a & b);

- // 位或运算

- printf("a | b = 0x%X\n", a | b);

- // 位异或运算

- printf("a ^ b = 0x%X\n", a ^ b);

- // 位非运算

- printf("~a = 0x%X\n", ~a);

- // 左移运算

- printf("a << 2 = 0x%X\n", a << 2);

- // 右移运算

- printf("a >> 2 = 0x%X\n", a >> 2);

- return 0;

- }

这些操作在系统编程、低级硬件交互以及优化性能时非常有用。

5.2 在Python中的应用

5.2.1 Python内置的十六进制支持

Python作为一种高级编程语言,内置了对十六进制数据的支持。在Python中,我们可以直接使用十六进制表示法,并通过内置函数进行转换。

- hex_value = 0x1A3F # 十六进制数值0x1A3F

- print(f"The hex value is: 0x{hex_value:X}") # 输出: 0x1A3F

在Python中,hex()函数可以将一个十进制整数转换成十六进制字符串。而int()函数可以将十六进制字符串转换回十进制整数,需要指定第二个参数为16。

- # 将十进制数转换为十六进制字符串

- decimal_value = 6719

- hex_str = hex(decimal_value) # 输出: '0x1a3f'

- print(f"The hex string is: {hex_str.upper()}") # 输出: 0X1A3F

- # 将十六进制字符串转换为十进制数

- hex_value = '1A3F'

- decimal_value = int(hex_value, 16) # 输出: 6719

- print(f"The decimal value is: {decimal_value}")

5.2.2 十六进制数据的高级处理

Python允许我们以更高级的方式来处理十六进制数据。例如,我们可以使用binascii模块来操作二进制和十六进制数据,或者使用正则表达式来解析十六进制字符串。

- import binascii

- import re

- # 从十六进制字符串得到字节数据

- hex_str = '1A3F'

- bytes_data = binascii.unhexlify(hex_str)

- # 从字节数据得到十六进制字符串

- hex_from_bytes = binascii.hexlify(bytes_data).decode('utf-8')

- # 使用正则表达式来验证十六进制字符串

- pattern = re.compile(r'^([0-9a-fA-F]{2})+$')

- if pattern.match(hex_str):

- print(f"The string {hex_str} is a valid hex string.")

- else:

- print("Invalid hex string.")

Python的高级特性使得处理十六进制数据变得更加简单和灵活。

5.3 在JavaScript中的应用

5.3.1 JavaScript中的十六进制字符串操作

在JavaScript中处理十六进制字符串同样很简单。使用parseInt和Number对象可以轻松实现十进制与十六进制的转换。

- // 将十六进制字符串转换为十进制数值

- var hexValue = "1A3F";

- var decimalValue = parseInt(hexValue, 16);

- console.log("The decimal value is: " + decimalValue); // 输出: 6719

- // 将十进制数值转换为十六进制字符串

- var decimalValue = 6719;

- var hexStr = decimalValue.toString(16).toUpperCase();

- console.log("The hex string is: " + hexStr); // 输出: 1A3F

5.3.2 十六进制与Web前端技术

在Web前端开发中,十六进制颜色值常用于CSS样式。JavaScript可以用来动态生成或者修改十六进制颜色值。

- // 动态生成十六进制颜色值

- function generateRandomHexColor() {

- var letters = '0123456789ABCDEF';

- var color = '#';

- for (var i = 0; i < 6; i++) {

- color += letters[Math.floor(Math.random() * 16)];

- }

- return color;

- }

- // 设置页面背景颜色为随机生成的十六进制颜色值

- document.body.style.backgroundColor = generateRandomHexColor();

JavaScript通过直接操作十六进制字符串,使前端设计师能够轻松实现丰富的视觉效果。

以上章节内容详细介绍了在C语言、Python和JavaScript中处理十六进制数据的方法和技巧。通过具体的代码实例和逻辑分析,使读者能够理解并掌握在不同编程语言中运用十六进制数据的技术要点。

6. 十六进制在现代信息技术中的应用

6.1 十六进制在软件开发中的应用

6.1.1 调试与反汇编

软件开发者在进行程序调试时,常常需要查看计算机的汇编指令,而这些指令在底层通常使用十六进制数表示。了解十六进制,可以帮助开发者更深入地理解程序执行时的内存状态和处理器行为。

在使用调试工具进行反汇编时,指令和数据往往以十六进制的形式展示。例如,在GDB中,可以使用x命令来查看内存中的十六进制数据:

- (gdb) x/10wx 0x0000000000400540

这条命令将会以十六进制格式显示从地址0x0000000000400540开始的10个字的内存内容。

6.1.2 高级语言中的二进制操作

在C++17之后,标准库中引入了std::to_integer,可以将字符串转换为十六进制的整型数。这样的功能使得在高级语言中处理十六进制数变得更加简便。

- #include <iostream>

- #include <string>

- #include <limits>

- int main() {

- std::string hexString = "1A3F";

- try {

- auto num = std::stoul(hexString, nullptr, 16);

- std::cout << "The decimal value of 0x" << hexString << " is " << num << std::endl;

- } catch (const std::invalid_argument& ia) {

- std::cerr << "Invalid argument: " << ia.what() << std::endl;

- } catch (const std::out_of_range& oor) {

- std::cerr << "Out of range: " << oor.what() << std::endl;

- }

- return 0;

- }

执行上述代码,会输出:

- The decimal value of 0x1A3F is 6719

6.1.3 数据序列化与网络通信

在进行数据序列化时,为了简化数据格式和便于传输,开发者经常使用十六进制表示二进制数据。在网络通信中,使用十六进制可以准确地表示复杂的二进制数据包,如用于HTTP请求或响应的头部信息。

一个实际例子是在REST API中传递JSON数据,其中十六进制数可能用于编码和解码二进制数据:

- {

- "id": "0x12345678",

- "data": "0xAABBCCDD"

- }

6.2 十六进制在网络技术中的应用

6.2.1 MAC地址和IP地址的表示

在计算机网络中,设备的物理地址(MAC地址)和IP地址的某些表示形式中,都包含十六进制数。例如,MAC地址由六组十六进制数字组成,通常以冒号(:)分隔,如00:1A:2B:3C:4D:5E。

在某些网络编程或网络管理工具中,直接使用十六进制处理这些地址信息可以更方便地进行匹配和过滤。

6.2.2 密码学中的应用

密码学中,十六进制用于表示加密算法的输出结果,如散列函数的哈希值。散列值通常用十六进制表示,因为它们能够以紧凑的形式表示大量的信息。

例如,使用SHA-256算法生成一个字符串的散列值,并用十六进制显示:

- echo -n "hello" | sha256sum | awk '{print toupper($1)}'

输出结果:

- 2CF24DBA5FB0A30E26E83B2AC5B9E29E1B161E5C1FA7425E73043362938B9824

6.2.3 数据库中的数据存储

在数据库中,尤其是关系型数据库,某些情况下会使用十六进制来存储二进制大对象(BLOB)。这些数据可能包括文件的二进制内容,而以十六进制表示可以简化存储和检索过程。

举个例子,在MySQL中插入一个十六进制表示的BLOB数据:

- INSERT INTO blobs (data) VALUES (UNHEX('4D5A9000'));

这里4D5A9000是十六进制表示的数据,UNHEX函数用于将十六进制字符串转换为二进制数据。

6.3 十六进制在嵌入式系统中的应用

6.3.1 固件与启动代码

在嵌入式系统中,固件通常使用十六进制文件来存储。这些文件在编程到设备的存储器之前,需要先被转换成二进制格式。十六进制文件提供了一种方便的格式,通过其可以直接观察和修改存储器的内容。

6.3.2 指令集架构与十六进制

在分析和理解底层硬件,比如微控制器或处理器的指令集架构时,十六进制数是不可或缺的。例如,ARM架构的汇编指令经常用十六进制表示,了解这些可以有助于理解硬件行为。

6.3.3 内存映射与地址

嵌入式系统开发者需要对硬件设备的内存映射有一个清晰的了解。十六进制数用于表示内存地址和寄存器值,这在设置和调试硬件设备时非常重要。

- volatile unsigned char *pReg = (unsigned char *)0x40021000;

- *pReg = 0x1E;

这段代码展示了如何使用十六进制地址直接访问和修改寄存器值。在0x40021000地址上设置值为0x1E。

6.4 十六进制在操作系统中的作用

6.4.1 系统调用接口

在操作系统中,系统调用经常涉及十六进制数。例如,在Linux系统中,使用十六进制表示系统调用号和相关参数。

6.4.2 模块与驱动开发

操作系统模块和驱动程序在编写时,经常需要以十六进制形式指定参数和内存地址。开发者使用十六进制来确保正确地设置硬件设备和内存映射。

6.4.3 调试与性能监控

在操作系统级别,开发者可能会使用十六进制值来跟踪系统资源使用情况、监控性能指标,或者在调试时观察寄存器和内存的状态。

例如,在Windows的调试器WinDbg中,使用u命令反汇编内存地址,十六进制值会被用作地址参数:

- u 0x00400000

以上就是在第六章中对十六进制在现代信息技术中应用的详细描述,涵盖了软件开发、网络技术、嵌入式系统以及操作系统等关键领域。这些应用实例展现了十六进制在当今技术领域中的重要性和多样性。