PyTorch模型保存与加载:大模型挑战的解决方案与实践

发布时间: 2024-12-11 19:08:34 阅读量: 12 订阅数: 20

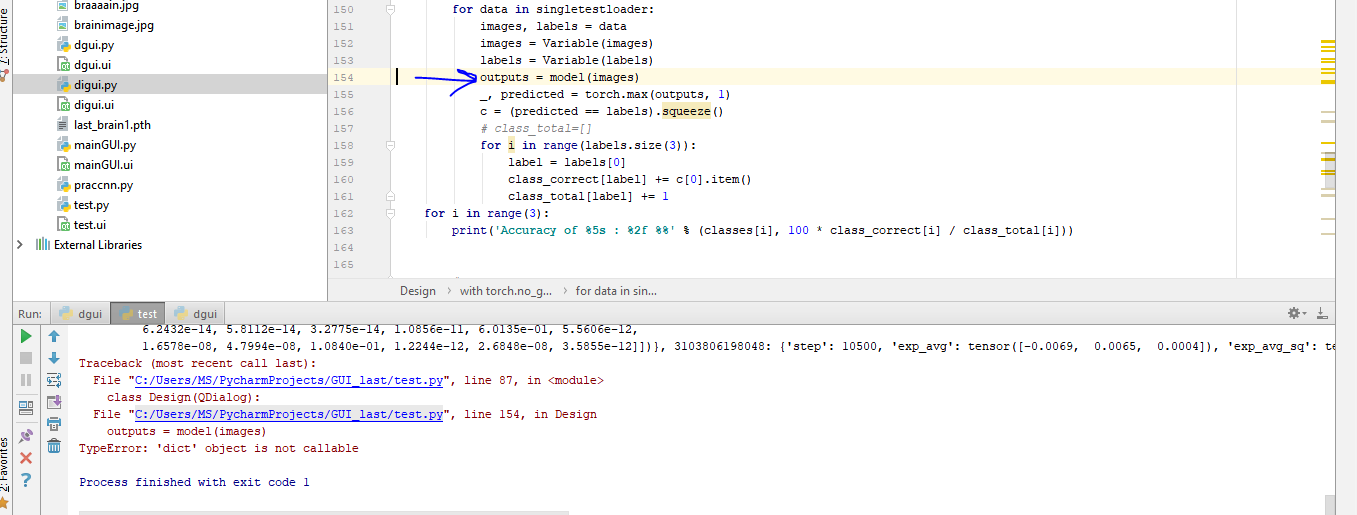

解决pytorch多GPU训练保存的模型,在单GPU环境下加载出错问题

# 1. PyTorch模型保存与加载的基本概念

在深度学习领域,模型的保存与加载是一项至关重要的技术。开发者们不仅需要关注模型的构建与训练,更需掌握如何有效地保存训练好的模型参数,以及如何从保存的状态中加载模型以供后续的推理或进一步训练。本章将引入PyTorch框架中的模型保存与加载的基本概念,并在后续章节中对这些概念进行深入分析和实际操作演示。

## 模型保存与加载的重要性

模型保存与加载的重要性首先体现在可以避免重复训练。对于那些需要长时间或大量资源才能训练完成的模型,重新进行训练显然既不经济也不高效。此外,保存训练好的模型参数,可以让模型的部署与应用变得更加灵活。在模型需要进行微调、或者要将训练好的模型部署到不同的平台或设备上时,能够加载预训练参数变得极其关键。

## PyTorch中模型保存与加载的方法

在PyTorch中,模型的保存和加载通过`torch.save`和`torch.load`函数来实现。简单来说,使用`torch.save`可以将模型的状态字典(包含模型参数以及优化器的状态)保存到磁盘上。当需要继续训练或者使用模型进行预测时,可以利用`torch.load`从磁盘读取状态字典,进而加载模型。

```python

import torch

# 创建一个简单的模型

model = torch.nn.Linear(10, 2)

# 保存模型参数

torch.save(model.state_dict(), 'model.pth')

# 加载模型参数

loaded_model = torch.nn.Linear(10, 2)

loaded_model.load_state_dict(torch.load('model.pth'))

```

在下一章,我们将更详细地探讨模型保存与加载的理论基础,包括深度学习模型持久化的必要性及其在工作流中的作用。

# 2. 模型保存与加载的理论基础

### 2.1 深度学习模型持久化的必要性

#### 2.1.1 模型训练的周期与成本

在深度学习领域,模型的训练通常是一个耗时且资源密集的过程。这不仅涉及到大量数据的预处理、批处理和迭代更新,还需要高性能计算资源,例如GPU或TPU集群,以缩短训练时间。一旦训练完成,模型的参数和训练状态就包含了所有的学习成果,这就需要持久化存储来保留这些成果。

模型持久化允许我们:

- **重新开始训练**:由于外部因素如硬件故障或中断任务,模型需要从一个特定点重新开始训练。

- **参数共享**:在不同的项目或团队之间共享训练好的模型,节省资源和时间。

- **调优与微调**:在已有模型的基础上进行进一步的优化和定制化调整。

训练一个复杂模型可能需要数天甚至数周时间,若不进行有效的保存,任何细微的意外都可能造成巨大的时间损失和经济成本。因此,能够保存和加载模型是深度学习研究和应用的基础之一。

#### 2.1.2 模型保存与加载在工作流中的作用

在机器学习的工作流程中,模型的保存与加载扮演了关键角色。工作流通常包含以下几个阶段:

1. **数据准备**:收集、清洗和预处理数据。

2. **模型设计**:基于问题定义构建适当的神经网络架构。

3. **训练与验证**:在训练数据集上进行模型训练,并在验证集上检查模型性能。

4. **测试与部署**:在独立的测试集上评估模型性能,并最终部署模型到生产环境中。

5. **监控与维护**:监控模型在生产环境中的表现,并定期进行模型维护和更新。

在这样的工作流程中,模型保存与加载确保了从测试阶段到部署阶段的平滑过渡,并为监控与维护提供必要的支持。在监控阶段,如果模型的表现不佳,工程师可以加载之前保存的最佳模型状态进行调整和再训练。在维护阶段,模型可能需要定期更新以适应新的数据模式,此时加载先前保存的模型状态可以作为新训练过程的起点。

模型持久化技术确保了整个机器学习工作流的效率和连续性,对保持项目进度和质量至关重要。因此,理解和掌握模型保存与加载的机制,对于任何一个深度学习从业者来说都是必须的。

### 2.2 PyTorch中的模型状态保存

#### 2.2.1 模型状态字典的结构与内容

在PyTorch中,一个训练好的模型的状态通常以字典(`dict`)的形式保存。该字典包含了模型的所有参数(weights)、偏置项(biases)和优化器的状态信息。字典的结构通常由模型的类结构和优化器的类型决定,但至少会包含以下两个关键项:

- `model_state_dict`:包含了模型的所有参数,即神经网络的权重和偏置项。

- `optimizer_state_dict`:包含了优化器的状态,包括学习率、动量以及其他任何训练过程中计算得到的状态。

此外,根据模型的不同,状态字典还可能包含其他信息,例如模型训练的轮次(epochs)、损失函数的参数或者任何其他训练过程中的特定状态。对于自定义层或模块,其状态也可能作为字典的一部分被保存。

状态字典的键(key)通常是字符串,对应于模型或优化器中的特定参数的名称,而值(value)则是具体的参数数据。这种键值对结构使得状态的保存和加载变得非常灵活和方便。

```python

# 保存模型状态字典的示例代码

torch.save(model.state_dict(), 'model.pth')

```

上面的代码展示了如何保存模型的状态字典到一个文件。`model.pth`是存储模型状态的文件,可以是`.pth`或`.pt`格式。

#### 2.2.2 使用torch.save保存模型状态

`torch.save`函数是PyTorch中用于持久化模型状态的标准方法。通过使用这个函数,可以将模型的参数、优化器的状态以及其他的训练信息保存到硬盘上,以便将来进行加载和使用。使用`torch.save`保存模型状态时,主要有以下优点:

- **兼容性强**:保存的文件可以跨平台使用,方便在不同系统间迁移和分享模型。

- **易于管理**:模型状态保存为文件,便于版本控制和文件备份。

- **简便操作**:PyTorch提供了一行代码即可保存整个模型状态的功能。

具体操作时,需要提供要保存的对象(如模型状态字典或整个模型对象),以及一个文件路径用于指定保存的文件名和位置。例如,保存一个模型的整个状态:

```python

# 假设有一个模型实例model和优化器optimizer

torch.save({

'model_state_dict': model.state_dict(),

'optimizer_state_dict': optimizer.state_dict(),

'epoch': epoch,

'loss': loss,

}, 'checkpoint.pth')

```

这个操作会将模型的参数、优化器的状态以及当前训练的轮次和损失值保存到一个名为`checkpoint.pth`的文件中。

### 2.3 PyTorch中的模型加载方法

#### 2.3.1 使用torch.load加载模型状态

加载保存的模型状态是模型持久化过程中的另一重要步骤。通过PyTorch提供的`torch.load`方法,可以将之前保存的状态字典加载到内存中,并且可以继续使用这些状态进行模型的评估、推理或进一步的训练。

使用`torch.load`加载模型状态主要具有以下优势:

- **灵活选择性加载**:可以加载模型的全部状态,也可以只加载部分参数。

- **兼容多种设备**:支持在不同类型的设备(CPU, GPU)上加载模型,且能够进行设备间的转换。

以下是使用`torch.load`加载模型状态字典的示例代码:

```python

# 加载模型状态字典的示例代码

checkpoint = torch.load('checkpoint.pth')

model.load_state_dict(checkpoint['model_state_dict'])

optimizer.load_state_dict(checkpoint['optimizer_state_dict'])

epoch = checkpoint['epoch']

loss = checkpoint['loss']

```

上述代码首先加载了之前保存的包含模型状态、优化器状态、训练轮次和损失值的文件。然后分别将模型状态和优化器状态加载到当前的模型和优化器实例中。最后,获取了保存的训练轮次和损失值,这些信息可以用于恢复训练进程或评估模型状态。

#### 2.3.2 加载技巧与最佳实践

在实际应用中,有多种加载技巧和最佳实践可以帮助我们更高效地使用PyTorch进行模型的保存与加载。下面列举了几个重要的加载技巧和最佳实践:

- **加载到指定设备**:可以通过`map_location`参数指定加载到的设备(CPU或GPU),这在不同的运行环境中尤其有用。

```python

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model.load_state_dict(torch.load('model.pth', map_location=device))

```

- **部分加载参数**:有时候可能只需要加载模型的部分参数,例如在进行微调时。可以通过修改`load_state_dict`方法中的`strict`参数来实现部分加载。

```python

model.load_state_dict(torch.load('model.pth'), strict=False)

```

- **动态更新模型结构**:如果原始模型结构有所改变,可以先创建一个空模型,然后加载模型状态,此时会忽略缺失的键,并给出警告,这样可以使得状态加载与模型结构分离。

```python

new_model = NewModelClass(*args, **kwargs)

new_mod

```

0

0