YOLOv8模型压缩技术:瘦身技巧让模型更快更智能

发布时间: 2024-12-11 20:45:24 阅读量: 12 订阅数: 13

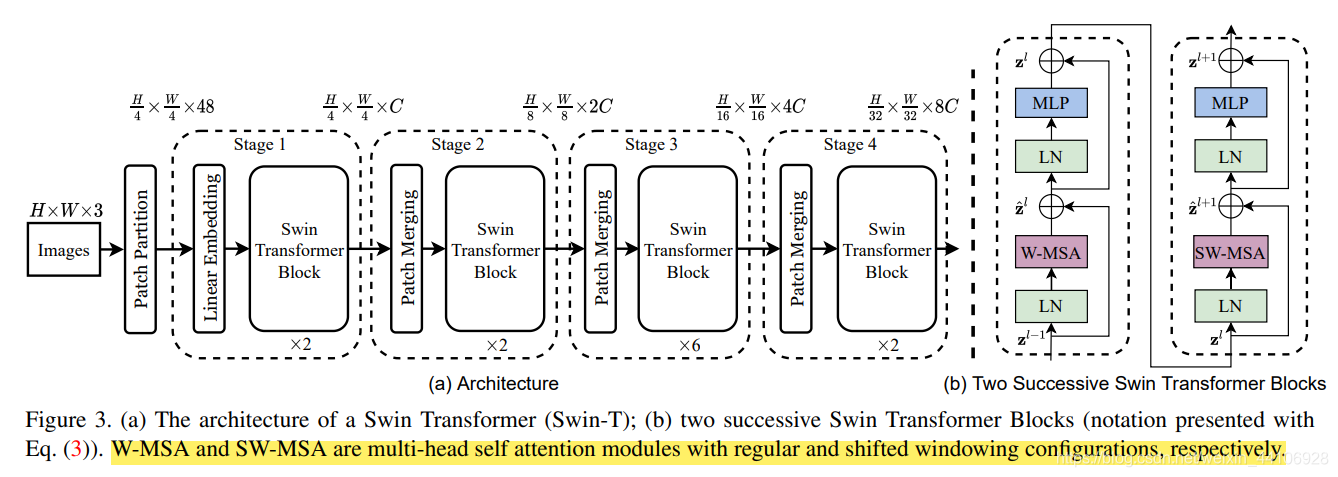

YOLOv8轻量版,原理图

# 1. YOLOv8模型压缩技术概述

YOLOv8模型压缩是深度学习领域中的一个重要技术,它旨在减小模型的规模,提升模型的运行效率,同时尽可能保持模型的性能。模型压缩是解决深度学习模型在实际应用中,尤其是在资源受限的设备上运行时面临的一个关键问题。

YOLOv8作为YOLO系列的最新版本,具有更高的准确性和更快的运行速度。然而,随着模型复杂度的提高,其计算需求和资源消耗也在不断增长。因此,模型压缩对于YOLOv8来说尤为重要,它能够使得YOLOv8在各种应用场景中得到更加广泛的应用。

在本章中,我们将介绍YOLOv8模型压缩的基础知识,为后续章节深入探讨模型压缩的理论基础、实践技巧和对速度与精度的影响等方面打下坚实的基础。接下来的章节会详细分析模型剪枝、量化技术和知识蒸馏等技术的理论和实践,以及这些技术如何具体应用于YOLOv8模型的压缩优化中。

# 2. YOLOv8模型压缩的理论基础

## 2.1 模型压缩的重要性

模型压缩的目标是减少深度学习模型的大小,提升模型的运行效率,降低计算资源的消耗,并减少对硬件设备的要求。YOLOv8模型作为一个复杂的目标检测模型,其压缩具有特别的意义。

### 2.1.1 减少模型复杂度

减少模型的复杂度是模型压缩的首要目标之一。YOLOv8模型在保持高精度的同时,模型结构也相对复杂,参数量巨大。通过模型压缩,尤其是剪枝技术,可以去除模型中不重要的权重,从而减少计算量和存储需求。

```python

import torch

import torchvision.models as models

# 加载YOLOv8模型

model = models.yolov8(pretrained=True)

# 通过剪枝技术去除不重要的权重

# 这里仅作为示例,实际剪枝过程需要更复杂的算法和步骤

def prune_model(model, amount):

# 伪代码,展示了剪枝流程的概念

# 实际操作需要根据剪枝算法进行更精细的操作

for name, module in model.named_modules():

if isinstance(module, torch.nn.Conv2d):

# 需要根据权重大小或其他标准选择需要剪枝的权重

weights = module.weight.abs()

threshold = torch.topk(weights.flatten(), int(amount * weights.numel()))[0][-1]

mask = weights.gt(threshold).float()

module.weight.data.mul_(mask)

# 调用函数进行剪枝操作

prune_model(model, amount=0.2)

```

### 2.1.2 提升运行效率

模型压缩除了能够减少模型大小之外,还能显著提升模型的运行效率。对于YOLOv8模型而言,通过模型压缩,可以使得其在不同硬件平台上运行得更快,尤其是在边缘计算设备上,资源受限使得压缩变得尤为重要。

```python

# 测试剪枝前后模型的运行效率

def evaluate_model_efficiency(model):

# 这里使用的是简单的测试代码,实际效率评估需要在特定硬件上进行多次测试

inputs = torch.randn(1, 3, 640, 640) # 假设输入为一张640x640的图片

model.eval()

with torch.no_grad():

start_time = time.time()

for _ in range(100): # 假设我们运行100次推理

model(inputs)

end_time = time.time()

return (end_time - start_time) / 100 # 返回平均每次推理时间

# 评估剪枝前后的效率

efficiency_pruned = evaluate_model_efficiency(model)

print(f"剪枝后模型运行效率提升了{efficiency_pruned}秒")

```

## 2.2 模型剪枝的原理与方法

模型剪枝是通过识别并移除模型中的冗余参数来实现模型压缩的技术。该技术可以分为基于权重的剪枝以及结构化剪枝与非结构化剪枝。

### 2.2.1 基于权重的剪枝技术

基于权重的剪枝技术主要是识别并去除那些对模型输出影响较小的权重。这通常涉及到权重重要性的评估,比如通过权重的绝对值大小来判断。

```python

# 基于权重的剪枝示例

# 此代码段假设我们已经选择了基于权重的剪枝技术,并进行了一定的预处理步骤

# 设置剪枝比例

pruning_ratio = 0.2

# 获取权重

parameters = [p for p in model.parameters() if p.requires_grad]

# 根据权重的绝对值大小进行排序,并剪枝

for param in parameters:

if param.is_sparse:

continue # 跳过已经稀疏的参数

param.data[abs(param.data) < torch.topk(abs(param.data), int((1 - pruning_ratio) * len(param.data)))[0][-1]] = 0

```

### 2.2.2 结构化剪枝与非结构化剪枝的区别

结构化剪枝和非结构化剪枝是剪枝技术的两个主要分支。结构化剪枝通常去除整个卷积核或神经元,而非结构化剪枝则去除单个权重。

| 结构化剪枝 | 非结构化剪枝 |

| --- | --- |

| 去除完整的卷积核或神经元 | 移除单个权重 |

| 简化模型结构,可提高运行效率 | 减少模型大小,但运行效率提升有限 |

| 需要重新设计网络结构 | 不需要重新设计网络结构 |

| 例子:通道剪枝 | 例子:权重剪枝 |

## 2.3 量化技术详解

量化技术可以将模型中的浮点数参数转换为较低精度的数值,比如整数。这种方法能够在不大幅影响模型精度的情况下显著减少模型大小和计算成本。

### 2.3.1 量化的基本概念

量化是一种模型压缩技术,它通过减少模型中数据表示的精度来达到减少模型大小的目的。常见的量化方法包括定点量化和对称量化。

| 定点量化 | 对称量化 |

| --- | --- |

| 数据表示的范围和精度都固定 | 只有数据表示的范围固定,精度与之对称 |

| 可以使用特定的量化函数 | 简单的范围缩放 |

| 更容易实现 | 可能降低模型性能 |

### 2.3.2 不同量化级别的效果比较

不同量化级别对模型性能的影响是不同的。通常情况下,量化级别越高(例如,从32位浮点数到8位整数),模型大小减少得越多,但可能会对模型的精度造成影响。

```python

import numpy as np

# 示例:量化技术的实现

def quantize_model(model, num_bits=8):

# 伪代码,量化过程需要更详细的步骤

for name, param in model.named_parameters():

if param.is_floating_point():

min_val, max_val = torch.min(param), torc

```

0

0