深入揭秘负载均衡:全面掌握其原理及最佳实践

发布时间: 2025-01-03 19:39:20 阅读量: 11 订阅数: 10

网络分析技术揭秘原理、实践与WinPcap深入解析

# 摘要

负载均衡技术是提高大规模分布式系统性能和可靠性的关键技术之一。本文系统地介绍了负载均衡的基础理论,详细阐述了其工作原理,包括不同类型的负载均衡策略和关键算法。进一步地,文章探讨了在云环境和分布式系统中负载均衡的实践部署,着重于配置实例、监控及性能优化。通过对高流量网站和分布式系统的案例分析,本文展示了负载均衡在实际应用中的策略和效果,并提出了相应的安全性考量。最后,文章展望了负载均衡技术的未来发展趋势,特别是在边缘计算和人工智能结合方面的创新应用。

# 关键字

负载均衡;云服务;性能优化;监控工具;边缘计算;人工智能

参考资源链接:[高创伺服驱动器功能详解:从控制模式到Canopen通讯](https://wenku.csdn.net/doc/644b83ffea0840391e5598cd?spm=1055.2635.3001.10343)

# 1. 负载均衡基础理论

在现代IT架构中,负载均衡是保证系统稳定运行和高可用性的重要技术。它通过分散访问请求,将工作负载在多个服务器或计算资源之间进行有效分配,从而提升系统的整体性能和可靠性。负载均衡技术不仅优化了资源利用,还可以为用户提供无缝的业务体验。

本章将介绍负载均衡的基础理论,包括其定义、重要性以及在IT架构中的基本应用。我们将从负载均衡的必要性出发,逐步深入到它的核心概念与技术细节,为后续章节中关于负载均衡的工作原理、实践部署以及最佳实践案例分析打下坚实的理论基础。

# 2. 负载均衡的工作原理

## 2.1 负载均衡的概念与分类

### 2.1.1 硬件与软件负载均衡

负载均衡是分布式系统中的核心组件,用于在多个服务器之间分配网络或应用流量。它确保没有单一的服务器因为请求过多而成为瓶颈,从而提高了系统的可靠性和可用性。根据实现方式,负载均衡可以分为硬件和软件两大类。

**硬件负载均衡器**是一些专门设计用来分发流量的物理设备,它们具备高性能的网络处理能力,通常在大型数据中心和企业网络中使用。常见的硬件负载均衡器有F5 Networks的Big-IP和Citrix的NetScaler等。硬件负载均衡器因其高性能、高稳定性和易用的管理界面而受到青睐。

**软件负载均衡器**通常指的是在通用硬件上运行的软件解决方案,如Nginx和HAProxy等。这些解决方案具有灵活性高、成本低的优点,能够方便地集成到现代的云计算环境中。

### 2.1.2 层次化的负载均衡策略

层次化的负载均衡策略是指在不同的网络层次上实施负载均衡。这种策略不仅包含传统的四层(传输层)和七层(应用层)负载均衡,还扩展到了网络层和会话层的负载分配。

- **四层负载均衡**主要基于传输控制协议(TCP)和用户数据报协议(UDP)的端口号来进行流量分配,例如,使用IP地址和端口号的哈希算法将流量分配到后端服务器。

- **七层负载均衡**考虑到了HTTP等应用层协议的特定内容,能够根据URL、HTTP头部信息等进行智能路由,实现更精细的流量管理。

- **网络层负载均衡**可能涉及到IP地址的变换(如NAT),能够为处于不同网络区域的服务器提供访问均衡。

- **会话层负载均衡**则关注于用户的会话状态,保证用户请求在整个会话过程中由同一服务器处理,从而保持会话一致性。

层次化的负载均衡策略提供了更全面的流量管理方案,适用于对负载均衡要求更高、更复杂的环境。

## 2.2 负载均衡的关键技术

### 2.2.1 负载感知与决策机制

负载感知是负载均衡器的核心功能之一,它需要实时监控各个后端服务器的负载情况,包括CPU、内存、磁盘I/O以及网络I/O等资源的使用率。负载均衡器通过这些数据,能够做出决策,将新的请求分配给负载最低的服务器。

**决策机制**通常包括轮询、最少连接数和基于响应时间等策略。轮询策略是按照服务器列表顺序依次分配请求;最少连接数则是优先将请求分配给当前连接数最少的服务器;而基于响应时间的策略则是根据服务器的响应情况来分配请求,以便于提供更快速的服务。

### 2.2.2 会话持久性和数据同步

在某些应用场景中,用户的会话需要在多个请求之间保持一致性,这就是所谓的会话持久性。为了实现这一点,负载均衡器需要具备某种机制来识别来自同一用户的连续请求,并将这些请求都路由到同一后端服务器。

数据同步是确保后端服务器之间数据一致性的重要技术。当用户请求被路由到某一个服务器后,其他服务器上的数据需要及时更新,以保证服务的连续性和数据的正确性。这通常涉及到分布式数据库、缓存同步策略等技术。

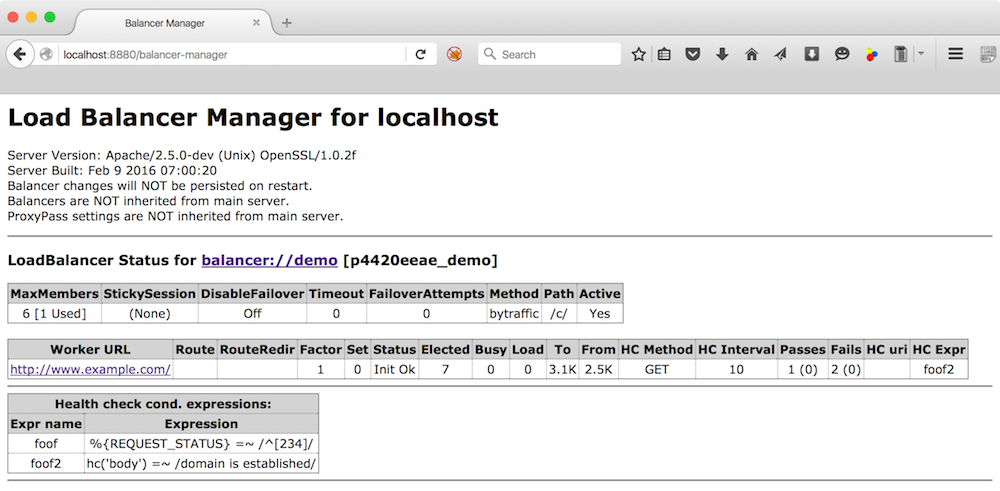

### 2.2.3 健康检查与故障转移

为了保障服务质量,负载均衡器需要定期对后端服务器进行健康检查。当服务器出现故障或无法处理请求时,健康检查可以快速发现这些问题,并将流量转移到其他健康的服务器上。

健康检查可以通过简单的ping命令或更复杂的HTTP请求检查来实现。故障转移机制可以是主动的,即负载均衡器在检测到故障时立即进行转移;也可以是被动的,即当用户报告无法访问服务时,系统才触发故障转移流程。

## 2.3 负载均衡的算法

### 2.3.1 静态与动态算法

负载均衡算法主要分为静态算法和动态算法两类。

静态算法通常不考虑服务器当前的负载情况,而是根据预设的规则进行流量分配。例如,轮询算法就是一种典型的静态算法,它不关心服务器的实际负载,只是简单地按照顺序轮流分配请求。

动态算法则实时考虑服务器的负载情况,动态地进行流量分配。常见的动态算法有最少连接算法、加权轮询等,这些算法能够根据服务器的处理能力或者实时负载,智能地将流量导向负载较轻的服务器。

### 2.3.2 常见算法的实现机制

每种负载均衡算法都有其特定的实现机制。以最少连接算法为例,它通常需要记录每个服务器处理的连接数,并在每次请求到来时,找到当前连接数最少的服务器。而加权轮询算法则需要为每个服务器设置权重,根据权重比例来分配流量。

实现这些算法时,负载均衡器需要不断更新服务器的状态信息,包括当前负载和健康状态。因此,高效的状态收集和快速决策是实现高效负载均衡的关键。

### 2.3.3 算法选择对性能的影响

选择合适的负载均衡算法对于系统的性能和可靠性至关重要。不同的应用场景和需求,可能需要不同的算法。

例如,对于需要快速响应的实时系统,动态算法可能更加合适;而对于相对静态的应用场景,静态算法可能更加简单高效。算法选择不当可能会导致服务器负载不均,进而影响系统的整体性能和用户体验。

在实践中,除了考虑算法的性能外,还需考虑实现复杂度、配置灵活性和维护成本等因素。通过综合评估,选择最适合自身业务特点的负载均衡算法,才能确保系统的稳定高效运行。

# 3. 负载均衡实践部署

在现代IT架构中,负载均衡不仅是提高服务可用性和扩展性的关键工具,也是确保应用性能和成本效益的重要组成部分。为了深化理论与实践之间的联系,本章将探讨在不同环境下负载均衡的部署策略、配置实践以及监控与优化的技术细节。

## 3.1 云环境下的负载均衡部署

随着云计算的普及,负载均衡技术已经与云服务提供商提供的解决方案紧密集成。本节将深入探讨云环境下的负载均衡部署策略。

### 3.1.1 云平台负载均衡服务对比

不同的云平台提供商,如AWS、Google Cloud Platform和Azure,都提供了自己的负载均衡服务。这些服务在功能、性能和成本上有各自的特点。在对比分析时,关键参数包括支持的协议类型、实例数量、性能指标(如吞吐量和响应时间)、安全性、以及价格模型。

### 3.1.2 云服务与负载均衡的整合

整合云服务和负载均衡要求理解云服务架构,包括网络配置、资源分配和自动化扩展。例如,AWS的Elastic Load Balancing(ELB)可以自动分配流量到处于健康状态的云实例。在整合过程中,关键是确保负载均衡服务能够与云服务提供商的自动扩展特性无缝对接。

### 代码块示例:AWS ELB 配置实例

```bash

# 创建一个应用负载均衡器

aws elbv2 create-load-balancer \

--name my-load-balancer \

--subnets subnet-9d8b6123 subnet-2f357b1c \

--scheme internet-facing

# 创建一个目标组

aws elbv2 create-target-group \

--name my-target-group \

--port 80 \

--protocol HTTP \

--vpc-id vpc-1ac95706

# 注册目标实例到目标组

aws elbv2 register-targets \

--target-group-arn arn:aws:elasticloadbalancing:us-east-1:123456789012:targetgroup/my-target-group/123ab4cd5ef6gh789 \

--targets Id=i-1234567890abcdef0,Port=80

# 创建监听器规则

aws elbv2 create-rule \

--listener-arn arn:aws:elasticloadbalancing:us-east-1:123456789012:listener/app/my-load-balancer/50dc6c495c0c9188/8e42084c35b1b7b8 \

--priority 1 \

--conditions Field=path-pattern,Values=/* \

--actions Type=forward,TargetGroupArn=arn:aws:elasticloadbalancing:us-east-1:123456789012:targetgroup/my-target-group/123ab4cd5ef6gh789

```

在这个示例中,我们创建了负载均衡器、目标组,并为特定的路径模式设置了一个简单的监听器规则,将请求转发到后端目标组。每一步都需要确保参数设置正确,并与云平台提供的资源和服务有效对接。

## 3.2 负载均衡配置实例

为了解决实际问题并优化性能,本节将提供几种常见的负载均衡器配置实例,包括Nginx、HAProxy以及Keepalived的高级配置技巧。

### 3.2.1 Nginx的负载均衡配置

Nginx作为一个轻量级的Web服务器和反向代理服务器,它也提供了丰富的负载均衡特性。下面是一个基本的Nginx负载均衡配置示例。

```nginx

http {

upstream backend {

server backend1.example.com weight=5;

server backend2.example.com;

server backend3.example.com;

server backend4.example.com backup;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}

```

在这个配置中,Nginx将根据服务器权重(weight)对请求进行负载均衡。`backup`关键字指明了在其他服务器无法使用时,`backend4.example.com`服务器作为备份服务器。参数`weight`可以控制服务器处理请求的比例,从而实现了基于权重的负载均衡。

### 3.2.2 HAProxy的高级配置技巧

HAProxy是一个高性能的负载均衡器,支持高可用性和各种高级配置选项。下面展示了如何配置HAProxy实现会话持久性和健康检查。

```haproxy

frontend http_front

bind *:80

default_backend http_back

backend http_back

option forwardfor

balance roundrobin

server server1 192.168.1.100:80 check

server server2 192.168.1.101:80 check inter 2000 rise 2 fall 5

```

在此配置中,`option forwardfor`使得HAProxy可以将客户端IP传递给后端服务器。`balance roundrobin`指定轮询策略作为负载均衡算法。每个后端服务器都进行了健康检查,`check inter 2000 rise 2 fall 5`表示每2000毫秒检查一次,成功两次后服务器被认为是可用的,失败五次后服务器被认为是不可用的。

### 3.2.3 使用Keepalived实现高可用负载均衡

Keepalived是用于实现虚拟路由冗余协议(VRRP)的一种工具,可以通过心跳检测和虚拟IP来实现高可用的负载均衡架构。

```bash

# 安装Keepalived

apt-get install keepalived

# Keepalived配置文件示例

vrrp_instance VI_1 {

state MASTER

interface eth0

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.1.10

}

}

# 启动Keepalived服务

systemctl start keepalived

```

在这个示例中,Keepalived配置为MASTER模式,并在eth0网络接口上运行,拥有虚拟路由器ID为51和优先级为100。虚拟IP地址`192.168.1.10`将被分配给活动的负载均衡器。

## 3.3 负载均衡的监控与优化

为了保证系统性能和快速响应故障,监控和优化是负载均衡部署中不可或缺的部分。

### 3.3.1 监控工具和性能指标

对于负载均衡的监控,常用的工具包括Prometheus结合Grafana、New Relic、Datadog等。关键的性能指标包括响应时间、吞吐量、并发连接数、错误率、请求处理时间和会话持久性状态等。

### 3.3.2 性能调优和故障排查

性能调优通常包括调整负载均衡器的参数、优化后端服务和网络配置等。故障排查则需要根据监控到的性能指标进行系统性的分析,确定问题根源,并及时采取措施。在实际操作中,应该定期进行压力测试以确保系统在高负载下的稳定性。

### 表格示例:性能指标与监控工具对比

| 性能指标 | Prometheus + Grafana | New Relic | Datadog |

|----------|----------------------|-----------|---------|

| 响应时间 | 支持 | 支持 | 支持 |

| 吞吐量 | 支持 | 支持 | 支持 |

| 并发连接 | 支持 | 支持 | 支持 |

| 错误率 | 支持 | 支持 | 支持 |

| 会话持久性 | 支持 | 支持 | 支持 |

通过对比,我们可以选择最适合业务需求和现有基础设施的监控工具。

### Mermaid流程图示例:故障排查流程

```mermaid

graph TD

A[开始监控] --> B[收集性能指标]

B --> C[识别性能下降]

C --> D[分析问题根源]

D --> E{是配置问题?}

E -- 是 --> F[调整配置]

E -- 否 --> G{是后端服务问题?}

F --> H[重启并监控]

G -- 是 --> I[优化后端服务]

G -- 否 --> J[检查网络连接]

I --> H

J --> H

H --> K{性能恢复?}

K -- 是 --> L[结束]

K -- 否 --> M[进一步调查]

M --> C

```

故障排查流程图展示了一个标准化的问题诊断和解决过程,确保了系统监控的连贯性和效率。

通过以上章节的内容,我们逐步深入理解了负载均衡在云环境下的部署方法,具体配置实例,以及监控和优化的策略。每一步都需要细致的操作,以确保负载均衡系统的高效和稳定运行。接下来的章节,我们将通过实际案例分析进一步了解负载均衡的最佳实践。

# 4. 负载均衡最佳实践案例分析

在探讨了负载均衡的理论基础、工作原理及其在实践中的部署策略之后,本章节将深入分析负载均衡在不同场景下的最佳实践案例。我们将会检视高流量网站如何实施负载均衡策略以应对瞬时流量高峰,探讨在复杂的分布式系统中如何设计有效的负载均衡解决方案,以及如何在保证系统可用性的同时,确保负载均衡的安全性。

## 4.1 高流量网站的负载均衡策略

高流量网站经常面临用户访问量激增的挑战,这要求网站能够灵活地扩展资源,以提供连续无中断的服务。负载均衡在这一过程中发挥着关键作用,它能够高效地分配访问请求,确保后端服务器的负载均匀,防止任何单点过载。

### 4.1.1 案例背景和需求分析

本案例以一家知名的电商平台为背景,该平台在双11等大型促销活动期间,访问量会呈现指数级增长。因此,网站架构必须能够适应短时间内用户访问量的巨大波动,同时保持高性能和高可靠性。

通过对该电商平台的技术需求进行分析,我们发现了以下关键点:

- **高可用性**:服务必须持续在线,即使在流量峰值期间也不能出现宕机。

- **水平扩展能力**:能够根据流量自动或手动增加后端服务器资源。

- **性能优化**:在高流量下保持快速响应用户请求。

- **成本效率**:在满足上述条件的同时,要尽可能降低运营成本。

### 4.1.2 解决方案与实施步骤

结合上述需求,我们设计了如下的负载均衡解决方案,并分步骤实施:

#### 步骤一:选择合适的负载均衡器

考虑到电商平台的规模和需求,我们选择了云服务提供商的负载均衡服务,它具备高可用性、自动弹性扩展和易于管理的特点。

#### 步骤二:配置负载均衡策略

我们采取了会话持久性和动态权重分配相结合的策略。会话持久性确保用户会话在多个请求间保持在同一个后端服务器上,而动态权重分配则根据服务器当前负载实时调整新请求的分配。

```mermaid

flowchart LR

LB[负载均衡器] -->|请求| ServerA[服务器A]

LB -->|请求| ServerB[服务器B]

LB -->|请求| ServerC[服务器C]

ServerA -->|会话状态| LB

ServerB -->|会话状态| LB

ServerC -->|会话状态| LB

```

#### 步骤三:后端服务器扩展

结合云服务的自动扩展功能,在流量监测工具的辅助下,实现按需扩展和缩减服务器资源。

#### 步骤四:监控和优化

部署监控系统,实时监控流量、服务器性能、响应时间等关键指标。根据监控数据进行系统调优,比如调整缓存策略、数据库查询优化等。

### 4.1.3 成果评估与总结

经过实施上述方案,该电商平台在双11期间成功处理了数以亿计的用户请求,网站响应时间保持在毫秒级。此外,通过自动扩展功能,成功降低了运营成本。这些成果证明了我们所采用的负载均衡策略是高效且符合预期的。

## 4.2 分布式系统的负载均衡设计

分布式系统由于其组件分布在网络的不同节点上,天然就需要高效的负载均衡策略来确保服务的可用性和扩展性。本节将探讨分布式系统中负载均衡设计的要点和挑战。

### 4.2.1 分布式系统的特点

分布式系统通常由多个地理位置分散的服务器和数据库组成,这些组件需要协同工作以提供统一的服务。其特点包括:

- **高并发处理能力**:为了满足大量的并发请求,系统需要具备高度并行处理数据的能力。

- **高可用性和容错性**:任何组件的故障都不应该导致整个系统的不可用。

- **可扩展性**:系统应该能够随时增加或减少资源以适应不断变化的负载需求。

### 4.2.2 负载均衡在分布式系统中的角色

在分布式系统中,负载均衡器不仅仅是分配请求到后端服务器那么简单,它还需要确保数据的一致性、系统的可靠性和可伸缩性。主要角色包括:

- **请求分发**:有效地将请求分发到不同的服务器和数据库。

- **故障转移**:当某个节点发生故障时,自动将流量转移至其他正常节点。

- **数据一致性**:确保用户操作在分布式环境中的数据一致性。

### 4.2.3 设计要点和挑战

设计分布式系统的负载均衡需要考虑的要点包括:

- **分布式会话管理**:如何在不同服务器间有效管理用户的会话状态。

- **分布式缓存策略**:合理的缓存机制来减少数据访问延迟。

- **跨数据中心的负载均衡**:如何高效地管理跨地域的数据流量。

- **网络延迟与拥塞控制**:在网络延迟和拥塞时,如何保证服务质量。

挑战在于如何在保持性能和可用性的同时,设计出既经济又高效的负载均衡架构。这通常需要综合使用多种负载均衡技术和策略,如软件定义网络(SDN)、网络功能虚拟化(NFV)等。

## 4.3 负载均衡的安全性考量

随着负载均衡的广泛应用,其安全性也成为了不可忽视的方面。本节将介绍负载均衡的安全机制、策略以及如何防御DDoS攻击和其他威胁。

### 4.3.1 安全机制与策略

负载均衡器作为网络流量的第一入口,其安全性对整个系统的安全性至关重要。安全机制和策略通常包括:

- **访问控制**:仅允许认证和授权的流量通过。

- **会话加密**:保护用户会话和敏感数据的传输安全。

- **DDoS防护**:防止分布式拒绝服务攻击导致的流量过载。

### 4.3.2 防御DDoS攻击和其它威胁

DDoS攻击是目前网络环境中常见的安全威胁之一。为了有效防御此类攻击,我们需要:

- **流量监控**:实时监控进入网络的流量模式。

- **阈值设置**:根据正常流量模式设定阈值,一旦超过阈值立即触发警报。

- **动态过滤规则**:动态调整防火墙规则,阻止攻击流量。

- **清洗流量**:使用专业的DDoS防护服务来清洗恶意流量。

### 4.3.3 安全配置示例与最佳实践

以下是一个简单的负载均衡安全配置示例,使用Nginx作为负载均衡器:

```nginx

http {

upstream myapp {

server backend1.example.com;

server backend2.example.com;

server backend3.example.com;

}

server {

listen 80;

server_name www.example.com;

location / {

proxy_pass http://myapp;

proxy_next_upstream error timeout invalid_header http_500 http_502 http_503 http_504;

proxy_redirect off;

proxy_buffering off;

}

# 添加额外的安全配置

include /etc/nginx/security.conf;

}

}

```

在`security.conf`中,我们可以添加更多的安全策略,比如:

```nginx

# HTTP严格传输安全 (HSTS)

add_header Strict-Transport-Security "max-age=31536000; includeSubDomains";

# 内容安全策略 (CSP)

add_header Content-Security-Policy "default-src 'self'; script-src 'self' https://trusted.cdn.com";

# X-Frame-Options

add_header X-Frame-Options DENY;

# X-Content-Type-Options

add_header X-Content-Type-Options nosniff;

```

最佳实践方面,组织应该持续评估和更新其负载均衡配置,以应对新的安全威胁。这可能包括周期性的安全审核、使用安全工具进行漏洞扫描以及采用最新的安全补丁和技术。

通过上述分析,我们可以看到负载均衡的最佳实践并不仅仅局限于技术层面,它还需要对业务需求、系统架构以及潜在的安全威胁有深刻的理解。只有这样,我们才能设计出真正符合需求的解决方案。

# 5. 负载均衡技术的未来趋势

在当今数字化时代,负载均衡技术作为IT基础设施的核心组成部分,持续推动着云计算、边缘计算和人工智能等前沿技术的发展。本章节将深入探讨负载均衡技术的未来趋势,包括新兴技术与负载均衡的融合、负载均衡在边缘计算中的应用以及人工智能与负载均衡结合的前景和挑战。

## 5.1 负载均衡技术的发展动态

### 5.1.1 新兴技术与负载均衡的融合

随着新兴技术的不断发展,负载均衡技术正在与容器化技术、微服务架构、以及自动化运维等技术相融合,实现更加高效和灵活的资源管理。例如,Kubernetes已成为容器编排的标准工具,而负载均衡器与Kubernetes集成,可实现服务发现和自动负载分配。

**案例示例:**

考虑一个微服务架构的电商平台,服务容器化后,需要快速扩展或缩减服务实例来应对不同的流量高峰。这时,负载均衡器与Kubernetes API的整合能够动态调整服务实例的负载,提高系统弹性。

### 5.1.2 行业标准和趋势预测

负载均衡行业标准的发展,正逐渐从单一的性能指标向综合性能评估过渡。性能指标不仅包括传统的吞吐量、响应时间和并发连接数,还包括安全、高可用性和自动化管理能力。随着云服务厂商对负载均衡技术的重视,未来的负载均衡器将更加集成化、智能化。

**趋势预测:**

预计未来负载均衡器将更多集成AI功能,如智能流量预测和自动优化,同时与5G网络的结合将为远程医疗、智慧城市等应用带来更低延迟和更高效的服务。

## 5.2 负载均衡在边缘计算中的应用

### 5.2.1 边缘计算的基础概念

边缘计算将计算资源推向网络边缘,接近数据源头,实现数据的快速处理和低延迟通信。负载均衡在边缘计算中起着至关重要的作用,它确保了边缘节点的高效工作,以及根据网络状况和资源可用性智能分配工作负载。

### 5.2.2 负载均衡在边缘计算的角色

在边缘计算环境中,负载均衡器不仅要考虑数据中心内部资源的平衡,还要结合地理位置、网络状况和业务逻辑来优化工作负载分配。边缘负载均衡器可能需要处理实时数据分析任务,以及应对移动设备和服务的动态变化。

**应用实例:**

在自动驾驶汽车领域,车辆产生的数据需要实时处理,边缘负载均衡器可以确保数据在不同的地理位置节点之间高效传输,同时保证处理的实时性和安全性。

### 5.2.3 应用实例和挑战

边缘计算环境中的负载均衡器需要能够处理大量设备和数据流,同时保证低延迟。挑战在于如何在有限的边缘资源下实现高性能的负载均衡。解决方案可能包括使用边缘专用的轻量级负载均衡器,或者开发高效的资源调度算法。

## 5.3 人工智能与负载均衡的结合

### 5.3.1 AI在负载均衡决策中的应用

随着AI技术的不断进步,负载均衡决策过程可以利用机器学习算法来优化。AI可以通过分析历史和实时数据来预测流量模式,并据此动态调整资源分配策略。

**实践案例:**

一家大型在线视频服务公司,通过使用机器学习分析用户行为和网络流量模式,能够提前预测流量高峰并动态调整其服务器负载。这不仅减少了延迟,还提高了资源利用率。

### 5.3.2 智能负载均衡的实践案例

智能负载均衡器利用实时分析和预测算法来响应不断变化的网络条件和流量模式。智能决策可以减少手动干预,提高系统的整体效率和可靠性。

### 5.3.3 未来展望与技术革新

未来,随着机器学习和数据分析技术的不断成熟,我们可以预见负载均衡技术将变得更加智能和自适应。例如,结合自然语言处理(NLP)技术,负载均衡器甚至可以更好地理解和响应复杂的用户请求。

综上所述,负载均衡技术的未来发展将在云计算、边缘计算以及人工智能等多个领域持续演进,实现更加智能化、自动化和安全化的IT环境。随着这些前沿技术的融合,负载均衡将成为支撑未来数字世界的基础设施之一。

0

0