Python进阶技巧

发布时间: 2024-10-05 20:14:00 阅读量: 24 订阅数: 24

20个Python进阶技巧

# 1. Python进阶概念的理解与应用

Python语言以其简洁易读的语法和强大的功能受到众多开发者的青睐。进阶概念的理解与应用是高级Python开发者必须掌握的部分,它们包括但不限于上下文管理器、装饰器、上下文相关概念以及元编程等。掌握这些概念可以帮助开发者编写出更加优雅、高效的Python代码。

## 1.1 上下文管理器与`with`语句

在Python中,上下文管理器和`with`语句通常用于管理资源,如文件读写、锁的获取与释放等。它们利用了`__enter__`和`__exit__`这两个特殊方法。

```python

with open('file.txt', 'r') as ***

***

```

上面的例子中,`open`函数是一个上下文管理器,`with`语句确保文件在操作完成后被正确关闭,即使在读取文件时发生异常也是如此。

## 1.2 装饰器的设计与应用

装饰器是一种设计模式,允许在不修改原有函数或类的情况下增加额外的功能。它通常使用闭包和函数嵌套实现。

```python

def my_decorator(func):

def wrapper():

print("Something is happening before the function is called.")

func()

print("Something is happening after the function is called.")

return wrapper

@my_decorator

def say_hello():

print("Hello!")

say_hello()

```

在上面的示例中,`my_decorator`就是一个装饰器,它在`say_hello`函数执行前后增加了一些打印操作。装饰器是Python进阶开发中非常强大的工具,可以用来实现日志、权限检查、性能分析等多种功能。

掌握这些进阶概念,对于编写可读性高、维护性强的Python代码至关重要。下一章将探讨Python中的高级数据结构,这些数据结构为处理复杂数据提供了更有效的解决方案。

# 2. Python中的高级数据结构

### 2.1 高级数据结构概述

#### 2.1.1 数据结构的重要性

在处理复杂的应用逻辑时,数据结构的选择和使用将直接影响到程序的性能和效率。高级数据结构通常拥有更优的时间和空间复杂度,在处理大数据集时表现出色,因此它们在软件开发中扮演着关键角色。Python作为一门高级编程语言,内置了丰富的数据结构,如列表、字典、集合和元组等。对这些高级数据结构的深入理解不仅可以帮助我们编写更简洁、更高效的代码,还能让我们在设计算法时更加游刃有余。

#### 2.1.2 集合、字典和元组的高级特性

集合(Set)是无序且不重复的元素集。它的主要用途在于快速完成成员关系测试和消除重复元素,是进行数学运算如并集、交集和差集等的理想选择。集合的操作如并集和交集在Python中可以使用 `|` 和 `&` 操作符来实现,如 `s1 | s2` 表示两个集合的并集。

字典(Dictionary)是键值对的集合,其优点在于提供了快速的查找操作。字典的特性使得它非常适合于构建键值映射、存储和检索数据的场景。在Python中,字典的键必须是不可变的类型,而值可以是任意类型。

元组(Tuple)是一种不可变的序列类型,一旦创建不能修改。它常被用作记录数据,也常用于函数返回多个值时。元组的不可变特性让它们在函数式编程中非常有用,因为它们可以保证数据的一致性和线程安全。

### 2.2 自定义数据类型

#### 2.2.1 类和对象的深入理解

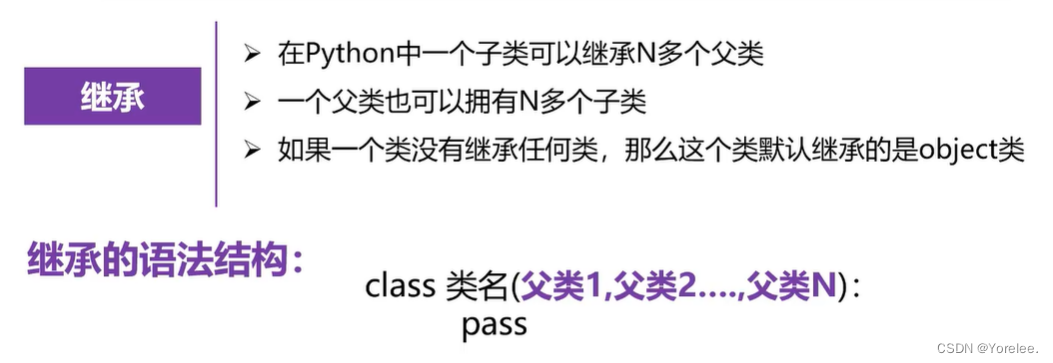

在Python中,类是创建对象的模板。在类的定义中,我们可以封装数据和函数(方法),定义自己的数据结构和操作。深入理解面向对象编程(OOP)可以帮助开发者编写更清晰、更易于维护的代码。Python支持封装、继承和多态这些OOP核心概念。

Python的类可以通过`__init__`方法来初始化对象的状态。类的方法可以使用`self`参数来访问对象的属性和其它方法。Python还支持`__slots__`机制,允许我们限制对象可以创建的属性,从而优化内存使用和提升访问速度。

#### 2.2.2 特殊方法和魔术方法的应用

Python中的特殊方法(也称为魔术方法)允许开发者定义对象如何响应各种语言操作。例如,`__str__`方法定义了对象的字符串表示,而`__len__`方法定义了对象的长度。通过这些方法,可以让自定义对象表现得像内置类型一样自然。

例如,我们可以定义一个简单的类,重载`__add__`方法以使两个实例相加时执行特定的行为:

```python

class SimpleNumber:

def __init__(self, value=0):

self.value = value

def __add__(self, other):

if isinstance(other, SimpleNumber):

return SimpleNumber(self.value + other.value)

else:

return NotImplemented

# 使用

a = SimpleNumber(1)

b = SimpleNumber(2)

c = a + b # c 会是一个SimpleNumber对象,其值为3

```

### 2.3 迭代器与生成器

#### 2.3.1 迭代器协议

Python中的迭代器协议允许一个对象被迭代。任何实现了`__iter__()`和`__next__()`方法的对象都是迭代器。迭代器协议是Python的可迭代对象的基础。可迭代对象是一个实现了`__iter__()`方法的对象,该方法返回一个迭代器。

理解迭代器对于编写高效和优雅的代码至关重要。例如,列表、字典、集合和元组都是可迭代的,因为它们都实现了`__iter__()`方法。当使用for循环时,Python会自动调用这些对象的`__iter__()`方法来获取迭代器。

#### 2.3.2 生成器的实现和优化

生成器提供了一种优雅的方式来处理序列,特别是当序列非常大且无法全部载入内存时。生成器通过延迟计算来产生值,从而节省内存。Python中的生成器函数使用`yield`关键字来产生值,而不是返回一个完整的列表。生成器表达式类似于列表推导式,但使用圆括号代替方括号。

使用生成器的典型好处是它们允许对一个大型数据集进行逐项处理,而不是一次性加载整个数据集到内存中。这在处理流数据或文件时尤其有用。

```python

def count_to(n):

count = 0

while count < n:

yield count

count += 1

# 使用

counter = count_to(5)

for c in counter:

print(c) # 输出: 0, 1, 2, 3, 4

```

生成器还可以通过组合来创建复杂的迭代器,允许开发者以惰性方式实现复杂的逻辑。这不仅简化了代码,还提高了执行效率,特别是在处理无限序列或大数据流时。

以上是本章的详细内容,介绍了高级数据结构在Python编程中的重要性、自定义数据类型的深入理解和迭代器及生成器的实现和优化。掌握这些高级数据结构能够使我们更加高效地进行数据处理和管理,为编写高质量的Python代码打下坚实的基础。在后续的章节中,我们将会进一步探索Python面向对象编程的进阶知识,以及性能优化技巧和Python在数据处理及Web开发中的高级应用。

# 3. ```

# 第三章:Python面向对象编程进阶

面向对象编程(OOP)是Python语言的核心概念之一,它通过对象抽象现实世界中具有相同特征和行为的实体。在本章节中,我们将深入探讨面向对象编程中的高级主题,如设计原则、类的高级特性,以及如何高效地利用多继承和混入类。

## 3.1 面向对象设计原则

### 3.1.1 SOLID原则在Python中的应用

SOLID原则是一组指导软件设计的五个面向对象设计原则的首字母缩写,它由Robert C. Martin提出,旨在提高软件的可读性、可扩展性和维护性。在Python中,SOLID原则同样适用,并且可以帮助我们编写出更加健壮和灵活的代码。

- **单一职责原则(Single Responsibility Principle, SRP)**:

每个类应该只有一个改变的理由,意味着一个类应该只负责一项任务。

- **开闭原则(Open/Closed Principle, OCP)**:

类应该对扩展开放,对修改关闭,即能够在不修改已有代码的情况下增加新的功能。

- **里氏替换原则(Liskov Substitution Principle, LSP)**:

子类对象应当能够替换掉所有父类对象,并且不会导致程序运行错误。

- **接口隔离原则(Interface Segregation Principle, ISP)**:

不应该强迫客户依赖于它们不用的方法,即使用多个专门的接口比使用单一接口要好。

- **依赖倒置原则(Dependency Inversion Principle, DIP)**:

高层模块不应该依赖于低层模块,两者都应该依赖于抽象;抽象不应该依赖于细节,细节应该依赖于抽象。

在Python中,我们可以通过抽象基类(ABCs)、接口(使用`abc`模块)和鸭子类型等特性来实现这些原则。例如:

```python

from abc import ABC, abstractmethod

class PaymentProcessor(ABC):

@abstractmethod

def process_payment(self, amount):

pass

class CreditCardProcessor(PaymentProcessor):

def process_payment(self, amount):

print(f"Processing {amount} via credit card.")

class PayPalProcessor(PaymentProcessor):

def process_payment(self, amount):

print(f"Processing {amount} via PayPal.")

# 通过继承抽象基类,实现了支付处理器的可扩展性

```

### 3.1.2 设计模式与Python代码的结合

设计模式是经过时间考验的、解决特定问题的模板。它们帮助开发者使用面向对象的方法来组织代码,从而应对各种常见问题。Python的动态类型系统和鸭子类型允许开发者以非常灵活的方式使用设计模式。

- **工厂模式**:

提供一个创建对象的接口,但由子类决定要实例化的类是哪一个。工厂方法让类的实例化推迟到子类中进行。

- **单例模式**:

确保一个类只有一个实例,并提供一个全局访问点。在Python中,我们通常使用模块或者类级别的属性来实现单例。

- **策略模式**:

定义一系列算法,把它们一个个封装起来,并使它们可相互替换。策略模式让算法的变化独立于使用算法的客户端。

以工厂模式为例:

```python

class PaymentProcessorFactory:

def create_processor(self, method):

if method == "credit_card":

return CreditCardProcessor()

elif method == "paypal":

return PayPalProcessor()

else:

raise ValueError("Unknown payment method")

# 使用工厂模式创建支付处理器

factory = PaymentProcessorFactory()

processor = factory.create_processor("credit_card")

processor.process_payment(100)

```

工厂方法模式的使用增加了支付方式的灵活性,而无需修改现有代码。

## 3.2 高级类特性

### 3.2.1 类装饰器和元类

类装饰器和元类是Python中强大的高级特性,它们允许我们修改或增强类的行为。

- **类装饰器**:

类装饰器是一个函数,它接受一个类作为参数并返回一个修改后的类。类装饰器可以用来添加属性、方法,或者改变类的行为。

- **元类**:

元类是创建类的“类”。它们定义了如何创建类对象,从而提供了强大的自定义类创建过程的能力。

下面是一个简单的类装饰器示例:

```python

def logged(cls):

class NewClass(cls):

def __getattribute__(self, name):

print(f"Calling {name}")

return super().__getattribute__(name)

return NewClass

@logged

class MyClass:

def method(self):

pass

instance = MyClass()

instance.method()

```

在这个例子中,`logged`类装饰器为`MyClass`类添加了一个日志功能,该功能会在每次属性或方法调用时输出。

### 3.2.2 属性描述符和属性控制

属性描述符是实现了`__get__`、`__set__`和`__delete__`特殊方法之一的类实例。它们提供了对属性访问的控制机制。

- **属性描述符**:

用于在类级别控制属性的访问,可以用于实现私有属性、只读属性等。

- **property装饰器**:

是一个简便的方法,用于将描述符应用到一个属性上。通过使用property装饰器,可以轻松创建只读属性或者将一个方法伪装成属性。

这里展示一个使用`property`装饰器的案例:

```python

class Temperature:

def __init__(self):

self._temperature = 0

@property

def temperature(self):

return self._temperature

@temperature.setter

def temperature(self, value):

if value < -273.15:

raise ValueError("Temperature below absolute zero")

self._temperature = value

# 使用property装饰器来控制temperature属性的访问和修改

```

在这个例子中,`temperature`属性通过`property`装饰器得到了控制,保证温度值不能低于绝对零度。

## 3.3 多继承和混入类

### 3.3.1 多继承的工作机制

在Python中,一个类可以继承自多个父类,这称为多继承。多继承机制增加了代码的复用性,但同时也可能导致菱形继承问题,即两个父类继承自同一个祖父类,最终的子类可能会继承到重复的祖父类属性和方法。

- **方法解析顺序(MRO)**:

Python使用C3线性化算法来解决方法解析顺序问题,确保每个类在继承时,它的方法和属性能够被正确地解析。可以通过`__mro__`属性或者`mro()`方法来查看类的方法解析顺序。

- **混入类(Mixin)**:

为了实现代码的重用,通常会使用混入类。混入类是一个设计用来为其他类提供额外功能的类,但不自己实现全部功能。它们通常被用作多重继承中的一个或多个父类。

下面展示了多继承和混入类的使用:

```python

class MoveMixin:

def move(self):

print("MoveMixin move")

class RotateMixin:

def rotate(self):

print("RotateMixin rotate")

class FlyingCar(MoveMixin, RotateMixin):

pass

car = FlyingCar()

car.move() # 输出 "MoveMixin move"

car.rotate() # 输出 "RotateMixin rotate"

```

在这个例子中,`FlyingCar`类通过继承`MoveMixin`和`RotateMixin`混入类,同时具备了移动和旋转的功能,而无需实现具体的方法逻辑。

### 3.3.2 混入类的设计模式和实践

混入类是实现组合优于继承原则的一种方式,它们提供了一种在多个类之间共享代码的手段。在设计模式中,混入类可以用来实现以下功能:

- **增加类的可复用性**:

通过混入类,我们可以将通用功能提取到单独的类中,然后将这些类作为父类加入到我们的类层次结构中。

- **分离关注点**:

在大型应用程序中,使用混入类可以帮助我们分离出系统的不同关注点,使得结构更加清晰。

- **提供可插拔的特性**:

混入类可以像插件一样被加入到类定义中,这样我们就可以在不修改原有类的情况下增加新的特性。

混入类的实践通常需要深入理解类的继承和方法解析顺序(MRO),以避免常见的陷阱,例如方法解析顺序带来的问题和混入类方法之间的冲突。

通过这些面向对象的高级特性,Python程序员可以构建出更加灵活、可维护和可扩展的应用程序。在下一节中,我们将探讨多继承的工作机制及其最佳实践,以及如何通过混入类设计模式提升软件设计的质量。

```

# 4. Python性能优化技巧

在现代软件开发中,性能优化是一个不可忽视的环节。特别是对于需要处理大量数据或服务高并发请求的应用来说,性能优化可以显著提升用户体验和系统稳定性。Python作为一种广泛使用的高级编程语言,虽然在易用性上有优势,但其在性能方面有时并不占优。幸运的是,Python社区提供了众多工具和技巧来帮助开发者优化代码性能。本章节将深入探讨Python性能优化的不同策略和实践。

## 4.1 代码优化策略

代码优化是性能提升的基础。合理地重写代码可以让程序运行更快、更高效。

### 4.1.1 理解Python的内存模型

Python使用引用计数来管理内存,同时还有垃圾收集机制来自动释放不再使用的对象。优化内存使用的关键在于理解如何减少对象的创建和增加对象的重用。

**代码块示例:**

```python

import sys

# 显示当前Python的内存使用情况

print(f"Initial memory usage: {sys.getsizeof(10)} bytes")

# 临时创建一些对象

for i in range(1000000):

_ = str(i)

# 再次查看内存使用情况

print(f"Memory usage after creating objects: {sys.getsizeof(10)} bytes")

```

在上述代码块中,我们通过`sys.getsizeof`函数来查看Python对象的内存占用。创建大量临时对象将导致内存使用增加,这会影响程序性能,特别是在数据密集型操作中。

**参数说明:**

- `sys.getsizeof`: 返回一个对象所占用的内存大小,单位为字节。

**逻辑分析:**

在编写代码时,应该尽量避免创建不必要的对象,特别是那些会迅速创建和销毁的临时对象。通过使用生成器表达式代替列表推导、共享大型数据结构、使用局部变量代替全局变量等方法,可以减少内存使用。

### 4.1.2 缓存和重复利用技巧

在需要多次计算相同结果的场景下,缓存(也称为记忆化)是一个提升性能的有效手段。缓存可以存储函数的返回值,当函数再次被调用时,可以直接返回存储的结果,无需重新计算。

**代码块示例:**

```python

import functools

@functools.lru_cache(maxsize=None)

def fibonacci(n):

if n < 2:

return n

return fibonacci(n-1) + fibonacci(n-2)

# 计算第30个斐波那契数

fibonacci(30)

```

**参数说明:**

- `functools.lru_cache`: 一个装饰器,用于缓存函数的调用结果。`maxsize`参数用于设置缓存的最大项数。

**逻辑分析:**

上述示例中,我们用`functools.lru_cache`装饰器来缓存`fibonacci`函数的计算结果。这样当计算较大的斐波那契数时,可以显著减少递归调用的次数,从而提升性能。缓存策略尤其适用于I/O密集型操作和计算密集型操作,可以有效地避免重复计算。

## 4.2 并发编程模型

Python中实现并发的机制包括多线程、多进程和异步编程。合理选择并发模型对于性能优化至关重要。

### 4.2.1 多线程编程的深入解析

Python的全局解释器锁(GIL)使得多线程不能在多核CPU上实现真正的并行执行。尽管如此,在I/O密集型任务中,使用多线程仍然可以显著提升性能。

**代码块示例:**

```python

import threading

def thread_function(name):

print(f'Thread {name}: starting')

# 模拟I/O操作

for i in range(3):

print(f'Thread {name}: {i}')

print(f'Thread {name}: finishing')

threads = list()

for index in range(3):

x = threading.Thread(target=thread_function, args=(index,))

threads.append(x)

x.start()

for index, thread in enumerate(threads):

thread.join()

```

**逻辑分析:**

在这个多线程示例中,我们创建了三个线程来模拟同时执行I/O操作的情况。尽管由于GIL的存在,并发执行受到限制,但通过多线程可以改善阻塞性I/O操作导致的CPU闲置时间。

### 4.2.2 异步编程和事件驱动模型

异步编程可以使用`asyncio`库来实现,它特别适合处理大量的网络连接,例如Web服务器或网络爬虫。

**代码块示例:**

```python

import asyncio

async def factorial(name, number):

f = 1

for i in range(2, number + 1):

print(f"Task {name}: Compute factorial({i})...")

await asyncio.sleep(1)

f *= i

print(f"Task {name}: factorial({number}) = {f}")

async def main():

# 启动并等待任务完成

await asyncio.gather(

factorial("A", 2),

factorial("B", 3),

factorial("C", 4),

)

# 运行主函数

asyncio.run(main())

```

**逻辑分析:**

在异步编程模型中,`asyncio.sleep`是一个异步操作,它允许事件循环在等待IO操作完成时切换到其他任务,从而提升性能。通过并发执行多个异步任务,可以极大地提高程序的效率,特别是在网络密集型或高频率的I/O操作场景中。

## 4.3 性能分析工具

性能分析工具是性能优化过程中的利器,可以帮助开发者找出瓶颈所在。

### 4.3.1 cProfile和line_profiler的使用

Python的内置模块`cProfile`和第三方模块`line_profiler`都可以用来分析Python代码的性能。

**代码块示例:**

```python

import cProfile

def sum_of_squares(n):

return sum(i * i for i in range(n))

cProfile.run('sum_of_squares(100000)')

```

**逻辑分析:**

上述代码使用`cProfile`模块分析了计算`100000`以内整数平方和的函数性能。执行后会输出每个函数调用的次数和总耗时,帮助开发者定位性能瓶颈。

### 4.3.2 优化前后的性能对比分析

在优化代码后,通常需要对比优化前后的性能差异。这可以通过记录关键操作的时间来完成。

**代码块示例:**

```python

import time

start_time = time.time()

sum_of_squares(100000)

end_time = time.time()

print(f"Time taken: {end_time - start_time} seconds")

```

通过记录代码执行前后的系统时间,我们可以计算出优化措施带来的性能提升。

**参数说明:**

- `time.time`: 返回当前时间的时间戳。

**逻辑分析:**

在进行性能优化时,应该使用这样的时间记录方法来对比优化前后的性能差异。这可以帮助开发者直观地看到改进的成效,并指导进一步的优化工作。

性能优化是一个涉及多个方面的复杂过程,需要开发者深入理解程序的运行机制和资源使用情况。通过代码优化、合理运用并发编程模型,以及利用专业的性能分析工具,开发者能够显著提升Python程序的性能和效率。在后续章节中,我们将继续探讨Python在数据处理和Web开发领域的高级应用和优化技巧。

# 5. Python在数据处理中的高级应用

## 5.1 高级数据处理技巧

### 5.1.1 使用Pandas进行复杂数据分析

Pandas库是Python数据处理领域中的核心工具之一,它提供了高性能、易用的数据结构和数据分析工具。在进行复杂数据分析时,Pandas不仅能够轻松处理大规模数据集,还能通过其丰富的接口进行数据清洗、转换、分析和可视化。

首先,掌握Pandas的基础数据结构Series和DataFrame是必要的。Series是带有标签的一维数组,而DataFrame则是二维标签化数据结构,可以认为是一个表格或者说是Excel工作表的实现。通过索引和切片的方式,可以方便地对数据进行查询和修改。

```python

import pandas as pd

# 创建一个简单的DataFrame

df = pd.DataFrame({

'A': ['foo', 'bar', 'baz', 'qux'],

'B': [1, 2, 3, 4]

})

print(df)

```

接下来,我们可以通过多种方式对数据进行预处理。例如,使用`fillna()`方法来填补数据中的空值,或者使用`dropna()`方法删除包含空值的行或列。数据清洗是数据分析中非常重要的一步,这直接关系到分析结果的准确性。

```python

# 替换空值为0

df_filled = df.fillna(0)

# 删除包含空值的行

df_dropped_rows = df.dropna(axis=0)

# 删除包含空值的列

df_dropped_columns = df.dropna(axis=1)

```

在复杂数据分析中,经常需要对数据进行聚合和分组处理。Pandas提供了`groupby()`方法,这个方法能够让我们根据某些键对数据进行分组,并对各组应用聚合函数。

```python

# 假设我们想要根据'A'列的值来对'B'列进行求和

result = df.groupby('A')['B'].sum()

print(result)

```

Pandas还提供了多种统计方法,如描述性统计,相关系数计算等,这使得我们在进行统计分析时更为便捷。

```python

# 计算描述性统计

desc_stats = df.describe()

# 计算相关系数

correlation = df.corr()

```

对于大规模数据集,Pandas支持高效的读写操作,可以处理多种格式的数据,如CSV、Excel、JSON、HDF5等。此外,Pandas与SQL数据库的连接也非常流畅,可以轻松地从数据库中提取数据。

Pandas通过提供这些丰富而强大的功能,极大地简化了复杂数据分析的过程,让数据科学家和分析师能够专注于数据洞察的提炼,而非数据处理的细节。

### 5.1.2 NumPy高级特性及矩阵运算

NumPy库是Python科学计算领域的基石,它为Python提供了高性能的多维数组对象以及相关工具。NumPy数组(ndarray)是用于存储数值数据的标准方式,且这些数据是同质的,意味着数组中的所有元素都具有相同的数据类型。

在复杂的数据处理任务中,NumPy提供了一套完整的数组操作和数学运算功能,这使得在进行数值分析时非常高效。例如,NumPy支持广泛的数组索引方式,包括布尔索引、花式索引和切片索引等。

```python

import numpy as np

# 创建一个NumPy数组

arr = np.array([[1, 2, 3], [4, 5, 6]])

# 使用切片索引获取子集

sub_arr = arr[0:2, 1:3]

# 使用布尔索引过滤数据

bool_index = arr[arr > 2]

print(sub_arr)

print(bool_index)

```

在进行矩阵运算时,NumPy提供了一系列高效的数学函数和通用函数(ufuncs)。这些函数能够对数组中的数据进行快速操作,如求和、求差、乘法、三角函数等,并且支持数组的广播规则,使得操作不同形状的数组变得简单。

```python

# 使用通用函数进行数组运算

arr1 = np.array([1, 2, 3])

arr2 = np.array([4, 5, 6])

# 广播机制实现两个数组的加法

result = arr1 + arr2

print(result)

```

NumPy在矩阵运算方面尤其突出,它提供了`dot`、`vdot`、`matmul`等函数用于进行点积、向量点积、矩阵乘法等操作。

```python

# 使用NumPy进行矩阵乘法

A = np.array([[1, 2], [3, 4]])

B = np.array([[5, 6], [7, 8]])

# 计算矩阵乘法

product = np.dot(A, B)

print(product)

```

除了基础的矩阵运算功能,NumPy还包含了一些用于生成特殊矩阵的函数,比如对角矩阵、单位矩阵、随机矩阵等,这对于某些算法的实现是必不可少的。

```python

# 生成一个单位矩阵

identity_matrix = np.eye(3)

print(identity_matrix)

```

除了这些,NumPy在信号处理、图像处理以及线性代数等领域同样提供了强大的支持。借助于这些高级特性,用户可以在进行复杂的数值分析时,大幅提高效率和精度。

### 5.1.3 高级数据处理框架集成应用

在实际应用中,数据处理往往不是孤立的,它需要与其他工具和框架紧密集成。Python的数据生态系统非常丰富,除了Pandas和NumPy,还有如SciPy、Matplotlib、Scikit-learn等众多库,它们之间可以无缝协作,形成强大的数据处理和分析能力。

例如,在数据科学的流程中,我们可能需要从CSV文件中读取数据,然后使用Pandas进行数据清洗和预处理,接着借助Scikit-learn构建机器学习模型,最后使用Matplotlib进行数据可视化展示。这样的集成应用大大提高了数据处理的效率和质量。

.fit(X, y)

# 使用Matplotlib绘制数据点和拟合线

plt.scatter(X, y, color='black')

plt.plot(X, model.predict(X), color='blue', linewidth=3)

plt.show()

```

在集成应用中,每个工具和库都有其特定的角色和优势,它们相互补充,共同构成了Python强大的数据处理能力。通过这种集成,开发者能够灵活地应对各种复杂的数据问题,从数据清洗到最终的数据分析报告,形成一条高效的数据处理流水线。

在本章中,我们通过Pandas和NumPy的详细讲解,展现了Python在高级数据处理方面的强大力量。结合这些库的高级特性,我们能够应对绝大多数复杂的数据分析任务。同时,通过集成其他高级框架,我们可以进一步拓宽Python在数据科学领域的应用范围,实现更为复杂和精准的数据处理与分析。

## 5.2 机器学习与数据分析

### 5.2.1 掌握Scikit-learn的高级用法

Scikit-learn是Python中一个非常流行的机器学习库,它集成了多种机器学习算法,并提供了统一的接口,使得机器学习变得简单易懂。在掌握Scikit-learn的基础使用后,我们可以进一步探索它的高级特性,例如特征提取、管道(Pipeline)和模型选择等。

Scikit-learn的高级特性使得我们能够更加高效地处理复杂的机器学习任务。首先,特征提取是机器学习中至关重要的一步,正确的特征能够有效提升模型的性能。Scikit-learn提供了多种特征提取的方法,包括文本处理、图像处理等领域的转换工具,能够帮助我们将原始数据转换为机器学习模型可以理解的格式。

```python

from sklearn.feature_extraction.text import CountVectorizer

# 示例文本数据

documents = ['The sky is blue.', 'The sun is bright.', 'The sun in the sky is bright.']

# 创建一个计数向量转换器对象

vectorizer = CountVectorizer()

# 对文档数据进行向量化处理

X = vectorizer.fit_transform(documents)

print(X.toarray())

```

接下来是Scikit-learn的管道(Pipeline)功能,它允许我们将多个处理步骤组合到一起,并且能够自动处理数据的转换和模型的训练。使用管道可以使得我们的代码更加清晰,并且方便进行交叉验证和模型调优。

```python

from sklearn.pipeline import Pipeline

from sklearn.svm import SVC

# 创建一个管道,包含文本向量化和分类器两个步骤

text_clf = Pipeline([

('vect', CountVectorizer()),

('clf', SVC()),

])

# 使用管道进行模型的训练和预测

text_clf.fit(documents, ['blue', 'bright', 'bright'])

predicted = text_clf.predict(['The sun is shining.'])

print(predicted)

```

在模型选择方面,Scikit-learn提供了网格搜索(GridSearchCV)功能,这使得我们能够系统地对一组参数进行调优,找到最优的模型配置。

```python

from sklearn.model_selection import GridSearchCV

# 定义SVC的参数网格

param_grid = {'C': [1, 10, 100, 1000], 'gamma': [0.001, 0.0001], 'kernel': ['rbf']}

# 创建GridSearchCV对象

grid_search = GridSearchCV(SVC(), param_grid, cv=5)

# 训练网格搜索

grid_search.fit(documents, ['blue', 'bright', 'bright'])

# 输出最佳参数和交叉验证分数

print("Best parameters set:")

print(grid_search.best_params_)

print("GridSearchCV score: {:.2f}".format(grid_search.best_score_))

```

Scikit-learn的高级用法还包括了集成学习技术,如随机森林、梯度提升树和AdaBoost等,这些技术通过组合多个模型来提高预测的准确率和鲁棒性。

```python

from sklearn.ensemble import RandomForestClassifier

# 创建随机森林分类器

rf_clf = RandomForestClassifier(n_estimators=100, random_state=42)

# 训练模型

rf_clf.fit(documents, ['blue', 'bright', 'bright'])

# 预测

predicted = rf_clf.predict(['The sun is shining.'])

print(predicted)

```

通过掌握Scikit-learn的高级用法,我们可以构建出更为复杂、性能更优的机器学习模型。这些高级特性不仅提高了模型的准确性,也提高了开发效率,使得我们可以快速地将机器学习应用到实际问题中去。

### 5.2.2 数据挖掘与预测模型构建

在数据挖掘过程中,我们经常需要构建预测模型来分析和预测数据。通过使用Python及其生态系统中的工具,如Scikit-learn、Pandas、NumPy等,我们可以完成从数据预处理到模型训练再到结果分析的整个流程。

构建预测模型的第一步是对数据进行预处理。在这一阶段,我们需要清洗数据、处理缺失值、转换数据格式等,以确保数据质量。

```python

# 使用Pandas处理缺失值

df = pd.DataFrame({

'feature1': [1, np.nan, 3, 4],

'feature2': [5, 6, np.nan, 8],

'target': [0, 1, 0, 1]

})

# 替换缺失值为中位数

df.fillna(df.median(), inplace=True)

```

数据预处理完成后,我们需要选择合适的特征进行模型训练。这一步可能包括特征选择和特征工程,目的是找出最有代表性的特征并提升模型性能。

```python

from sklearn.feature_selection import SelectKBest

from sklearn.feature_selection import f_classif

# 使用SelectKBest进行特征选择

X_new = SelectKBest(f_classif, k=1).fit_transform(df.drop('target', axis=1), df['target'])

# 查看选择后的特征

print(X_new)

```

在模型训练阶段,我们可以尝试不同的算法,如逻辑回归、随机森林或支持向量机(SVM)等,并通过交叉验证来评估模型性能。

```python

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LogisticRegression

# 创建逻辑回归模型

logreg = LogisticRegression()

# 使用交叉验证评估模型性能

scores = cross_val_score(logreg, X_new, df['target'], cv=5)

print("Cross-validation scores:", scores)

```

模型评估后,我们会选择表现最好的模型,并在测试集上进行最终的性能评估。如果性能满意,则可以将模型部署到生产环境中,进行实际的预测任务。

```python

# 假设我们有一个测试集

test_df = pd.DataFrame({

'feature1': [2, 3],

'feature2': [6, 8],

})

# 对测试集进行同样的预处理

test_X_new = SelectKBest(f_classif, k=1).fit_transform(test_df.drop('target', axis=1), test_df['target'])

# 使用训练好的模型进行预测

predictions = logreg.predict(test_X_new)

print("Predictions:", predictions)

```

数据挖掘和预测模型构建是一个迭代的过程,经常需要反复调整模型参数或尝试不同的算法来达到最佳性能。借助Python的强大功能,我们可以有效地完成这一过程,并实现高效的预测任务。

在本章节中,我们介绍了使用Python进行数据挖掘和预测模型构建的一系列方法和步骤。通过集成不同库的高级特性,我们能够构建出强大且灵活的数据分析和预测解决方案。无论是在金融领域进行信用评分,还是在市场营销中进行客户细分,Python都提供了丰富的工具,帮助我们实现这些复杂的数据处理任务。

## 5.3 数据可视化与报告

### 5.3.1 Matplotlib和Seaborn的高级图表绘制

数据可视化是数据科学中不可或缺的一部分。它不仅帮助我们更直观地理解数据,也是向他人展示分析结果的重要方式。Python提供了多个强大的库来进行数据可视化,Matplotlib和Seaborn就是其中最流行的两个。

Matplotlib是Python中最基本的绘图库,它提供了一套类似于MATLAB的绘图API,可以用来绘制各种静态、动态、交互式的图表。尽管Matplotlib的语法相对复杂,但它的灵活性很高,几乎可以定制图表的每一个细节。

```python

import matplotlib.pyplot as plt

import numpy as np

# 创建数据

x = np.linspace(0, 10, 100)

y = np.sin(x)

# 绘制基本的折线图

plt.plot(x, y)

plt.title('Sine Wave')

plt.xlabel('x values')

plt.ylabel('sin(x)')

plt.show()

```

Seaborn则是基于Matplotlib构建的一个高级可视化库。它对Matplotlib进行了封装,并提供了更加美观的默认样式和颜色。Seaborn也提供了许多专门的图表类型,比如用于统计分析的箱形图、直方图、散点图等。

```python

import seaborn as sns

import pandas as pd

# 使用Seaborn绘制散点图

tips = sns.load_dataset('tips')

sns.scatterplot(x='total_bill', y='tip', data=tips)

plt.title('Scatterplot of Total Bill vs. Tip')

plt.xlabel('Total Bill')

plt.ylabel('Tip')

plt.show()

```

Seaborn还提供了用于探索性数据分析的高级功能,如关系图、分类图等。这些功能可以帮助我们快速发现数据中的趋势和模式。

```python

# 使用Seaborn绘制箱形图

sns.boxplot(x='day', y='total_bill', data=tips)

plt.title('Boxplot of Total Bill by Day')

plt.xlabel('Day of the Week')

plt.ylabel('Total Bill')

plt.show()

```

使用Matplotlib和Seaborn,我们可以创建复杂且美观的图表,从而使得数据的展示和分析更加高效和直观。

### 5.3.2 Jupyter Notebook的交互式报告

Jupyter Notebook是一个开源的Web应用程序,它允许用户创建和共享包含实时代码、方程式、可视化和文本的文档。这些文档被称为“notebooks”,它们广泛应用于数据清理和转换、数值模拟、统计建模、机器学习等领域的分析和报告。

Jupyter Notebook的一个显著特点是其交互性。用户可以直接在notebook中编写和执行代码,实时查看输出结果。这不仅使得数据分析的过程变得更加直观,而且也便于调试和分享。

plt.title('Simple Plot')

plt.xlabel('X Axis')

plt.ylabel('Y Axis')

plt.show()

```

在Jupyter Notebook中,我们可以轻松地将Matplotlib或Seaborn图表嵌入到单元格中。此外,我们可以添加Markdown文本、LaTeX公式、以及视频和图像等多媒体内容,从而使得报告更为丰富和完整。

:

plt.plot(x, y)

plt.title('Custom Plot')

plt.xlabel('X values')

plt.ylabel('Y values')

plt.show()

# 使用不同的参数

plot_data([0, 1, 2, 3], [0, 3, 2, 5])

```

由于Jupyter Notebook的交互性和可读性,它已经成为数据科学领域的一个标准工具。它不仅被用于个人数据分析,也是教育、研究和工业界进行协作和分享知识的重要平台。

在本章节中,我们学习了使用Matplotlib和Seaborn进行高级图表绘制的方法,以及利用Jupyter Notebook进行交互式报告的技巧。这些工具和平台为数据科学家提供了强大的数据可视化和分析报告功能,使得数据分析的过程和结果展示更为高效、直观和易于理解。

通过上述介绍,我们了解了Python在数据处理中的高级应用,包括数据处理技巧、机器学习应用、数据可视化以及报告的创建。掌握了这些知识点后,我们可以充分利用Python强大的数据处理功能,为各种复杂的数据分析任务提供解决方案。

# 6. Python在Web开发中的进阶实践

在Web开发的世界中,Python的使用已经变得越来越广泛和深入。从底层的服务器网关接口(WSGI)到成熟的Web框架如Django和Flask,再到复杂的RESTful API设计以及安全性和性能优化,Python都能够提供强大的支持。本章节将带你深入了解Python在Web开发中的高级实践。

## 6.1 深入理解WSGI标准

### 6.1.1 WSGI的原理和工作方式

WSGI是Web服务器和Python Web应用程序之间的一个简单、标准化的接口。它由PEP 333定义,为Python应用程序提供了一个标准化的通信协议。当Web服务器收到HTTP请求时,它会将请求传递给WSGI应用程序,并将应用程序的响应返回给客户端。

WSGI接口包括两个主要的组件:服务器(或网关)和应用程序。服务器的责任是接收来自客户端的请求,然后调用应用程序,并将应用程序返回的响应发送回客户端。应用程序的责任则是处理请求并返回响应。应用程序可以使用框架编写,如Django、Flask等,这些框架内部实现了WSGI标准。

### 6.1.2 中间件的开发与应用

中间件位于WSGI服务器和应用程序之间,可以用来修改请求和响应,提供跨应用程序的公共服务。例如,中间件可以用于处理认证、日志记录、内容压缩等功能。

开发中间件需要遵循WSGI的规范,创建一个可调用对象,该对象接受两个参数:环境字典和启动响应的函数。例如,下面是一个简单的中间件示例,它会打印出请求的路径:

```python

def simple_middleware(environ, start_response):

path = environ.get('PATH_INFO', None)

print("Handling path:", path)

return start_response('200 OK', [('Content-Type', 'text/plain')])

```

在WSGI应用程序中,中间件按照它们在配置中的顺序被调用。中间件可以调用下一个中间件或应用程序,从而形成一个调用链。

## 6.2 框架深入与定制

### 6.2.1 Django和Flask框架的高级特性

Django是一个全功能的MVC(Model-View-Controller)框架,提供了一个完整的解决方案,从数据库到模板渲染再到管理界面。其高级特性包括ORM(对象关系映射)、强大的管理员界面、中间件、信号和缓存框架。

Flask是一个轻量级的WSGI web应用程序框架,适合快速开发小型应用程序。其高级特性包括灵活的路由系统、模板引擎、强大的扩展生态系统和RESTful请求处理。

为了满足特定需求,开发者经常需要定制框架。在Django中,可以通过继承内置类来自定义ORM行为,而在Flask中,可以编写自定义的装饰器和扩展来增强功能。

### 6.2.2 框架扩展和RESTful API设计

在开发过程中,扩展框架以满足特定需求是很常见的。例如,可以在Django中创建自定义的表单字段或者管理命令,而在Flask中可以添加自定义的模板过滤器或上下文处理器。

RESTful API设计已经成为构建Web服务的标准。通过定义资源的URL和使用HTTP方法(如GET、POST、PUT、DELETE),开发者可以创建一个既简单又强大的API。Django REST framework是一个为Django提供的强大且灵活的工具包,用于构建Web API。它支持序列化、权限控制、认证和分页等功能。

## 6.3 安全性与性能优化

### 6.3.1 网站安全性的最佳实践

安全性是Web开发中不可忽视的部分。网站安全性的最佳实践包括使用HTTPS、保护敏感数据、防止SQL注入、实施身份验证和授权、防止跨站脚本攻击(XSS)和跨站请求伪造(CSRF)等。

例如,在Django中,可以通过CSRF令牌来防止CSRF攻击,同时还可以通过配置`SECURE_SSL_REDIRECT`设置项来强制HTTPS。Flask中也有类似的扩展来增强安全性。

### 6.3.2 性能调优及部署策略

性能优化是提高Web应用响应速度和处理能力的关键。使用缓存来减少数据库的查询频率、使用异步处理来提高并发请求处理能力、优化代码逻辑以及资源压缩等都是性能优化的常用方法。

部署策略也对性能有重大影响。选择合适的Web服务器(如Nginx、Apache)、负载均衡器以及使用云服务和容器化(如Docker)都可以提高应用的稳定性和扩展性。

在本章中,我们深入探讨了Python在Web开发中的高级实践,包括WSGI标准、框架深入与定制、安全性与性能优化等关键主题。通过实际的代码示例和分析,我们了解了如何利用Python的强大功能来构建高效、安全的Web应用。在未来,随着技术的不断进步,Python在Web开发中的应用将会更加广泛,而掌握这些高级实践对于每一个Python Web开发者来说都至关重要。

0

0