【ANSYS文件操作高阶】:数据处理的高级技巧详解

发布时间: 2024-12-04 18:47:23 阅读量: 20 订阅数: 29

java+sql server项目之科帮网计算机配件报价系统源代码.zip

参考资源链接:[ANSYS命令流完全指南:2023R1版](https://wenku.csdn.net/doc/82vdfzdg9p?spm=1055.2635.3001.10343)

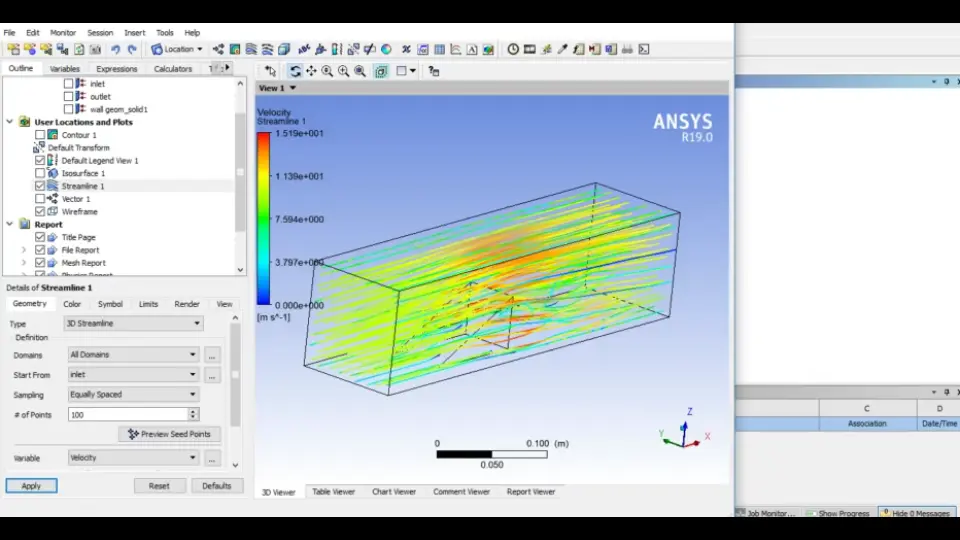

# 1. ANSYS文件操作概述

ANSYS作为一个强大的计算机辅助工程(CAE)软件,广泛应用于工程模拟、分析和优化领域。在使用ANSYS进行复杂仿真过程中,有效的文件操作是至关重要的。本章旨在为读者提供一个全面的ANSYS文件操作概览,涵盖基本的文件交互、格式理解以及为后续章节中深入探讨的高级策略和技巧打下基础。

在开始之前,我们将简要了解ANSYS中文件的基本类型和结构,以及如何通过ANSYS软件和其APDL(ANSYS参数设计语言)执行常见的文件操作任务。我们还将学习文件操作对仿真流程效率的重要性,为深入研究提供必要的理论支撑。

最后,我们将探讨一些最佳实践和技巧,帮助用户避免常见错误,提高ANSYS工作流程的效率。例如,我们将讨论如何在ANSYS中进行文件保存、导出、导入,以及如何管理这些文件以确保数据的完整性和准确性。

```mermaid

flowchart LR

A[ANSYS文件操作概述] --> B[ANSYS文件类型与结构]

A --> C[文件操作基本任务]

A --> D[文件操作对仿真效率的影响]

D --> E[最佳实践与避免常见错误]

B --> F[文件保存、导出和导入]

C --> G[文件管理技巧]

```

通过本章的学习,读者将能够对ANSYS的文件操作有一个清晰的认识,并为深入探索高级文件读写技巧打下坚实的基础。

# 2. 高级文件读写技巧

## 2.1 文件读取的深入策略

### 2.1.1 高效读取大型文件

在处理大型文件时,传统的逐行读取方式可能会导致性能瓶颈,特别是在需要对数据进行复杂分析的情况下。为了提高读取效率,可以采用以下策略:

- **分块读取**: 将文件分割成若干块,每次读取一小部分数据进行处理,而不是一次性加载整个文件到内存。这样可以有效控制内存使用,提高处理速度。

- **流式处理**: 对于顺序访问文件的场景,可以采用流式处理,边读边处理数据,减少内存占用。

- **多线程/多进程**: 利用多线程或多进程并行读取文件,可以显著提高读取速度,但需要注意数据同步和并发控制问题。

示例代码块展示如何用Python进行分块读取文件:

```python

def read_large_file(file_path, chunk_size=1024):

"""分块读取文件,按块大小逐块返回数据"""

with open(file_path, 'rb') as file:

while True:

data = file.read(chunk_size)

if not data:

break

yield data

# 使用示例

for chunk in read_large_file('large_data_file.bin'):

# 对块数据进行处理

process_data(chunk)

```

### 2.1.2 字符串处理与模式匹配

文件读取过程中,经常需要对字符串数据进行处理和模式匹配,比如提取特定信息或过滤数据行。这里涉及到字符串操作和正则表达式的应用。

- **字符串分割与索引**: 快速定位和分割字符串,有助于高效处理文本数据。

- **正则表达式**: 对于复杂的文本匹配和提取,正则表达式提供了强大的功能。Python 的 `re` 模块是处理正则表达式的利器。

以下是使用Python正则表达式进行模式匹配的示例:

```python

import re

def extract_pattern(file_path, pattern):

"""从文件中提取符合正则表达式的字符串"""

regex = re.compile(pattern)

with open(file_path, 'r') as file:

for line in file:

match = regex.search(line)

if match:

yield match.group(0)

# 使用示例

for extracted in extract_pattern('log_file.log', r'ERROR.*'):

print(extracted)

```

## 2.2 文件写入的最佳实践

### 2.2.1 缓冲区管理与性能优化

文件写入操作中,合理使用缓冲区可以提升性能。缓冲区可以暂时存储数据,减少磁盘I/O操作次数,当缓冲区满时,数据才被写入磁盘。

- **缓冲大小的配置**: 根据数据量和磁盘I/O性能合理配置缓冲区大小。

- **批量写入**: 对于大量数据写入,应尽量采用批量写入方式,以减少文件系统元数据操作的开销。

以下是如何在Python中使用缓冲区进行文件写入的示例代码:

```python

buffer_size = 1024 # 设定缓冲区大小

buffer = []

def write_large_data(file_path, data):

"""将数据分批写入文件,使用缓冲区减少I/O操作"""

buffer.append(data)

if len(buffer) >= buffer_size:

with open(file_path, 'a') as file:

file.writelines(buffer)

buffer = []

# 使用示例

for chunk in generate_large_data():

write_large_data('output.log', chunk)

# 记得最后清空缓冲区

if buffer:

with open(file_path, 'a') as file:

file.writelines(buffer)

```

### 2.2.2 定制化输出格式与日志记录

在文件写入时,为了后续处理或日志记录的方便,可以考虑定制化输出格式,比如JSON格式、CSV格式等。同时,合理的日志记录也是必不可少的。

- **格式化输出**: 对输出数据进行格式化,可以使用模板引擎或直接进行字符串拼接。

- **日志级别和记录**: 根据需要设置不同级别的日志记录,以及记录详细的信息,如时间戳、进程ID、用户信息等。

以下是如何在Python中将数据格式化为JSON并写入文件的示例代码:

```python

import json

def write_json_data(file_path, data_list):

"""将数据列表格式化为JSON格式并写入文件"""

with open(file_path, 'w') as json_file:

for data in data_list:

json.dump(data, json_file)

json_file.write('\n') # 每个JSON对象占一行

# 使用示例

data_points = [{'value': 123}, {'value': 456}]

write_json_data('data_log.json', data_points)

```

## 2.3 错误处理与异常管理

### 2.3.1 异常情况的检测与诊断

在文件操作中,经常会遇到各种异常情况,比如文件不存在、读写权限问题、磁盘空间不足等。对这些异常进行有效的检测和诊断是保证程序稳定运行的关键。

- **异常捕获**: 在代码中使用try-except块来捕获异常,避免程序因异常而崩溃。

- **日志记录**: 异常发生时,记录详细的错误信息到日志文件中,有助于问题的后续分析和定位。

示例代码块展示异常捕获和日志记录:

```python

import logging

def safe_file_operation(file_path):

"""安全的文件操作,异常处理和日志记录"""

try:

with open(file_path, 'r') as file:

content = file.read()

except FileNotFoundError:

logging.error('文件未找到: %s', file_path)

except PermissionError:

logging.error('无权访问文件: %s', file_path)

except Exception as e:

logging.error('文件操作错误: %s', str(e))

else:

logging.info('文件读取成功: %s', file_path)

return content

# 使用示例

content = safe_file_operation('some_file.txt')

```

### 2.3.2 文件操作错误的应对策

0

0