日志分析实战:深入挖掘Rose MirrorHA操作日志的技巧与秘诀

发布时间: 2024-12-14 07:45:04 阅读量: 9 订阅数: 13

ROSE mirror HA 双机热备软件

参考资源链接:[IBM X3650M3双机 Rose Mirror HA 配置详解与PostgreSQL数据库部署](https://wenku.csdn.net/doc/4ajga6zfku?spm=1055.2635.3001.10343)

# 1. 日志分析的重要性与基础

在信息技术领域,日志文件是记录系统运行状态、用户活动和错误信息的宝贵资源。正确地进行日志分析不仅可以帮助我们快速定位问题、优化系统性能,还可以为安全分析和业务决策提供重要依据。本章将从日志分析的基础知识入手,深入探讨其重要性,并为后续章节中关于Rose MirrorHA操作日志的详细讨论打下基础。

## 日志分析的重要性

日志分析的重要性体现在多个方面,例如:

- **故障诊断**:通过分析日志文件,我们能够迅速识别故障原因和影响范围,缩短系统恢复时间。

- **性能优化**:分析日志中反映的性能数据,帮助我们发现系统的瓶颈和优化点,提高系统效率。

- **安全审计**:日志是安全事件的痕迹,为安全事件的追溯和分析提供了重要信息。

## 日志分析的基础知识

日志分析的基础知识包括理解日志的结构、关键字段含义以及数据收集和整理的方法。一个典型的日志文件通常包含时间戳、日志级别、消息内容和相关元数据等信息。有效利用这些信息,需要我们掌握以下基础操作:

- **日志结构解析**:识别并理解日志中各个字段的作用。

- **日志收集与清洗**:使用日志收集工具,如rsyslog、fluentd等,配置日志收集策略,并对日志数据进行清洗和格式化。

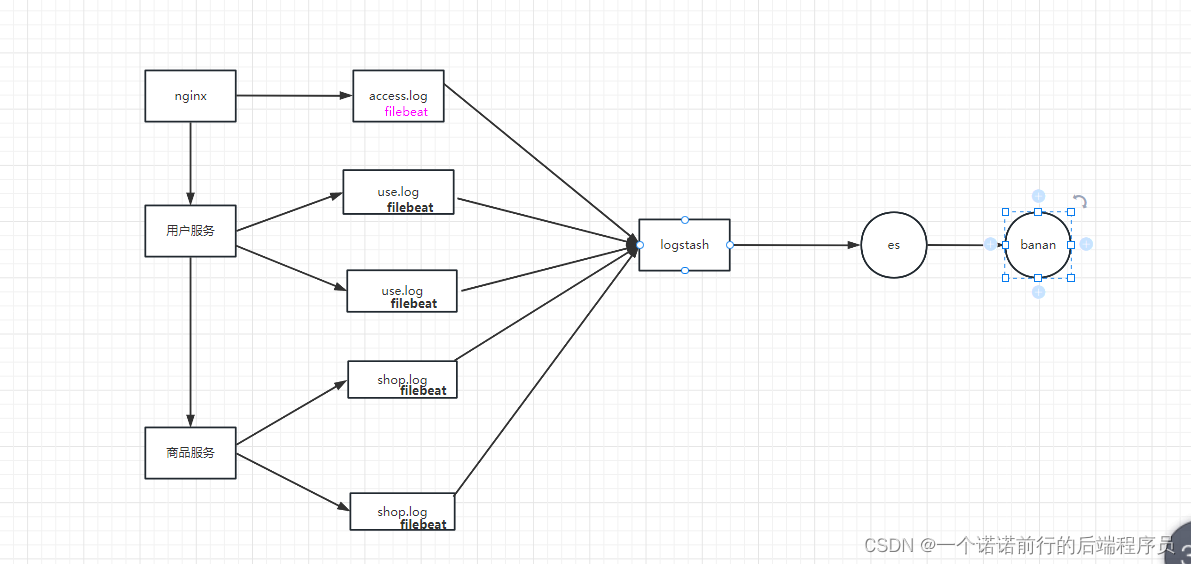

- **日志存储与检索**:采用合适的日志管理系统,如ELK Stack(Elasticsearch, Logstash, Kibana),以便于高效存储和快速检索日志信息。

通过上述内容的介绍,我们已经对日志分析的重要性有了初步认识,并打下了基础。随着文章的深入,我们将逐步掌握更为高级的日志分析技术和实战应用,特别是在处理Rose MirrorHA这类高可用性系统中的日志。

# 2. Rose MirrorHA操作日志概述

### 2.1 Rose MirrorHA简介

#### 2.1.1 Rose MirrorHA的定义和功能

Rose MirrorHA是一种用于高可用性环境下的数据同步和故障转移解决方案,旨在通过实时复制技术保证关键数据和应用服务的持续性。它广泛应用于数据库、文件系统以及应用程序的高可用性场景中。其核心功能包括:

- 数据同步:在主服务器和备份服务器之间,实时同步数据变更,保证数据的一致性。

- 故障检测与自动转移:实时监控主服务器运行状态,一旦检测到异常,可快速将服务切换到备份服务器。

- 手动故障转移:在进行维护或者升级等操作时,可手动将服务从主服务器切换到备份服务器。

- 多数据源支持:支持多种数据库和文件系统,可适应不同的应用场景。

- 灵活的部署策略:提供全量和增量同步选项,根据业务需求进行优化配置。

#### 2.1.2 Rose MirrorHA的应用场景

Rose MirrorHA在多种行业场景中发挥作用,主要应用包括:

- 金融行业:对于交易系统和支付系统的高可用性和数据一致性有极高的要求。

- 医疗卫生:保护病历数据和医疗记录,确保患者信息的连续性和准确性。

- 在线服务提供商:如电商平台、视频网站,保证用户服务不中断,提升用户体验。

- 政府和公共服务:用于重要信息系统,保障政府服务的连续性。

### 2.2 日志结构解析

#### 2.2.1 日志文件的组成和格式

日志文件是记录系统运行状态和事件的文件,通常包含时间戳、日志级别、消息内容等元素。Rose MirrorHA的日志文件格式遵循标准日志结构,一般由以下几部分组成:

- 时间戳:记录日志生成的具体时间。

- 日志级别:如INFO、WARN、ERROR等,表示日志的严重程度。

- 消息:详细的日志信息,包括事件描述、数据同步状态、故障转移状态等。

- 错误代码:当发生错误时,提供错误代码以便于问题的追踪和分析。

例如,一条典型的Rose MirrorHA日志可能如下所示:

```log

2023-04-01 12:05:43 [INFO] Data sync completed successfully between serverA and serverB.

```

#### 2.2.2 日志中关键字段的解读

对日志中的关键字段进行深入解读有助于更好地理解系统状态和进行问题诊断。以下是一些关键字段的解读:

- 时间戳:确定事件发生的具体时间,可以用来对比其他系统日志,进行事件关联分析。

- 日志级别:决定日志的紧急程度和处理优先级。例如,ERROR级别的日志需要立即关注。

- 消息内容:详细描述了某个事件的上下文信息。通过分析消息内容,可以确定故障转移是否成功,数据同步是否出现异常等。

### 2.3 日志数据的收集与整理

#### 2.3.1 日志收集工具的选择与配置

为确保日志的有效收集和分析,选择合适的日志收集工具至关重要。常见的日志收集工具有ELK Stack(Elasticsearch、Logstash、Kibana)、Fluentd和Logz.io等。以下是使用ELK Stack作为日志收集系统的配置步骤:

- **安装和配置Elasticsearch**:作为日志存储和搜索的后端。

- **配置Logstash**:作为数据收集引擎,负责收集、处理和转发日志数据。

- **搭建Kibana**:提供日志数据的可视化界面,便于实时监控和数据分析。

#### 2.3.2 日志清洗与格式标准化方法

收集到的日志数据常常包含杂乱无章的信息,需要进行清洗和标准化处理,以便于分析。日志清洗通常包含以下步骤:

- 过滤掉不重要的日志信息。

- 格式化日志时间戳,统一时间格式。

- 删除重复的日志项。

- 提取关键信息字段,创建结构化的日志数据。

例如,可以使用Logstash对日志文件进行解析和格式化,以下是一个Logstash的配置示例:

```conf

input {

file {

path => "/var/log/roseha.log"

start_position => "beginning"

}

}

filter {

date {

match => ["timestamp", "yyyy-MM-dd HH:mm:ss"]

}

mutate {

remove_field => ["@version"]

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "roseha-%{+YYYY.MM.dd}"

}

}

```

以上配置将指定路径下的日志文件作为输入源,按照给定的时间格式解析日志时间戳,并将清洗后的日志数据存储到Elasticsearch中。

# 3. 日志分析技巧与实践

## 3.1 日志模式识别与提取

日志模式识别与提取是日志分析中的一项核心技能

0

0