Erdas非监督分类自动化流程:4大策略提升工作效率

发布时间: 2024-12-29 18:08:34 阅读量: 17 订阅数: 13

PCI ERDAS监督分类.doc

# 摘要

本文针对Erdas软件的非监督分类自动化策略进行了全面的探讨,从理论基础到实践应用,再到高级技巧与未来发展展望。文章首先介绍了非监督分类的基础知识及其与监督分类的区别,并概述了常见的非监督分类算法。随后,本文强调了自动化流程的必要性和优势,阐述了实现参数优化与标准化、算法选择与集成的理论框架。在实践部分,文章详细介绍了环境搭建、数据准备、参数优化实施以及算法集成的步骤和效果评估。案例分析部分通过土地覆盖分析和遥感图像分析的具体应用实例展示了自动化流程的实际效果。最后,本文展望了利用高级自动化技术和人工智能技术在遥感分类领域的应用前景,并对Erdas软件未来版本的可能发展方向进行了讨论。整体而言,本文为Erdas非监督分类的自动化实践提供了完整的理论与技术支持。

# 关键字

Erdas;非监督分类;自动化策略;参数优化;算法集成;人工智能

参考资源链接:[利用erdas的遥感图像非监督分类的操作步骤](https://wenku.csdn.net/doc/6412b60dbe7fbd1778d45576?spm=1055.2635.3001.10343)

# 1. Erdas非监督分类基础

## 1.1 非监督分类概述

非监督分类是遥感图像处理中的一项重要技术,它允许用户对图像中的不同像素或区域进行分组,而不依赖于预先标注的训练样本。与监督分类相比,非监督分类对于那些没有训练数据或训练数据难以获取的情况尤其有用。其目标是揭示出图像中自然存在的数据分布,使得相似的像素被归入同一类别。

## 1.2 非监督分类流程

非监督分类的基本步骤包括:

- 图像的预处理(比如去噪、对比度拉伸)

- 特征提取(例如灰度、纹理、形状)

- 应用分类算法(如K-means、ISODATA、模糊C均值算法)

- 分类结果的评估和后处理(比如去除小斑块、分类结果的可视化)

非监督分类的核心是分类算法的选择和参数的设定,因为这将直接影响到分类的质量和准确性。

在下一章中,我们将深入探讨非监督分类算法的理论基础,为自动化流程的实施打下坚实的基础。

# 2. ```

# 第二章:非监督分类自动化策略的理论基础

## 2.1 非监督分类算法概述

非监督分类算法是遥感图像处理中一种重要技术,它不同于监督分类算法,不依赖于预先标记的训练数据集。非监督分类的目的是在未标记的图像数据中自动发现自然分组或结构。

### 2.1.1 非监督分类与监督分类的区别

非监督分类和监督分类是遥感图像分类领域的两个主要方向。监督分类依赖于有标记的数据来训练模型,通过学习已知类别来对新的数据进行分类。而非监督分类无需预先标记的数据集,它通过数据本身特征来推断其可能的类别。

非监督分类的常用算法有:

- K-means聚类

- ISODATA聚类

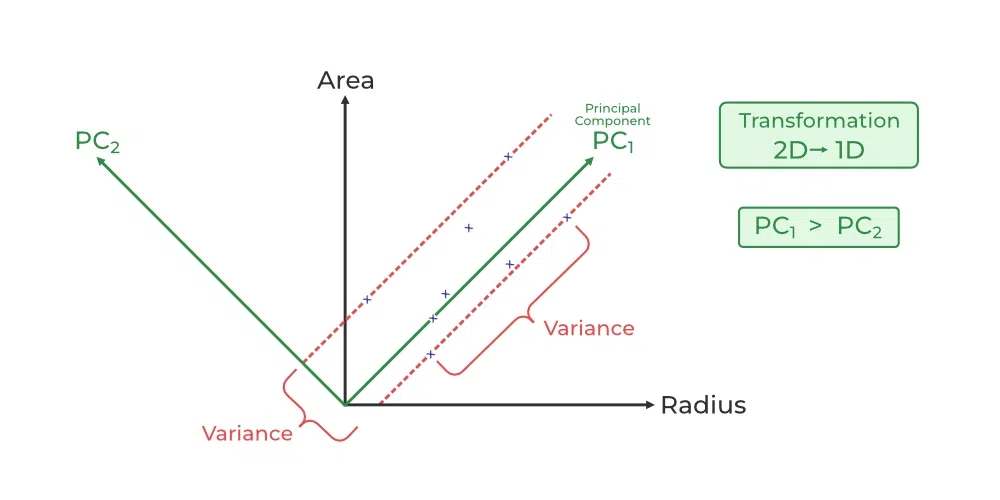

- 主成分分析(PCA)

- 独立成分分析(ICA)

### 2.1.2 常见非监督分类算法简介

在Erdas软件中,几种常用的非监督分类算法包括但不限于K-means聚类和ISODATA聚类。

- **K-means聚类**:以距离作为相似性度量,将数据分割成K个类别,旨在最小化类内的方差和类间的方差。

- **ISODATA聚类**:一种迭代自组织数据分析技术,它对聚类中心进行动态调整,直至满足特定收敛条件。

## 2.2 自动化流程的必要性与优势

### 2.2.1 手动分类流程的局限性

手动进行非监督分类需要大量的用户交互和决策,这不仅耗时而且主观性强,容易造成分类结果的不一致和不稳定。

### 2.2.2 自动化流程带来的效率提升

自动化流程可以在一定程度上降低人工干预,保证分类流程的一致性和效率。自动化的实现不仅减少了重复劳动,还提高了对大规模数据集处理的能力。

## 2.3 自动化策略的理论框架

### 2.3.1 策略一:参数优化与标准化

自动化的一个关键步骤是参数优化与标准化,这包括选择合适的初始参数,以及后续的调整以获得最佳分类结果。

### 2.3.2 策略二:算法选择与集成

在自动化流程中,选择合适的算法及考虑算法的集成是提升分类性能的重要策略。这涉及到对不同算法进行比较,选取最佳单一算法或者将多种算法的优点结合。

### 2.3.2.1 算法选择

在选择合适的分类算法时,需要考虑数据的特性,如数据维度、数据量、分布特性等。例如,对于高维数据,可能需要考虑降维方法来改善聚类效果。

### 2.3.2.2 算法集成

算法集成通常指使用多种分类器并结合它们的预测结果,常用的集成方法包括Bagging和Boosting。集成的目标是综合不同模型的优点,以获得比单一模型更好的分类性能。

### 2.3.2.3 集成效果评估

在集成多个算法之后,评估集成效果是至关重要的一步。常用的评估指标包括分类准确率、混淆矩阵、召回率等。通过这些指标可以综合评价分类的性能,指导进一步的优化。

### 2.3.2.4 优化集成方法

集成方法的优化是一个迭代过程,可能需要多次尝试和调整才能得到最优结果。在此过程中,可能需要对算法权重、投票策略或结合技术进行微调。

通过以上步骤,自动化策略理论框架可以为Erdas非监督分类提供一套系统的解决方案,以实现高效和准确的图像处理。

### 代码块展示及逻辑分析

下面给出一个K-means聚类算法的基础代码实现,这将帮助我们理解非监督分类算法在Python中的应用。此示例使用Python的`sklearn`库来演示如何实现K-means聚类。

```python

from sklearn.cluster import KMeans

import numpy as np

import matplotlib.pyplot as plt

# 生成随机数据

X = np.random.rand(100, 2)

# 创建KMeans实例

kmeans = KMeans(n_clusters=3)

# 应用模型

kmeans.fit(X)

# 打印聚类结果

print("Cluster centers:\n", kmeans.cluster_centers_)

# 预测新数据

new_samples = np.array([[0.1, 0.6], [1.1, 1.1]])

predictions = kmeans.predict(new_samples)

# 可视化结果

plt.scatter(X[:, 0], X[:, 1], c=kmeans.labels_, cmap='viridis')

plt.scatter(new_samples[:, 0], new_samples[:, 1], c=predictions, cmap='viridis', marker='*', s=200)

plt.show()

```

#### 参数解释

- `KMeans(n_clusters=3)`: 创建一个K-means聚类器实例,设置聚类中心数目为3。

- `.fit(X)`: 使用数据集X训练模型。

- `.predict(new_samples)`: 使用训练好的模型对新数据进行预测。

#### 逻辑分析

- **初始化**: 随机选择三个初始聚类中心。

- **分配**: 将每个样本点分配给最近的聚类中心。

- **更新**: 重新计算每个聚类的中心。

- **迭代**: 重复分配和更新步骤,直到聚类中心不再变化。

以上代码块和逻辑分析是理解如何在实际中应用非监督分类算法的关键。

```

这一

0

0