【Java Fork_Join框架终极指南】:精通并行编程,提升性能的10个秘诀

发布时间: 2024-10-21 09:56:46 阅读量: 49 订阅数: 23

# 1. Java Fork/Join框架的概述与原理

## Java并发编程的发展与Fork/Join的出现

Java并发编程历史悠久,随着多核处理器的普及,为充分利用多核并行计算能力,Fork/Join框架应运而生。该框架是Java 7及以上版本引入的,旨在简化多处理器并发编程的复杂性。Fork/Join框架的核心在于它可以将大任务拆分为小任务,并通过线程池中的工作线程来并行执行这些任务。

## Fork/Join框架的初步理解

Fork/Join框架通过递归地拆分任务来提升并发性能。它的两个主要操作是“fork”和“join”。简单地说,“fork”操作是指把一个大任务分割成多个小任务并行执行,而“join”操作则是等待这些小任务执行完毕并收集它们的结果。这种模式特别适合于可以分解为更小任务的场景。

## 框架背后的原理和设计哲学

Fork/Join框架的设计哲学是“分而治之”。为了高效地管理线程资源,该框架采用了工作窃取算法。在此算法下,如果一个工作线程完成了自己的任务队列中的任务,它可以去窃取其他线程任务队列中的任务来执行。这种设计不仅优化了CPU资源的使用,同时也减少了线程间竞争,提高了程序的并发性能。

```java

// 示例代码:使用Fork/Join框架

import java.util.concurrent.RecursiveTask;

import java.util.concurrent.ForkJoinPool;

class MyRecursiveTask extends RecursiveTask<Integer> {

private final int threshold = 10000;

private int start;

private int end;

public MyRecursiveTask(int start, int end) {

this.start = start;

this.end = end;

}

@Override

protected Integer compute() {

int sum = 0;

boolean canCompute = (end - start) <= threshold;

if (canCompute) {

for (int i = start; i <= end; i++) {

sum += i;

}

} else {

int middle = (start + end) / 2;

MyRecursiveTask leftTask = new MyRecursiveTask(start, middle);

MyRecursiveTask rightTask = new MyRecursiveTask(middle + 1, end);

leftTask.fork();

rightTask.fork();

sum = leftTask.join() + rightTask.join();

}

return sum;

}

}

public class ForkJoinExample {

public static void main(String[] args) {

ForkJoinPool forkJoinPool = new ForkJoinPool();

MyRecursiveTask task = new MyRecursiveTask(0, 100000);

int result = forkJoinPool.invoke(task);

System.out.println("Result: " + result);

}

}

```

以上代码展示了如何使用Fork/Join框架计算从0到100000的整数求和,通过递归拆分成更小的任务并最终合并结果。在第二章中,我们将深入探讨Fork/Join框架的内部机制和工作原理。

# 2. 深入理解Fork/Join框架的内部机制

### 2.1 Fork/Join框架的工作原理

Fork/Join框架是Java并发编程中一个强大的工具,它通过工作窃取算法来优化多处理器的利用,使得程序可以更加高效地执行。接下来,我们将深入探索Fork/Join框架的工作原理,以及它是如何通过任务分解、递归执行和工作窃取来实现并发处理的。

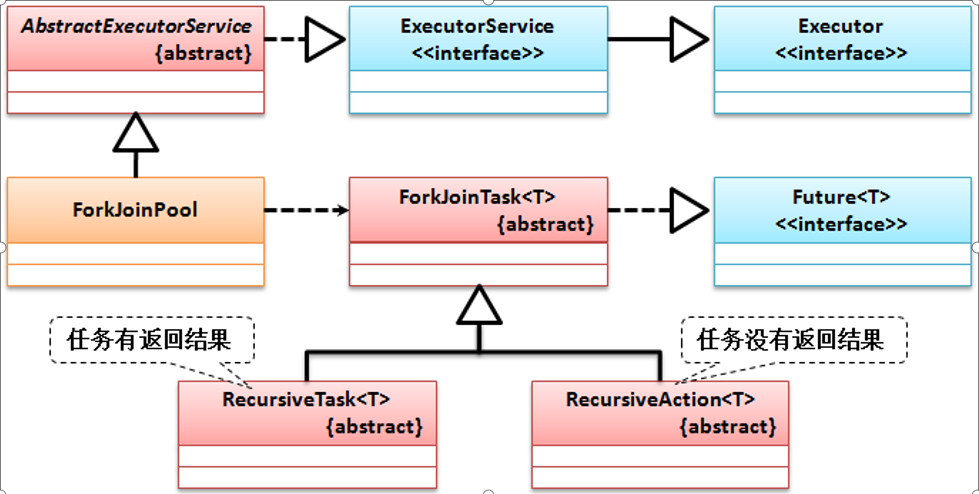

#### 2.1.1 任务分解与递归执行

Fork/Join框架中的任务通常通过递归的方式分解为更小的任务。这种分而治之的策略允许复杂问题逐步被解决。Java中的`RecursiveTask`和`RecursiveAction`是两种特殊的任务,它们可以被递归地执行。`RecursiveTask`有返回值,而`RecursiveAction`则没有。下面是任务分解与递归执行的一个简单例子:

```java

class MyTask extends RecursiveTask<Integer> {

private final int阈值 = 1000;

private final int[] 数组;

private final int 起始;

private final int 结束;

MyTask(int[] 数组, int 起始, int 结束) {

this.数组 = 数组;

this.起始 = 起始;

this.结束 = 结束;

}

@Override

protected Integer compute() {

if (结束 - 起始 < 阈值) {

// 计算局部结果

} else {

// 分解任务

int 中间 = (结束 + 起始) / 2;

MyTask 左 = new MyTask(数组, 起始, 中间);

MyTask 右 = new MyTask(数组, 中间 + 1, 结束);

// 执行任务

左.fork();

右.fork();

// 合并结果

return 左.join() + 右.join();

}

return 0;

}

}

```

在上述代码中,我们创建了一个可以递归分割的`MyTask`类,它继承自`RecursiveTask<Integer>`。当任务分解到指定阈值时,递归停止,开始执行实际的计算。然后,它会将任务分割成两个子任务,并通过`fork()`方法并发执行。最后通过`join()`方法获取并合并子任务的结果。

#### 2.1.2 工作窃取算法的实现

Fork/Join框架的核心之一是工作窃取算法。当一个工作线程完成了它的工作队列中的所有任务时,它并不空闲,而是会从其他工作线程的队列尾部窃取一个任务来执行。这种算法极大地提高了CPU的利用率,避免了线程空闲的问题。

工作窃取算法是如何工作的呢?简单来说,每个工作线程都有自己的双端队列(Deque),工作线程从队列的头部获取并执行任务,当队列为空时,它会从另一个线程的队列尾部窃取任务。每个任务都是一次性从队列中取走,保证了窃取线程能够顺利执行而不会与原队列线程冲突。

为了更好地理解工作窃取的过程,我们来看一个简化的mermaid流程图:

```mermaid

flowchart TD

A[工作线程A的队列] -->|窃取| B[工作线程B的队列]

B -->|任务已执行完毕| C[工作线程B空闲]

C -->|窃取| A

A -->|任务未完成| D[工作线程A继续工作]

D -->|继续| A

```

通过上面的流程图,我们可以看到工作线程A和B如何相互窃取任务来保证CPU的高效利用。

### 2.2 Fork/Join线程池的管理

Fork/Join框架通过专门的线程池来管理并发任务,这使得它能够控制任务执行的方式和效率。接下来我们将详细讨论线程池的创建、配置以及工作队列和任务调度的具体实现。

#### 2.2.1 Fork/Join线程池的创建与配置

Java中的Fork/Join线程池通过`ForkJoinPool`类实现,它提供了多种构造器来配置线程池。下面的代码展示了如何创建一个默认配置的Fork/Join线程池:

```java

ForkJoinPool forkJoinPool = new ForkJoinPool();

```

在创建`ForkJoinPool`实例时,可以指定一个参数来设定线程池的并行度,即同时运行的线程数。并行度是根据当前机器的处理器数量来确定的,也可以根据实际情况进行调整。

```java

int 并行度 = Runtime.getRuntime().availableProcessors();

ForkJoinPool forkJoinPool = new ForkJoinPool(并行度);

```

并行度对性能的影响很大。如果并行度太小,将无法充分利用系统资源;如果并行度太大,可能会导致上下文切换的开销增加。

#### 2.2.2 线程池的工作队列与任务调度

Fork/Join线程池使用了一种特殊的双端队列(Deque)来存储任务,这种队列支持从两端插入和删除任务。工作线程会从队列的头部获取任务,而工作窃取则是从其他线程队列的尾部来窃取任务。这种方式允许线程池高效地管理任务,减少等待和竞争。

任务调度过程遵循以下规则:

- 当线程池中有空闲线程时,总是优先从队列头部取出任务进行执行。

- 如果工作线程没有任务可执行,它会选择其他线程的队列尾部进行任务窃取。

- 当所有工作线程都空闲时,如果还有未处理的任务,则会根据任务的优先级或其他规则,重新分配任务到各个队列中。

通过合理地配置线程池和任务调度机制,可以使得Fork/Join框架能够有效地执行大量的并行任务。

### 2.3 异常处理与任务管理

在并发编程中,异常处理是不可或缺的一部分。Fork/Join框架提供了一套机制来处理任务执行过程中可能出现的异常,并确保任务能够得到适当的处理。同时,框架也支持任务结果的获取与合并,使并发任务的执行更加可控。

#### 2.3.1 任务执行中的异常传播

Fork/Join框架中的任务在执行过程中如果抛出了异常,这些异常会被封装在`RuntimeException`或者`ExecutionException`中。通过调用`join()`方法,这些异常会被重新抛出,从而允许调用者适当地处理异常情况。这是通过以下机制实现的:

- 任务的执行结果通过异常来传递,当任务执行出现异常时,异常会被封装在`Future`的实现中。

- 当调用`join()`方法时,如果任务执行中出现异常,异常会被抛出。

- 异常类型通常是`ExecutionException`,它是`RuntimeException`的子类,可以通过`getCause()`方法获取实际的异常原因。

下面的代码演示了如何捕获和处理这些异常:

```java

MyTask task = new MyTask(数组, 0, 数组.length);

Future<Integer> future = forkJoinPool.submit(task);

try {

Integer 结果 = future.get(); // 这里可能会抛出ExecutionException

} catch (ExecutionException e) {

Throwable 原因 = e.getCause(); // 获取实际的异常原因

// 处理异常

} catch (InterruptedException e) {

// 当前线程被中断

}

```

#### 2.3.2 任务结果的获取与合并

在Fork/Join框架中,任务的执行结果通常需要在任务完成后合并。这种合并操作发生在任务递归执行完成后的返回路径上。每个子任务完成后,其结果会被其父任务收集,并进行相应的合并操作,最终得到整个任务的处理结果。

任务的合并逻辑是Fork/Join框架的一个关键特性,这使得它能够处理具有自然递归分解特性的算法。例如,在并行归并排序中,每个子任务会对子数组进行排序,然后父任务将这些子数组合并为最终的结果。

为了更好地理解任务结果的获取与合并,我们可以看看下面的表格,它总结了在并行归并排序中子任务和父任务的关系:

| 父任务 | 子任务A | 子任务B | 合并结果 |

|-------|----------|----------|----------|

| 排序整个数组 | 排序数组的前半部分 | 排序数组的后半部分 | 合并排序后的两部分 |

| ... | ... | ... | ... |

通过这种表格形式,我们可以清晰地看到任务分解与合并的过程,以及每个任务在处理过程中所扮演的角色。

# 3. Java Fork/Join框架的实践应用

深入掌握Fork/Join框架的原理之后,我们就可以通过具体的实践应用来发挥其强大的并发处理能力。本章将从算法实现、性能提升、并发问题处理三个方面探讨Fork/Join框架在实际编程中的应用。

## 面向并发的算法实现

Fork/Join框架为并发执行算法提供了便利,特别是在可以分解为更小任务的算法上,如分治算法。本节将通过分治算法和并行归并排序来演示如何在实践中应用Fork/Join框架。

### 分治算法案例分析

分治算法的核心思想是将一个难以直接解决的大问题分割成一些规模较小的相同问题,递归地解决这些子问题,然后合并其结果,以得到原问题的解。Fork/Join框架的递归执行和工作窃取算法正好能够支持这种模式。

```java

import java.util.concurrent.RecursiveTask;

public class CountTask extends RecursiveTask<Integer> {

private static final int THRESHOLD = 10000;

private int start;

private int end;

public CountTask(int start, int end) {

this.start = start;

this.end = end;

}

@Override

protected Integer compute() {

int sum = 0;

boolean canCompute = (end - start) < THRESHOLD;

if (canCompute) {

for (int i = start; i <= end; i++) {

sum += i;

}

} else {

int middle = (start + end) / 2;

CountTask leftTask = new CountTask(start, middle);

CountTask rightTask = new CountTask(middle + 1, end);

leftTask.fork();

rightTask.fork();

int leftResult = leftTask.join();

int rightResult = rightTask.join();

sum = leftResult + rightResult;

}

return sum;

}

}

```

在这段代码中,`CountTask`类扩展了`RecursiveTask<Integer>`,可以返回一个整数值。如果任务太大,就将其拆分为两个子任务并递归调用自身,否则直接进行计算。

### 归并排序的并行实现

归并排序是一种分治算法,排序过程可以自然地分解为多个子排序过程,然后将排序好的子数组合并。使用Fork/Join框架可以并行地执行这些子任务。

```java

import java.util.concurrent.RecursiveTask;

public class ParallelMergeSort extends RecursiveTask<int[]> {

private static final int THRESHOLD = 10000;

private int[] array;

private int start;

private int end;

public ParallelMergeSort(int[] array, int start, int end) {

this.array = array;

this.start = start;

this.end = end;

}

@Override

protected int[] compute() {

int length = end - start;

if (length <= THRESHOLD) {

sortSequentially(start, end);

return null;

}

int mid = (length >>> 1) + start;

ParallelMergeSort leftTask = new ParallelMergeSort(array, start, mid);

ParallelMergeSort rightTask = new ParallelMergeSort(array, mid, end);

invokeAll(leftTask, rightTask);

merge(array, start, mid, end);

return null;

}

private void sortSequentially(int start, int end) {

// Sequential sorting logic here

}

private void merge(int[] array, int start, int mid, int end) {

// Array merging logic here

}

}

```

此代码展示了如何利用Fork/Join框架实现一个并行的归并排序。其中`THRESHOLD`参数用于决定何时进行子任务拆分。如果任务小于这个阈值,则直接使用顺序排序。否则,将任务拆分为左右两部分,然后并行处理并合并结果。

## 提升性能的实战技巧

在使用Fork/Join框架时,合理调整任务粒度和优化线程池大小是提升性能的关键。本节将讨论如何通过调整这些参数来优化程序性能。

### 任务粒度的调整策略

任务粒度指的是任务被分割的大小。理想的任务粒度能够保证每个任务的执行时间大致相同,并且每个任务都能够充分利用多核处理器的优势。

| 粒度大小 | 描述 | 影响效率因素 |

|----------|------------------------------|---------------|

| 太大 | 任务数量少,负载不均衡 | 资源浪费 |

| 适中 | 达到并行效率最大化 | 资源优化 |

| 太小 | 过多的上下文切换和任务调度 | 性能下降 |

为了避免资源浪费或性能下降,建议进行性能测试,找到最优的任务粒度。粒度过大或过小都会导致程序效率降低。

### 线程池大小的优化方法

Fork/Join框架的线程池通过`ForkJoinPool`类实现。线程池大小对性能有着显著影响。线程池太大可能会导致竞争激烈,太小则无法充分利用多核优势。

| 线程池大小 | 描述 | 影响效率因素 |

|------------|------------------------------------|---------------|

| 太大 | 线程间竞争激烈,上下文切换频繁 | 性能降低 |

| 适中 | 线程数量与CPU核心数匹配,高并发执行 | 效率最优化 |

| 太小 | CPU资源浪费,无法充分利用多核优势 | 性能限制 |

线程池大小的设定可以通过公式:`线程数 = CPU核心数 × (1 + 并发系数)`,其中并发系数通常取值在[1.5, 2.0]之间。通过监控工具进一步调整优化,是最终确定线程池大小的最佳实践。

## 处理并发中的常见问题

并发编程虽然可以显著提高程序性能,但也引入了诸如死锁、线程安全和数据一致性等问题。本节将探讨如何在使用Fork/Join框架时解决这些问题。

### 死锁的避免与检测

死锁是多线程环境中常见的问题,当两个或多个线程互相等待对方释放资源时就会发生死锁。在Fork/Join框架中,由于工作窃取的特性,死锁的发生概率相对较低,但仍需注意。

```java

import java.util.concurrent.ForkJoinPool;

import java.util.concurrent.RecursiveTask;

public class DeadlockAvoidance {

public static void main(String[] args) {

ForkJoinPool forkJoinPool = new ForkJoinPool();

int[] array = new int[10000];

ParallelSort task = new ParallelSort(array, 0, array.length);

forkJoinPool.invoke(task);

}

}

class ParallelSort extends RecursiveTask<int[]> {

// ...

}

```

为了避免死锁,应当遵循以下原则:

- 确保所有任务最终都能被完成。

- 避免无限递归,合理设定任务阈值。

- 避免共享资源的互相等待。

### 线程安全与数据一致性问题

线程安全是指多个线程访问同一资源时,资源状态的一致性。Fork/Join框架中,线程安全问题主要出现在任务间的共享变量和状态管理上。

| 线程安全策略 | 描述 |

|--------------|------------------------------------------------------|

| 不可变对象 | 使用不可变对象来避免并发修改问题 |

| 同步机制 | 使用synchronized关键字或显式锁来同步代码块 |

| 线程局部变量 | 使用ThreadLocal类为每个线程提供独立变量的副本 |

| 原子操作 | 使用原子类如AtomicInteger来保证操作的原子性 |

| 并发集合 | 使用ConcurrentHashMap等线程安全集合来管理共享数据集合 |

通过上述策略,可以有效解决Fork/Join框架中遇到的线程安全和数据一致性问题。

在下一章节,我们将深入探讨Fork/Join框架的高级特性与扩展,包括自定义任务的分割与合并逻辑,以及如何与其他并发工具集成。这将为读者提供更全面的技术视角和更丰富的实战经验。

# 4. Fork/Join框架的高级特性与扩展

## 4.1 自定义Fork/Join任务

### 4.1.1 继承RecursiveTask和RecursiveAction

在Java中,Fork/Join框架提供了两种抽象类,用于定义可以并行执行的任务:RecursiveTask和RecursiveAction。RecursiveTask用于返回结果的任务,而RecursiveAction用于不返回结果的任务。自定义任务通常需要继承这两个类,并实现其`compute`方法。

`RecursiveTask`需要返回一个结果,这通常是一个继承自`RecursiveTask<V>`的类,其中`V`是结果的类型。以下是一个简单的例子,展示了如何使用`RecursiveTask`来计算一个数值数组中所有元素的总和。

```java

import java.util.concurrent.RecursiveTask;

public class SumTask extends RecursiveTask<Integer> {

private final int[] numbers;

private final int start;

private final int end;

public SumTask(int[] numbers, int start, int end) {

this.numbers = numbers;

this.start = start;

this.end = end;

}

@Override

protected Integer compute() {

if (end - start <= 10) {

// 基本情况:任务足够小,直接计算结果

int sum = 0;

for (int i = start; i < end; i++) {

sum += numbers[i];

}

return sum;

} else {

// 大任务分割为两个子任务

int mid = (start + end) / 2;

SumTask leftTask = new SumTask(numbers, start, mid);

SumTask rightTask = new SumTask(numbers, mid, end);

leftTask.fork(); // 在线程池中异步执行左侧任务

int rightResult = ***pute(); // 同步执行右侧任务

int leftResult = leftTask.join(); // 等待左侧任务完成,并获取结果

return leftResult + rightResult; // 合并结果

}

}

}

```

### 4.1.2 实现自定义任务的分割与合并逻辑

在上面的例子中,`compute`方法的逻辑展示了任务的分割与合并。如果任务足够小(这里设置为小于等于10个元素),则直接计算结果。否则,任务被递归地分割为两个子任务,并使用`fork`方法将其中一个任务提交到线程池异步执行,同时使用`compute`方法同步执行另一个子任务。完成后,使用`join`方法等待异步执行的子任务完成并获取结果,最后将两个子任务的结果相加合并。

自定义任务的关键在于找到合适的分割阈值,以及设计高效的合并逻辑。分割阈值需要根据实际问题的复杂度来确定,太小可能导致任务分割的开销过高,太大则可能不足以充分利用多核处理器的优势。

## 4.2 Fork/Join框架与其他并发工具的集成

### 4.2.1 与CompletableFuture的结合使用

`CompletableFuture`是Java 8引入的一个强大的并发工具,它提供了对异步计算的全面支持。它可以和Fork/Join框架一起使用,以提供更加灵活的并发解决方案。`CompletableFuture`提供了许多便捷的方法来构建异步操作,它们可以通过`fork`方法与Fork/Join线程池集成。

以下是一个结合使用`CompletableFuture`和Fork/Join框架的简单例子,它展示了如何异步计算两个数值的和。

```***

***pletableFuture;

import java.util.concurrent.RecursiveTask;

public class CompletableFutureWithForkJoin {

public static int sum(int[] numbers, int start, int end) {

return CompletableFuture.supplyAsync(() -> {

if (end - start <= 10) {

int sum = 0;

for (int i = start; i < end; i++) {

sum += numbers[i];

}

return sum;

} else {

int mid = (start + end) / 2;

SumTask leftTask = new SumTask(numbers, start, mid);

SumTask rightTask = new SumTask(numbers, mid, end);

leftTask.fork();

int rightResult = ***pute();

int leftResult = leftTask.join();

return leftResult + rightResult;

}

}).join(); // 等待CompletableFuture完成并获取结果

}

}

```

### 4.2.2 与Stream API的协同工作

Java 8引入的Stream API是处理集合的强大工具,它提供了声明式的API来进行集合操作。Stream API可以与Fork/Join框架协同工作,特别是当使用并行流时,底层会使用Fork/Join线程池来执行并行操作。

以下是使用Stream API与Fork/Join框架协同工作的示例,这个例子计算了一个数值数组中所有元素的总和:

```java

import java.util.Arrays;

import java.util.stream.IntStream;

public class StreamWithForkJoin {

public static int sum(int[] numbers) {

return Arrays.stream(numbers).parallel().reduce(0, Integer::sum);

}

}

```

在这个例子中,`parallel()`方法指示Stream API使用并行处理,底层实现正是利用了Fork/Join框架。`reduce`方法将并行流中的所有元素合并成一个单一结果。

## 4.3 性能调优与监控

### 4.3.1 深入分析Fork/Join框架的性能瓶颈

在使用Fork/Join框架时,性能瓶颈可能会在多个层面出现。首先,任务的分割策略至关重要。如果任务分割得不够细,那么并行的收益可能就不明显;反之,如果任务分割得太细,那么任务创建和上下文切换的开销可能会超过并行执行带来的好处。

其次,线程池的大小也是一个重要的考量因素。线程池太大可能会导致资源竞争和上下文切换的开销;太小则无法充分利用多核CPU的优势。可以通过实验来找到最佳的线程池大小。

### 4.3.2 监控工具的使用与性能报告

监控Fork/Join框架的执行状况和性能指标,通常可以使用JVM自带的监控工具,如jvisualvm或jconsole。这些工具提供了丰富的监控界面和数据图表,可以帮助开发者深入理解Fork/Join线程池的性能表现。

此外,还可以编写特定的代码片段来监控任务的执行时间、线程池的状态、任务等待时间等关键指标。这些数据可以帮助开发者识别性能瓶颈,优化应用。

```java

import java.util.concurrent.ForkJoinPool;

import java.util.concurrent.RecursiveTask;

import java.util.concurrent.TimeUnit;

public class ForkJoinPoolMonitor extends ForkJoinPool {

public ForkJoinPoolMonitor(int parallelism) {

super(parallelism);

}

@Override

protected void beforeExecute(ForkJoinWorkerThread w, RecursiveTask<?> task) {

super.beforeExecute(w, task);

// 在任务执行前记录时间

}

@Override

protected void afterExecute(RecursiveTask<?> task, Throwable t) {

super.afterExecute(task, t);

// 在任务执行后记录时间,并计算执行时长

}

public static void main(String[] args) throws InterruptedException {

ForkJoinPoolMonitor pool = new ForkJoinPoolMonitor(Runtime.getRuntime().availableProcessors());

SumTask task = new SumTask(numbers, 0, numbers.length);

pool.execute(task);

pool.awaitQuiescence(1, TimeUnit.MINUTES); // 等待所有任务完成或超时

// 这里可以添加代码输出性能报告

}

}

```

通过上述代码,我们可以在ForkJoinPool的基础上扩展监控功能,记录任务的执行前后时间,并计算出每个任务的执行时间。这可以帮助开发者评估任务分解和线程池配置的效果,并进一步优化。

请注意,示例中的代码可能需要进一步调整以适应具体的应用场景,并确保它们能够正确地运行。在实际应用中,应根据实际需求来调整任务粒度、线程池的参数等,以达到最佳性能。

# 5. Fork/Join框架在现代应用中的应用案例

## 5.1 大数据处理场景下的应用

### 5.1.1 分布式文件系统中的数据处理

在处理大规模数据时,分布式文件系统如Hadoop的HDFS经常是首选。Fork/Join框架可以和分布式文件系统结合使用,以提高数据处理的效率。在HDFS这样的系统中,数据被分割成多个块(block)存储在不同的节点上。我们可以使用Fork/Join框架来并行处理这些块,加速整个数据处理流程。

下面是一个简化的案例,演示了如何结合Fork/Join框架和分布式文件系统来处理存储在HDFS上的大量文本数据:

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.io.IOException;

public class WordCount {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

String[] words = value.toString().split("\\s+");

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(TokenizerMapper.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

```

在此代码中,`TokenizerMapper`类是一个自定义的Mapper类,它将输入的文本分割为单词,并为每个单词生成键值对。在Mapper类中,我们没有使用Fork/Join,但在实际应用中,可以根据数据量和节点数来考虑在Mapper阶段实现Fork/Join模式以进一步优化性能。

### 5.1.2 实时数据流的并行分析

在实时数据流处理场景中,如使用Apache Kafka收集的日志数据或社交媒体数据,需要快速且有效地分析这些流数据,以便实时作出响应或进行监控。Fork/Join框架可以将实时数据流的任务分解并分配到多个线程,以实现并行处理。

以Apache Kafka为数据源,结合Fork/Join框架进行数据流分析的高层次流程如下:

1. 数据从Kafka主题中消费出来。

2. 使用Fork/Join框架将消费的数据进行并行处理。

3. 分析结果被汇总并输出,以便进一步处理或存储。

这里是一个假设性的代码段,演示如何将Fork/Join应用到实时数据流分析中:

```java

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.KafkaConsumer;

***mon.serialization.StringDeserializer;

import java.time.Duration;

import java.util.Arrays;

import java.util.Properties;

import java.util.concurrent.RecursiveTask;

public class KafkaForkJoinExample {

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "test");

props.put("key.deserializer", StringDeserializer.class.getName());

props.put("value.deserializer", StringDeserializer.class.getName());

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList("test-topic"));

ForkJoinPool forkJoinPool = new ForkJoinPool(Runtime.getRuntime().availableProcessors());

while (true) {

forkJoinPool.submit(new KafkaConsumerTask(consumer));

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

static class KafkaConsumerTask extends RecursiveTask<Integer> {

private KafkaConsumer<String, String> consumer;

public KafkaConsumerTask(KafkaConsumer<String, String> consumer) {

this.consumer = consumer;

}

@Override

protected Integer compute() {

// 模拟处理逻辑

consumer.poll(Duration.ofMillis(1000));

return 1;

}

}

}

```

在这个示例中,我们创建了一个`KafkaConsumerTask`类,它继承自`RecursiveTask<Integer>`,表示它返回一个结果。通过提交到`ForkJoinPool`,我们能够并行地处理从Kafka中消费的数据。

## 5.2 高性能计算任务的实践

### 5.2.1 科学计算中的并行算法实现

在科学计算领域,经常需要处理大型矩阵、进行复杂模拟或解决偏微分方程。这些任务往往具有高度的计算密集型,适合使用Fork/Join框架进行优化。通过并行化,我们可以将这些任务划分为更小的部分,然后并行地执行,显著缩短整体执行时间。

一个并行科学计算的典型例子是对大型矩阵进行并行乘法。下面是一个简化的示例,展示了如何对两个大型矩阵进行并行乘法:

```java

import java.util.concurrent.RecursiveTask;

public class MatrixMultiplicationTask extends RecursiveTask<Double[][]> {

private final double[][] matrixA;

private final double[][] matrixB;

private final int startRow;

private final int endRow;

private final int columnB;

public MatrixMultiplicationTask(double[][] matrixA, double[][] matrixB, int startRow, int endRow, int columnB) {

this.matrixA = matrixA;

this.matrixB = matrixB;

this.startRow = startRow;

this.endRow = endRow;

this.columnB = columnB;

}

@Override

protected Double[][] compute() {

if (endRow - startRow <= 100) { // 叶子任务的阈值

return multiplyMatrix Portions(matrixA, matrixB, startRow, endRow, columnB);

}

// 分割任务并创建子任务

int middle = (startRow + endRow) / 2;

MatrixMultiplicationTask task1 = new MatrixMultiplicationTask(matrixA, matrixB, startRow, middle, columnB);

MatrixMultiplicationTask task2 = new MatrixMultiplicationTask(matrixA, matrixB, middle, endRow, columnB);

// 启动子任务

task1.fork();

task2.fork();

// 等待子任务完成并合并结果

return combineResults(task1.join(), task2.join());

}

// 实现矩阵乘法并返回结果矩阵

private Double[][] multiplyMatrix Portions(double[][] matrixA, double[][] matrixB, int startRow, int endRow, int columnB) {

// ...

}

// 合并两个结果矩阵的子集

private Double[][] combineResults(Double[][] result1, Double[][] result2) {

// ...

}

}

```

在此代码中,`MatrixMultiplicationTask`扩展了`RecursiveTask`,它计算了两个矩阵片段的乘积。如果子任务足够小(例如,矩阵的行数少于100),它将直接执行乘法;否则,它将任务拆分为更小的部分,并使用`fork()`和`join()`方法来并行执行。

### 5.2.2 高并发网络服务中的任务调度

现代的网络服务,特别是API服务和微服务架构,面临着大量的并发请求。使用Fork/Join框架可以优化请求的调度和处理,确保即使在高负载下也能高效地处理任务。

考虑一个简化的案例,其中网络服务需要处理多个独立的用户请求,每个请求都可以并行处理。使用Fork/Join框架,我们可以创建一个任务池来管理和调度这些请求:

```java

import java.util.concurrent.RecursiveTask;

import java.util.concurrent.ForkJoinPool;

public class RequestProcessingTask extends RecursiveTask<RequestResult> {

private final UserRequest request;

public RequestProcessingTask(UserRequest request) {

this.request = request;

}

@Override

protected RequestResult compute() {

// 模拟请求处理逻辑

return new RequestResult("处理结果");

}

}

class UserRequest {

// 用户请求的参数和方法

}

class RequestResult {

// 请求处理的结果

public RequestResult(String result) {

// ...

}

}

public class ServerApp {

public static void main(String[] args) {

ForkJoinPool forkJoinPool = new ForkJoinPool(Runtime.getRuntime().availableProcessors());

UserRequest[] requests = getUserRequests(); // 获取用户请求数组

for (UserRequest request : requests) {

forkJoinPool.submit(new RequestProcessingTask(request));

}

forkJoinPool.shutdown();

}

}

```

在`ServerApp`中,我们创建了一个`ForkJoinPool`实例,并向其提交了多个`RequestProcessingTask`实例。每个任务代表对一个用户请求的处理。通过这种方式,网络服务可以并行处理多个请求,提高整体的吞吐量和响应速度。

这些现代应用案例展示了Fork/Join框架在大数据处理和高性能计算任务中的实际应用和优势。通过并行化任务,我们可以高效地利用系统资源,缩短处理时间,从而满足现代应用对高性能的需求。

0

0