操作系统同步机制:实验报告中的智慧解析与算法应用

发布时间: 2024-12-21 14:57:15 阅读量: 5 订阅数: 6

# 摘要

本文对操作系统同步机制进行了全面的概述和分析,详细阐述了同步机制的理论基础,包括临界区问题、同步机制分类、互斥锁与信号量、条件变量与事件控制等关键概念。通过构建实验环境,本文进一步研究了同步机制在实际操作中的应用,并对实验结果进行了深入分析。文章还探讨了同步算法的角色、选取标准和实现,并提出了同步算法的优化策略。最后,基于实验结论,本文总结了同步机制的有效性,并对同步机制的未来研究方向进行了展望,特别是新型同步机制的探索和在新兴领域中的应用潜力。

# 关键字

操作系统;同步机制;理论基础;互斥锁;信号量;同步算法

参考资源链接:[吉林大学计算机专业操作系统实验报告](https://wenku.csdn.net/doc/6412b5cebe7fbd1778d44777?spm=1055.2635.3001.10343)

# 1. 操作系统同步机制概述

## 1.1 同步机制的定义与重要性

在多任务操作系统中,同步机制是确保多个执行单元能够协调一致地访问共享资源,避免数据不一致和竞态条件的关键技术。其重要性体现在能够维持系统的稳定性和公平性,保障任务执行的有序性和一致性。

## 1.2 同步与并发的关系

同步机制是并发编程中的核心概念之一,它规定了并发执行的任务如何协调彼此动作。没有适当的同步,任务间的相互作用可能导致数据的破坏或者程序的不可预测行为。因此,合理设计和实现同步机制对于提升软件质量至关重要。

## 1.3 同步机制的分类

同步机制按照实现方式可以分为硬件同步和软件同步两大类。硬件同步通常依赖于特定的硬件指令,如测试和置位指令(test-and-set)。软件同步则包含各种软件层面的算法,例如互斥锁、信号量、条件变量等。每种同步机制都有其特定的应用场景和优缺点,将在后续章节详细讨论。

# 2. 操作系统同步机制的理论基础

## 2.1 同步机制的理论模型

### 2.1.1 临界区问题和解决方案

在操作系统中,临界区问题是指多个进程或线程在并发执行时,需要访问共享资源,而这些共享资源的访问必须是互斥的。这被称为临界区(Critical Section)问题,以避免竞态条件(Race Condition)的发生。为了解决临界区问题,设计了一系列同步机制,以保证在任何时刻,只有一个进程能够进入临界区。

为了解决这一问题,可以采用Peterson算法、信号量、互斥锁(Mutex)等方法。Peterson算法是一种软件解决方案,适用于两个进程的互斥访问。信号量则通过一个计数器和一个等待队列来控制对共享资源的访问。互斥锁是广泛使用的一种硬件解决方案,它提供了锁的机制,保证了互斥性。

### 2.1.2 同步机制的分类和特点

同步机制可以分为几类,每类具有其特定的特点和使用场景:

- **互斥锁(Mutex)**:确保在任何时刻只有一个线程可以访问共享资源。它适用于简单的互斥同步需求。

- **读写锁(Read-Write Locks)**:允许多个读操作并行,但在写操作时会阻止新的读或写操作。适用于读多写少的场景。

- **信号量(Semaphore)**:可以用来实现互斥锁和读写锁,支持更复杂的同步需求。信号量允许多个进程进入临界区,直到信号量计数为零。

- **条件变量(Condition Variables)**:用于线程之间的协调,使得一个线程在某种条件未满足时进入等待状态,其他线程在条件满足后可以唤醒等待的线程。

- **事件控制(Event Control)**:可以用来控制线程的执行流程,使得一个线程在特定事件发生时继续执行。

## 2.2 互斥锁与信号量

### 2.2.1 互斥锁的概念与实现

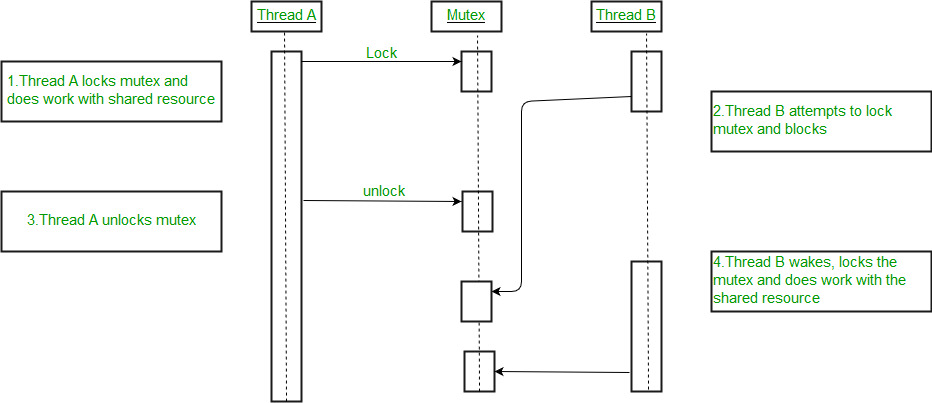

互斥锁是实现线程间互斥访问共享资源的简单机制。它提供了一种简单的加锁操作,当一个线程获取到锁后,其他试图获取锁的线程将被阻塞,直到锁被释放。

在实际实现中,互斥锁通常包含锁定和解锁两种操作。锁定操作会检查锁的状态,如果锁已经被占用,则线程将进入等待状态;如果锁是空闲的,则获取锁并进入临界区。解锁操作将释放锁,使得其他等待该锁的线程有机会获取它。

下面是一个使用互斥锁的伪代码示例:

```c

mutex_lock(&lock); // 尝试获取锁

// 临界区开始

// 执行需要互斥访问的代码

// 临界区结束

mutex_unlock(&lock); // 释放锁

```

在使用互斥锁时,必须确保每个锁定操作都有一个对应的解锁操作,以避免死锁的发生。

### 2.2.2 信号量的概念与应用

信号量是一种同步机制,它允许一定数量的进程或线程进入临界区。信号量通常用一个计数器来实现,当有进程或线程尝试进入临界区时,它会执行一个名为`wait`或`P`的操作,这个操作会减少信号量的值。如果信号量的值已经为零,则该进程或线程将会阻塞,直到信号量的值增加。

与互斥锁不同,信号量允许多个线程同时进入临界区,只要信号量的计数值允许。因此,信号量更灵活,适用于实现复杂同步场景。

信号量的`wait`操作通常与`signal`或`V`操作配对使用。`signal`操作会增加信号量的值,并且如果有进程或线程因该信号量被阻塞,它会被唤醒。

信号量的伪代码实现如下:

```c

sem_wait(&sem); // 尝试减少信号量的值

// 临界区开始

// 执行需要同步访问的代码

// 临界区结束

sem_post(&sem); // 增加信号量的值

```

## 2.3 条件变量与事件控制

### 2.3.1 条件变量的作用和工作原理

条件变量是线程同步机制的一部分,用于处理线程间复杂的协调问题,尤其是在生产者-消费者模式中。一个条件变量允许线程在某个条件不满足时挂起执行,直到其他线程改变了条件的状态并发出通知。

条件变量通常与互斥锁一起使用。一个线程在检查条件变量前,必须先获取相应的互斥锁。如果条件不满足,线程将释放锁并挂起等待条件变量的通知;当条件满足并收到通知时,线程被唤醒并重新尝试获取锁,如果成功,就可以执行临界区的代码。

条件变量的操作包括`wait`、`signal`和`broadcast`。`wait`操作会使线程等待条件变量;`signal`唤醒一个等待该条件变量的线程;`broadcast`唤醒所有等待的线程。

### 2.3.2 事件控制在同步中的应用

事件控制提供了一种机制,允许线程或进程在某个事件发生之前挂起。事件控制主要用于同步操作,它允许线程在等待一个特定条件成立时挂起执行,并在条件满足时继续执行。

事件控制操作一般包括设置事件(设置为通知状态)、清除事件(设置为未通知状态)、等待事件(等待直到事件被设置为通知状态)。事件可以被设置为手动或自动重置模式。

在实际应用中,事件控制可以用来实现生产者-消费者模型、线程间同步以及执行线程的同步等待。

接下来,我们将探讨操作系统同步机制的实验分析和算法应用,将理论应用到实践中去,并分析其性能表现。

# 3. 操作系统同步机制的实验分析

## 3.1 实验环境搭建

### 3.1.1 实验平台的选择与配置

在进行操作系统同步机制的实验分析之前,选择合适的实验平台至关重要。通常,我们可以选择虚拟机或者真实的物理机作为实验环境。例如,使用VirtualBox或VMware创建虚拟机,安装Linux操作系统,如Ubuntu Server,因为它对硬件要求相对较低,同时提供丰富的文档和社区支持,这将有助于解决实验中可能出现的问题。

为了更贴近真实环境,在硬件选择上应尽可能地模拟生产环境,保证实验的准确性和可迁移性。接下来是配置实验所需的软硬件环

0

0