【Java注解工具全景】:APT、Annotation Processing与Lombok深度解析

发布时间: 2024-10-19 00:25:16 阅读量: 42 订阅数: 27

探索Java注解的神秘世界:Annotation全解析

# 1. Java注解的基础概念与原理

## 1.1 注解简介

注解是Java语言中的一个强大特性,它提供了一种机制,允许开发者在不改变原有代码逻辑的前提下,在代码中加入额外的信息。这种信息可以通过编译器处理,或者在运行时被其他程序读取。注解的主要目的是减少样板代码(boilerplate code),提高开发效率,并且让代码更加简洁易读。

## 1.2 注解的分类

Java中的注解大致可以分为三类:

- **标记注解**:没有成员,仅用于标记,如@Override。

- **单值注解**:有一个成员,名字通常为value,如@Test(value="example")。

- **完整注解**:有一个或多个成员,成员必须有默认值,如@Author(name="Author Name", date="2021-01-01")。

## 1.3 注解的工作原理

注解不会直接影响代码的操作,它们在编译时或者运行时通过注解处理器(Annotation Processor)来执行某些操作。编译器在编译代码时可以检测到这些特殊的注解,并根据注解的类型和位置执行相应的处理逻辑。这种处理逻辑通常以插件的形式存在,称为注解处理工具(APT)。

通过深入理解Java注解的基础概念与原理,可以为后续学习APT和Annotation Processing打下坚实的基础,并在实际开发中更加高效地使用这些强大的特性。

# 2. APT(Annotation Processing Tool)的原理与应用

## 2.1 APT的基本原理

### 2.1.1 注解处理的生命周期

APT作为一种注解处理工具,它的处理时机是在编译期间。与Java反射机制不同,APT处理注解不需要在运行时消耗性能,因为所有的注解处理在源代码编译成字节码之前就已经完成了。APT的生命周期主要分为以下几个阶段:

1. **解析阶段**:APT在编译早期开始工作,主要负责扫描源代码中的注解,并进行解析。此阶段,注解处理器会接收项目中所有源代码文件的抽象语法树(AST)作为输入,从而确定哪些注解被用在了什么地方。

2. **处理阶段**:在解析注解后,注解处理器需要根据解析结果执行相应的代码生成或修改。例如,对于一个数据绑定注解,处理器可能会生成相应的方法和类,以简化数据访问操作。

3. **输出阶段**:处理器完成后,APT将编译后的类文件作为输出,传递给Java编译器进行进一步的编译处理。

### 2.1.2 APT中的重要类和接口

APT的实现依赖于几个关键的类和接口,理解这些是掌握APT原理的基础:

- `javax.annotation.processing.AbstractProcessor`:该类是所有注解处理器的抽象父类,开发者需要扩展这个类,并重写`process`方法来实现自己的注解逻辑。

- `javax.annotation.processing.RoundEnvironment`:它提供了一个环境,通过这个环境,注解处理器可以访问到编译时的上下文信息,如获取当前被处理的注解类型、源文件等。

- `javax.lang.model.element.Element`:代表源代码中的程序元素,如包、类、方法、字段等。通过这个接口,注解处理器可以与源代码进行交互。

- `javax.lang.model.type.TypeMirror`:表示源代码中的类型,与`Element`配合使用,可以提供类型检查、获取泛型参数等能力。

## 2.2 APT在实际开发中的应用

### 2.2.1 利用APT生成元数据和代码

在开发中,我们经常会遇到需要自动生成大量样板代码的场景,这时候使用APT可以大大简化开发流程。例如:

```java

@Retention(RetentionPolicy.CLASS)

@Target(ElementType.TYPE)

public @interface AutoService {

String value();

}

```

在上述例子中,`AutoService`注解可以用来标记一个服务接口,APT则可以用来生成对应的实现类,这样就可以减少手动编写实现类的工作。

### 2.2.2 APT与注解驱动开发案例

通过一个简单的用户验证场景,演示APT在注解驱动开发中的应用:

假设我们有一个注解`@Validate`用于方法上,表示该方法需要进行参数验证。

```java

@Retention(RetentionPolicy.CLASS)

@Target(ElementType.METHOD)

public @interface Validate {

// 注解定义,这里留空,仅作为标记使用

}

```

一个APT处理器可以扫描所有带有`@Validate`注解的方法,并在编译时期生成必要的验证代码,例如,如果某个方法参数需要非空验证:

```java

public void registerUser(@Validate String username, @Validate String password) {

// 方法实现...

}

```

APT处理后,自动生成以下验证逻辑:

```java

public void registerUser(String username, String password) {

if (username == null || username.isEmpty()) {

throw new IllegalArgumentException("Username must not be null or empty");

}

if (password == null || password.isEmpty()) {

throw new IllegalArgumentException("Password must not be null or empty");

}

// 实际方法实现...

}

```

## 2.3 APT工具与框架的比较

### 2.3.1 APT与反射的区别

虽然APT和反射都是处理注解的技术,但它们有本质的区别:

- **处理时机**:APT在编译期处理注解,反射则在运行时处理。

- **性能影响**:APT处理对性能无影响,而反射则因为运行时的额外操作影响性能。

- **使用场景**:APT适合生成元数据和代码,反射则适合在运行时动态操作对象。

### 2.3.2 APT与其他注解处理框架对比

目前,除了APT外,还存在其他注解处理框架,如Dagger、AutoValue等。它们各有优劣,下面通过一个表格,对APT和其他框架进行对比:

| 特性/框架 | APT | Dagger | AutoValue |

|------------|-----|--------|-----------|

| 编译时处理 | 是 | 是 | 是 |

| 运行时处理 | 否 | 是 | 否 |

| 代码生成 | 是 | 部分 | 是 |

| 自动化程度 | 低 | 高 | 中 |

| 使用复杂度 | 中 | 高 | 低 |

APT通常被看作是一个基础工具,开发者需要自行实现复杂的逻辑;而其他框架则在APT的基础上提供了更高级的抽象,简化了开发流程,但可能会牺牲一定的灵活性。

# 3. Annotation Processing的深入解析

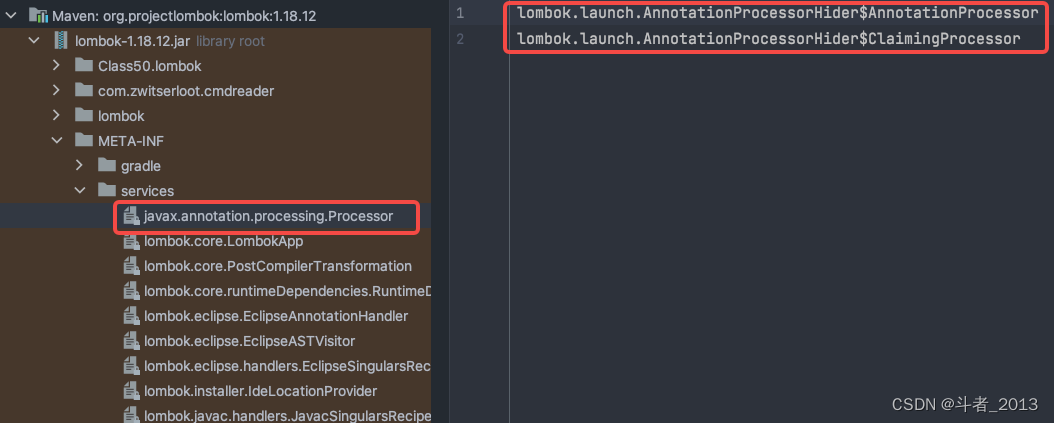

Annotation Processing是Java编译器的一个特性,它允许开发者在编译阶段插入自定义的代码生成逻辑。通过这个特性,开发者可以利用注解来生成源代码、资源文件和其他的元数据,这极大地增强了Java语言的灵活性和扩展性。本章节将深入解析Annotation Processing的基本原理,探讨其在实际项目中的应用,并分析其优势与局限性。

## 3.1 Annotation Processing的基本原理

### 3.1.1 注解处理的编译时特性

Annotat

0

0