Java接口限流与降级策略:打造健壮接口的6大技巧

发布时间: 2024-09-25 05:33:40 阅读量: 111 订阅数: 37

summo-springboot-interface-demo 优化接口设计接口限流策略JAVA代码

# 1. 接口限流与降级的必要性

在当代的分布式系统中,接口限流与降级已经成为保证系统高可用性和服务质量的关键技术手段。随着服务架构复杂性的增加,系统面临着突发流量或异常访问模式的挑战,这可能导致资源耗尽和整体性能下降,乃至崩溃。

接口限流的实施能够有效控制访问请求的速率,避免因并发量过大而造成的系统过载。通过策略性地拒绝部分请求或降低服务质量,限流不仅可以保护后端服务不被击垮,也有助于维持系统的稳定运行。

降级策略则是在系统面临故障或资源紧张的情况下,主动降低部分非核心功能的服务质量,甚至将部分服务临时关闭,以此来保障系统的整体性能和用户体验。合理的降级策略能够使系统更加健壮,具备自适应和自我保护的能力。

限流与降级是构建弹性架构不可或缺的组成部分,理解它们的必要性并合理运用到系统设计中,是每个IT从业者的职责所在。在接下来的章节中,我们将深入探讨限流和降级的理论基础、实现方式以及如何在实际应用中优化这些策略。

# 2. 限流策略的理论与实践

### 限流的基本原理和算法

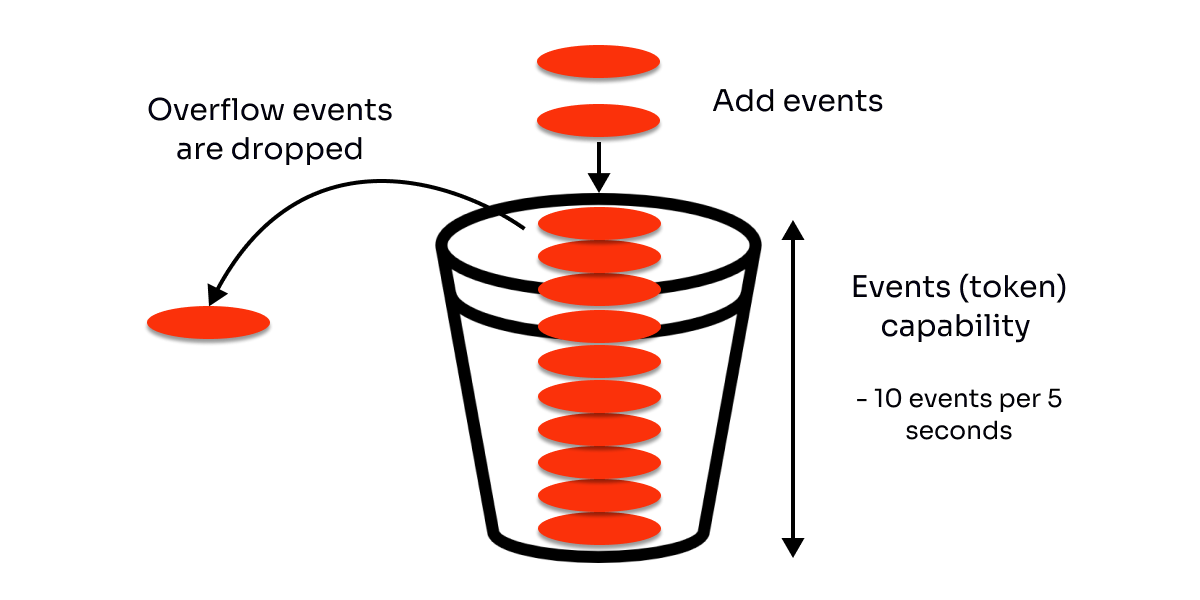

#### 令牌桶算法详解

令牌桶算法是一种广泛用于网络流量整形和速率限制的方法。该算法的核心思想是:系统以恒定的速率向桶中投放令牌,每个需要发送数据的请求必须先从桶中获取一个令牌,只有拿到令牌才能发送数据,从而达到限流的目的。

算法的工作流程可以用以下步骤描述:

1. 桶中始终有一定数量的令牌,代表系统允许的最大并发数。

2. 令牌按预设的速率(容量)被放入桶中。

3. 当一个请求到来时,首先检查桶中是否有令牌。

4. 如果桶中有令牌,请求可以拿走一个,并立即执行。

5. 如果桶中没有令牌,请求将被阻塞,直到有新的令牌被放入桶中。

代码块示例:

```python

import time

import threading

# 令牌桶的实现

class TokenBucket:

def __init__(self, rate):

self.rate = rate

self.capacity = rate * 2 # 可以设置桶的容量

self.tokens = self.capacity

self.lock = threading.Lock()

def consume(self, amount=1):

with self.lock:

now = time.time()

while self.tokens < amount:

if now > self.last_check + 1:

self.tokens += (now - self.last_check) * self.rate

self.last_check = now

else:

return False # 没有足够的令牌

self.tokens -= amount

return True

rate = 5 # 每秒5个令牌

bucket = TokenBucket(rate)

```

在上述代码中,令牌桶每秒生成令牌,存储在`tokens`变量中。`consume`方法用于消费令牌,如果请求到来时没有足够的令牌,请求将被拒绝。

#### 漏桶算法机制

漏桶算法则是另一种限流方法,它将所有的请求都放入一个漏桶中,漏桶以固定的速率处理请求,从而保证系统不会因为突发的流量压力而崩溃。

漏桶算法的工作原理:

1. 所有进入系统的请求首先进入一个"漏桶",桶的容量是有限的。

2. "漏桶"以固定的速率(即系统能够处理的极限速率)处理请求。

3. 当请求到达的速度超过处理速度时,过多的请求会在"漏桶"中排队。

4. 当队列满时,额外的请求将会被丢弃,保证了系统的稳定性。

漏桶算法适合于需要对流量进行平滑处理的场景,而令牌桶适合于有突发流量处理需求的场景。

### 限流策略的实现方式

#### 单机限流的实践

单机限流是在单个服务实例内部限制请求速率,实现方式可以基于内存中的计数器,也可以使用令牌桶或漏桶算法。对于单机限流,我们更关心的是如何在不依赖外部存储的情况下实现限流,并保证系统的健壮性。

代码示例:

```python

# 使用漏桶算法实现的单机限流器

class LeakyBucket:

def __init__(self, rate):

self.rate = rate

self.capacity = rate * 2

self.queue = []

self.last_watered = time.time()

def consume(self, amount=1):

with self.lock:

now = time.time()

self._water(now)

if len(self.queue) < self.capacity:

self.queue.append(amount)

return True

return False

def _water(self, now):

water = (now - self.last_watered) * self.rate

self.last_watered = now

while water > 0 and self.queue:

amount = self.queue.pop(0)

water -= amount

```

在上述代码中,我们使用一个队列来模拟漏桶,`consume`方法用于消费流量,如果队列满了,额外的请求将无法加入队列,从而实现了限流。

#### 分布式限流的应用场景

在分布式系统中,多个服务实例共同处理请求,限流策略需要能够在多个实例之间同步状态,以确保整个系统的限流效果。

常见的分布式限流工具包括Redis、ZooKeeper等,它们通过外部存储来维护令牌桶或漏桶的状态,以实现分布式限流。

以Redis为例,我们可以使用Redis的原子操作来维护令牌桶的状态。例如,使用`INCRBY`命令来增加令牌数量,使用`DECRBY`命令来消费令牌。

```python

# 使用Redis实现的分布式限流器

def acquire_token():

conn = redis.Redis(host='localhost', port=6379, db=0)

with conn.pipeline() as pipe:

while True:

# 检查令牌数量

if conn.get('tokens') < 1:

return False

# 尝试消费令牌

pipe.multi()

pipe.decrby('tokens', 1)

results = pipe.execute()

if results[0] >= 0:

return True

```

在上述代码中,我们使用了Redis的`DECRBY`命令来原子性地减少一个令牌的数量,以此来模拟请求的消费过程。

#### API网关限流的集成

API网关作为微服务架构中的重要组件,天然适合做限流处理。它位于请求入口,可以对所有进入的请求进行统一的管理。常用的API网关有Kong、Zuul等。

在API网关层集成限流,可以基于请求的来源IP、API路径、用户身份等信息来实现不同的限流策略。

例如,在使用Kong网关时,我们可以编写一个插件来实现基于用户的限流逻辑:

```lua

local Kong = kong

local令牌桶 = require("token_bucket")

local plugin = {

PRIORITY = 10,

VERSION = "1.0",

}

function plugin.access(plugin_conf)

local token_bucket = token_bucket.new({

rate = plugin_conf.rate,

capacity = plugin_conf.capacity,

})

if not token_bucket:consume() then

Kong.response.exit(429, {

message = "Too Many Requests",

})

end

end

return plugin

```

在上述Lua脚本中,我们创建了一个令牌桶实例,并在每次请求时消耗一个令牌。如果无法获得令牌,Kong网关将返回429错误,表示请求过多。

### 限流工具与框架对比分析

#### 常见限流工具比较

在限流工具的选择上,开发者可以根据具体的场景和技术栈来选择合适的工具。

| 工具名称 | 适用场景 | 优点 | 缺点 |

| --- | --- | --- | --- |

| Redis | 分布式限流 | 高可用、易扩展、丰富的数据类型支持 | 依赖外部存储,可能增加网络延迟 |

| Guava RateLimiter | 单机限流 | 实现简单,性能优秀 | 不支持分布式限流 |

| Hystrix | 微服务限流 | 支持自动降级、容错处理 | 难以实现精细的流量控制 |

#### 限流框架的实际应用案例

Hystrix是Netflix开发的一个用于处理分布式系统的延迟和容错的开源框架,它提供了限流、降级、熔断等多种容错功能。

案例分析:

假设我们有一个电商系统的订单服务,使用Hystrix来实现限流和降级:

```java

// 使用Hystrix实现的限流降级逻辑

public class OrderService {

@HystrixCommand(

```

0

0