【数据科学必修课】:线性代数在PCA中的核心作用

发布时间: 2024-12-15 20:07:59 阅读量: 7 订阅数: 16

参考资源链接:[斯特朗线性代数第五版习题答案详解](https://wenku.csdn.net/doc/6412b4c6be7fbd1778d40c85?spm=1055.2635.3001.10343)

# 1. 数据科学中的线性代数基础

在数据科学的众多工具箱中,线性代数是构建和实现复杂算法的基础。本章将带领读者回顾和巩固线性代数的基本概念和定理,为理解后续章节中的PCA(主成分分析)奠定坚实的理论基础。

## 1.1 线性代数基础回顾

线性代数涉及向量、矩阵及其在向量空间中的操作。我们将从向量开始,逐步探讨矩阵运算,包括矩阵乘法、逆矩阵和行列式等。理解这些基础是至关重要的,因为它们在数据变换和特征提取中扮演着关键角色。

```plaintext

例如,向量可以被看作是数据点在多维空间中的表示,而矩阵乘法则可以看作是多个数据点进行线性变换的方法。

```

## 1.2 向量空间与基的概念

向量空间是由向量构成的集合,其中包含了加法和数乘这两种操作。基是一组线性无关的向量,它们可以生成整个向量空间。理解基的概念有助于我们理解数据点在多维空间中的表示及其维度压缩。

```plaintext

例如,在三维空间中,基通常由三个相互垂直的向量组成,它们可以张成整个三维空间。

```

## 1.3 特征值与特征向量

特征值和特征向量是线性代数中描述线性变换性质的两个重要概念。特征值代表了线性变换对特定方向上向量的拉伸程度,而特征向量则是这些方向上的向量。这一概念在PCA中扮演了核心角色,有助于确定数据的主要变化方向。

```plaintext

考虑一个矩阵A,如果存在非零向量v和标量λ,使得Av = λv,则v是A的特征向量,λ是对应的特征值。

```

通过以上三个部分的介绍,读者将对线性代数有一个基础的理解,并能够理解其在PCA等数据分析方法中的应用。下一章我们将详细探讨PCA的理论基础和数学原理。

# 2. 主成分分析(PCA)的理论基础

## 2.1 PCA的概念与数学原理

### 2.1.1 数据降维的重要性

数据降维是统计学和机器学习中的一个重要概念,它指的是将原始数据从高维空间映射到低维空间的过程。降维的目的在于简化数据结构,减少计算复杂度,同时尽可能保留原始数据的重要信息。降维技术如PCA不仅可以帮助我们理解数据的内在结构,还能用于数据可视化、提高机器学习算法性能和速度。

在高维数据中,经常遇到的是维数灾难(Curse of Dimensionality),即随着维度增加,数据稀疏性增加,数据点之间的距离变得越来越远,这使得许多算法变得低效甚至失效。降维技术可以缓解这一问题,使我们能够更有效地进行数据处理。

### 2.1.2 协方差矩阵的作用

协方差矩阵是PCA中的关键步骤之一,它描述了数据各维度间的协方差,即维度间的线性相关性。协方差矩阵的每个元素表示了两个不同维度之间的协方差,如果元素值为正,则表示这两个维度正相关;如果为负,则表示负相关;如果为零,则表示它们之间无线性相关性。

在PCA中,协方差矩阵的特征值和特征向量对于确定主成分至关重要。特征向量确定了变换矩阵的方向,而特征值则表征了在这些方向上的方差大小。主成分的选择,实际上就是基于特征值的大小来确定数据方差最大的方向。

## 2.2 特征值和特征向量在PCA中的角色

### 2.2.1 特征值和特征向量的定义

在数学中,对于一个方阵A,如果存在标量λ和非零向量v使得Av = λv,则称λ为A的特征值,v为对应的特征向量。特征值和特征向量在PCA中用于确定数据的主要分布方向。

对于数据集中的特征值,它们表示的是数据在对应特征向量方向上的方差。特征值越大,表明在该方向上的数据变化越大,数据分布越分散。反之,特征值较小则表示数据在该方向上变化小,分布较为集中。

### 2.2.2 特征值分解与数据压缩

特征值分解是线性代数中一种提取数据重要信息的方法。在PCA中,通过执行特征值分解,可以从原始数据矩阵中提取出最重要的特征值和对应的特征向量。通过保留最大的k个特征值对应的特征向量,可以重构数据的一个近似,从而实现数据压缩。

这种压缩方法减少了数据的冗余,保留了数据最关键的信息。由于特征向量构成的子空间是原始空间的一个最佳近似,重构后的数据可以保持大部分重要的统计特性,例如方差和协方差结构。

## 2.3 主成分提取过程详解

### 2.3.1 从协方差矩阵到主成分

主成分分析的第一步是从数据集中计算出协方差矩阵,然后对这个矩阵进行特征值分解。通过分析每个特征值和对应的特征向量,我们可以确定数据的主要方向和每个方向的方差贡献。

具体来说,通过计算可以得到一个特征值列表,列表中的每个特征值都对应着一个特征向量。这些特征向量可以看作是数据空间中的轴,而特征值则表示沿着该轴的数据分布情况。我们通常按特征值从大到小排序,选择最大的几个特征值对应的特征向量作为数据的新坐标轴,即为提取的主成分。

### 2.3.2 选择主成分的标准与方法

选择主成分的过程实际上是选择保留数据中多少信息的过程。一般来说,我们会选择特征值最大的前k个特征向量来构造数据的低维表示。一个常用的选择标准是累积贡献率,即前k个特征值之和占所有特征值总和的比例。

选择主成分的方法通常包括以下步骤:

1. 计算协方差矩阵并执行特征值分解。

2. 排序特征值及其对应的特征向量。

3. 计算累计方差贡献率,并选取使得累计方差贡献率达到预设阈值(如95%)的特征值对应的特征向量作为主成分。

例如,使用Python的NumPy库可以方便地执行这一过程:

```python

import numpy as np

# 假设X是已经中心化后的数据矩阵

cov_matrix = np.cov(X, rowvar=False)

eigenvalues, eigenvectors = np.linalg.eig(cov_matrix)

# 按特征值大小排序

sorted_indices = np.argsort(eigenvalues)[::-1]

sorted_eigenvalues = eigenvalues[sorted_indices]

sorted_eigenvectors = eigenvectors[:, sorted_indices]

# 选择前k个特征向量作为主成分

k = 2 # 假设我们选择前两个主成分

principal_components = sorted_eigenvectors[:, :k]

```

在上述代码中,我们首先计算了数据矩阵X的协方差矩阵,然后进行了特征值分解,并根据特征值的大小进行排序。最后,我们根据需要提取的主成分数量k,选择了前k个特征向量,它们构成了新的数据空间的基。

PCA作为一个统计技术,不仅在理论上有着坚实的基础,而且在实践中也证明了其强大能力。掌握PCA的原理和实现细节,对于数据科学家和统计学家来说是必备的技能之一。通过PCA,我们可以有效地挖掘数据的内在结构,为后续的数据分析、数据处理和机器学习任务打下坚实的基础。

# 3. 线性代数在PCA实践中的应用

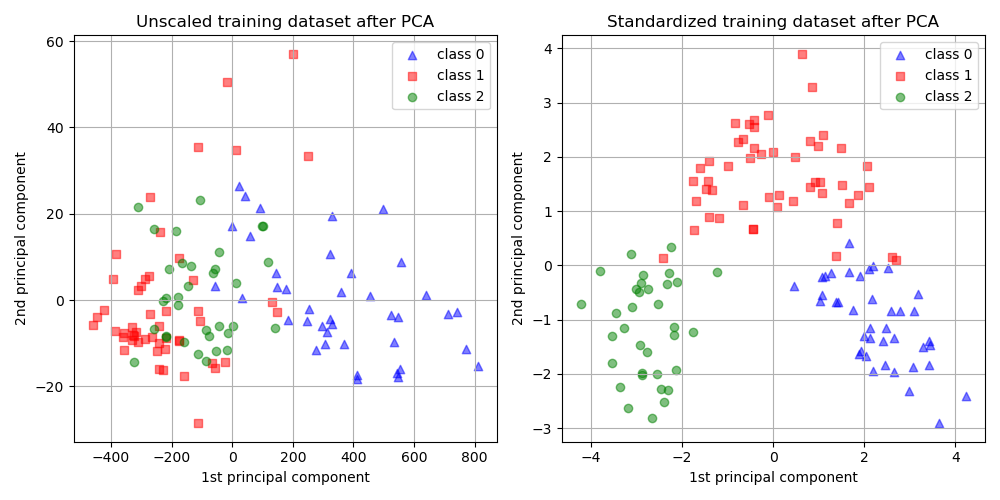

线性代数不仅在理论上构成了PCA的核心,而且在实践中也是实现PCA不可或缺的工具。理解并熟练运用线性代数的操作,能够帮助我们更好地理解和执行PCA分析。在第三章中,我们将会详细探讨数据预处理、线性代数工具的使用以及如何解释PCA分析结果。

## 3.1 数据预处理与标准化

数据预处

0

0