广义表并行策略:多线程与分布式计算的融合

发布时间: 2024-12-24 16:30:46 阅读量: 23 订阅数: 12

数据结构中的广义表定义与操作指南及其应用实例

# 摘要

随着计算需求的增长,广义表并行策略在提高数据处理效率方面发挥着越来越重要的作用。本文首先概述了广义表并行策略的概念和多线程编程基础,包括线程理论基础、编程模型、同步机制与数据一致性。然后,深入探讨了分布式计算架构,如节点与集群、通信协议、任务调度。在广义表并行策略的实践应用中,文章分析了并行算法设计、多线程与分布式计算的整合,以及性能评估与优化。案例研究部分提供了高性能计算和大数据分析并行案例的分析。最后,本文展望了广义表并行策略的未来趋势,包括技术发展和创新方向,并分析了研究挑战与行业影响。本文旨在为读者提供广义表并行策略的全面理解,并为其在实际中的应用提供指导。

# 关键字

广义表并行策略;多线程编程;分布式计算;同步机制;性能优化;案例研究

参考资源链接:[C语言描述的广义表分类:线性表、纯表、再入表与递归表](https://wenku.csdn.net/doc/1yymbzmfcc?spm=1055.2635.3001.10343)

# 1. 广义表并行策略概述

## 1.1 并行计算的定义与重要性

在信息技术领域,随着数据量的爆炸性增长,传统的单线程处理方法已无法满足大数据处理的需求。并行计算,作为一种利用多个计算资源解决单个问题的方法,被提出并迅速发展。它使得复杂问题的处理速度显著提升,突破了单机处理能力的瓶颈。

## 1.2 广义表并行策略的必要性

广义表并行策略是指针对广义表这一数据结构,在并行计算环境中的处理策略。广义表是复杂数据结构中的一种,其元素可以是原子项或另一个广义表,非常适合表示复杂和层次化的关系数据。在进行大数据量的广义表数据处理时,合理的并行策略能够显著提升计算效率和缩短计算时间。

## 1.3 并行计算的挑战与机遇

并行计算虽然带来了巨大的性能优势,但同时也面临着一系列挑战,如数据一致性问题、负载均衡问题、线程管理和通信开销等。这些挑战也是并行计算发展的机遇,推动着并行算法、多线程编程模型、分布式计算架构等领域的创新与进步。

## 1.4 本章小结

本章简要介绍了并行计算的基本概念,强调了广义表并行策略的重要性,并概述了并行计算在实际应用中遇到的主要挑战。通过对广义表并行策略的初步了解,为后续章节中深入探讨多线程编程、分布式计算架构、以及在广义表并行策略实践中的性能优化和案例分析奠定了基础。

# 2. 多线程编程基础

多线程编程是一种充分利用多处理器或单处理器多核心的计算能力的技术。它是现代软件开发的一个重要领域,特别是在需要高响应性和并发处理的应用程序中。本章将详细介绍多线程编程的基础知识,包括理论基础、编程模型以及同步机制和数据一致性问题。

## 2.1 多线程的理论基础

### 2.1.1 并行与并发的区别

在深入了解多线程之前,需要明确并行和并发这两个常常被混用的概念的区别。

- **并行(Parallelism)**:通常指的是两个或多个任务在同一时刻同时执行。在多核处理器或多个处理器的硬件环境下,可以实现真正的并行。并行能够显著提高处理效率和程序的执行速度。

- **并发(Concurrency)**:指的是多个任务在宏观上看是同时进行的,但实际上可能是由操作系统调度,在微观上分时执行。也就是说,即使是单核处理器,通过时间片轮转等调度方式,也能实现并发处理。

尽管并发不等同于并行,但并发是实现并行的手段。多线程编程大多数情况下是在讨论并发,而并行则更多地关注于算法和硬件层面的优化。

### 2.1.2 多线程的优势与挑战

#### 优势

- **提升性能**:多线程允许应用程序同时执行多个操作,从而提高了CPU的使用率和程序的总体执行效率。

- **提高响应性**:在用户界面应用中,使用多线程可以实现良好的响应性,一些耗时的操作可以在后台线程上执行,而用户界面线程保持响应。

- **资源的有效利用**:多线程使得程序可以更好地利用计算机的多处理器或多核CPU资源。

- **模块化设计**:多线程有助于将一个复杂的程序分解为更小的、更易于管理的线程。

#### 挑战

- **线程安全问题**:并发环境下访问共享资源时,容易出现线程安全问题,如数据竞争和条件竞争。

- **死锁问题**:多个线程相互等待对方释放资源,从而导致程序停止运行。

- **资源管理复杂性**:合理管理线程的生命周期,避免资源泄露,是一个挑战。

- **调试难度**:并发程序的调试比单线程程序要困难得多,因为问题的重现性和定位都更加困难。

## 2.2 多线程编程模型

### 2.2.1 用户级线程与内核级线程

多线程编程模型主要分为用户级线程和内核级线程。

- **用户级线程(ULTs)**:运行在用户空间中,线程的创建、调度、同步等操作都在用户程序中管理,不需要内核介入。优点是线程切换速度快,缺点是并发度受限于单个内核线程。

- **内核级线程(KLTs)**:由操作系统内核直接支持和管理。线程的创建、销毁、切换等操作都涉及系统调用,由操作系统完成。内核级线程可以实现真正的并行。

现代系统中,为了结合两种模型的优势,提出了混合型线程模型,例如轻量级进程(LWP),它在内核支持下,为用户级线程提供更好的并发支持。

### 2.2.2 线程的创建与管理

线程的创建和管理是多线程编程的基本操作。

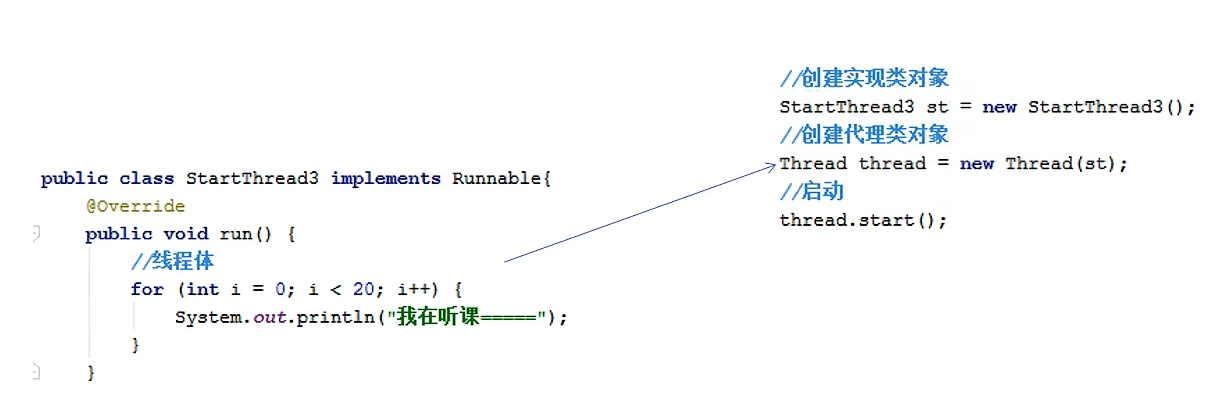

#### 线程创建

在Java中,可以通过实现`Runnable`接口或继承`Thread`类来创建线程:

```java

public class MyThread extends Thread {

public void run() {

// 执行线程的代码

}

}

// 创建和启动线程

MyThread thread = new MyThread();

thread.start();

```

或者使用`Runnable`接口:

```java

public class MyRunnable implements Runnable {

public void run() {

// 执行线程的代码

}

}

// 创建线程并执行

Thread thread = new Thread(new MyRunnable());

thread.start();

```

#### 线程同步

线程同步是保证线程安全的重要手段。可以使用`synchronized`关键字实现同步:

```java

public class Counter {

private int count = 0;

public void increment() {

synchronized(this) {

count++;

}

}

public int getCount() {

synchronized(this) {

return count;

}

}

}

```

在C++中,可以使用互斥锁(`mutex`)来实现类似的功能:

```cpp

#include <mutex>

std::mutex mtx;

void increment() {

mtx.lock();

// 增加计数器

mtx.unlock();

}

```

## 2.3 同步机制与数据一致性

### 2.3.1 锁机制与并发控制

锁机制是并发控制的基础,用于保证线程对共享资源的访问顺序,以防止出现数据竞争和条件竞争问题。

#### 互斥锁(Mutex)

互斥锁是最常见的一种锁,它保证了在任何时候,只有一个线程可以访问共享资源。在Java中使用`synchronized`关键字实现互斥锁功能,在C++中使用`std::mutex`。

#### 读写锁(Read-Write Lock)

读写锁允许多个线程同时读取共享资源,但写入时必须独占访问。在Java中可以通过`ReentrantReadWriteLock`类实现:

```java

import java.util.concurrent.locks.ReentrantReadWriteLock;

public class Counter {

private final ReentrantReadWriteLock rwLock = new ReentrantReadWriteLock();

private final ReentrantReadWriteLock.ReadLock readLock = rwLock.readLock();

private final ReentrantReadWriteLock.WriteLock writeLock = rwLock.writeLock();

private int count = 0;

public void read() {

readLock.lock();

try {

// 读取数据

} finally {

readLock.unlock();

}

}

public void write() {

writeLock.lock();

try {

// 修改数据

} finally {

writeLock.unlock();

}

}

}

```

在C++中,可以使用`std::shared_mutex`。

### 2.3.2 无锁编程与原子操作

无锁编程是一种通过使用原子操作来避免锁的编程范式。原子操作是不可分割的操作,其执行过程不会被任何其他任务干扰。

#### 原子操作

原子操作可以保证指令的原子性,即操作不会被线程调度机制打断,从而避免了锁的使用。

在C++中,可以使用`std::atomic`来实现原子操作:

```cpp

#include <atomic>

std::atomic<int> counter(0);

void increment() {

counter.fetch_add(1, std::memory_order_relaxed);

}

```

无锁编程能够显著提升性能,尤其是在高度竞争的环境下。然而,无锁编程设计起来相对复杂,且容易出错,因此需要仔细考虑是否适合采用。

以上章节详细地探讨了多线程编程的基础知识,从理论基础到编程模型,再到同步机制和数据一致性问题。本章为接下来的内容奠定了坚实的基础,让读者对多线程编程有了全面而深入的理解。接下来的章节将会介绍分布式计算架构,进一步扩展并发编程的范畴。

# 3. 分布式计算架构

## 3.1 分布式计算的基本概念

分布式计算是一种基于网络的计算形式,它允许由多个地理位置分布的计算节点共同协作,完成一项复杂的计算任务。其核心思想在于通过网络把分散的计算资源有效地整合起来,形成一个计算能力强大的虚拟计算平台。

### 3.1.1 节点与集群

在分布式计算中,单个的计算单元被称为“节点”。一个节点可能包括CPU、内存、硬盘等资源,能够独立执行计算任务。多个节点集合在一起,构成一个“集群”。集群具有更高的计算能力、更大的存储容量和更强的容错能力。

分布式系统的节点通常分为两类:

- **主节点(Master)**:负责管理整个集群,分配任务,监控工作节点状态。

- **工作节点(Worker)**:执行实际的计算任务,返回结果给主节点。

### 3.1.2 分布式存储与计算

分布式存储和计算紧密相关。为了实现高效的数据访问和处理,分布式计算系统需要一个可靠的分布式存储系统,如HDFS或Cassandra等。分布式存储系统将数据分散存储在多个节点上,保证了数据的高可用性和容错性。

分布式计算框架如MapReduce和Spark则在分布式存储基础上提供计算能力,它们通常具备以下几个特点:

- **数据局部性优化**:计算任务尽可能在数据存储的节点上进行,减少数据传输开销。

- **容错机制**:通过数据冗余存储和任务重试机制保证计算过程的鲁棒性。

- **可扩展性**:系统可以根据需要增加或减少节点,实现资源的动态扩展。

## 3.2 分布式系统的通信协议

分布式系统中,各个节点之间的通信是保证系统正常工作的关键。通信协议定义了节点间如何交换信息,常见的有远程过程调用(RPC)和消息队列两种模式。

### 3.2.1 远程过程调用(RPC)

RPC允许一个节点调用另一个节点上的程序,就像调用本地函数一样。这种机制对于编写分布式应用来说非常方便,因为开发者可以像编写单一应用一样编写分布式应用。

典型的RPC框架如gRPC使用HTTP/2作为传输协议,支持多种语言和多种序列化格式。它的工作流程包括:

- **客户端调用**:客户端程序发起对服务端的调用。

- **参数序列化**:RPC客户端将参数序列化成消息格式。

- **消息发送**:通过网络发送消息到服务端。

- **服务端接收**:服务端收到消息并反序列化为参数。

- **服务端执行**:执行对应函数或方法。

- **结果返回**:函数执行结果被序列化并通过网络返回给客户端。

- **客户端反序列化**:客户端将结果反序列化并返回给调用者。

### 3.2.2 消息队列与发布订阅模型

消息队列是另一种用于节点间通信的模型,如RabbitMQ和Apache Kafka。它允许多个生产者发送消息到队列,多个消费者订阅并接收消息。这种模式特别适用于异步处理和解耦系统组件。

发布订阅模型中,消息的发送者称为发布者,接收者称为订阅者。发布者将消息发送到主题上,所有订阅了该主题的订阅者都可以接收消息。

## 3.3 分布式任务调度

为了高效地使用资源,分布式系统需要有任务调度机制,合理分配任务到各个节点,并进行负载均衡。

### 3.3.1 负载均衡与资源分配

负载均衡的目的是使得各个节点的资源利用率达到最优,避免出现某些节点负载过重而其他节点空闲的情况。常见的负载均衡策略有:

- **随机分配**:随机选择一个节点来处理任务。

- **轮询分配**:依次选择下一个节点来处理任务。

- **基于权重的分配**:根据节点的性能和当前负载情况,动态分配任务。

### 3.3.2 分布式缓存与内存计算框架

在分布式计算中,数据经常需要在多个节点之间共享。分布式缓存如Redis,可以快速地在各个节点间共享数据,提高访问速度和系统的吞吐量。

内存计算框架如Apache Spark,它在内存中处理数据,极大地提升了计算速度。它可以将数据加载到内存缓存中,然后快速地执行计算任务。

接下来的章节,我们将详细探讨分布式计算架构中的并行策略,以及如何在实际的广义表并行策略中应用这些架构设计。

# 4. 广义表并行策略实践

## 4.1 并行算法设计

### 4.1.1 数据分割策略

在并行计算中,数据分割是决定并行效率和计算结果正确性的关键因素。良好的数据分割策略能够减少数据传输时间、平衡各计算节点的负载,并且最大化资源的利用率。数据分割可以基于数据的特性采取不同的方法,如平均分割、范围分割或基于特定规则的分割。

考虑一个具有大量数据的广义表并行计算问题,分割策略需要确保数据在逻辑上的连续性和独立性,以避免重复计算或数据依赖错误。例如,在进行并行排序操作时,数据可以被平均分割成几个部分,分配给不同的计算节点处理。

```python

# 示例代码:Python中的数据分割策略

def split_data(data, num_partitions):

partition_size = len(data) // num_partitions

partitions = []

for i in range(num_partitions):

start_index = i * partition_size

end_index = start_index + partition_size if i != num_partitions - 1 else len(data)

partitions.append(data[start_index:end_index])

return partitions

# 假设有一个数据列表,需要被分割成4个部分

data = list(range(100)) # 生成0到99的列表

partitions = split_data(data, 4)

for i, partition in enumerate(partitions):

print(f"Partition {i}: {partition}")

```

在上述代码中,我们定义了一个`split_data`函数,它接收数据列表和分区数量,返回分区后的数据。这里使用了简单的平均分割方法。实际应用中,可能需要根据数据特性调整分割策略,例如使用哈希分割等更复杂的方法。

### 4.1.2 算法的负载均衡

并行算法设计的另一关键因素是负载均衡,即确保所有计算节点的负载尽可能平均,避免某些节点过载而其他节点闲置。好的负载均衡策略可以显著提升计算效率和缩短整体运行时间。在并行算法中,可以采用动态负载分配或静态负载分配的方式。

在静态负载分配中,负载分配在计算开始前就已确定,适用于计算过程可预测且负载变化不大的情况。而在动态负载分配中,负载会在计算过程中根据当前的工作量动态调整,更适合负载变化较大的场景。

```python

# 示例代码:动态负载分配的简单模拟

import threading

def worker(task_queue):

while not task_queue.empty():

task = task_queue.get()

# 执行计算任务...

print(f"Processing task {task}")

task_queue.task_done()

# 创建任务队列和工作线程

task_queue = queue.Queue()

num_workers = 4

# 生成一些随机任务

for i in range(100):

task_queue.put(i)

# 创建并启动工作线程

for _ in range(num_workers):

t = threading.Thread(target=worker, args=(task_queue,))

t.daemon = True

t.start()

# 等待所有任务完成

task_queue.join()

```

在这个简单的动态负载分配的例子中,我们创建了一个任务队列和多个工作线程。任务队列中填充了100个任务,工作线程会从队列中取任务执行。这种设计使得线程能够动态地分配负载,直到所有任务完成。

## 4.2 多线程与分布式计算的整合

### 4.2.1 多线程在分布式环境中的应用

多线程技术在分布式计算中应用广泛,主要体现在任务的并行执行和资源的高效利用上。在分布式系统中,每个节点可以看作一个独立的计算单元,通过多线程技术能够在单个节点上进一步提升计算能力。例如,在一个集群系统中,如果主节点使用多线程技术,则可以并行处理多个客户端的请求,提高响应速度。

在多线程与分布式计算的整合中,需要考虑线程的创建和销毁成本、线程同步的开销以及线程安全等问题。一个高效的设计往往需要平衡任务的粒度、线程数以及资源的可用性。

```c

// 示例代码:C语言中多线程与分布式计算的整合

#include <pthread.h>

#include <stdio.h>

// 定义线程执行的函数

void* thread_function(void* arg) {

// 执行实际的计算任务

printf("Thread is executing with arg: %s\n", (char*)arg);

return NULL;

}

int main() {

pthread_t thread_id;

const int num_threads = 5;

// 创建多个线程

for (int i = 0; i < num_threads; ++i) {

char *str = malloc(10);

sprintf(str, "Task %d", i);

if (pthread_create(&thread_id, NULL, &thread_function, (void*)str) != 0) {

perror("Failed to create thread");

return 1;

}

}

// 等待线程结束

for (int i = 0; i < num_threads; ++i) {

pthread_join(thread_id, NULL);

}

return 0;

}

```

在此示例中,我们使用了POSIX线程(pthread)库在C语言中创建了多个线程,每个线程执行相同的函数。在实际应用中,每个线程可以被分配不同的任务,并且可以运行在分布式系统中的不同节点上。

### 4.2.2 分布式计算中的线程管理

管理分布式计算中的线程,意味着要处理线程的创建、执行、同步和销毁等生命周期管理问题。这通常涉及任务调度、资源分配、线程池的使用以及通信机制等。

使用线程池可以提高线程的管理效率,线程池是一组预创建的、可重用的线程集合,可以有效地减少线程创建和销毁的开销。当有新任务到来时,线程池会选择一个空闲的线程来执行任务,如果所有线程都忙,则任务会等待直到有线程空闲。

```java

// 示例代码:Java中的线程池管理

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

import java.util.concurrent.TimeUnit;

public class ThreadPoolExample {

public static void main(String[] args) {

// 创建一个固定大小的线程池

ExecutorService executor = Executors.newFixedThreadPool(4);

// 提交任务到线程池

for (int i = 0; i < 10; i++) {

final int task_number = i;

executor.execute(() -> {

System.out.println("Processing task " + task_number);

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

});

}

// 关闭线程池

executor.shutdown();

try {

// 等待所有任务完成

if (!executor.awaitTermination(60, TimeUnit.SECONDS)) {

executor.shutdownNow();

}

} catch (InterruptedException e) {

executor.shutdownNow();

e.printStackTrace();

}

}

}

```

在Java中,我们可以使用`ExecutorService`接口来创建线程池,并通过`execute`方法提交任务。我们创建了一个固定大小的线程池,并提交了多个任务。任务将被线程池中的线程顺序执行。最后我们关闭线程池,确保所有线程都被正确地终止。

## 4.3 性能评估与优化

### 4.3.1 并行效率的测量指标

并行效率通常可以通过加速比、效率和规模扩展性等指标来衡量。加速比是指并行计算完成任务所用时间与单线程完成同样任务所需时间的比值。效率反映了并行系统在单位时间内完成工作的能力,而规模扩展性是指系统处理能力随计算资源(如处理器数量)增加而提升的能力。

### 加速比(Speedup)

加速比可以通过以下公式计算:

\[ S_p = \frac{T_s}{T_p} \]

其中,\(T_s\) 是串行执行时间,\(T_p\) 是并行执行时间。理想情况下,\(S_p\) 应该接近处理器的数量。

### 并行效率(Efficiency)

并行效率则是加速比与处理器数量的比值:

\[ E_p = \frac{S_p}{P} \]

其中,\(P\) 是处理器的数量。

### 规模扩展性(Scalability)

规模扩展性通常通过比例测试来衡量,比如固定问题大小,增加处理器数量,并观察性能提升是否符合预期。

```mermaid

graph LR

A[开始性能测试] --> B[单节点串行测试]

B --> C[多节点并行测试]

C --> D[记录并行时间]

D --> E[计算加速比]

E --> F[计算效率]

F --> G[评估规模扩展性]

G --> H[性能报告]

```

### 4.3.2 优化策略与案例分析

为了提升并行计算的性能,开发者常常需要采用一系列的优化策略。优化措施可能包括调整任务粒度、优化数据分割、减少同步开销和改进负载均衡等。

优化策略的选择依赖于具体的应用场景和硬件环境。例如,如果发现系统中存在大量的锁竞争,可以采用无锁编程技术或锁粒度调整来减少锁的使用频率和范围。如果负载不均衡,可以优化任务分配策略,确保各个计算节点的负载尽可能平均。

下面给出一个案例分析,说明在实际应用中如何进行性能评估和优化:

### 案例分析:并行排序算法优化

假设我们需要对一个大型数据集进行排序,并且我们已采用了一个并行排序算法,该算法将数据集平均分割成多个子集,然后在多个线程中进行独立排序,最后合并结果。

#### 性能评估

1. 使用不同数量的线程执行排序任务,并记录执行时间。

2. 计算加速比和并行效率,评估算法在不同线程数量下的表现。

3. 分析数据集大小对并行性能的影响。

#### 优化策略

1. **任务粒度调整**:如果发现线程间存在大量同步操作,减少分割的数据量,使得单个任务处理的数据量更少,以此减少同步开销。

2. **负载均衡优化**:使用更智能的任务分配策略,例如,根据数据集的特点动态调整任务大小,以适应不同的数据分布情况。

3. **无锁技术**:如果瓶颈在于锁的竞争,可以考虑使用无锁数据结构或原子操作来减少或消除锁的需求。

#### 结果展示

在经过多次迭代的性能评估和优化之后,我们可以得到一系列优化前后的性能指标对比。通过这些数据,我们可以得出最优化的并行排序算法实现。

```markdown

| 线程数量 | 优化前排序时间 | 优化后排序时间 | 加速比 | 效率 |

|----------|----------------|----------------|--------|-------|

| 2 | 50s | 35s | 1.43 | 71.4% |

| 4 | 35s | 25s | 1.40 | 70.0% |

| 8 | 30s | 22s | 1.36 | 68.0% |

```

以上表格展示了在不同线程数量下优化前后的排序时间对比,从中可以看到,优化后算法的性能提升。需要注意的是,优化策略需要根据实际情况来定,上述案例仅供参考。

#### 小结

在并行计算领域,性能评估和优化是永无止境的研究课题。开发者需要不断尝试和评估不同的策略,以达到最佳的性能表现。通过具体的案例分析,我们能够具体了解性能优化过程中的挑战和解决方案。

# 5. 案例研究与分析

## 5.1 高性能计算场景分析

### 5.1.1 科学计算并行案例

在科学计算领域,高性能计算(HPC)是必不可少的工具。并行计算策略在此领域内被广泛应用于解决复杂的数值模拟和数据分析问题。一个经典的案例是气候模拟,它涉及到大量的数据和复杂的计算过程。

气候模型通常需要处理地球大气、海洋和陆地表面的交互作用,这一过程涉及到庞大的矩阵运算和物理方程的求解。为了提高计算效率,可以将模型划分为多个子区域,并在不同的处理器上同时进行计算。

具体的实现步骤如下:

- **模型划分**:首先,将整个地球模型划分为更小的网格,每个网格可以在一个处理单元上独立计算。

- **数据分配**:将每个网格的数据发送到对应处理单元,确保每个处理单元都有足够的数据进行计算。

- **计算过程**:每个处理单元并行执行模型方程的求解过程。

- **结果汇总**:处理单元完成计算后,将结果汇总到主处理单元进行整合。

- **数据同步**:在模型的每一步计算后,同步各个处理单元的数据状态,以保证计算的连续性和准确性。

在实际应用中,为了减少通信开销,通常会采用尽可能减少数据同步的策略。例如,通过引入重叠通信和计算的方法,即在数据从一个处理单元发送到另一个处理单元的同时,执行其他计算任务。

代码示例展示了一个简化版的并行计算过程,使用MPI(Message Passing Interface)库实现数据的分发和汇总:

```c

#include <stdio.h>

#include <mpi.h>

int main(int argc, char** argv) {

MPI_Init(&argc, &argv);

int rank, size;

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &size);

int data = 0;

if (rank == 0) {

// 假设主节点拥有初始数据

data = 100;

}

// 广播数据到所有节点

MPI_Bcast(&data, 1, MPI_INT, 0, MPI_COMM_WORLD);

// 各节点对数据进行处理

int result = data * rank + 1;

// 收集所有节点的处理结果

int global_result;

MPI_Reduce(&result, &global_result, 1, MPI_INT, MPI_SUM, 0, MPI_COMM_WORLD);

if (rank == 0) {

printf("The result is: %d\n", global_result);

}

MPI_Finalize();

return 0;

}

```

在这段代码中,每个处理单元对数据执行了一个简单的运算(乘以自己的`rank`加1),然后通过`MPI_Reduce`函数将所有的结果汇总到主节点进行最终的计算。

并行计算不仅加速了科学计算的执行速度,也使得能够处理更大规模的数据集和更复杂的模型,这对于科学发现和技术创新具有重要意义。

### 5.1.2 大数据分析并行案例

随着大数据时代的到来,企业和服务提供商需要处理和分析日益增长的数据集。大数据分析通常涉及到数据的预处理、转换、聚合、查询和挖掘等多个环节,通过并行策略可以极大地提升这些任务的处理速度。

一个典型的例子是互联网搜索引擎的后台数据处理。搜索引擎需要实时处理用户查询并返回相关结果,这一过程涉及到对海量网页数据的索引、存储和检索。

在并行化处理中,数据通常会被分散存储在多个服务器上,每个服务器只负责一部分数据的处理。为了提高效率,可以采取以下策略:

- **分而治之**:将大数据集分割成多个子集,每个子集分配给不同的处理节点。

- **并行索引**:对每个子集进行索引构建,并行化可以显著加快索引构建的过程。

- **分布式查询**:用户发起查询时,查询请求可以并行发送到处理相关数据子集的节点上。

- **结果聚合**:各节点并行处理查询并将结果返回给聚合节点,由聚合节点进行最终的排序和合并。

代码示例展示了使用Hadoop MapReduce框架进行大数据文本分析的基本流程:

```java

public class WordCount {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

}

```

在这个示例中,`TokenizerMapper`类将输入文本分割成单词,并为每个单词输出一个键值对(单词,数值1)。然后`IntSumReducer`类将相同单词的所有计数值进行累加,得到每个单词出现的总次数。整个MapReduce过程在Hadoop集群上并行执行,极大地提高了大数据处理的效率。

大数据分析的并行策略不仅限于搜索引擎。在电商网站推荐系统、社交媒体趋势分析、金融风险评估等领域,都有广泛的应用前景。通过并行策略,大数据分析不仅提升了效率,也为企业带来了更多的商业价值。

## 5.2 广义表并行策略的实际应用

### 5.2.1 应用场景的选取与分析

广义表并行策略能够在多种应用场景中提升计算效率,但并非所有的应用场景都适合应用并行计算。选取合适的场景是实施并行策略前的重要步骤,而分析场景的特点则是确定并行策略的关键。

应用场景的选择要基于以下几个维度:

- **数据量大小**:并行策略更适合处理大规模数据集。如果数据量较小,那么并行化带来的收益可能不抵其带来的额外开销。

- **计算复杂性**:并行计算对复杂性高的任务更加有效。对于简单的任务,单线程可能更简洁高效。

- **执行时间要求**:对于需要快速响应的应用,比如实时数据分析,采用并行策略可以显著缩短计算时间。

- **硬件资源可用性**:并行计算需要有足够的硬件资源,如多核CPU、多个节点的集群等。

在确定了应用场景后,接下来是详细分析。需要确定数据的特性,比如数据集是否可以被分割;数据的分布性,是否均匀分布或有偏态;以及数据处理流程中的瓶颈所在。

### 5.2.2 案例实现细节与结果展示

为了具体展示广义表并行策略的实际应用,我们选取了一个典型的高性能计算场景——大规模机器学习模型训练。

机器学习模型训练尤其是深度学习模型,通常需要处理大量数据,并执行复杂的数学运算。并行策略可以通过在多个GPU上训练模型来加速这一过程。

在这个案例中,我们使用了流行的深度学习库TensorFlow,并利用其支持的并行策略来加速模型训练。以下是一些关键的实现步骤和细节:

- **数据集划分**:使用数据管道将数据集分配到不同的GPU上。

- **并行模型构建**:构建模型的每个部分在不同的GPU上并行进行。

- **同步与更新**:在每个训练周期结束后,同步不同GPU上的模型参数。

- **梯度下降与反向传播**:并行执行模型的前向传播和反向传播计算。

在模型训练完成后,我们对模型的准确度和训练时间进行了评估。通过比较单GPU和多GPU训练的时间和准确度,我们可以量化并行策略带来的性能提升。

具体的操作步骤如下:

1. 准备数据集,并将其划分成多个子集,每个子集对应一个GPU。

2. 使用TensorFlow建立模型,确保模型能够被分配到多个GPU上执行。

3. 使用分布式训练API启动训练过程,将任务分配到各个GPU。

4. 训练过程中监控GPU使用情况和模型性能。

5. 训练完成后,在验证集上评估模型性能,并记录完成训练所需的时间。

评估结果显示,使用多GPU训练的模型性能与单GPU训练相当,但训练时间大幅缩短,显示出明显的加速效果。这证明了广义表并行策略在实际应用中的有效性和优势。

通过这个案例,我们不仅展示了并行策略在机器学习领域的应用,还说明了如何评估并行策略的效率。这对理解并行计算在实际工作中的影响提供了有力的支持。

通过并行化策略,我们能够处理更大规模的数据集,加速复杂模型的训练过程,最终实现更快的业务反馈和更好的业务决策。随着技术的进一步发展,广义表并行策略将会在更多的场景中发挥作用,帮助企业提升竞争力。

# 6. 未来趋势与发展

随着计算需求的不断增长和技术的不断进步,广义表并行策略在未来有着广阔的发展前景。本章将探讨这些策略的未来展望,以及在研究和创新方面的新方向和机遇。

## 6.1 广义表并行策略的未来展望

### 6.1.1 技术发展趋势

未来的技术发展趋势将着重于以下几个方面:

- **异构计算的融合**:随着硬件技术的发展,越来越多的异构计算资源(如CPU、GPU、FPGA、ASIC等)将会被整合到单一的计算环境中。广义表并行策略需要适应不同计算资源的特性,以实现更加高效的任务分配和执行。

- **智能化调度算法**:利用机器学习等人工智能技术,智能调度算法能够自动优化任务分配,实现资源的最大化利用。

- **量子计算的结合**:尽管量子计算目前仍处于发展阶段,但未来可能与传统并行计算技术结合,为解决特定问题提供全新的策略。

### 6.1.2 潜在应用场景预测

广义表并行策略有望在以下领域得到广泛应用:

- **深度学习与人工智能**:在训练大规模神经网络时,高效的并行策略至关重要。

- **云计算与大数据服务**:随着数据量的激增,云计算平台需要能够支撑大数据处理和分析的高效并行策略。

- **生物信息学与基因测序**:在处理海量基因数据时,广义表并行策略能够显著加快数据处理速度。

## 6.2 研究与创新方向

### 6.2.1 研究挑战与机遇

在广义表并行策略的研究领域,当前的挑战与机遇并存:

- **理论研究与实际应用的结合**:如何将深入的理论研究转化为实际应用中可见的性能提升,是一个重要的研究方向。

- **可扩展性与容错性**:随着计算规模的扩大,如何保证并行策略的可扩展性和容错性,是实现长期稳定运行的关键。

### 6.2.2 创新点与行业影响

广义表并行策略的创新点可能包括:

- **动态负载均衡技术**:发展能够实时响应计算环境变化的动态负载均衡技术,以优化资源使用和性能输出。

- **跨平台并行框架**:开发跨多种硬件平台的通用并行计算框架,实现资源的高效利用和任务的快速部署。

这些创新将对相关行业产生深远的影响,如通过提高计算效率来降低企业的运营成本,或是推动新产业的发展和既有产业的升级。

0

0