Ubuntu on Jetson Nano进阶秘籍

发布时间: 2024-12-22 07:33:29 阅读量: 5 订阅数: 3

嵌入式ARM版本的ubuntu(jetson nano)版本的向日葵远程控制软件

# 摘要

本文深入介绍了在NVIDIA Jetson Nano硬件上安装、配置以及优化Ubuntu操作系统的过程,包括硬件概述、系统安装、性能调优及监控。此外,文章探讨了如何搭建适用于深度学习的编程环境,包括必要的开发工具和SDK安装、交叉编译环境建立以及虚拟化技术的应用。文中还详述了在Jetson Nano平台上部署深度学习模型、进行模型训练及优化的技术细节,并通过实际应用案例展示其能力。高级功能拓展章节涵盖了自动驾驶、多媒体处理、创新应用等方面。最后,本文提供了故障排除、系统维护与安全加固的策略,确保系统的稳定性和数据的安全性。整体而言,本文为开发者提供了一套完整的指南,旨在提升Jetson Nano平台上的Ubuntu系统性能和应用能力。

# 关键字

Jetson Nano;Ubuntu系统;硬件配置;性能优化;深度学习;系统维护;安全性加固

参考资源链接:[向日葵远程控制软件在ARM版Ubuntu(Jetson Nano)的应用](https://wenku.csdn.net/doc/hepq0vp5cb?spm=1055.2635.3001.10343)

# 1. Ubuntu on Jetson Nano 简介

## 1.1 Jetson Nano概述

Jetson Nano是NVIDIA推出的一款边缘计算设备,专为学习、开发和运行AI应用而设计。它搭载了NVIDIA Maxwell GPU架构,提供惊人的计算性能和能效比,让开发者能够在边缘设备上轻松部署深度学习和AI算法。Ubuntu作为Jetson Nano的默认操作系统,提供了一个全面的、易于使用的开发平台,使开发者可以快速上手并开始他们的项目。

## 1.2 Ubuntu on Jetson Nano的使用场景

Ubuntu on Jetson Nano提供了一个强大的平台,适用于各种AI和边缘计算应用。比如,它可以在智能家居、机器人、无人机和智能视频分析等场景中使用。Ubuntu的稳定性和丰富的软件包仓库,以及对开源社区的友好支持,使得Jetson Nano成为了开发者和学生的热门选择。

## 1.3 Ubuntu on Jetson Nano的优势

与传统的嵌入式系统相比,Ubuntu on Jetson Nano的明显优势在于其广泛的兼容性和强大的生态系统。通过使用Ubuntu,开发者可以访问到数以千计的开源库和工具,并能够通过包管理器方便地进行安装和管理。此外,Ubuntu还支持Docker容器技术,为创建轻量级、隔离的运行环境提供了便利,从而在不影响系统稳定性的前提下,简化了开发和部署过程。

# 2. Jetson Nano 硬件与Ubuntu系统配置

## 2.1 Jetson Nano 硬件概述

### 2.1.1 硬件架构详解

Jetson Nano是NVIDIA推出的一款小尺寸边缘计算设备,专为开发小型、低功耗的AI系统而设计。它搭载了NVIDIA Maxwell架构的GPU核心,拥有128个CUDA核心,可以进行并行计算处理。此外,Jetson Nano集成了ARM Cortex-A57 CPU,提供了四核处理能力,能够支持多种操作系统,例如Ubuntu。硬件上,Jetson Nano还内置了HDMI和DisplayPort接口、USB 3.0端口、千兆以太网接口、以及用于连接各种传感器的GPIO接口。

为了更好地理解其硬件架构,我们可以通过以下关键点进行详细解读:

- **处理器**:4核心ARM Cortex-A57 MPCore处理器,提供足够的处理能力来运行操作系统和应用。

- **GPU**:NVIDIA Maxwell架构GPU,具有128个CUDA核心,专为并行计算优化。

- **内存**:2GB 64-bit LPDDR4内存,速度高达25.6 GB/s。

- **存储**:支持通过microSD卡进行扩展,推荐使用速度较快的UHS-I类以上的卡。

- **连接性**:具备4个USB 3.0端口、千兆以太网接口、HDMI和DisplayPort视频输出接口。

- **GPIO接口**:40针GPIO可用于连接各种传感器和执行器。

### 2.1.2 硬件性能测试与评估

为了全面评估Jetson Nano的性能,我们可以进行一系列基准测试和应用场景的实测。以下是几个关键的测试项目:

- **综合性能测试**:通过使用如Jetson-Perf工具进行综合性能测试,评估CPU和GPU的整体性能。

- **AI推理测试**:使用NVIDIA提供的AI推理基准测试,如TensorRT-Inference-Server,测试其深度学习性能。

- **I/O速度测试**:使用dd工具测试读写速度,评估microSD卡的性能。

- **电源效率测试**:通过测量不同工作负载下的功耗,评估Jetson Nano的电源效率。

在进行测试之前,需要确保硬件与软件环境均已经按照推荐配置准备完毕。例如,可以安装NVIDIA提供的JetPack SDK,它会同时包含CUDA、cuDNN以及TensorRT等必需的深度学习库,同时还可以安装NVIDIA的Jetson System Profiler等工具来辅助测试。

以下是使用Jetson System Profiler进行硬件性能评估的一个基础示例:

```bash

# 安装Jetson System Profiler

sudo apt update

sudo apt install nvidia-jetson-profiler

# 运行性能评估

sudo jetson_stats

```

在性能评估过程中,开发者可以收集到处理器、内存、存储、网络和GPU等硬件组件的详细信息,从而为后续的性能优化提供依据。

## 2.2 Ubuntu系统安装与初始化设置

### 2.2.1 Ubuntu系统安装流程

Jetson Nano支持多种操作系统,但Ubuntu是其最常用的Linux发行版之一。安装Ubuntu的过程大体可以分为以下几个步骤:

1. **准备工作**:下载适合Jetson Nano的Ubuntu镜像文件。

2. **制作启动盘**:将下载的镜像文件写入一个至少16GB的microSD卡中,可以使用Etcher等工具完成。

3. **安装Ubuntu**:将制作好的启动盘插入Jetson Nano,首次启动后按照提示进行系统安装。

4. **系统配置**:安装完成后,对系统进行必要的配置,包括设置用户名、密码、时区、网络等。

注意,在进行安装前要确保Jetson Nano设备的固件已更新到最新版本,以避免兼容性问题。具体步骤可参照NVIDIA官方文档。

### 2.2.2 系统配置与优化指南

安装完毕之后,我们需要对系统进行初始配置并执行一系列优化措施,以确保系统稳定性和性能最大化。以下是一些重要的优化步骤:

- **更新系统**:执行以下命令来更新系统到最新版本,并安装必要的工具和依赖。

```bash

sudo apt-get update

sudo apt-get upgrade -y

```

- **更改默认shell**:可选地,更改默认shell到更高效的操作界面,如zsh或fish。

- **安装并配置Swap**:Jetson Nano默认只有2GB内存,当运行大型应用时可能会出现内存不足的情况。配置一个swap分区或swap文件可以帮助缓解内存压力。

```bash

sudo fallocate -l 2G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

```

- **调整内核参数**:为了提高系统性能,我们可能需要调整一些内核参数。可以通过编辑 `/etc/sysctl.conf` 文件来配置,并使用 `sudo sysctl -p` 来应用更改。

```properties

# 示例内核参数配置

vm.swappiness=10

vm.dirty_ratio=60

vm.dirty_background_ratio=30

```

## 2.3 系统性能调优与监控

### 2.3.1 调整系统参数以提升性能

系统性能调优是一个细致的过程,需要针对具体的应用场景来进行。以下是一些常见并能有效提升性能的调优步骤:

- **优化CPU调度**:通过更改CPU的Governor模式来优化性能。可以安装如cpufreq工具来轻松更改模式。

```bash

sudo apt install -y cpufrequtils

sudo cpufreq-set -r -g performance

```

- **减少系统开销**:通过禁用不必要的服务和后台进程来减少系统开销。可以使用 `systemctl` 或 `service` 命令来管理服务。

```bash

sudo systemctl disable ModemManager

sudo systemctl stop ModemManager

```

- **使用cgroups限制资源**:通过控制组(cgroups)对特定应用程序进行资源限制,确保关键应用有足够的资源可用。

```bash

# 示例:创建一个cgroup来限制进程的CPU时间和内存使用

```

### 2.3.2 使用工具监控系统状态

为了有效地监控系统性能,需要定期检查各个硬件组件的工作状态。以下是一些常用的监控工具和方法:

- **Jetson System Profiler**:如前所述,使用NVIDIA提供的Jetson System Profiler工具可以监控处理器、内存、存储、网络和GPU等。

- **top / htop**:使用 `top` 或 `htop` 命令查看当前运行的进程和系统资源使用情况。

- **nmon**:安装并使用nmon工具可以直观地查看和记录CPU、内存、磁盘、网络和进程等性能数据。

```bash

# 安装nmon

sudo apt install nmon

# 使用nmon查看系统状态

nmon

```

通过上述监控工具可以了解系统运行情况,及时发现瓶颈并进行优化,确保系统的高性能运行。

以上就是对Jetson Nano硬件与Ubuntu系统配置部分的详细介绍,了解这些内容对于构建一个稳定且高效的开发平台至关重要。在下一章节中,我们将探索如何在Jetson Nano上搭建一个适合深度学习开发的编程环境。

# 3. Ubuntu on Jetson Nano 编程环境搭建

## 3.1 安装开发工具与SDK

### 3.1.1 安装CUDA、cuDNN和TensorRT

在Jetson Nano上进行深度学习或者高性能计算任务,CUDA、cuDNN和TensorRT是不可或缺的组件。它们分别是NVIDIA的并行计算平台与编程模型、用于深度神经网络加速的库以及深度学习推理加速器。

首先,确保Jetson Nano已经连接到互联网,并且系统是最新的。打开终端执行以下命令来添加NVIDIA官方的软件仓库:

```bash

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt-get update

```

安装CUDA Toolkit前,需要确认你安装的JetPack版本,因为JetPack版本决定了支持的CUDA版本。例如,JetPack 4.4默认支持CUDA 10.0。一旦确认了版本,可以使用apt包管理器安装CUDA:

```bash

sudo apt-get install cuda-10-0

```

接下来,安装cuDNN,它提供了深度学习的优化。从NVIDIA官网下载对应版本的cuDNN包,并解压后,执行以下命令:

```bash

sudo dpkg -i libcudnn8_8.0.4.30-1+cuda10.0_amd64.deb

sudo dpkg -i libcudnn8-dev_8.0.4.30-1+cuda10.0_amd64.deb

sudo dpkg -i libcudnn8-samples_8.0.4.30-1+cuda10.0_amd64.deb

```

最后,安装TensorRT,它对模型进行优化并提供推理加速:

```bash

sudo dpkg -i tensorrt-repo-ubuntu1804-cuda10.0-trt6_6.0.1-1+cuda10.0_amd64.deb

sudo apt-key add /var/tensorrt-repo-ubuntu1804-cuda10.0-trt6/7fa2af80.pub

sudo apt-get update

sudo apt-get install libnvinfer6=6.0.1-1+cuda10.0 libnvinfer-dev=6.0.1-1+cuda10.0 libnvinfer-plugin6=6.0.1-1+cuda10.0 libnvinfer-plugin-dev=6.0.1-1+cuda10.0

```

这些组件的安装可能会导致系统对硬件资源的使用增加,建议在安装过程中监控系统的状态,确保系统稳定性。

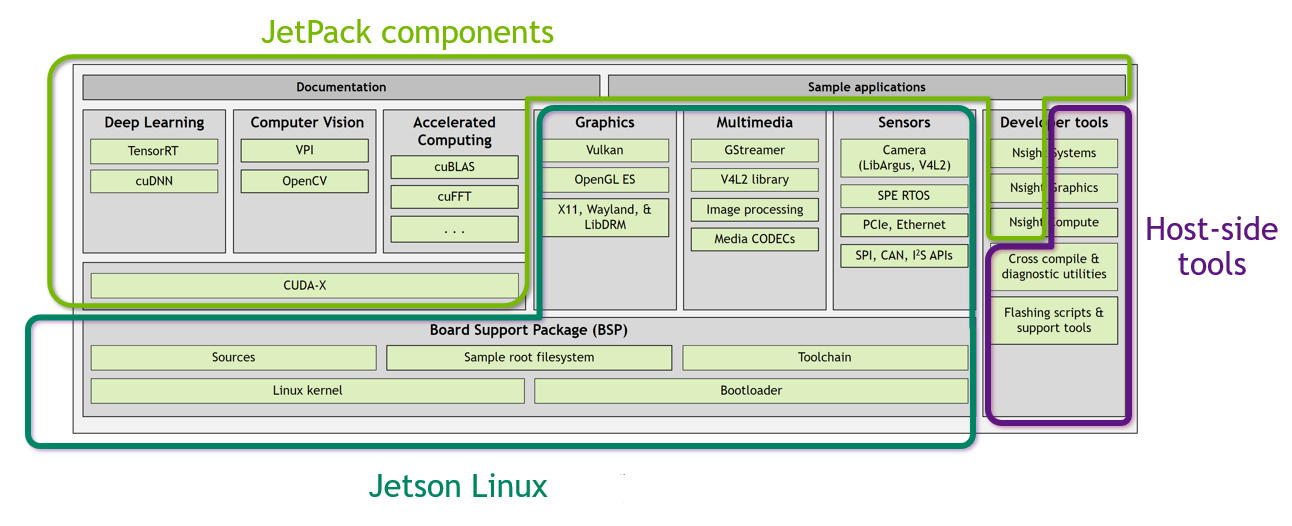

### 3.1.2 安装JetPack SDK

JetPack是NVIDIA为Jetson平台提供的一个完整AI开发套件,它包括了Linux操作系统镜像、CUDA、cuDNN、TensorRT以及NVIDIA深度学习应用架构(如TensorFlow, PyTorch, VisionWorks等)。

安装JetPack需要使用NVIDIA提供的SDK Manager工具,它是一个跨平台的图形界面程序,用于在Jetson设备上安装操作系统镜像和软件包。首先下载并安装SDK Manager:

```bash

# 下载SDK Manager

wget https://nvidia.box.com/shared/static/c9r8m1j91bgx28f5j99qbc9tkti07qkn.sh

# 使脚本可执行并运行SDK Manager安装

chmod +x ./c9r8m1j91bgx28f5j99qbc9tkti07qkn.sh

sudo ./c9r8m1j91bgx28f5j99qbc9tkti07qkn.sh

```

在安装过程中,SDK Manager会自动下载最新的JetPack版本,并引导你完成安装。你需要连接一个Jetson Nano设备,并选择需要安装的组件。请注意,安装过程中可能会有多个步骤需要你手动确认,务必仔细阅读每个提示信息。

安装完成后,SDK Manager会自动配置环境变量和系统设置,以便你可以立即开始使用深度学习和计算机视觉库。

## 3.2 交叉编译环境的建立

### 3.2.1 配置交叉编译工具链

交叉编译允许开发者在一个平台上为另外一个平台构建软件,这对于嵌入式设备开发尤为重要。在Jetson Nano上,通常需要为ARM架构交叉编译代码。

首先,我们需要下载适用于Jetson Nano的交叉编译工具链,NVIDIA官方提供了一个专门为Jetson Nano配置的工具链:

```bash

wget https://nvidia.box.com/shared/static/0f83c3c9xakuk278w92167f941yf0335.tgz

tar -xvzf gcc-linaro-7.5.0-2019.12-x86_64_aarch64-linux-gnu.tar.xz

```

解压后,将该工具链的bin目录添加到你的PATH环境变量中,以便可以在任何位置调用交叉编译器:

```bash

export PATH=$PATH:~/gcc-linaro-7.5.0-2019.12-x86_64_aarch64-linux-gnu/bin

```

配置交叉编译工具链后,你可以使用它来为Jetson Nano构建应用程序和库。例如,使用aarch64-linux-gnu-gcc编译器:

```bash

aarch64-linux-gnu-gcc --version

```

交叉编译工具链的配置允许你在PC上为Jetson Nano开发和测试代码,而不必一直将代码直接在目标设备上编译。不过,需要保持工具链和目标系统的同步,以确保编译出的程序能在Jetson Nano上正常运行。

### 3.2.2 跨平台开发实践

跨平台开发意味着在一种硬件/操作系统平台上开发应用程序,并能在另一种平台上运行。对于Jetson Nano,这通常意味着在x86架构的PC上开发,并在ARM架构的Jetson Nano上运行。

在这一小节中,我们将探讨如何使用上述交叉编译工具链进行跨平台开发。首先,你需要确认你的开发环境中已经安装了必要的库和工具。例如,如果你正在开发一个Python应用,你需要在你的开发机上安装Python及交叉编译后的Python库。

接下来,创建一个简单的Python脚本作为测试:

```python

# hello.py

print("Hello, Jetson Nano!")

```

使用交叉编译工具链编译Python脚本。尽管Python脚本通常是解释执行的,但Python解释器和它的库需要为ARM平台编译:

```bash

aarch64-linux-gnu-python3 hello.py

```

这个命令会告诉Python解释器使用ARM架构的编译器。由于在x86系统上不能直接运行ARM编译后的Python解释器,你必须将脚本和解释器一起传输到Jetson Nano上运行。

对于C++或其他编译型语言的项目,可以使用CMake和交叉编译工具链一起设置一个跨平台编译环境。例如,在CMakeLists.txt中设置交叉编译工具链文件:

```cmake

# CMakeLists.txt

cmake_minimum_required(VERSION 3.10)

project(crossplatform LANGUAGES CXX)

# 设置交叉编译工具链

set(CMAKE_TOOLCHAIN_FILE ~/gcc-linaro-7.5.0-2019.12-x86_64_aarch64-linux-gnu/aarch64-linux-gnu.cmake)

add_executable(my_app main.cpp)

```

之后执行:

```bash

mkdir build && cd build

cmake ..

make

```

这将生成一个可在Jetson Nano上运行的可执行文件。确保在目标设备上测试生成的程序,以验证其功能和性能。

跨平台开发是一个挑战,但通过正确配置和管理工具链,开发者可以有效地在不同的硬件和操作系统上开发应用程序。

## 3.3 虚拟化与容器技术的应用

### 3.3.1 Docker在Jetson Nano上的应用

Docker是一个开源的应用容器引擎,它允许开发者打包他们的应用以及应用的依赖包到一个可移植的容器中。借助Docker,可以简化应用程序的部署过程,并确保应用在不同环境中的一致性。

虽然Jetson Nano的资源受限,但仍然可以运行轻量级的Docker容器。首先,确保你安装的JetPack版本支持Docker。安装Docker社区版:

```bash

sudo apt-get update

sudo apt-get install docker.io

```

安装完成后,你可以拉取一个预配置的Docker镜像,例如一个简单的Ubuntu镜像:

```bash

sudo docker pull ubuntu

```

运行一个容器实例:

```bash

sudo docker run -it ubuntu /bin/bash

```

上述命令会启动一个Ubuntu容器,你可以在这个容器中安装任何需要的软件或库,并且这些变化仅限于容器内部,不会影响到宿主机。这对于开发环境的隔离和统一是非常有用的。

### 3.3.2 使用虚拟机扩展开发环境

对于一些不提供Docker支持的软件或更复杂的应用环境,虚拟机提供了一种选择。虚拟机通过软件模拟完整的硬件系统,可以在一台物理设备上运行多个操作系统实例。不过,由于资源限制,Jetson Nano运行虚拟机可能会遇到性能瓶颈。

如果决定在Jetson Nano上使用虚拟化技术,选择轻量级的虚拟机软件如QEMU可能是最佳选择。下面是一个使用QEMU启动ARMv8架构虚拟机的基本示例:

```bash

# 安装QEMU

sudo apt-get install qemu

# 设置QEMU模拟器,需要下载一个适合的镜像文件

qemu-system-aarch64 -m 2048 -cpu cortex-a57 -M virt -nographic -kernel path/to/vmlinuz -initrd path/to/initrd.img -append "console=ttyAMA0 root=/dev/vda"

```

上述命令参数解释:

- `-m 2048` 指定内存大小为2048MB。

- `-cpu cortex-a57` 指定CPU型号为Cortex-A57。

- `-M virt` 指定使用虚拟平台机器。

- `-nographic` 无图形界面,所有输出都重定向到控制台。

- `-kernel` 和 `-initrd` 分别指定内核和初始内存磁盘映像。

- `-append` 指定启动参数。

在使用虚拟机时,资源需求会显著增加,特别是内存和CPU,因此建议仅在必要时使用,或者在性能评估后确认资源可用性。

虚拟机技术的使用在嵌入式开发中不是非常普遍,但对于学习、开发和测试那些难以在物理机器上复制的复杂场景,仍然有其价值。

以上内容详细阐述了如何在Ubuntu on Jetson Nano上搭建开发环境,从安装开发工具与SDK到建立交叉编译环境,再到使用虚拟化与容器技术拓展开发环境。每一步都提供了必要的代码、命令和解释,旨在帮助开发者有效利用Jetson Nano的硬件资源进行高效的开发工作。

# 4. Ubuntu on Jetson Nano 的深度学习应用

## 4.1 深度学习基础与Jetson Nano

### 4.1.1 深度学习框架概览

深度学习,作为一种强大的机器学习方法,近年来在各个领域都取得了显著的进展。从图像识别到自然语言处理,再到自动驾驶技术,深度学习正推动着人工智能的边界不断扩张。Jetson Nano作为一款集成性能与便携性的硬件平台,因其高性价比和易用性,被越来越多的深度学习开发者采用。

在Jetson Nano上可以运行多种深度学习框架,如TensorFlow、PyTorch、Caffe、Keras等,这些框架提供了丰富的API接口和预训练模型,让开发者能够轻松实现深度学习项目。然而,不同的框架在性能和功能上有所不同,选择合适的框架将直接影响到项目的效率和结果。

### 4.1.2 在Jetson Nano上部署深度学习模型

在Jetson Nano上部署深度学习模型,需要考虑到模型的大小、计算复杂度和Nano的硬件性能。模型压缩和优化是必要的步骤,以确保模型在资源有限的设备上能够顺利运行。

首先,要选择合适的模型。对于推理任务,可以选用轻量级的模型如MobileNet、SqueezeNet等,它们专为移动和边缘设备设计。然后,通过框架提供的工具进行模型优化,例如在TensorFlow中使用TensorFlow Lite,在PyTorch中使用TorchScript。

在模型优化之后,便可以在Jetson Nano上部署模型。通常使用Python脚本调用优化后的模型,通过推理引擎如TensorRT(NVIDIA提供的深度学习推理加速器)来执行。TensorRT能够优化模型的运行效率,提高推理速度。

### 4.2 模型训练与优化

#### 4.2.1 训练流程与技巧

在深度学习模型训练阶段,Jetson Nano受限于较小的GPU和内存,可能无法像在服务器上那样进行大规模的训练任务。但即便如此,Jetson Nano还是提供了足够资源进行模型的初步训练和验证。

训练流程涉及数据准备、模型设计、训练执行和评估等多个步骤。在Jetson Nano上执行这些步骤时,需要注意资源分配,优化GPU和CPU的使用。通过使用NVIDIA的DALI(NVIDIA Data Loading Library),可以加速数据加载和预处理,从而提升整体训练效率。

在模型设计时,应当选择适合Nano的模型结构和参数。避免使用过于复杂的网络结构,它们可能会导致训练时间过长甚至无法在资源有限的设备上运行。

#### 4.2.2 模型压缩与加速技术

模型压缩和加速技术能够在不牺牲太多准确度的情况下减小模型大小和提升推理速度。Jetson Nano的硬件资源限制使得这些技术尤为重要。

有几种常见的模型压缩技术:

1. 权重剪枝:通过移除网络中不重要的连接,减少模型参数数量。

2. 量化:将浮点数权重和激活转换为低精度的数据类型,如int8。

3. 知识蒸馏:将大型“教师”模型的知识迁移到更小的“学生”模型中。

Jetson Nano利用TensorRT提供的加速器,可以实现模型的高效执行。TensorRT能够优化计算图,实现层融合、内核自动调优等技术,提高推理性能。

### 4.3 实际应用案例分析

#### 4.3.1 视觉识别与处理实例

视觉识别是深度学习应用中最具代表性的领域之一。Jetson Nano结合相应的深度学习模型,可以轻松搭建起图像分类、物体检测、人脸识别等多种视觉处理系统。

以物体检测为例,使用Jetson Nano和TensorRT优化过的YOLOv4-tiny模型,可以在实时视频流中准确检测出多种物体。这不仅要求模型能够快速推理,还要求有较低的延迟和稳定的运行速率。

代码块展示如何利用TensorRT进行模型加载和推理:

```python

import tensorrt as trt

TRT_LOGGER = trt.Logger(trt.Logger.WARNING)

trt_runtime = trt.Runtime(TRT_LOGGER)

# 解析TensorRT引擎文件

with open("yolov4-tiny.engine", "rb") as f:

engine_data = f.read()

engine = trt_runtime.deserialize_cuda_engine(engine_data)

context = engine.create_execution_context()

# 构建输入输出内存

input_shape = (1, 3, 416, 416) # 例如:批次大小,通道数,高度,宽度

d_input = cuda.mem_alloc(batch_size * input_shape[1] * input_shape[2] * input_shape[3] * trt.float32.itemsize)

bindings = [int(d_input)]

# 创建输出内存

output_shape = (1, 25200, 85) # 输出数据的形状

d_output = cuda.mem_alloc(batch_size * output_shape[1] * output_shape[2] * trt.float32.itemsize)

bindings.append(int(d_output))

# 创建流以异步执行内核

stream = cuda.Stream()

# 执行推理

input_data = np.random.random(size=input_shape).astype(np.float32)

cuda.memcpy_htod_async(d_input, input_data, stream)

context.execute_async_v2(bindings=bindings, stream_handle=stream.handle)

cuda.memcpy_dtoh_async(output_data, d_output, stream)

stream.synchronize()

# 结果处理

output_data = np.frombuffer(output_data, dtype=np.float32)

print(output_data)

```

#### 4.3.2 语音识别与处理实例

语音识别是另一个深度学习可以大显身手的领域。Jetson Nano可以运行诸如Google的TensorFlow Lite或Mozilla的DeepSpeech等开源语音识别库。

例如,使用DeepSpeech模型进行语音识别时,需要将录制的语音数据预处理后送入模型进行推理。根据推理结果,Jetson Nano可以进一步处理文本数据,执行如语音控制指令等后续操作。

下面的代码块展示了如何使用DeepSpeech Python库进行语音识别:

```python

import deepspeech

import io

# 初始化模型

model = deepspeech.Model('output_graph.pbmm')

# 使用DeepSpeech进行推理

with io.open('audio.wav', 'rb') as audio_file:

audio = audio_file.read()

# 将字节数据转换为DeepSpeech期望的格式

spectrogram = model.stft(audio)

# 执行推理并获取识别结果

text = model.speech_to_text(spectrogram)

print(text)

```

以上两个实例说明了Jetson Nano在深度学习不同应用领域的灵活性和有效性,从视觉到听觉数据处理,它提供了实用的平台以实现从原型到产品的转化。

# 5. Ubuntu on Jetson Nano 高级功能拓展

随着技术的发展,Jetson Nano不仅仅停留在基础的学习和开发,还可以在更多领域发光发热。本章节将探讨Jetson Nano在更高级功能拓展方面的应用,特别是面向特定领域的硬件集成和软件框架应用。

## 5.1 自动驾驶与机器人技术

### 5.1.1 传感器集成与数据处理

自动驾驶和机器人技术的实现需要集成多种传感器,如摄像头、雷达、激光雷达(LiDAR)等,获取环境数据。Jetson Nano凭借其出色的GPIO、I2C、SPI以及UART接口,可以方便地与这些传感器连接。

在数据处理方面,Jetson Nano拥有GPU、DLA(Deep Learning Accelerator)和ISP(Image Signal Processor),使得它能够高效处理图像和传感器数据。使用TensorRT等工具可以进一步优化推理性能,从而实现实时数据处理。

```python

import jetson.inference

import jetson嗓音识别

# 假设sensor_data是从传感器获取的图像数据

sensor_data = jetson嗓音识别.getSensorData()

# 使用TensorRT优化的模型进行图像处理

net = jetson.inference.loadTensorRTModel("my-model.trt")

detections = net.ProcessImage(sensor_data)

# 处理推理结果

for detection in detections:

print(detection)

```

在上述代码中,我们展示了如何加载一个优化后的模型,并处理来自传感器的数据。

### 5.1.2 实时操作系统ROS的应用

机器人操作系统(ROS)是机器人技术领域中广泛采用的标准软件平台。Jetson Nano能够运行ROS,并且可以配合ROS使用各种驱动程序和算法。

由于ROS的包非常丰富,开发者可以使用现有的ROS包或者为Jetson Nano创建自定义的ROS包,以实现特定的机器人功能。

## 5.2 多媒体处理与流媒体服务

### 5.2.1 高效能视频编解码实践

Jetson Nano可以处理高性能的视频编解码任务。利用其强大的GPU,我们可以使用如FFmpeg这样的工具来压缩和解压视频流,实现高效视频处理。

下面是一个使用FFmpeg工具编解码视频流的示例:

```bash

ffmpeg -i input.mp4 -c:v h264_nvenc -preset fast output.mp4

```

在这个命令中,我们使用了NVIDIA的硬件编码器(h264_nvenc)来进行视频压缩,并设置了快速预设(fast),以在不牺牲太多质量的前提下获得更快的处理速度。

### 5.2.2 构建流媒体服务器与客户端

为了实现远程视频监控和视频流广播,我们需要构建流媒体服务器和客户端。Jetson Nano可以运行一个轻量级的流媒体服务器,比如使用Nginx配合RTMP模块来实现。

一个典型的配置文件`nginx.conf`示例如下:

```nginx

http {

server {

listen 80;

location /live/ {

rtmp {

server 127.0.0.1 live;

publish_notify on;

}

}

}

}

```

上述配置文件中定义了一个RTMP服务器,用于视频流的广播。

## 5.3 创新应用与开发者社区

### 5.3.1 探索Jetson Nano的创新应用案例

Jetson Nano已经在多个领域展示了其创新应用的可能性。例如,在农业自动化、环境监测、教育学习平台、甚至是个人电子项目中都有应用。社区中不断有开发者分享他们的项目和使用经验,推动了Jetson Nano的多样化应用。

### 5.3.2 加入开发者社区与资源分享

开发者社区是推动Jetson Nano生态系统发展的重要力量。在NVIDIA官方论坛、GitHub以及其他相关社区中,开发者可以分享自己的项目、问题和解决方案。NVIDIA定期也会举办相关的网络研讨会和活动,提供更多学习与交流的机会。

以上章节深入探讨了在Ubuntu on Jetson Nano环境下的高级功能拓展,包括自动驾驶与机器人技术、多媒体处理以及创新应用案例等方面。通过这些内容,我们可以看到Jetson Nano不仅仅是一个简单的开发板,它已经发展成为了一个强大、灵活且极具潜力的计算平台。

# 6. 故障排除与系统维护

在使用Ubuntu on Jetson Nano进行开发和部署过程中,系统故障是不可避免的问题之一。有效识别和解决故障对于确保系统的稳定性和安全性至关重要。同时,对于系统的长期运行来说,安全加固和数据保护也是不可忽视的环节。本章将介绍系统故障诊断与解决方法、安全性加固与数据保护策略,以及长期维护与升级规划。

## 6.1 系统故障诊断与解决

故障诊断是发现并解决问题的过程。对于Jetson Nano来说,常见的故障可能包括系统无法启动、性能问题或者软件应用异常。

### 6.1.1 常见故障及排查方法

**系统无法启动**:如果遇到系统无法启动的情况,首先检查电源连接是否稳固,包括USB-C电源适配器和Jetson Nano板卡上的连接。接着,使用Jetson Nano的指示灯状态进行故障诊断,例如红色LED亮起可能指示内存问题,绿色LED闪烁可能表示系统正在尝试从某个设备启动。

**性能问题**:性能下降可能是由于系统资源过度使用。检查系统资源使用情况可以通过命令行工具如`htop`或`top`。确认是否有进程消耗异常多的CPU或内存资源。

**软件应用异常**:软件应用异常可能与应用安装或配置有关。检查应用日志文件,如`/var/log/syslog`或`/var/log/jetson_stats.log`,可提供错误信息和线索。

### 6.1.2 系统更新与升级最佳实践

系统更新与升级是维护系统稳定性和安全性的重要手段。对于Jetson Nano,可以通过以下步骤进行系统更新和升级:

1. 打开终端,执行以下命令以更新系统包列表:

```bash

sudo apt update

```

2. 安装可用的更新:

```bash

sudo apt upgrade

```

3. 对于重要系统升级,如内核升级,建议查看NVIDIA官方论坛或Jetson Nano开发者社区,以了解兼容性和潜在问题。

## 6.2 安全性加固与数据保护

安全性加固是保护系统不受攻击的重要措施。数据保护确保系统故障时数据的完整性。

### 6.2.1 系统安全设置与策略

- **使用防火墙**:确保启用了防火墙,如使用`ufw`配置防火墙规则来限制未授权访问。

```bash

sudo ufw enable

sudo ufw allow ssh

```

- **配置SSH安全**:更改默认的SSH端口,使用密钥对进行认证,并禁用密码认证。

```bash

sudo nano /etc/ssh/sshd_config

```

- **权限和所有权管理**:确保系统文件和目录的权限正确设置,避免权限过高或过低造成的安全隐患。

### 6.2.2 数据备份与恢复方案

- **定期备份**:使用`rsync`或`tar`工具定期备份重要数据。

```bash

tar -czvf backup-$(date +%Y%m%d).tar.gz /path/to/directory

```

- **故障恢复**:通过备份文件恢复数据,确保备份与恢复流程能够顺畅进行。

## 6.3 长期维护与升级规划

长期维护对于确保系统长期稳定运行非常关键。适当的规划能够避免因过时的硬件或软件而影响项目的进度。

### 6.3.1 长期运行的系统维护计划

- **监控系统健康**:定期检查系统日志和硬件状态,预防性维护。

- **评估系统升级**:根据新的系统更新和性能提升进行定期评估和升级。

### 6.3.2 规划硬件和软件的未来升级路径

- **硬件升级**:考虑存储和内存扩展的可能性,以及必要的硬件兼容性检查。

- **软件生态适应性**:随着技术的发展,评估现有的软件是否需要迁移或重写以适应新的技术标准。

通过遵循上述故障排除、安全性加固和长期维护的策略,Ubuntu on Jetson Nano的使用者可以保持系统的健康、安全并延长其使用寿命。

0

0