R语言lme包解决方案:克服模型过度拟合的方法(模型优化指南)

发布时间: 2024-11-06 02:26:21 阅读量: 50 订阅数: 24

# 1. R语言中的lme包概述和过度拟合问题

R语言作为数据科学和统计分析的重要工具,提供了多种高级功能包来处理复杂的数据结构。其中,`lme`包是用于拟合线性混合效应模型(Linear Mixed-effects Models)的专用工具。在这一章节,我们将对`lme`包进行基础的介绍,并着重探讨过度拟合问题及其在混合模型中的潜在表现。过度拟合是一个模型学习过头,与训练数据过于吻合,从而导致泛化能力下降的现象。我们将阐明过度拟合在`lme`模型中的表现,以及它对模型预测性能的影响。通过这章的学习,读者应能够理解过度拟合的含义并识别出在`lme`模型中可能出现的问题。这为后续章节中讨论如何通过数据预处理、模型优化策略以及交叉验证来解决过度拟合打下基础。

# 2. 理解过度拟合及其在lme模型中的表现

### 2.1 过度拟合的基本概念

#### 2.1.1 定义和产生的原因

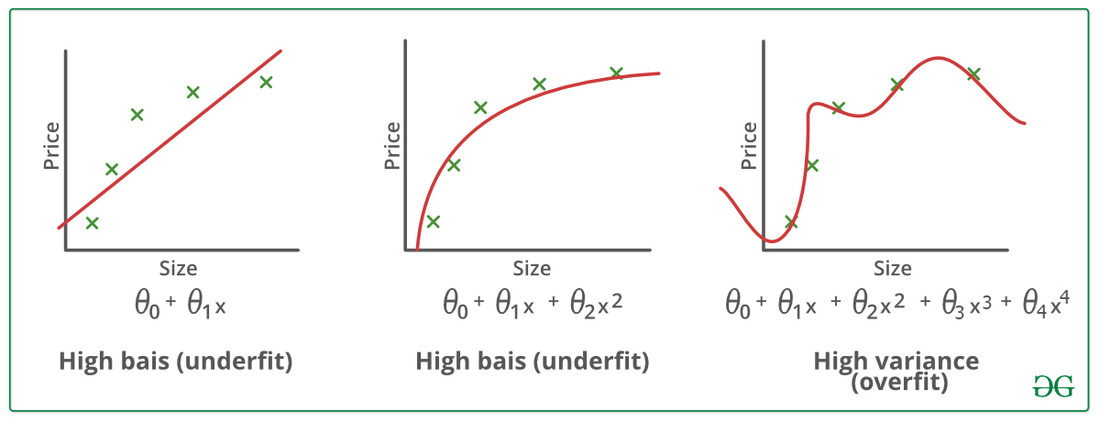

在统计学和机器学习领域,过度拟合(Overfitting)是指一个模型在训练数据上的预测表现非常好,但在未知数据上的表现却大幅下降。它发生的原因多种多样,往往涉及到模型过于复杂,以至于它开始学习训练数据中的噪声和异常值,而不是数据的真实潜在规律。一个过度拟合的模型对于新数据的泛化能力差,预测的准确性就会下降。

过度拟合产生的主要原因通常包括:

- 模型复杂度过高:模型的参数过多,能够捕捉数据的每一个细节,包括噪音。

- 训练数据量不足:当数据不足以支撑模型复杂度时,模型易于记忆而非学习数据规律。

- 过度训练:在没有适当的停止条件或验证集的情况下,让模型训练的时间过长。

#### 2.1.2 过度拟合对模型性能的影响

过度拟合对模型性能的影响是灾难性的,尤其是在需要模型对未知数据做出准确预测的情况下。模型在训练数据上的表现可能会达到一个不切实际的高水平,这通常表现为训练误差远低于验证误差。由于模型依赖于训练数据的特殊性质,它无法很好地处理新样本,导致在实际应用中的性能下降。这不仅损害了模型的实用性,还可能误导决策者依赖于模型的错误判断。

### 2.2 lme模型的原理和结构

#### 2.2.1 线性混合效应模型(lme)简介

lme模型,全称为线性混合效应模型(Linear Mixed-effects Models),是处理具有分层或群组结构数据的一种统计模型。这类数据通常在生物统计、经济学、心理学和社会科学等领域中出现,特点是存在分层或者相关性,每个层级或群组可以有自己的截距和斜率。lme模型能够很好地估计固定效应和随机效应的参数,是这些领域内常用的一种分析方法。

lme模型的核心在于其混合效应部分,它允许对数据中的组内相关性进行建模,比如个体测量的重复性或层级数据结构中的依赖性。这通过将模型的参数定义为固定效应和随机效应的组合来实现。固定效应对所有个体或组都是相同的,而随机效应则允许不同个体或组之间存在差异。

#### 2.2.2 lme模型的参数估计和假设检验

lme模型的参数估计通常使用最大似然估计(MLE)或限制最大似然估计(REML)。这些方法可以提供一致且渐近有效的估计量。而假设检验则通常通过似然比检验(Likelihood Ratio Test, LRT)或卡方分布近似来进行。这些检验用于确定固定效应和随机效应的统计显著性。

值得注意的是,lme模型的参数估计和假设检验比传统的线性回归模型更为复杂,因为涉及到随机效应的方差和协方差结构。在实际应用中,通常需要借助专门的统计软件包,例如在R语言中的lme4包,来进行这些复杂的统计运算。

### 2.3 过度拟合在lme模型中的识别

#### 2.3.1 过度拟合的识别方法

在lme模型中识别过度拟合,我们通常需要关注模型的预测误差和复杂度。识别过度拟合的方法包括:

- 利用训练集和验证集的误差比较:如果模型在训练集上的误差远小于验证集的误差,可能存在过度拟合。

- 简化模型结构:在保持模型预测准确性的同时,简化模型结构,检查预测误差是否有显著变化。

- 交叉验证:使用k折交叉验证可以有效评估模型的泛化能力,过度拟合的模型在交叉验证中的表现通常不如简单模型稳定。

#### 2.3.2 实际案例分析:lme模型的过度拟合诊断

在实际案例中,过度拟合的诊断可以通过以下步骤进行:

1. 数据分割:将数据集分为训练集和测试集。

2. 模型构建:在训练集上构建lme模型。

3. 模型评估:在测试集上评估模型性能,记录预测误差。

4. 模型简化:对模型结构进行调整,去除不必要的随机效应或固定效应,重复步骤2和3。

5. 结果比较:比较不同模型的预测误差,并分析模型复杂度和误差之间的关系。

通过这样的案例分析,我们不仅能够识别出过度拟合的问题,还能找到最佳的模型复杂度,从而保证模型在未知数据上的表现。实际案例的详细步骤和操作会在后续章节中介绍。

# 3. lme模型优化策略

在前一章节中,我们已经深入探讨了lme模型的过度拟合问题以及其表现。为了提升模型的泛化能力,本章将着重介绍如何通过不同的优化策略来调整和改善lme模型,以达到更好的预测效果。

## 3.1 数据预处理对过度拟合的影响

数据是机器学习模型训练的基石。通过优化数据预处理阶段,我们可以极大地改善模型性能,并降低过度拟合的风险。

### 3.1.1 数据清洗和特征选择技巧

数据清洗是数据预处理的重要环节。在这一阶段,我们要移除噪声和异常值,填充缺失值,以及纠正数据格式错误。通过这样的处理,数据集将变得更为整洁,模型训练过程也会更加稳定。

```r

# 示例:数据清洗和特征选择的R代码片段

# 假设有一个名为data的数据框,其中包含了需要清洗的数据集

data <- read.csv("data.csv") # 读取数据

# 填充缺失值

data$column_name[is.na(data$column_name)] <- median(data$column_name, na.rm = TRUE)

# 删除异常值(这里使用了简单的3倍标准差法则)

data <- data[abs(scale(data$column_name)) < 3, ]

# 特征选择可以使用一些统计测试或模型选择方法

# 这里我们用基于卡方检验的特征选择作为例子

selected_features <- names(data[sapply(data, function(col) chisq.test(col, data$response)$p.value < 0.05)])

filtered_data <- data[, selected_features]

```

在以上代码中,我们完成了数据清洗的几个基本步骤,并进行了特征选择。代码逻辑清晰,并对数据集进行了一系列的预处理操作。

### 3.1.2 缺失数据处理和异常值管理

在处理缺失数据和异常值时,数据科学家们有多种策略可以选择。简单的策略如删除含有缺失值的记录或用平均值、中位数填充。对于异常值的处理,可以采用基于统计的方法,如Z得分和IQR方法来识别和处理异常值。

```r

# 示例:异常值处理的R代码片段

# 异常值检测 - 使用IQR方法

Q1 <- quantile(data$column_name, 0.25)

Q3 <- quantile(data$column_name, 0.75)

IQR <- Q3 - Q1

# 确定异常值的上下界

lower_bound <- Q1 - 1.5 * IQR

upper_bound <- Q3 + 1.5 * IQR

# 标记异常值

data$anomaly <- ifelse(data$column_name < lower_bound | data$column_name > upper_bound, TRUE, FALSE)

# 可以选择删除或替换这些异常值

data_cleaned <- data[!data$anomaly, ] # 删除异常值

# 或者替换异常值为平均值

data$column_name[data$anomaly] <- mean(data$column_name, na.rm = TRUE)

```

通过代码块的逻辑分析,我们了解了如何在R中通过IQR方法检测和处理异常值,为模型训练提供了更为可靠的数据基础。

## 3.2 正则化方法在lme模型中的应用

正则化是一种常见的防止过度拟合的方法,它通过向模型的损失函数添加一个罚项来实现。

0

0