【大数据与pickle】:揭秘处理大规模数据集的策略,提升数据处理能力

发布时间: 2024-10-09 10:39:39 阅读量: 49 订阅数: 33

HTTPS 隧道预测分析数据集 Tunneling Predictive Analysis Dataset(pickle格式)

# 1. 大数据处理的背景与挑战

随着信息技术的飞速发展,大数据已成为推动现代企业、科研机构以及政府部门决策的重要力量。大数据处理不仅涉及海量数据的存储和管理,更涵盖对这些数据的高效分析和提取有价值信息的能力。然而,在大数据时代背景下,数据处理面临前所未有的挑战。

首先,数据量的快速增长给传统存储和计算方法带来巨大压力。不仅需要高成本的硬件投入以保证足够的存储空间,还要依靠强大的计算资源以应对繁重的数据分析任务。

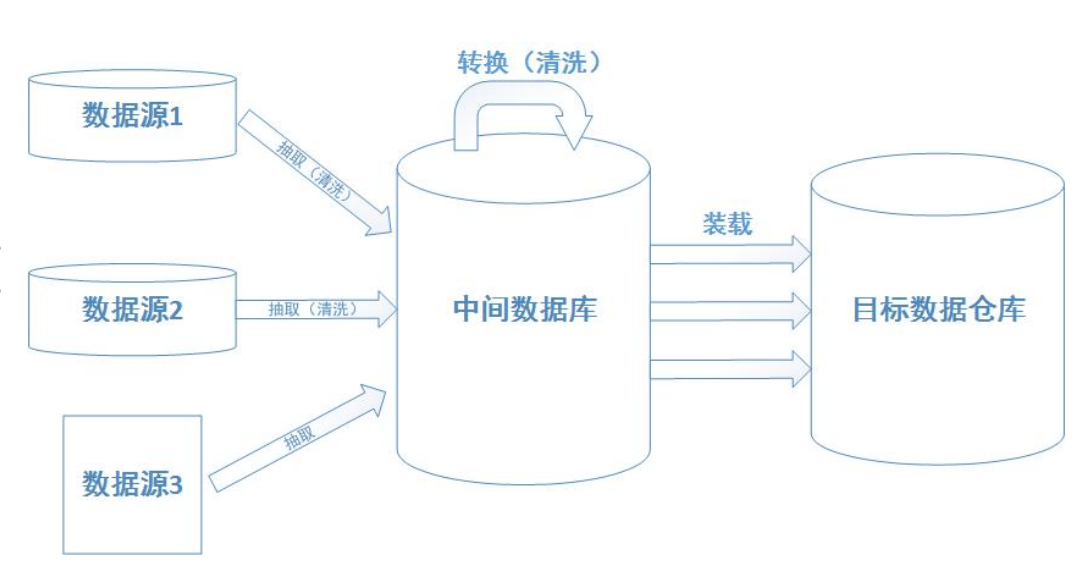

其次,数据的异构性也是一个不容忽视的问题。大数据往往来自不同的数据源,包括结构化数据、半结构化数据以及非结构化数据。如何高效地整合这些数据并进行统一的处理成为了一大难题。

最后,数据隐私和安全性问题也不容小觑。在处理涉及敏感信息的大数据时,如何在不侵犯个人隐私的前提下安全地管理和使用数据,成为了众多企业和组织必须严肃对待的问题。

在这样复杂多变的背景下,研究大数据处理技术的演进与优化,以及如何应对相关挑战,对于数据科学家和IT专业人员而言,是推动行业进步的重要课题。随着数据处理技术的不断成熟,我们可以期待在数据驱动的时代创造出更多的可能性和价值。

# 2. Python pickle模块的基础知识

### 2.1 Python序列化与pickle模块概述

序列化是将数据结构或对象状态转换为可保存或传输的形式的过程。在Python中,序列化与反序列化通常用于对象持久化、网络传输、多进程通信等场景。Pickle是Python提供的一个内建模块,专门用于对象序列化与反序列化。

#### 2.1.1 序列化的重要性与应用场景

序列化的应用场景十分广泛,例如在Web开发中,将用户的会话状态存储在缓存或数据库中。在分布式系统中,服务之间的数据交换、进程间通信也需要序列化。此外,机器学习中,模型训练完成后,我们需要将模型持久化以便后续使用。Python的pickle模块能够将复杂的数据结构,如列表、字典、集合、自定义对象等,转换为字节流(bytes),便于存储和传输。

```python

import pickle

# 序列化示例

data = {'key': 'value', 'list': [1, 2, 3]}

serialized_data = pickle.dumps(data) # 将字典序列化为bytes

# 反序列化示例

deserialized_data = pickle.loads(serialized_data) # 将bytes反序列化为字典

```

#### 2.1.2 pickle模块的基本使用方法

使用pickle模块进行序列化非常简单。`pickle.dumps()`方法用于将对象序列化为bytes,而`pickle.loads()`用于将bytes反序列化为原始对象。除此之外,也可以使用`pickle.dump()`和`pickle.load()`分别将对象保存到文件和从文件中读取对象。

```python

import pickle

# 将对象写入文件

with open('data.pkl', 'wb') as ***

***

* 从文件读取对象

with open('data.pkl', 'rb') as ***

***

```

### 2.2 深入pickle的数据结构与特性

#### 2.2.1 pickle支持的数据类型

Pickle模块支持几乎所有的Python基本数据类型和结构,如整数、浮点数、复数、布尔值、字符串、字节、列表、元组、字典、集合以及任何实现了序列化方法的自定义类的实例。不过,对于一些特殊的对象如文件句柄、数据库连接等,pickle无法序列化,需要进行特殊处理。

#### 2.2.2 高级特性:自定义对象的序列化与反序列化

当处理自定义对象时,需要确保对象所属类在序列化和反序列化过程中是可访问的。为此,通常需要在类中实现`__getstate__()`和`__setstate__()`方法,用以控制序列化过程中对象状态的获取和设置。

```python

class MyClass:

def __init__(self, value):

self.value = value

def __getstate__(self):

# 定义序列化时保存的属性

return {"value": self.value}

def __setstate__(self, state):

# 定义反序列化时设置的属性

self.value = state["value"]

# 使用自定义类的序列化与反序列化

obj = MyClass(123)

serialized_obj = pickle.dumps(obj)

deserialized_obj = pickle.loads(serialized_obj)

```

### 2.3 pickle模块的性能考量

#### 2.3.1 性能测试:与其他序列化模块的比较

在性能测试方面,通常将pickle与其他序列化工具如`json`、`shelve`、`json`、`MessagePack`等进行对比。测试可以涵盖序列化和反序列化的速度、数据占用的空间大小以及可处理的数据类型范围等。pickle的性能可能不是最快的,但它在易用性和语言内置支持方面具有明显优势。

#### 2.3.2 针对大数据场景的优化建议

在处理大数据时,通常推荐使用二进制格式进行数据序列化,以减少数据体积和读写时间。例如,可以使用`dill`模块,它是pickle的一个扩展,支持更广泛的Python特性,并可能在性能上有更优的表现。另外,针对大规模数据集的处理,可以考虑分块序列化,利用内存映射文件(memory-mapped file)技术,这样可以提高大文件处理的效率。

以上内容为第二章的内容。第二章整体对Python pickle模块的基础知识进行了介绍,包括了序列化的重要性与应用场景、基本使用方法、数据结构与特性的深入理解以及性能考量和优化建议。下文将继续深入探讨如何利用pickle处理大规模数据集。

# 3. 使用pickle处理大规模数据集

随着数据科学和机器学习的发展,对于大规模数据集的处理成为了日常工作的重要组成部分。Python pickle模块提供了强大的序列化和反序列化功能,使得存储和加载复杂数据结构变得轻而易举。本章将介绍如何利用pickle模块处理大规模数据集,并探讨在大数据场景下的读取、存储、预处理、并行处理和分布式存储策略。

## 3.1 大数据的读取与存储策略

大规模数据集处理的第一步是有效地读取和存储数据。这包括分块读取数据以适应有限的内存资源,并利用数据缓存机制来优化数据访问。

### 3.1.1 分块读取与批量处理

在处理大规模数据集时,分块读取(chunking)是一种常见且有效的数据处理策略。它允许我们按需读取数据的子集,从而减少内存使用并提高程序效率。下面是一个使用pickle模块按块读取数据的示例代码:

```python

import pickle

def read_large_data(file_path, chunk_size=1024):

with open(file_path, 'rb') as f:

while True:

chunk = f.read(chunk_size)

if not chunk:

break

# 在此处处理每个数据块

process_data_chunk(chunk)

# 模拟数据处理

print(chunk)

def process_data_chunk(chunk):

# 这里为数据处理逻辑

pass

# 示例:读取文件中的数据块

read_large_data('large_dataset.pickle')

```

在该代码中,我们使用了`with`语句来确保文件最终会被正确关闭。`process_data_chunk`函数代表了对数据块进行处理的地方,根据实际需求可以包含数据清洗、转换、分析等逻辑。分块读取避免了一次性将整个大数据集加载到内存中,从而降低了内存消耗。

### 3.1.2 利用pickle进行数据缓存

在数据处理过程中,为了避免重复计算,经常需要将中间结果缓存起来。pickle模块可以用于缓存数据,尤其是当数据结构较为复杂时。以下是使用pickle进行数据缓存的示例代码:

```python

import pickle

def cache_data(data, cache_file):

with open(cache_file, 'wb') as f:

pickle.dump(data, f)

def load_cached_data(cache_file):

if os.path.exists(cache_file):

```

0

0