BeautifulSoup爬虫初级故障排除指南

发布时间: 2024-04-16 09:23:20 阅读量: 84 订阅数: 36

Python 爬虫技术栈指南

# 1. 理解爬虫基本原理

网络爬虫是一种自动化程序,用于从互联网上获取信息。其工作原理包括发送请求获取网页数据,解析页面结构提取信息。在实际操作中,网络爬虫通过HTTP协议与服务器通信,根据响应状态码判断请求结果。页面的解析涉及HTML结构和CSS选择器,HTML用于展示网页内容,而CSS选择器则用于定位特定元素。深入理解网络爬虫的基本原理,对于开发高效稳定的爬虫程序至关重要。通过学习和掌握网络爬虫的工作原理,我们能够更加灵活地处理各种爬虫项目中遇到的问题,提升爬虫程序的效率和稳定性。

# 2. BeautifulSoup简介与安装

2.1 BeautifulSoup库介绍

BeautifulSoup 是一个用于解析 HTML 和 XML 文档的 Python 库,它能够方便地从网页中提取数据。使用 BeautifulSoup 可以快速定位指定标签和提取内容,是爬虫程序中常用的数据解析工具。

2.2 安装BeautifulSoup库

在安装 BeautifulSoup 库之前,确保已经安装好 Python 解释器。

- 2.2.1 使用pip安装

通过 pip 工具可以方便地安装 BeautifulSoup 库。

- 2.2.1.1 安装命令示例

下面是在命令行中使用 pip 安装 BeautifulSoup 库的示例代码:

```python

pip install beautifulsoup4

```

- 2.2.1.2 确认安装成功

安装完成后,可以在命令行中运行以下代码来确认是否安装成功:

```python

python

>>> from bs4 import BeautifulSoup

```

- 2.2.2 手动安装

如果需要手动安装 BeautifulSoup 库,可以按照以下步骤进行:

- 2.2.2.1 下载BeautifulSoup库文件

首先,从官方网站 https://pypi.org/project/beautifulsoup4/ 下载最新版本的 BeautifulSoup 库文件。

- 2.2.2.2 安装步骤

将下载的文件解压缩,在命令行中进入解压后的目录,然后运行以下命令进行安装:

```python

python setup.py install

```

通过以上安装步骤,就可以成功安装 BeautifulSoup 库,方便后续在爬虫程序中使用。

# 3. 初级故障排除技巧

3.1 网址请求问题排查

网络爬虫在爬取数据时,首要任务是发送请求获取网页内容。如果网址请求出现问题,爬虫就无法正常工作。常见的网址请求问题包括:网络连接不稳定、网址拼写错误或网站服务器故障等。要排查网址请求问题,可以使用以下方法:

- 检查网络连接是否正常

- 确认网址拼写是否准确

- 查看目标网站是否存在服务器故障

3.2 页面解析失败原因排查

页面解析是爬虫提取数据的关键步骤,若页面解析失败,爬虫将无法获取所需信息。解析失败的原因多种多样,包括选择器错误和编码问题等。针对页面解析失败,可采取以下排查方法:

- 检查CSS选择器是否准确

- 查看网页HTML结构是否符合预期

- 确认网页编码格式是否正确

3.2.1 选择器错误

选择器错误是页面解析失败的常见原因之一。通过检查选择器,可以找出问题并及时修复。在排查选择器错误时,可采取以下步骤:

- 检查CSS选择器是否与网页结构匹配

- 观察选择器是否能准确定位到目标元素

- 通过浏览器开发者工具调试选择器的有效性

```python

# 示例:利用BeautifulSoup解析网页

from bs4 import BeautifulSoup

html_doc = """

<html>

<head>

<title>示例网页</title>

</head>

<body>

<div class='content'>

<p>这是示例内容</p>

</div>

</body>

</html>

soup = BeautifulSoup(html_doc, 'html.parser')

target_element = soup.find('p') # 使用CSS选择器查找目标元素

print(target_element.text)

```

3.2.2 编码问题

另一个常见的页面解析失败原因是编码问题。网页的编码格式不正确会导致数据解析错误。为解决编码问题,可以采取以下措施:

- 确认网页的编码格式(如UTF-8、GBK等)

- 采用正确的编码处理方法,如使用decode()或encode()

- 在爬虫中设置适当的编码参数,如在请求中指定编码方式

流程图示例:

```mermaid

graph TD

A[开始] --> B{编码问题}

B -->|是| C[确认编码格式]

C --> D[使用正确编码方法处理]

B -->|否| E[调整编码参数]

```

通过以上排查方法,可以快速定位并解决初级故障,确保网络爬虫顺利获取所需数据。

# 4. 利用日志进行故障诊断

在开发和维护网络爬虫时,日志记录是非常重要的一环。通过设置合适的日志等级和输出方式,可以帮助我们及时定位并解决爬虫运行过程中的故障。

1.1 日志记录的重要性

在编写爬虫代码时,需要考虑到代码执行过程中可能会遇到各种问题,如网络请求失败、页面解析出错等。通过日志记录,我们可以详细地了解程序的执行情况,快速发现并排查问题。

1.2 设置日志等级

日志等级用于指定日志消息的优先级,区分日志的严重程度,帮助开发者快速定位问题。

- 1.2.1 日志级别选择

日志级别通常包括 DEBUG、INFO、WARNING、ERROR、CRITICAL 等不同级别,每个级别用于表示不同严重程度的问题。

- 1.2.1.1 DEBUG等级

DEBUG级别通常用于输出详细的调试信息,帮助开发者跟踪程序运行过程中的细节。

- 1.2.1.2 ERROR等级

ERROR级别用于指示发生了错误,通常表示程序遇到严重问题,可能需要开发者介入解决。

- 1.2.2 日志输出方式

我们可以将日志消息输出到不同的位置,如控制台、文件等,以便后续查看和分析日志信息。

- 1.2.2.1 控制台输出

将日志信息输出到控制台可以实时查看程序运行过程中产生的日志,方便调试和监控。

- 1.2.2.2 文件输出

将日志信息输出到文件中可以长久保存日志记录,帮助开发者在程序出现故障时进行追踪和分析。

通过合理设置日志等级和输出方式,我们可以更好地了解爬虫程序的运行情况,及时发现和解决潜在问题,确保爬取任务的顺利进行。

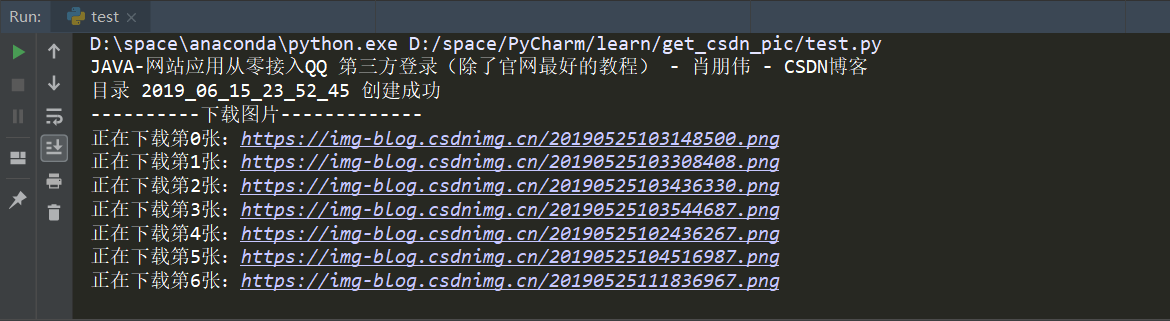

# 5. 实例演练与案例解析

在本章节中,我们将通过一个具体的爬虫实例演练以及一些常见的故障案例来帮助读者更好地理解爬虫的运行原理和可能遇到的问题解决方法。通过这些实践案例,您可以更加深入地了解如何应对不同类型的故障,从而提高爬虫程序的稳定性和效率。

#### 5.1 爬虫实例演练

在这个实例演练中,我们将以爬取一个简单网页的标题和链接为例进行说明。以下是基于Python的代码示例:

```python

import requests

from bs4 import BeautifulSoup

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 获取标题

title = soup.title.text

print("网页标题: ", title)

# 获取所有链接

links = soup.find_all('a')

for link in links:

print("链接: ", link.get('href'))

```

在这个实例中,我们首先用`requests`库发送请求获取网页内容,然后利用`BeautifulSoup`库解析网页,最后提取出网页的标题和所有链接,并输出到控制台。

#### 5.2 故障案例解析

##### 5.2.1 网页结构变化导致的问题

**问题描述:** 当爬取的网页结构发生变化时,原有的选择器无法准确定位到需要的信息。

**解决方法:**

- 更新选择器方法:通过检查新的网页结构,更新代码中的CSS选择器。

- 实时监测网页变化:定期检查目标网页的结构变化,及时调整爬虫程序。

##### 5.2.2 反爬虫机制引发的故障

**问题描述:** 网站针对爬虫程序采取了反爬虫机制,导致爬取失败或被封IP。

**解决方法:**

- 使用代理IP:通过使用代理IP来隐藏真实IP地址,避免被网站识别出是爬虫程序。

- 设置访问延时:在爬取过程中加入访问延时,模拟人类访问行为,降低被封IP的风险。

通过以上案例解析,读者可以更好地理解在实际爬虫项目中可能遇到的问题,并学会相应的解决方法,从而提升爬虫程序的稳定性和成功率。

0

0