【R语言DataTables数据报告构建】:一步到位的高级技巧指南

发布时间: 2024-11-08 17:15:30 阅读量: 36 订阅数: 20

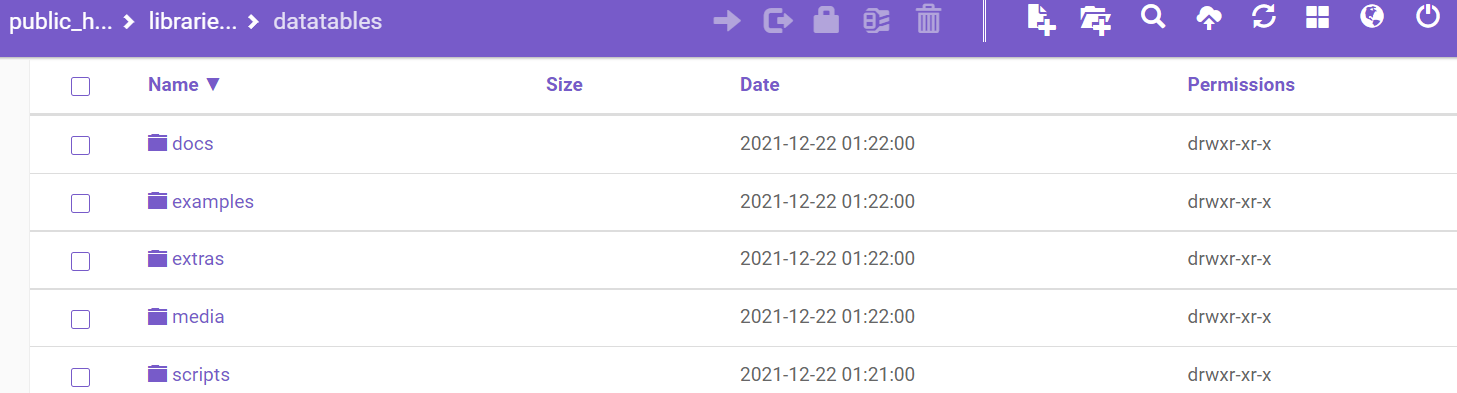

Datatables-Bootstrap3:数据表插件Bootstrap3 UI兼容性

# 1. R语言与DataTables介绍

## 1.1 R语言简介

R语言是一种专门用于统计分析和图形表示的编程语言,特别在数据科学领域中被广泛使用。它拥有强大的数据处理能力,同时拥有丰富的包和库支持,这让R语言成为了数据分析工作的重要工具。

## 1.2 DataTables的定义与功能

DataTables是一种用于R语言的数据框架扩展库,它在基础数据框(data.frame)的基础上提供了更加丰富和高效的数据操作功能。DataTables为数据分析和数据操作提供了更为高级的接口,例如更快的数据处理速度和更多种类的数据处理功能。

## 1.3 DataTables与R语言的结合

将DataTables融入R语言,可以让数据分析师和数据科学家在进行数据操作时更加得心应手。DataTables的强大数据处理能力,使得复杂的数据操作变得更加简单和高效。此外,DataTables的丰富功能也可以在R语言中发挥出更大的效用,例如在数据整理、数据可视化和数据分析等环节中提高工作效率。

# 2. DataTables的数据整合技巧

## 2.1 数据导入与预处理

### 2.1.1 读取不同类型数据源

在数据分析的起始阶段,数据的导入与预处理是至关重要的步骤。R语言提供了多种方法来读取不同类型的数据源,例如CSV、Excel、JSON、XML等。这些数据源在行业内部广泛存在,能够熟练掌握这些导入技巧对于任何数据分析师来说都是基本功。

为了读取CSV文件,`read.csv` 函数是常用的方法。这个函数能够直接将CSV文件转化为R语言中的data frame数据结构。

```r

# 导入CSV文件示例代码

data <- read.csv("path/to/your/file.csv")

```

针对Excel文件,`readxl` 包中的 `read_excel` 函数非常有用。它能够处理`.xls`和`.xlsx`格式的Excel文件,并且能够指定工作表名称或编号。

```r

# 读取Excel文件示例代码

library(readxl)

data <- read_excel("path/to/your/file.xlsx")

```

处理JSON文件,在R中可以使用`jsonlite`包的`fromJSON`函数来将JSON数据转换为R对象。

```r

# 读取JSON文件示例代码

library(jsonlite)

data <- fromJSON("path/to/your/file.json")

```

XML数据的处理稍微复杂一些,`XML`包的`xmlParse`和`xmlToDataFrame`函数可以帮助我们从复杂的XML结构中提取数据,并转换为data frame结构。

```r

# 读取XML文件示例代码

library(XML)

doc <- xmlParse("path/to/your/file.xml")

data <- xmlToDataFrame(doc)

```

### 2.1.2 数据清洗与预处理方法

数据清洗是指对原始数据进行一系列处理,以提高数据的质量和准确性。这包括处理缺失值、异常值、数据格式转换以及编码转换等。

处理缺失值常见的方法有删除含有缺失值的行或列,或用中位数、均值、众数等填充缺失值。

```r

# 删除缺失值的示例代码

complete_cases <- na.omit(data) # 删除含有NA的行

data$column[is.na(data$column)] <- mean(data$column, na.rm = TRUE) # 用均值填充列的NA

```

处理异常值则需要根据业务逻辑和统计检验来确定,如使用箱线图的方法识别异常值。

```r

# 箱线图识别异常值示例代码

boxplot.stats(data$column)$out # 返回列中可能的异常值

```

数据格式转换常常涉及到日期和时间数据的转换,这可以通过`lubridate`包来实现。

```r

# 日期时间转换示例代码

library(lubridate)

data$date <- ymd(data$date) # 将字符型日期转换为日期对象

```

此外,文本数据的清洗也不容忽视,例如可以使用正则表达式来去除空格、换行符等。

```r

# 文本数据清洗示例代码

data$text <- gsub("\n", "", data$text) # 去除文本中的换行符

data$text <- gsub(" ", "", data$text) # 去除文本中的空格

```

## 2.2 高效数据合并技术

### 2.2.1 数据框的合并与连接

在R语言中,数据的合并与连接是将来自不同数据源的数据根据一定的条件进行合并。`merge`函数可以进行基础的数据库连接操作。

```r

# 基础的合并操作示例代码

data1 <- data.frame(id = c(1, 2, 3), value = c(10, 20, 30))

data2 <- data.frame(id = c(2, 3, 4), category = c("A", "B", "C"))

merged_data <- merge(data1, data2, by = "id") # 根据id列合并

```

### 2.2.2 高级合并操作:使用data.table包

`data.table` 是R语言中一个强大的包,专门用于高效数据处理,尤其在大数据场景下。`data.table`的语法与`data.frame`略有不同,但它提供了更高效的数据合并能力。

```r

# 使用data.table合并数据示例代码

library(data.table)

DT1 <- data.table(id = c(1, 2, 3), value = c(10, 20, 30))

DT2 <- data.table(id = c(2, 3, 4), category = c("A", "B", "C"))

setkey(DT1, id)

setkey(DT2, id)

merged_DT <- DT1[DT2] # 使用data.table合并数据

```

`data.table` 在处理大规模数据集时,能够显著提高数据合并的效率。在合并操作前,合理设置key是提升合并效率的关键。

```r

# 设置key示例代码

setkey(DT1, id)

setkey(DT2, id)

```

## 2.3 数据筛选与子集创建

### 2.3.1 基于条件的数据筛选

数据筛选是数据分析中的基本操作,例如筛选满足特定条件的记录。R语言提供了丰富的数据筛选方法。

```r

# 基于条件的数据筛选示例代码

filtered_data <- data[data$value > 20, ] # 筛选value大于20的所有记录

```

### 2.3.2 创建子集的高级技术

高级筛选技术包括但不限于使用`subset`函数,利用逻辑运算符与`%in%`来筛选数据。

```r

# 创建子集示例代码

subset_data <- subset(data, value > 20 & category %in% c("A", "B")) # 同时满足多个条件的筛选

```

通过上述方法,我们能够有效地从数据集中提取有用的信息,为后续的分析和报告制作打下良好的基础。

# 3. DataTables的数据分析工具箱

## 3.1 统计分析基础

### 3.1.1 常用统计描述函数

统计分析是理解数据集的基础。在R语言中,DataTables包提供了一系列函数来执行统计描述。例如,`sum()`、`mean()`、`median()`、`sd()`(标准差)、`var()`(方差)、`min()` 和 `max()` 等基本函数可以帮助我们计算数据集中的主要统计量。

```r

# 计算数据集的统计描述

sum(dt$x) # 数据总和

mean(dt$x) # 数据平均值

median(dt$x) # 数据中位数

sd(dt$x) # 数据标准差

var(dt$x) # 数据方差

min(dt$x) # 数据最小值

max(dt$x) # 数据最大值

```

在使用上述函数时,`dt$x`代表的是DataTables对象中的某一列。这些函数对于数据探索非常有用,尤其是当处理大型数据集时。

### 3.1.2 分组统计与汇总

分组统计和汇总是数据分析中非常重要的步骤,可以帮助我们从不同的角度理解数据。DataTables中的`table()` 函数可以用来制作基本的交叉表。而`data.table`包中的`dcast()`和`melt()`函数可用于数据的重塑和汇总。

```r

# 分组统计

grouped_summary <- dt[, .(Sum = sum(x), Mean = mean(x)), by = .(GroupColumn)]

```

在上述代码中,我们按 `GroupColumn` 列对 `dt` 数据表进行分组,计算每组的 `x` 列的总和(Sum)和平均值(Mean)。`.( )` 是 `.()` 的简写,用于创建列表。`by = .(GroupColumn)` 表明我们按 `GroupColumn` 列的值进行分组。

## 3.2 数据可视化实践

### 3.2.1 制作基础图表

数据可视化是数据分析中一个不可或缺的组成部分。在R中,DataTables与`ggplot2`包的结合可以用来创建高质量的图表。

```r

# 基础图表示例:条形图

library(ggplot2)

ggplot(dt, aes(x = GroupColumn)) +

geom_bar(

```

0

0