【HDFS行存储的排序与索引】:传统方法的改进与创新,提升效率

发布时间: 2024-10-28 12:07:28 阅读量: 35 订阅数: 22

基于Lucene和HDFS的PB级数据索引、搜索、存储系统.zip

# 1. HDFS行存储的背景与挑战

## 1.1 行存储的应用背景

在大数据时代背景下,分布式文件系统(HDFS)作为存储和处理海量数据的核心技术,其行存储模式成为了重要的数据组织方式。行存储特别适合于需要频繁查询整行数据的业务场景,如金融、电信及在线分析处理(OLAP)系统。

## 1.2 行存储面临的挑战

尽管行存储具有查询速度快、事务处理能力强的优势,但它也面临着存储效率、扩展性以及数据管理等挑战。例如,在大数据环境下,高效率的排序和索引变得至关重要,但同时也带来了复杂的系统开销。

## 1.3 排序与索引的重要性

为了应对挑战并优化HDFS行存储的性能,排序与索引成为了研究的热点。通过高效的排序和索引方法,不仅可以加速数据检索过程,还可以提高整体的数据处理效率。本章将探讨HDFS行存储的背景与挑战,并为后续章节排序与索引的具体应用奠定基础。

# 2. 传统排序与索引方法在HDFS中的应用

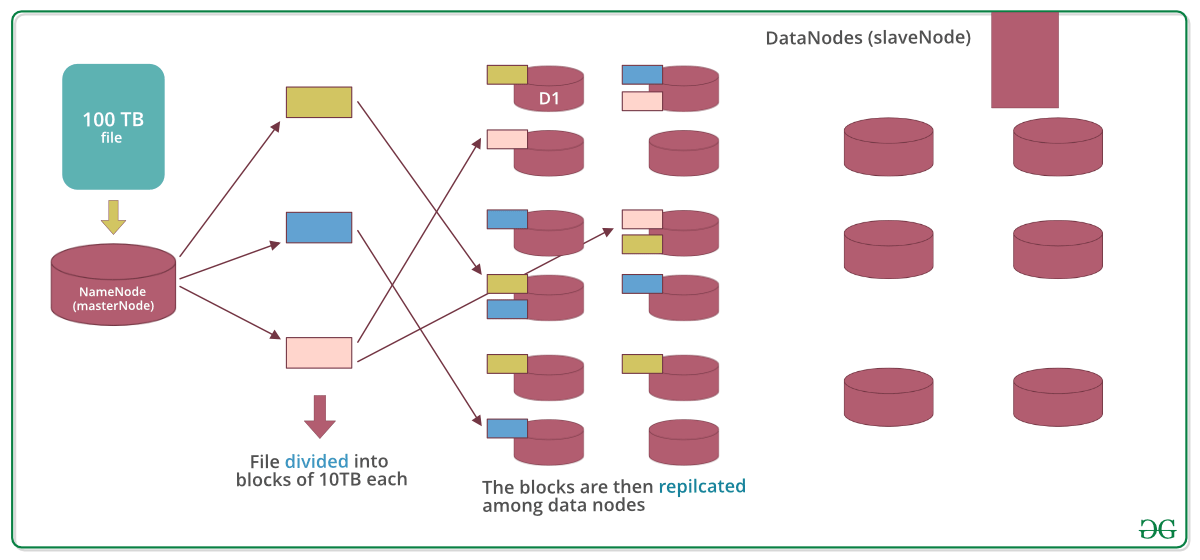

Hadoop分布式文件系统(HDFS)是大数据处理的核心组件,提供高容错性的存储解决方案。随着数据量的激增,对数据的排序和索引变得至关重要。本章节将探讨HDFS行存储的数据模型、传统排序与索引技术的实现方式以及它们如何在Hadoop生态系统中发挥作用。

## 2.1 HDFS行存储的数据模型

### 2.1.1 行存储的基本概念

HDFS中的行存储是将数据以行为单位进行存储的方式。相对于列存储,行存储更适合于不经常更新的数据集,以及对查询性能要求不是特别严格的场合。在行存储中,每条记录的所有字段值都存储在一起,这样的结构使得插入、更新和删除操作相对简单,因为这些操作通常只涉及到单条记录。

行存储的优势在于:

- 读写操作简单

- 事务处理能力较强

- 简化了数据的维护工作

但是,由于数据的垂直压缩率较低,行存储通常不适合用于数据量极大的分析型数据库,对查询性能优化的要求较高。

### 2.1.2 行存储的数据结构

在HDFS的行存储模型中,数据被存储为一系列的记录。每条记录由多个字段组成,而这些字段的集合就构成了数据表的一行。行存储的物理布局通常为连续存储,这意味着在进行数据的顺序访问时,能取得较好的性能。

HDFS的行存储数据结构需要支持以下特点:

- 有效管理存储空间

- 支持数据的快速检索

- 兼容性,能够适应多种数据访问模式

### 代码块

下面是一个简单的Java代码示例,展示如何在HDFS中创建一个文本文件,并以行为单位进行数据写入。

```java

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path path = new Path("/hdfs/path/to/output.txt");

// 使用FileSystem API创建输出流

FSDataOutputStream out = fs.create(path, new Progressable() {

public void progress() {

System.out.print(".");

}

});

// 写入多行数据

for(String line : "line1\nline2\nline3\n".split("\n")) {

out.writeBytes(line);

out.writeBytes("\n");

}

// 关闭输出流

out.close();

```

在上述代码中,我们首先设置了HDFS的配置信息,并获取了文件系统的实例。然后创建了一个输出文件,并通过循环写入了多行数据,每行数据后追加一个换行符表示结束。最后关闭输出流完成文件的写入。

## 2.2 排序技术的HDFS实现

### 2.2.1 内存排序与磁盘排序的对比

在分布式计算中,排序是数据处理不可或缺的一部分。内存排序速度快但受限于内存大小,而磁盘排序虽然速度慢,却能够处理超出内存容量的数据集。在HDFS环境下,结合磁盘和内存的混合排序方法,是常见的实践方式。

- **内存排序**:当数据集可以完全加载到内存时,内存排序(如快速排序、堆排序)效率较高。

- **磁盘排序**:通过分而治之的策略将数据分块,排序后存储到磁盘。典型的算法是外部排序。

Hadoop通过MapReduce框架提供排序实现,使用磁盘排序来处理大规模数据集。

### 2.2.2 MapReduce框架下的排序过程

MapReduce框架内部实现了排序机制,其中主要依赖于Shuffle过程。Shuffle过程包括Map阶段的排序和Reduce阶段的排序。

Map端排序:

- Map函数输出键值对

- 数据在Map端进行局部排序

- 排序后的数据被发送到Reducer

Reduce端排序:

- Reduce端接收到有序的数据流

- 进行全局排序

- 调用Reduce函数处理排序后的数据

### 代码块

```java

public static class MyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

// 分词处理

String[] words = value.toString().split("\\s+");

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

public static class MyReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

在这段代码中,我们定义了一个Mapper类和一个Reducer类。在Mapper中,我们对输入的文本数据进行分词,并将每个单词作为key,值为1输出。然后在Reducer中对相同的单词(key)进行聚合求和。MapReduce框架负责了整个过程的排序和分组工作。

## 2.3 索引技术的HDFS实现

### 2.3.1 B-tree与LSM-tree索引结构

在HDFS中处理大规模数据时,索引技术对于提高查询性能至关重要。两种常见的索引结构是B-tree和LSM-tree。

- **B-tree**:适用于频繁访问和查找的场景,因为它能够提供稳定的查询性能。

-

0

0