【Diadem数据处理全流程剖析】:数据获取到结果呈现的终极指南

发布时间: 2024-12-23 19:01:27 阅读量: 3 订阅数: 6

空客公司选择NI DIAdem平台改进风洞测试的数据处理能力.pdf

# 摘要

本文全面介绍了数据处理流程的各个方面,从数据获取到存储、分析,再到结果展示和报告。文中详细探讨了数据获取技术的理论基础和实践技巧,包括网络爬虫、APIs的使用,以及如何处理动态内容和反爬机制。在数据分析领域,本文提供了理论框架,并介绍了使用Python和R语言进行数据分析的技术,还包括大数据平台上的实践应用。数据存储章节讨论了不同数据库技术的选择、优化策略以及大数据存储解决方案。最后,文章阐述了数据结果的展示与报告的制作技巧,并强调了数据安全与合规的重要性。本文旨在为数据科学从业者提供一条清晰的数据处理路径,并关注数据生命周期中的关键技术和最佳实践。

# 关键字

数据获取;网络爬虫;数据分析;数据可视化;数据存储;数据安全

参考资源链接:[使用教程:NI DIAdem数据分析初探](https://wenku.csdn.net/doc/2f0fkd9193?spm=1055.2635.3001.10343)

# 1. 数据处理流程概述

数据处理是现代信息社会中不可或缺的一环,它包括从原始数据的获取、清洗、分析、存储、可视化到最终报告的全过程。在数据科学领域中,有效的数据处理流程能够提高数据质量,从而提升决策效率和准确性。本章将概述数据处理流程的主要环节及其重要性,为读者构建一个整体的理解框架。

数据获取是数据处理的第一步,涉及对不同来源数据的抓取和整合。而数据预处理与清洗阶段是确保数据可用性的关键步骤。没有经过清洗的数据往往包含了噪声、缺失值和异常值,这些都可能影响后续分析的准确性。在数据获取与预处理的基础上,数据分析和数据可视化使得我们能够从数据中提取信息,发现模式,并形成直观的理解。数据存储和管理保证了数据的安全、稳定和高效访问。最后,数据结果的展示与报告是整个流程的总结,它将分析结果转化为决策支持的材料。

本章内容将为接下来的章节打下基础,让我们更加深入地了解数据处理流程的每个环节,以及它们在实际应用中的具体操作和最佳实践。

# 2. 数据获取技术与实践

## 2.1 数据抓取的理论基础

### 2.1.1 网络爬虫与APIs的作用

网络爬虫(Web Crawler)和应用程序接口(APIs)是数据获取过程中的两个核心概念,它们在自动化获取公开信息方面起着至关重要的作用。网络爬虫通过模拟用户访问网页的过程来检索互联网上的信息,而APIs提供了一种更加结构化和可预测的方式来获取数据。

网络爬虫通常用于网站的数据抓取。它通过发送HTTP请求,接收网页内容,并从中提取有用的信息。这些爬虫可以针对特定网站或一组网站,对于搜索引擎索引网页内容、价格监控、内容聚合等场景尤为有用。

相比之下,APIs提供了一种更加高效和直接的数据获取方法。它们是预先定义好的接口,允许开发者通过一组规则来请求服务。使用APIs可以减少对网页结构的依赖,也更容易应对网站结构的变化,而且通常APIs会返回结构化的数据,如JSON或XML格式,这使得数据处理更为简单。

### 2.1.2 数据抓取的法律与伦理考量

尽管数据抓取在信息获取和数据分析方面提供了极大的便利,但它也伴随着法律和伦理方面的考虑。在设计和实施爬虫程序时,需要尊重网站的robots.txt文件,这是一个放置在网站根目录下的文件,用来指导爬虫如何抓取内容。

同时,数据抓取还需遵守相关法律法规,如《通用数据保护条例》(GDPR)等,确保用户隐私和数据安全。此外,过度抓取可能会对网站服务器造成负担,影响网站正常运行,因此在实践中应遵守数据使用的伦理原则和网站的使用条款。

## 2.2 数据获取实践技巧

### 2.2.1 使用Python进行网页爬取

Python作为一种高级编程语言,在数据抓取方面有着广泛的应用。借助于第三方库,如requests进行网络请求和BeautifulSoup或lxml进行HTML解析,可以方便地构建出功能强大的爬虫程序。

以下是一个简单的Python爬虫示例,展示如何抓取一个网页的标题:

```python

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求获取网页内容

response = requests.get('http://example.com')

# 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页标题

title = soup.find('title').text

print(f'网页标题是:{title}')

```

这段代码首先使用requests库获取目标网页的内容,然后用BeautifulSoup解析返回的HTML文本,最后提取并打印出`<title>`标签中的文本。

### 2.2.2 利用APIs自动化数据提取

使用APIs进行数据提取比直接爬取网页要简洁和快速,同时APIs通常返回格式化良好的数据,减少了后续处理的复杂性。以下是一个使用Python中的requests库调用REST API并打印数据的简单示例:

```python

import requests

# API URL

api_url = "https://api.example.com/data"

# 发起GET请求

response = requests.get(api_url)

# 检查响应状态码

if response.status_code == 200:

# 解析响应内容为JSON格式

data = response.json()

# 打印所需数据

print(data)

else:

print(f"请求失败,状态码:{response.status_code}")

```

在使用APIs时,需要了解API的认证方式(如API密钥、OAuth等),以及请求的参数设置。开发者文档通常会详细描述如何构建请求、可用的端点以及返回数据的格式。

### 2.2.3 处理动态加载的内容和反爬机制

动态加载的内容和反爬虫机制是现代网络爬虫面临的两大挑战。动态内容通常通过JavaScript动态生成,传统的HTTP请求无法直接获取到这些数据。对于这类问题,可以使用Selenium或Puppeteer这样的自动化工具来模拟真实浏览器行为,从而获取动态加载的数据。

反爬机制则是网站所有者用来限制爬虫访问的一种手段,可能包括请求频率限制、IP封禁等。处理这些反爬策略需要灵活运用各种代理技术、请求头伪装等技巧。

## 2.3 数据预处理与清洗

### 2.3.1 数据清洗的重要性和方法

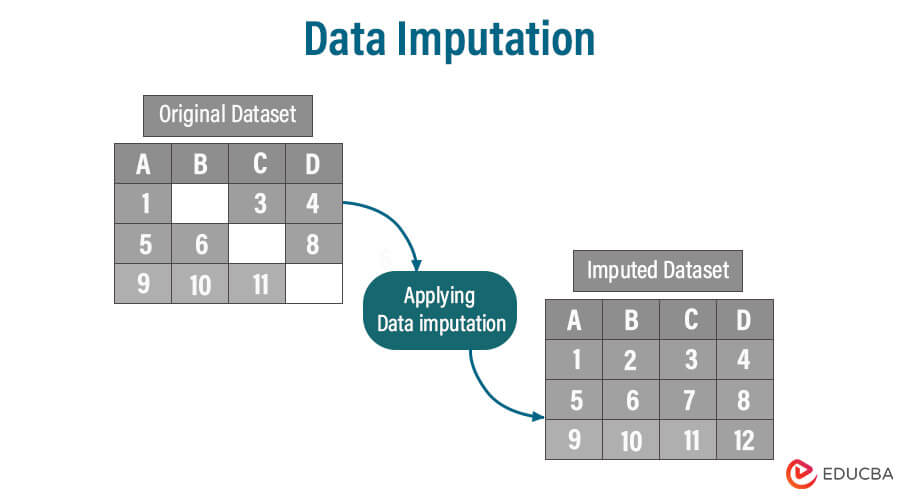

数据清洗是数据分析和数据科学领域中至关重要的一步,它涉及到识别和纠正数据集中的错误和不一致性,从而提高数据的质量。数据清洗包括处理缺失值、异常值、数据格式化、统一数据表示等多个方面。

数据清洗的重要性在于它能显著改善模型训练的质量,减少分析误差,提高结果的可信度。一个干净、准确的数据集是做出有效决策的基础。下面将介绍几种常见的数据清洗方法。

### 2.3.2 文本数据的预处理技术

文本数据在自然语言处理(NLP)和文本分析中极为常见。文本预处理包含以下步骤:

- 分词(Tokenization):将文本分割成单词或短语。

- 去除停用词(Stop Words Removal):删除无意义的常用词。

- 词干提取(Stemming)/词形还原(Lemmatization):将词汇还原到基本形式。

- 大小写转换(Case Normalization):统一字母的大小写,以减少特征空间。

Python中的NLTK库提供了这些预处理技术的实现,下面是一个简单的文本数据预处理流程:

```python

import nltk

from nltk.tokenize import word_tokenize

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

nltk.download('punkt')

nltk.download('stopwords')

nltk.download('wordnet')

text = "NLTK is a leading platform for building Python programs to work with human language data."

tokens = word_tokenize(text)

stop_words = set(stopwords.words('english'))

lemmatizer = WordNetLemmatizer()

clean_tokens = [lemmatizer.lemmatize(token).lower() for token in tokens if token.isalpha() and token.lower() not in stop_words]

print(clean_tokens)

```

### 2.3.3 图像和视频数据的预处理技术

图像和视频数据预处理通常包括调整图像尺寸、归一化、数据增强等步骤。图像数据可以通过深度学习框架(如TensorFlow或PyTorch)进行预处理,以便用于机器学习模型。图像预处理的核心在于转换数据格式使其适合输入到神经网络中。

下面是一个使用Pillow库进行图像预处理的例子,展示了如何读取图像文件、调整尺寸,并转换为神经网络输入所需的格式:

```python

from PIL import Image

import numpy as np

# 打开图像文件

image = Image.open('example.jpg')

# 调整图像尺寸

image = image.resize((224, 224))

# 转换为数组形式

image_array = np.array(image)

# 归一化像素值

image_array = image_array / 255.0

# 图像预处理完成,可以用于模型训练

```

接下来,数据的预处理与清洗技术将继续在下一章节中进行深入探讨,这将帮助我们更好地理解和应用数据预处理与清洗的方法。

0

0