Hadoop数据块同步挑战:保持数据一致性的解决方案

发布时间: 2024-10-30 03:46:18 阅读量: 51 订阅数: 27

carsim,simulink联合仿真,自动驾驶基于mpc自定义期望速度跟踪控制,可以在外部自定义期望速度传入sfunction函数,设置了两个不同状态方程,控制量为加速度,加速度变化量提供进行对比

# 1. Hadoop数据块同步概述

在现代数据密集型应用中,Hadoop已经成为处理大数据的关键技术之一。数据块同步作为Hadoop分布式文件系统(HDFS)的核心功能,确保了数据的高可用性和容错性。在本章中,我们将概述Hadoop数据块同步的必要性和基本原理,为读者提供一个关于数据块同步的初步认识。

## 1.1 Hadoop数据块同步的需求

Hadoop设计之初就考虑到了大数据存储的可靠性和高效性。数据块同步机制允许Hadoop通过在不同的节点上复制数据块来分散存储风险,提供系统冗余。在节点故障时,系统能够自动从其他节点恢复数据,保障数据不丢失,确保了整个分布式存储系统的鲁棒性。

## 1.2 数据块同步的基本概念

在Hadoop中,数据块是文件系统存储的基本单位。为了实现高效和可靠的存储,每个数据块会在不同的DataNode上复制指定数量的副本。副本数量由配置文件中的`dfs.replication`参数来指定,默认值为3。NameNode负责管理整个文件系统的元数据和数据块的位置信息,而DataNode则实际存储数据块。数据块同步是HDFS在数据写入和读取过程中,确保数据副本之间一致性的机制。

## 1.3 本章小结

综上所述,Hadoop数据块同步是为了应对分布式系统中数据管理的复杂性而设计的关键机制。通过对数据块的智能复制和管理,Hadoop不仅保证了数据的可靠性,也极大地提高了数据的可用性和访问性能。接下来的章节将深入探讨数据一致性基础理论,以及Hadoop内部如何实现高效的数据块同步。

# 2. 数据一致性基础理论

数据一致性是分布式计算系统中的核心问题之一,它确保了系统中所有节点的数据状态保持一致,从而保证了数据的准确性和可靠性。在分布式系统中,尤其是在像Hadoop这样的大规模存储系统中,数据一致性是保证数据块同步和数据完整性的基础。本章将从数据一致性的定义和重要性入手,深入探讨一致性模型的分类,以及在Hadoop中实现数据块同步的机制。

### 2.1 数据一致性的定义和重要性

#### 2.1.1 一致性模型的分类

在分布式系统中,一致性模型定义了系统在发生更新操作后,数据副本之间所要达到的同步状态。一致性的模型可以大致分为以下几类:

- **强一致性(Strong Consistency)**:系统中的所有操作都是原子的,一旦一个更新操作完成,那么系统中的所有后续操作都将看到这个更新。

- **弱一致性(Weak Consistency)**:系统对于操作的同步没有严格要求,只保证在一段时间后数据副本之间会达到一致状态。

- **最终一致性(Eventual Consistency)**:在没有新的更新操作发生的情况下,最终所有的数据副本都将同步。

- **因果一致性(Causal Consistency)**:只有具有因果关系的更新才会在数据副本之间按顺序同步。

#### 2.1.2 一致性与系统性能的权衡

在实现一致性模型时,系统通常需要在一致性保证和性能之间做出权衡。强一致性往往需要复杂的同步协议,可能会导致较高的延迟和较低的吞吐量。而弱一致性或最终一致性则可以提供更高的性能和更好的扩展性,但可能会牺牲一定程度的可用性。

### 2.2 Hadoop中的数据块同步机制

#### 2.2.1 HDFS的数据块复制机制

Hadoop分布式文件系统(HDFS)中的数据块复制机制是保证数据一致性的核心。HDFS将大文件分割成固定大小的数据块,默认大小为128MB,并将每个数据块复制三份(默认情况下)存储在不同的DataNode上。这种冗余存储策略提供了容错能力,确保了数据的可靠性。

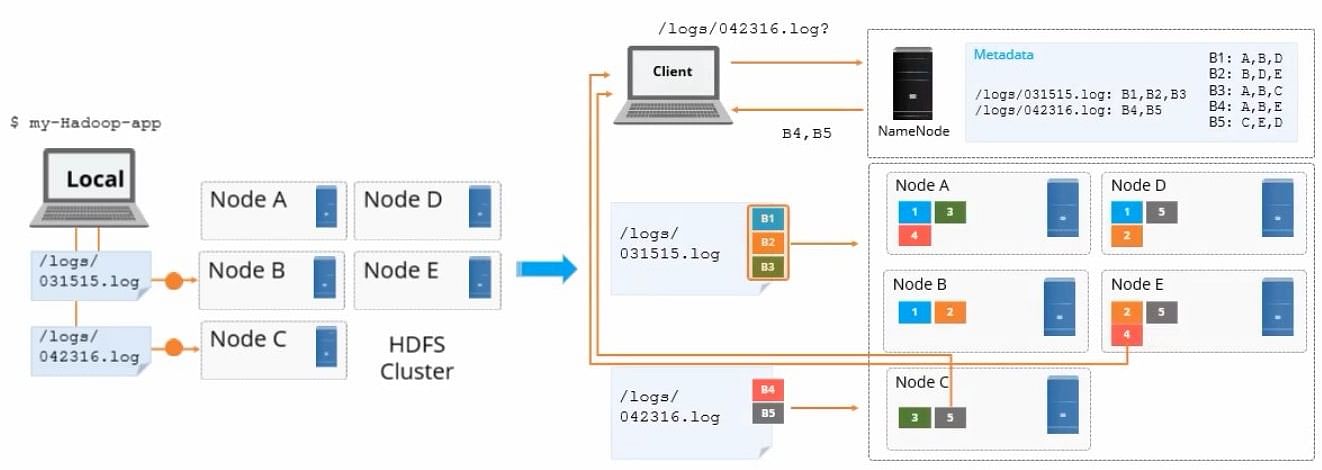

#### 2.2.2 NameNode与DataNode的交互

HDFS中的NameNode是中心节点,负责维护文件系统的命名空间,以及管理数据块到DataNode的映射信息。DataNode则负责存储实际的数据块。当客户端需要读写数据时,NameNode负责将数据块的位置信息返回给客户端,客户端直接与相应的DataNode交互。

#### 2.2.3 副本放置策略和同步流程

HDFS的副本放置策略遵循一定的规则,例如第一份副本放置在提交数据的应用所在的节点上,第二份副本放置在与第一份副本不同机架的节点上,以此类推。这种策略旨在平衡数据的可靠性与机架故障带来的风险。同步流程涉及数据块的复制和数据完整性校验,确保所有副本的数据一致性。

### 2.3 深入理解副本同步流程

为了深入理解Hadoop中的数据块同步流程,以下是一个简化的流程图,描述了副本同步的基本步骤:

```mermaid

graph LR

A[客户端写入数据] --> B[NameNode生成唯一的数据块ID]

B --> C[NameNode选择DataNode放置数据块]

C --> D[客户端与DataNode建立连接]

D --> E[数据块写入DataNode]

E --> F[DataNode之间开始复制数据块]

F --> G[副本同步完成后,NameNode更新元数据]

```

该流程图展示了一个数据块从客户端写入开始,到最终副本同步完成并由NameNode更新元数据的整个过程。数据块的复制是异步进行的,以减少对客户端操作性能的影响。而副本同步的完成保证了数据的一致性和可靠性。

### 2.4 代码实现与逻辑分析

在Hadoop中,数据块的同步和复制是通过一系列内部机制和网络协议实现的。下面是一个简化的代码示例,展示了客户端写入数据到HDFS的过程:

```java

// HDFS客户端API示例

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

FSDataOutputStream out = fs.create(new Path("/user/hadoop/file.txt"));

out.write("Data to be synchronized".getBytes());

out.close();

```

上述代码片段中,`FileSystem.create`方法用于创建一个新文件,并返回一个输出流,客户端可以将数据写入此输出流。数据一旦写入,HDFS客户端库将负责将数据块分配给DataNode,并负责数据的同步和复制。

```mermaid

graph LR

A[客户端写入数据] --> B[NameNode生成唯一的数据块ID]

B --> C[NameNode选择DataNode放置数据块]

C --> D[客户端与DataNode建立连接]

D --> E[数据块写入DataNode]

E --> F[DataNode之间开始复制数据块]

F --> G[副本同步完成后,NameNode更新元数据]

```

同步完成后,NameNode会更新其元数据,确保对数据块的任何访问都将返回最新的、一致的数据副本。数据的写入流程涉及到了多个组件之间的交互,包括客户端、NameNode和DataNode。这一过程的实现依赖于Hadoop底层复杂的通信协议和状态管理机制,保证了数据的一致性和系统的高可用性。

以上内容只是对Hadoop数据一致性基础理论的一个概述和深入分析,后续章节将继续探讨如何在Hadoop环境中解决数据同步过程中的理论挑战和实践优化方案。

# 3. Hadoop数据

0

0