评估迁移学习模型:揭秘性能指标的正确打开方式

发布时间: 2024-09-04 06:07:43 阅读量: 82 订阅数: 64

【java毕业设计】智慧社区教育服务门户.zip

# 1. 迁移学习模型的性能评估概述

在人工智能和机器学习领域,迁移学习作为一项关键技术,已经广泛应用于图像识别、自然语言处理和推荐系统等多个领域。本章将重点概述迁移学习模型的性能评估,这是模型开发与优化过程中的一个核心环节。评估过程涉及量化模型在特定任务上的表现,它要求准确、高效并能够真实反映模型的泛化能力。我们将会探讨性能评估的理论基础,以及如何选择合适的评估指标,这些都是构建有效迁移学习模型不可或缺的一部分。为了给读者提供更深入的理解,本章还会讨论评估过程中可能遇到的常见问题和解决方案。

# 2. 迁移学习的基础理论

### 2.1 迁移学习的定义与核心概念

#### 2.1.1 迁移学习的基本定义

迁移学习是一种机器学习方法,它涉及将一个领域中的知识迁移到另一个领域。在机器学习中,通常面临数据稀缺和计算资源有限的问题。迁移学习通过迁移已有任务上的知识,加速学习过程,并提高新任务的学习效率。

在深度学习中,迁移学习主要体现为预训练模型的应用。比如,可以先在一个大数据集上训练一个深度神经网络,然后将这个网络作为一个起点,迁移到一个新的、数据较少的任务上。在这个新的任务上,可以继续训练或微调网络参数,以适应新任务的特点。

#### 2.1.2 迁移学习的类型和场景

迁移学习可以根据源任务和目标任务的关系被分类为同质迁移和异质迁移。同质迁移指的是源任务和目标任务拥有相同的输入和输出形式,比如在图像分类任务中,源任务和目标任务都是对不同类别对象的识别。异质迁移则涉及到源任务和目标任务在输入和输出上存在差异。

场景上,迁移学习广泛应用于计算机视觉、自然语言处理、语音识别等领域。例如,在医疗影像分析中,可以将一个在大规模图像数据集上训练得到的模型迁移到特定疾病图像的分类任务上,这样可以显著减少对大量标注医疗图像的需求,加速模型训练过程。

### 2.2 迁移学习的关键技术

#### 2.2.1 特征提取与转换

特征提取是迁移学习中的一个关键技术,它涉及从原始数据中提取有助于新任务学习的特征。在深度学习中,特征提取往往通过预训练的深度神经网络来实现,该网络在源任务上已经学习到了丰富的特征表示。

特征转换则是对特征进行变换,以便更好地适应新任务。常见的特征转换方法包括主成分分析(PCA)和线性判别分析(LDA)。通过特征转换,可以在保留关键信息的同时减少特征的维度,从而提高模型在新任务上的泛化能力。

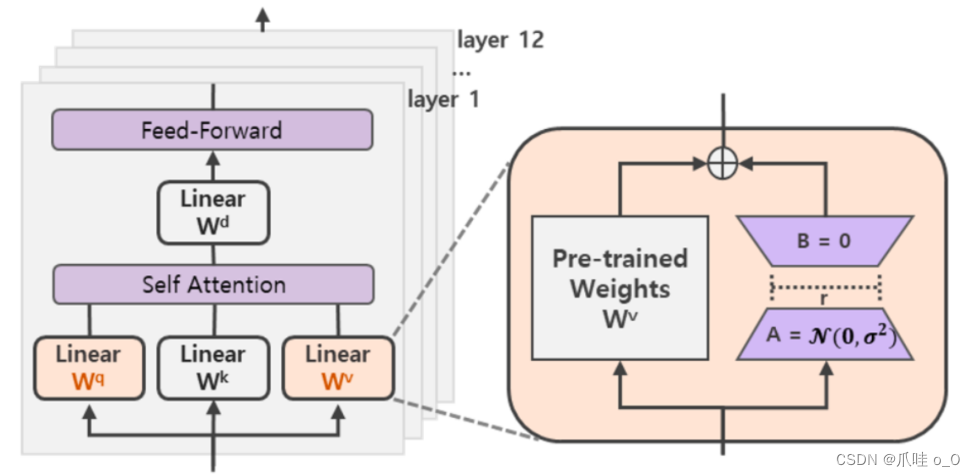

#### 2.2.2 模型微调技术

模型微调是指在迁移学习过程中,使用目标任务的少量数据来微调预训练模型的参数。这个过程中,通常会冻结预训练模型的大部分层,只训练模型的顶层或特定的几层,以适应新任务的特点。

微调过程中,学习率的选择至关重要。通常会使用较低的学习率,以防止在微调过程中破坏预训练模型学习到的有用特征。微调步骤需要仔细设计,以确保新任务的数据可以有效指导模型参数的更新。

### 2.3 迁移学习的性能评估理论

#### 2.3.1 性能评估的重要性

在迁移学习中进行性能评估非常重要,因为评估结果不仅可以用来衡量模型在新任务上的表现,还可以用来指导模型微调和特征选择的过程。性能评估可以帮助我们识别模型在哪些方面存在问题,以及如何改进模型的结构和参数。

此外,性能评估还可以帮助研究人员和工程师比较不同迁移学习策略的有效性,选择最佳的迁移学习方法。它是迁移学习研究中不可或缺的一部分,能够确保模型在面对新任务时能够达到预期的性能水平。

#### 2.3.2 评估指标的选择依据

选择合适的评估指标对于迁移学习模型的性能评估至关重要。评估指标通常需要根据任务的性质来选择。对于分类任务,常见的评估指标包括准确率、精确率、召回率以及F1分数。对于二分类任务,ROC曲线下面积(AUC)也是一个常用的评估指标。

选择指标时还需要考虑指标的鲁棒性和计算的复杂度。鲁棒性指的是指标对于数据分布变化的敏感程度,一个好的评估指标应该能够准确反映模型的性能,不受数据噪声的影响。同时,计算复杂度也是一个重要因素,尤其是在处理大规模数据时,简单的评估指标更有利于快速反馈模型性能。

### 2.4 实际案例中的性能评估应用

为了展示迁移学习在实际应用中的性能评估,考虑一个图像识别任务和一个自然语言处理任务作为案例研究。在这些案例中,将详细说明如何利用上述定义和概念来实现迁移学习,并评估其性能。

#### 2.4.1 图像识别任务的性能评估

在图像识别任务中,常用的性能评估指标是准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1分数。准确率是在所有预测标签中,正确预测的比率。精确率表示预测为正类别的样本中,实际为正类别的比率。召回率是实际为正类别的样本中,被正确预测为正类别的比率。F1分数是精确率和召回率的调和平均数,用于平衡二者之间可能存在的冲突。

为了评估模型性能,可以构建一个混淆矩阵来详细记录模型在不同类别上的预测情况。混淆矩阵展示了真实标签和预测标签之间的关系,对于分析模型性能、识别错误类型非常有用。

```python

from sklearn.metrics import confusion_matrix

import seaborn as sns

import matplotlib.pyplot as plt

# 假设 y_true 和 y_pred 分别是真实标签和模型预测的标签

y_true = [0, 1, 0, 1, 1, 1, 0, 0, 0, 1]

y_pred = [0, 1, 0, 1, 1, 0, 0, 0, 1, 0]

# 创建混淆矩阵

cm = confusion_matrix(y_true, y_pred)

# 使用热图展示混淆矩阵

sns.heatmap(cm, annot=True, fmt='d')

plt.ylabel('True Label')

plt.xlabel('Predicted Label')

plt.show()

```

通过上述代码,可以生成一个混淆矩阵的热图,这有助于直观地评估模型在每个类别上的表现。

#### 2.4.2 自然语言处理任务的性能评估

在自然语言处理(NLP)任务中,除了上述的通用指标外,有时还会使用 BLEU 分数来评估机器翻译任务的性能,以及 ROUGE 分数来评估文本摘要任务的性能。

BLEU 分数衡量机器翻译输出与一组参考翻译之间的相似度,它是n-gram的精确度与n的几何平均数的乘积。ROUGE 分数则是通过比较自动生成的摘要与人工编写的摘要之间的重叠部分来评估。

在文本分类任务中,除了上述提到的指标外,还可以使用词错误率(WER),尤其是在语音识别任务中。词错误率计算错误识别的单词数与总单词数之间的比例,能够有效衡量模型对于语音信号的处理能力。

```python

from nltk.translate.bleu_score import sentence_bleu

# 假设 reference 是参考翻译,hypothesis 是模型输出的翻译

reference = [['this', 'is', 'a', 'test']]

hypothesis = ['this', 'is', 'a', 'test']

# 计算 BLEU 分数

bleu = sentence_bleu(reference, hypothesis)

print(f"BLEU Score: {bleu}")

```

使用NLTK库中的sentence_bleu函数可以计算出BLEU分数,帮助评估模型在机器翻译任务中的性能。

总结而言,评估迁移学习模型的性能需要根据任务的特性选择合适的评估指标。对于图像识别任务,通常使用准确率、精确率、召回率和F1分数。在自然语言处理任务中,BLEU、ROUGE等指标则被广泛应用。通过这些评估指标,可以全面地了解模型在新

0

0