【同步机制深度探索】:libucrt中的互斥锁、信号量与条件变量

发布时间: 2024-12-25 18:10:37 阅读量: 4 订阅数: 8

Linux线程管理必备:解析互斥量与条件变量的详解

# 摘要

本文全面探讨了同步机制的基本概念、关键技术和应用案例。通过深入分析互斥锁、信号量和条件变量的定义、工作原理以及在libucrt中的应用,本文揭示了这些同步机制在多线程环境中的重要性,特别是在避免竞态条件、防止死锁和优化线程安全的库函数设计中的关键作用。文章还提供了针对同步机制常见问题的诊断与优化策略,以及同步性能评估的方法。通过综合案例分析,本文为开发高效、安全的并发程序提供了理论依据和实用指导。

# 关键字

同步机制;互斥锁;信号量;条件变量;线程安全;死锁预防;性能优化

参考资源链接:[解决VS无法打开ucrtd.lib等文件的错误方法](https://wenku.csdn.net/doc/5r3b713zvj?spm=1055.2635.3001.10343)

# 1. 同步机制的基本概念

在现代的多线程编程中,同步机制是维护数据一致性和保障线程间协调的关键。同步机制涉及到互斥锁、信号量、条件变量等基本元素,它们共同构建了多线程环境下程序的同步框架。本章将从基础入手,解析同步机制的核心理念和基本构成。

## 1.1 同步机制的重要性

同步机制的设立是为了避免多线程在共享资源上产生的竞争条件,确保数据的完整性。通过对访问共享资源的线程进行合理调度,同步机制可以减少不必要的数据冲突和异常,提升程序的稳定性和性能。

## 1.2 同步与异步

同步和异步是并发编程的两个基本概念。同步操作是指线程间的执行顺序相互依赖,一个线程必须等待另一个线程的操作完成才能继续执行。相对的,异步操作允许线程不等待其他线程直接继续执行,提高了程序的响应速度和吞吐量。理解这两者的区别对于构建有效的同步机制至关重要。

## 1.3 同步机制的类型

在多线程编程中,主要的同步机制包括互斥锁、信号量和条件变量。互斥锁用于保证线程对共享资源的独占访问;信号量则通过一个计数器控制多个线程对资源的访问;条件变量允许线程在某些条件不满足时进入等待状态,直到条件达成。这些机制将是我们后续章节深入探讨的重点。

# 2. 互斥锁的深入解析与应用

### 2.1 互斥锁的定义与功能

互斥锁(Mutex Lock)是一种广泛使用的同步机制,用于在多线程环境中控制对共享资源的互斥访问,防止多个线程同时操作同一资源造成数据不一致或竞态条件。

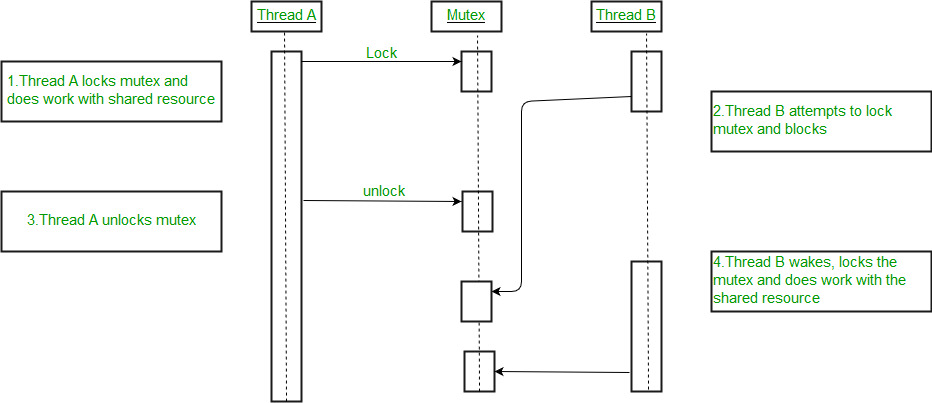

#### 2.1.1 互斥锁的工作原理

互斥锁的工作原理是通过锁的状态来控制对共享资源的访问。当一个线程获得锁时,它将锁的状态设置为“锁定”( Locked ),其他尝试获取该锁的线程将被阻塞,直到锁被释放。一旦锁被释放,操作系统将根据一定的策略(通常是最先进入等待的线程)唤醒一个等待线程,使其获得锁的控制权。

以下是互斥锁在多线程中的作用的具体细节:

- **防止数据竞争**:确保同一时间内只有一个线程可以修改数据。

- **控制并发访问**:在多个线程同时需要访问共享资源时,互斥锁可以防止资源同时被多线程访问,保证了操作的原子性。

- **保证操作的顺序性**:在某些情况下,需要保证特定的代码段按顺序执行,互斥锁可以帮助实现这一点。

```c

#include <pthread.h>

pthread_mutex_t lock; // 定义互斥锁变量

// 获取互斥锁

pthread_mutex_lock(&lock);

// 执行临界区代码...

// 释放互斥锁

pthread_mutex_unlock(&lock);

```

在上述代码块中,我们使用 `pthread_mutex_lock` 函数来获取锁,在临界区执行完毕后,使用 `pthread_mutex_unlock` 来释放锁。当线程试图对一个已经上锁的互斥锁进行上锁操作时,它会阻塞直到锁被释放。

#### 2.1.2 互斥锁在多线程中的作用

互斥锁在多线程编程中扮演着至关重要的角色,特别是在需要协调多个线程对共享资源的访问时。通过互斥锁,可以确保对共享资源的访问是串行的,从而避免了竞态条件和数据不一致的问题。

一个典型的场景是,当多个线程需要修改全局变量或者访问共享内存时,互斥锁保证了这些操作的原子性。例如,在一个银行系统的多线程环境中,如果多个线程同时执行对同一账户的存款或取款操作,互斥锁就可以保证这些操作是线程安全的。

在C++中,可以使用`std::mutex`类来实现互斥锁的功能:

```cpp

#include <mutex>

std::mutex mtx; // 创建互斥锁实例

void critical_function() {

mtx.lock(); // 上锁

// 执行临界区代码...

mtx.unlock(); // 解锁

}

```

在这个例子中,`std::mutex` 类的 `lock` 和 `unlock` 方法分别用于获取和释放锁。需要注意的是,应当确保互斥锁的正确使用,避免死锁的发生,即两个或多个线程相互等待对方释放锁,从而导致程序的无限阻塞。

### 2.2 libucrt中的互斥锁使用

libucrt 是一个虚构的或者不具体的库,因此我们将讨论一个通用的库,比如 POSIX 线程库(pthread),它为C语言提供了多线程编程的能力。我们将在此上下文中探讨互斥锁的API使用。

#### 2.2.1 libucrt互斥锁API简介

在 POSIX 线程库中,互斥锁的API非常直接和简单,主要包括以下几个函数:

- `pthread_mutex_init()`:初始化一个互斥锁。

- `pthread_mutex_destroy()`:销毁一个互斥锁。

- `pthread_mutex_lock()`:对互斥锁上锁,如果锁已经被其他线程持有,则调用线程会阻塞直到锁可用。

- `pthread_mutex_trylock()`:尝试对互斥锁上锁,如果锁已经被其他线程持有,则立即返回一个错误代码。

- `pthread_mutex_unlock()`:释放对互斥锁的控制。

在下面的代码示例中,我们将展示如何使用这些API来实现一个简单的线程安全打印函数。

#### 2.2.2 实际代码示例与分析

假设我们有一个全局字符串变量,多个线程需要访问它来打印信息:

```c

#include <stdio.h>

#include <pthread.h>

char global_str[256] = {0}; // 全局字符串变量

pthread_mutex_t str_mutex = PTHREAD_MUTEX_INITIALIZER;

void* thread_function(void* arg) {

pthread_mutex_lock(&str_mutex);

printf("Thread %ld prints: %s\n", (long)arg, global_str);

pthread_mutex_unlock(&str_mutex);

return NULL;

}

int main() {

pthread_t t1, t2;

strcpy(global_str, "Hello from main());

// 创建两个线程

pthread_create(&t1, NULL, thread_function, (void*)(long)1);

pthread_create(&t2, NULL, thread_function, (void*)(long)2);

// 等待线程结束

pthread_join(t1, NULL);

pthread_join(t2, NULL);

pthread_mutex_destroy(&str_mutex); // 销毁互斥锁

return 0;

}

```

在这段代码中,我们创建了两个线程,它们都试图打印全局字符串`global_str`的内容。通过使用互斥锁`str_mutex`,我们保证了即使两个线程同时到达打印语句,也只有一个线程能够获得锁并执行打印操作,从而避免了可能的竞态条件。

### 2.3 互斥锁的高级特性

#### 2.3.1 递归锁与普通互斥锁的对比

普通互斥锁(也称为非递归锁)不允许同一个线程多次锁定同一个互斥锁,如果尝试这么做,将会导致死锁。为了克服这一限制,递归锁允许同一线程多次锁定同一个互斥锁,前提是每次锁定都必须有一次相匹配的解锁操作。

递归锁和普通互斥锁在使用上存在差异,通常通过以下方法实现:

- 对于非递归锁,调用`pthread_mutex_lock()`的次数必须与调用`pthread_mutex_unlock()`的次数完全匹配。

- 对于递归锁,其内部通常维护一个锁定计数器,表示锁被递归锁定的次数。只要调用`pthread_mutex_unlock()`的次数与这个计数器相匹配,锁最终会被释放。

#### 2.3.2 死锁的预防与解决策略

死锁是指两个或多个线程在执行过程中因竞争资源而造成的一种僵局。互斥锁的使用不当是导致死锁的常见原因。

为了预防和解决死锁,可以采取以下策略:

- **遵守锁定顺序**:确保所有线程以相同的顺序获取多个锁。

- **尝试非阻塞锁定**:使用`pthread_mutex_trylock()`,如果锁不可用则返回错误,避免阻塞。

- **锁定时间限制**:限制线程持有锁的时间,减少锁等待的时间。

- **资源分配图分析**:使用资源分配图和等待图算法来分析和预防死锁。

下面是一个简单的死锁预防示例代码:

```c

pthread_mutex_t lock1 = PTHREAD_MUTEX_INITIALIZER;

pthread_mutex_t lock2 = PTHREAD_MUTEX_INITIALIZER;

void* thread_function(void* arg) {

pthread_mutex_lock(&lock1); // 获取第一个锁

pthread_mutex_lock(&lock2); // 获取第二个锁

// 临界区操作...

pthread_mutex_unlock(&lock2); // 释放第二个锁

pthread_mutex_unlock(&lock1); // 释放第一个锁

return NULL;

}

```

在这个例子中,我们确保了无论哪个线程先获得执行,它们都按照相同的顺序(先`lock1`后`lock2`)来获取锁,这样可以预防死锁的发生。

通过以上讨论,我们对互斥锁的概念、使用以及高级特性有了更深入的理解。互斥锁是实现线程安全操作共享资源的重要工具,但正确使用它需要对多线程编程有深刻的认识和理解。

# 3. 信号量的机制与实现

在现代操作系统中,信号量是一种广泛使用的同步机制,它能够在多个线程或进程之间控制对共享资源的访问。信号量不仅适用于控制对单个资源的访问,还能有效管理多个资源。通过使用信号量,可以避免共享资源的冲突,从而保证数据的一致性和程序的正确性。

## 3.1 信号量的基本理论

### 3.1.1 信号量的定义与分类

信号量的概念由荷兰计算机科学家Edsger Dijkstra于1965年提出,它是一个整数变量,可以用来控制对共享资源的访问。根据其不同的功能和特性,信号量可以分为以下几种:

- 二进制信号量:其值只能是0或1,用于互斥访问资源。

- 计数信号量:其值可以大于1,用于控制对一组资源的访问。

信号量的主要操作有:

- 等待(wait)操作:申请一个资源。

- 信号(signal)操作:释放一个资源。

这两个操作在信号量的值上执行减1和加1操作,并且这两个操作是原子的,即在执行过程中不会被其他线程或进程中断。

### 3.1.2 信号量的工作流程

信号量的工作流程涉及到两个基本操作:`P`(Proberen,荷兰语中的“尝试”)和`V`(Verhogen,荷兰语中的“增加”)。在不同的文献中,这两个操作可能有不同的表示方式,如`wait`和`signal`或`acquire`和`release`。这些操作具有以下特点:

- 当一个线程执行`wait`操作时,如果信号量的值大于零,线程会获取到资源,并将信号量的值减一。如果信号量的值为零,则线程会被阻塞,直到信号量的值大于零。

- 当一个线程执行

0

0