电子科技大学820真题并行编程精讲:高性能计算的关键技术

发布时间: 2024-12-17 10:23:53 阅读量: 5 订阅数: 6

电子科技大学820计算机专业基础历年考研真题汇编及部分参考答案

参考资源链接:[电子科技大学820真题1999-2019终极版.pdf](https://wenku.csdn.net/doc/6401abbecce7214c316e9574?spm=1055.2635.3001.10343)

# 1. 并行编程的概念和重要性

随着计算机硬件技术的飞速发展,多核处理器和分布式计算系统变得越来越普及,这为并行编程提供了物理基础。并行编程是指利用多核处理器的并行处理能力,将任务分解为可以同时执行的多个部分,从而显著提高计算效率和性能。在处理大数据集、运行复杂算法和执行资源密集型任务时,传统的串行编程方法往往受到性能瓶颈的限制,而并行编程则能有效突破这些限制,大幅度缩短计算时间,对于提高软件的效率和响应速度至关重要。

并行编程不仅限于高性能计算(HPC)领域,随着云计算、物联网(IoT)和人工智能(AI)的发展,许多行业开始依赖并行计算技术来解决大规模数据处理和复杂问题求解的需求。它在提高计算效率的同时,也为软件工程师和系统架构师提供了新的挑战与机遇。在此背景下,了解并行编程的核心概念和重要性,对IT专业人员来说,是提升个人技能和应对未来技术挑战的关键一步。

# 2. 并行编程的理论基础

### 2.1 并行计算的基本原理

并行计算是指利用多个计算资源同时解决计算问题的过程。与串行计算相比,它显著缩短了计算时间,提高了计算效率。了解并行计算的基本原理是深入掌握并行编程的必要前提。

#### 2.1.1 并行计算模型

在并行计算模型中,一个计算任务被划分为多个子任务,这些子任务可以并行执行。常见的并行计算模型有:

- 数据并行模型:在这种模型中,数据集被分割成多个部分,每个部分由不同的处理器处理。

- 任务并行模型:任务并行关注于分解一个程序的独立任务或函数,并让不同的处理器同时执行这些任务。

并行计算模型的选择往往依赖于具体的计算问题和硬件平台。理解这些模型对于设计高效的并行算法至关重要。

```mermaid

graph TD

A[并行计算模型] --> B[数据并行模型]

A --> C[任务并行模型]

```

#### 2.1.2 并行算法设计基础

设计一个高效的并行算法需要考虑如下几个基础要素:

1. **负载平衡**:在多处理器系统中,每个处理器的工作量应尽量均衡,避免出现瓶颈。

2. **通信开销**:由于处理器之间需要交换信息,因此需要最小化通信开销。

3. **局部性原理**:尽可能地利用处理器本地的数据,以减少对共享资源的访问。

### 2.2 并行计算机体系结构

并行计算机体系结构按照其存储模型的不同,主要可以分为多核处理器和共享内存体系结构以及分布式内存系统和消息传递体系结构。

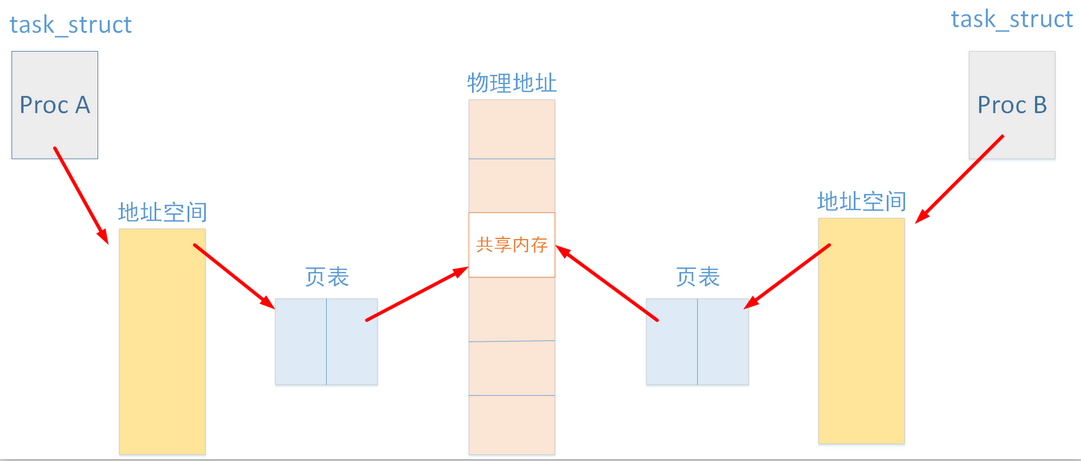

#### 2.2.1 多核处理器和共享内存

在多核处理器体系结构中,每个核心都共享一个统一的内存空间。这种结构设计简单,编程模型直观。

```markdown

| 多核处理器特点 | 共享内存模型 |

| --- | --- |

| 高度集成 | 易于编程实现 |

| 低通信延迟 | 内存一致性的挑战 |

```

#### 2.2.2 分布式内存系统和消息传递

分布式内存系统中,每个处理器拥有自己的内存空间。处理器间通信需要通过消息传递来完成。MPI(消息传递接口)是实现这一模型的典型标准。

```mermaid

graph LR

A[处理器1] -->|消息传递| B[处理器2]

A -->|消息传递| C[处理器3]

```

### 2.3 并行编程模型与范式

并行编程模型与范式为开发者提供了一组定义明确的编程概念和规则,以利用并行计算机的计算资源。

#### 2.3.1 数据并行和任务并行

- **数据并行**:将数据集分割成多个部分,每个部分由不同的处理器同时处理。OpenMP是一种广泛使用的数据并行编程模型。

- **任务并行**:将程序分解为多个任务,每个任务由不同的处理器执行。这种范式在分布式内存系统中更为常见。

#### 2.3.2 共享内存模型(OpenMP)与消息传递模型(MPI)

- **OpenMP**:它是一种用于多处理器共享内存并行计算机的API,它主要通过编译器指令、运行时库和环境变量来实现多线程并行编程。

- **MPI**:消息传递接口是针对分布式内存体系结构定义的,并行编程模型和库。MPI提供了一组函数来实现进程间的通信。

代码示例(OpenMP):

```c

#include <omp.h>

int main() {

int var1, var2;

#pragma omp parallel private(var1) reduction(+: var2)

{

var1 = 1;

var2 += var1;

}

return var2;

}

```

逻辑分析:在上述代码中,使用`#pragma omp parallel`指令创建了一个并行区域。`private(var1)`声明了变量`var1`为私有变量,每个线程拥有其副本;`reduction(+: var2)`用于声明变量`var2`是归约变量,并在并行区域结束时进行累加操作。

参数说明:`omp parallel`指令是OpenMP的指令之一,用于创建并行执行的代码块。指令中的`private`和`reduction`子句定义了线程私有数据和需要进行的操作。

通过这样的分析和代码实现,我们可以更清晰地理解如何在共享内存模型下利用OpenMP进行并行编程。

# 3. 并行编程实践技术

## 3.1 并行编程语言和工具

### 3.1.1 C/C++中的并行编程扩展

C/C++语言因其高效的性能和接近硬件的控制能力,在并行编程领域中占据着重要地位。现代C/C++标准库中引入了针对并行计算的扩展,特别是C++11及以后版本,提供了线程库(threading library)、原子操作(atomic operations)和并行算法(parallel algorithms)等特性。

```cpp

#include <iostream>

#include <thread>

#include <vector>

void printHello() {

std::cout << "Hello from thread " << std::this_thread::get_id() << '\n';

}

int main() {

std::vector<std::thread> threads;

for (int i = 0; i < 5; ++i) {

threads.emplace_back(printHello);

}

for (auto& th : threads) {

th.join();

}

return 0;

}

```

在上述代码中,我们创建了多个线程,每个线程负责打印一条消息。`std::thread` 是C++11提供的用于创建新线程的类,通过 `join` 方法可以同步线程的执行,保证主线程等待所有子线程完成后才继续执行。

### 3.1.2 Python中的并行编程库

Python因其易用性广泛应用于快速原型设计和数据分析,但它默认的单线程执行方式限制了其在并行计算中的表现。幸运的是,Python社区开发了多个并行编程库,如 `multiprocessing`、`concurrent.futures` 和 `joblib`,以支持多核CPU的充分利用。

```python

from multiprocessing import Pool

import time

def function_to_parallelize(x):

time.sleep(1)

return x*x

if __name__ == '__main__':

pool = Pool(processes=4) # 创建一个含有4个工作进程的进程池

results = [pool.apply_async(function_to_parallelize, (i,)) for i in range(10)]

output = [p.get() for p in results]

print(output)

```

在这段代码中,我们使用 `multiprocessing.Pool` 来创建一个进程池,并通过 `apply_async` 方法异步地并行执行多个函数调用。进程池允许我们管理和重用一个固定数量的进程,提高并行执行的效率。

## 3.2 并行编程中的同步机制

### 3.2.1 锁和信号量

在并行编程中,多个线程或进程可能同时访问共享资源,这会导致竞态条件和数据不一致的问题。为了解决这些问题,引入了同步机制,包括锁(Locks)、互斥锁(Mutexes)和信号量(Semaphores)等。

```c

#include <pthread.h>

#include <stdio.h>

pthread_mutex_t lock;

void* thread_function(void* arg) {

pthread_mutex_lock(&lock);

// 关键区代码

printf("Thread %ld acquired lock\n", (long)arg);

// ...

pthread_mutex_unlock(&lock);

return NULL;

}

int main() {

pthread_mutex_init(&lock, NULL);

pthread_t threads[2];

for (int i = 0; i < 2; ++i) {

pthread_create(&threads[i], NULL, thread_function, (void*)(long)i);

}

for (int i = 0; i < 2; ++i) {

pthread_join(threads[i], NULL);

}

pthread_mutex_destroy(&lock);

return 0;

}

```

在上述示例中,使用了POSIX线程库中的互斥锁(`pthread_mutex_t`)来确保在同一时间只有一个线程可以进入临界区。这是通过 `lock` 和 `unlock` 方

0

0