【Origin数据处理:最佳实践】:数据清除有效方法的实操案例分析

发布时间: 2025-01-04 16:04:20 阅读量: 31 订阅数: 12

# 摘要

数据处理是科学研究和数据分析中的关键环节,有效的数据清洗能够显著提升数据质量,保障分析结果的准确性。本文首先概述了Origin数据处理的基础理论,讨论了数据清洗的重要性、常见问题及其对数据质量的影响。随后,重点介绍了Origin软件的功能,以及在数据清洗中的具体操作技巧,如筛选、排序、转换和计算等。通过一系列实操案例,本文展现了如何利用Origin处理缺失值、异常值以及数据格式化和标准化问题。文章最后探讨了数据清洗后的质量评估方法,并通过案例研究比较了清洗前后数据的差异。此外,本文还探讨了高级数据处理技术,包括机器学习在数据清洗中的应用,以及在特定行业如生物统计学和物理实验数据处理中的应用案例。

# 关键字

数据清洗;数据质量;Origin软件;缺失值处理;异常值检测;质量评估

参考资源链接:[Origin入门:数据清除与显示范围设置教程](https://wenku.csdn.net/doc/456phsuzzi?spm=1055.2635.3001.10343)

# 1. Origin数据处理概览

## 1.1 数据处理的重要性

在IT及数据分析领域,准确、及时的数据处理是提炼有价值信息的关键。Origin软件作为一种专业图表绘制和数据分析工具,其在科学数据处理和可视化方面发挥着不可或缺的作用。

## 1.2 Origin软件的定位

Origin专为工程师和科研人员设计,它简化了复杂数据集的处理、分析和图形展示。通过Origin,用户能够进行数据导入、处理、统计分析,以及生成高质量的图形输出。

## 1.3 数据处理的流程

Origin的数据处理流程通常包含数据导入、清洗、分析、可视化等步骤。本章会为读者提供一个数据处理流程的概览,并在后续章节中深入介绍每个步骤的具体操作和技巧。

# 2. 数据清洗的理论基础

### 2.1 数据清洗的重要性

数据是现代企业决策的基础,然而,不准确或不完整数据的存在可能导致错误的结论。在这一部分,我们将深入探讨数据质量对分析的影响以及数据清洗流程的基本概念。

#### 2.1.1 数据质量对分析的影响

数据质量是数据清洗工作开始的源头。数据质量问题会直接影响到分析结果的准确性,这在数据驱动的决策中是一个关键考虑因素。数据质量低下可能会带来以下几个问题:

- **错误的洞察**:数据中的错误或异常值可能导致分析人员得出错误的结论。

- **决策失误**:基于错误的数据做出的业务决策可能会对企业造成巨大的经济损失。

- **效率损失**:数据质量问题可能使得数据处理和分析人员浪费大量时间在处理无效或错误的数据上。

- **数据仓库污染**:未清洗的数据加入到数据仓库中可能会污染整个数据库,影响未来的数据使用和分析。

#### 2.1.2 数据清洗流程概述

数据清洗流程是一个系统化的过程,它涉及一系列步骤,以识别和纠正数据集中的错误和不一致性。一个标准的数据清洗流程通常包括以下几个阶段:

1. **识别问题**:通过数据质量检查确定数据集中存在的问题类型和位置。

2. **数据清洗**:针对识别的问题,应用一系列技术如填补缺失值、删除重复记录、修正数据错误等。

3. **数据验证**:清洗后的数据需要重新验证以确保问题已经被正确处理。

4. **数据监控**:定期检查数据集,防止新的数据质量问题产生。

### 2.2 数据清洗中的常见问题

在数据清洗的过程中,我们会遇到多种多样的问题,这里将介绍几种最为常见的问题,并探讨它们的识别和处理方法。

#### 2.2.1 缺失值的处理

缺失值是在数据集中经常遇到的问题之一。处理缺失值的方法多种多样,常见的有:

- **忽略缺失值**:当数据集足够大时,可以考虑忽略那些包含缺失值的记录。

- **填充缺失值**:使用均值、中位数、众数或者基于其他变量的预测模型来填充缺失值。

- **删除记录**:如果缺失值不多,可以选择删除含有缺失值的记录。

在实际应用中,选择哪种方法取决于具体问题和数据集的特点。处理缺失值之前,需要仔细分析缺失数据的模式和原因。

#### 2.2.2 异常值的识别与处理

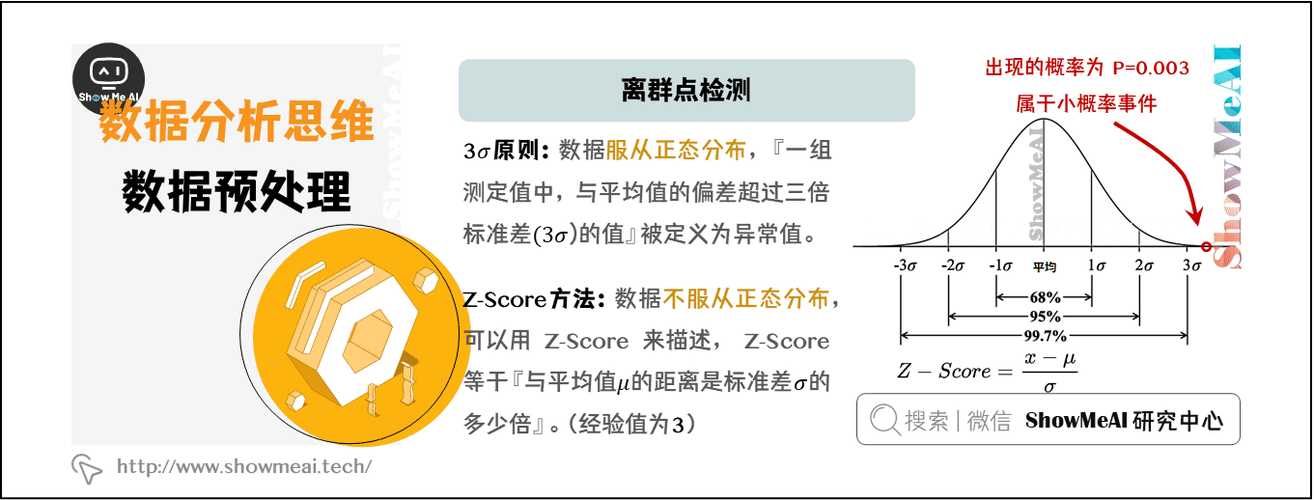

异常值是数据集中那些不符合整体数据趋势的观测值。处理异常值需要一系列的方法:

- **统计检验**:使用统计检验方法(如 Z 分数、箱线图等)来识别异常值。

- **可视化**:绘制箱线图和直方图等可以帮助直观地发现数据中的异常值。

- **异常值处理**:可以删除、修正或替换异常值,但必须谨慎处理,以免错误地移除数据中的重要信息。

#### 2.2.3 数据一致性问题

数据一致性是指数据在各个系统或报表中保持一致。数据不一致性可能源于:

- **重复记录**:相同的数据实体出现在数据集中多次。

- **格式不统一**:同一个字段的不同表示方式(如日期格式、货币单位等)。

- **编码冲突**:不同数据源使用不同的编码系统,如产品ID。

解决这些问题的策略包括:

- **数据去重**:通过软件工具或编写脚本识别并删除重复记录。

- **数据格式化**:确保数据使用统一的格式,如标准化日期和数字的显示方式。

- **建立映射关系**:创建编码映射表,将不同的编码系统统一起来。

### 2.3 小结

本章为数据清洗的理论基础,我们深入了解了数据质量的重要性,并概述了数据清洗的基本流程。此外,我们还讨论了数据清洗中常见的问题及其应对策略。通过这些方法和策略,分析人员能够确保数据集的准确性和可用性,为后续的数据分析工作奠定坚实的基础。

# 3. Origin数据处理工具介绍

## 3.1 Origin软件功能概述

### 3.1.1 Origin界面和基本操作

Origin是一款功能强大的科学图形和数据分析软件,广泛应用于科学研究领域。它拥有直观的用户界面,让数据处理和图形绘制更加高效。Origin的界面主要由菜单栏、工具栏、工作区和视图窗口构成,其中工作区是核心,用于创建和编辑图表、矩阵、工作表等。基本操作包括导入数据、创建图表、编辑图形元素、保存和输出结果等步骤。

### 3.1.2 Origin中的数据表和矩阵处理

Origin提供了强大的数据表(Worksheet)和矩阵(Matrix)处理功能。数据表是一种二维表格,可以容纳数值型和文本型数据,便于进行数据筛选、排序、统计分析等操作。矩阵处理则是专门针对图像数据或实验数据的二维数组进行分析和处理,支持诸如傅里叶变换等高级数学运算,适合处理光谱数据、图像分析等应用场景。

## 3.2 利用Origin进行数据筛选和排序

### 3.2.1 数据筛选的技巧

数据筛选是数据清洗中的重要步骤,它允许用户根据特定条件展示数据子集。在Origin中,可以通过“Data Filter”功能实现这一操作。用户可以通过设置简单的条件表达式,如“列A > 100”,来筛选出满足条件的数据。此外,Origin还支持逻辑运算符,例如AND(与)、OR(或),使筛选条件更加灵活和复杂。筛选后,可以选择“筛选

0

0