网络爬虫升级:requests库的高级用法与数据提取技巧(爬虫进阶)

发布时间: 2024-10-04 09:34:23 阅读量: 52 订阅数: 49

Python网络爬虫从入门到进阶全指南

# 1. 网络爬虫与requests库基础

网络爬虫是自动抓取网页数据的程序,它在数据抓取、分析、处理和存储等方面发挥着巨大作用。在Python中,requests库是最受欢迎的HTTP库之一,以其简单易用而受到开发者的青睐。

## 1.1 网络爬虫的概念及应用场景

网络爬虫是一个模拟浏览器行为的自动化脚本,通过发起HTTP请求获取网页内容。它主要用于信息检索、搜索引擎索引、数据监控、市场分析等领域。爬虫程序可以对目标网站进行结构化数据提取,为各种应用提供原始数据支持。

## 1.2 requests库的基本用法

使用requests库非常简单,基本步骤如下:

- 导入库:`import requests`

- 发送请求:`response = requests.get(url)`

- 获取响应内容:`html_content = response.text`

## 1.3 requests库的优势与限制

requests库的优势在于其简洁的API,支持各种HTTP请求方法,还能自动处理编码和会话维持。然而,它不具备内置的并发处理和大规模爬取能力,对于复杂的爬虫任务,需要结合其他库和框架进行功能拓展。

在本章中,我们将重点探讨如何使用requests库来构建基础的爬虫,包括如何发起请求、处理异常以及如何解析响应数据,为后续章节中探讨更高级的爬虫技术打下坚实的基础。

# 2. ```

# 第二章:深入理解requests库的高级特性

网络爬虫的发展与进步,不仅体现在爬取目标的多样性和复杂性上,也反映在对爬虫工具深度掌握上。Python的requests库作为网络爬虫开发者普遍使用的工具之一,其高级特性为我们提供了强大的网络交互能力。本章节将深入探讨requests库的高级特性,帮助您更好地掌握requests库的高级使用技巧,从而提高网络爬虫的性能和稳定性。

## 2.1 requests库的会话管理

在处理多个请求的场景中,会话管理是至关重要的。requests库通过会话对象Session,提供了一种保持某些参数的方法,同时也有助于管理Cookie。

### 2.1.1 会话保持与Cookie处理

会话对象允许我们在多个请求之间保持某些参数。这对于处理需要登录认证的网站尤其有用,因为可以保存用户的认证信息,从而在后续请求中自动使用。

```python

import requests

# 创建一个会话对象

session = requests.Session()

# 第一次请求

response = session.get('***', data={'username': 'user', 'password': 'pass'})

# 使用会话对象发送请求,此时已经携带了第一次请求的Cookie

response = session.get('***')

print(response.json())

```

会话对象会自动处理服务器返回的Set-Cookie头部,并将其发送到同一主机的后续请求中。在上面的代码示例中,一旦登录成功,session对象就会自动保存Cookie,并在随后对“/api/profile”发出请求时使用该Cookie。

### 2.1.2 跨请求认证机制

会话对象不仅能够自动处理Cookie,还能够维持跨多个请求的特定认证机制。这使得开发者可以轻松地实现跨请求的持续认证状态,无需在每次请求时重复认证过程。

```python

# 假设我们有一个需要OAuth 2.0认证的API

auth_url = '***'

payload = {'username': 'user', 'password': 'pass', 'grant_type': 'password'}

token_response = session.post(auth_url, data=payload)

# 现在Session对象保存了token,后续请求会自动使用它

headers = {'Authorization': f'Bearer {token_response.json()["access_token"]}'}

session.get('***', headers=headers)

```

## 2.2 高级请求控制技巧

在复杂的网络爬虫项目中,对请求进行精细控制是不可或缺的。requests库提供了多种高级技巧,以适应不同的网络交互需求。

### 2.2.1 超时设置与重试机制

在发起网络请求时,可能会遇到目标服务器响应缓慢或无法及时响应的情况。为了避免爬虫因长时间等待而停滞,可以设置超时参数,让请求在指定时间内未收到响应时自动放弃。

```python

# 设置请求超时时间为10秒

response = session.get('***', timeout=10)

# 如果请求超时,可以使用自定义的重试逻辑

def retry_request(url, **kwargs):

max_retries = 3

retries = 0

while retries < max_retries:

try:

response = session.get(url, **kwargs)

if response.status_code == 200:

return response

else:

print(f"Request failed with status code: {response.status_code}")

except requests.exceptions.Timeout:

print("Request timed out, retrying...")

except requests.exceptions.RequestException as e:

print(f"Request failed with exception: {e}")

retries += 1

return None

# 使用自定义的重试函数发起请求

response = retry_request('***', timeout=10)

```

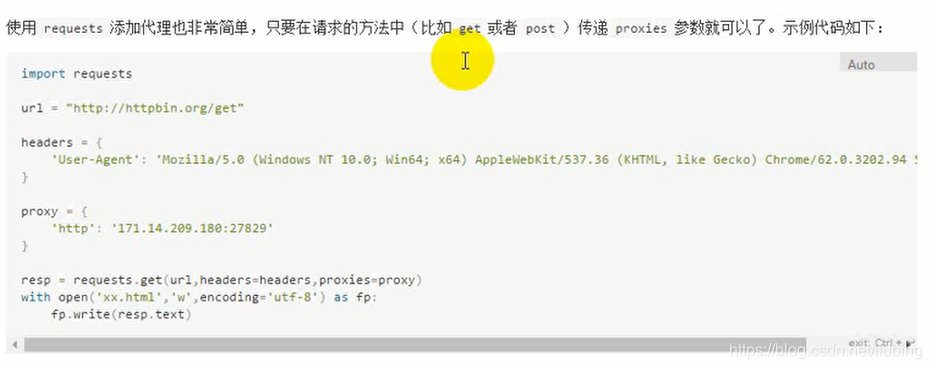

### 2.2.2 使用代理和IP池进行爬取

在爬取目标网站时,如果请求过于频繁或者存在IP访问限制,很容易触发反爬机制。这时可以使用代理或IP池来避免IP被封禁。

```python

# 使用代理进行爬取

proxies = {

'http': '***',

'https': '***',

}

response = session.get('***', proxies=proxies)

# 使用IP池

import random

ip_pool = ['***.***.***.***', '***.***.***.***', '***.***.***.***']

proxy = f'***{random.choice(ip_pool)}:1080'

response = session.get('***', proxies={'http': proxy, 'https': proxy})

```

通过代码示例,我们展示了如何在requests请求中配置代理,从而改变请求的来源IP地址,以应对目标网站可能存在的IP限制。

## 2.3 数据流处理与压缩

在处理大量数据时,下载整个响应然后进行处理可能效率低下且消耗内存。requests库支持流式响应处理,允许开发者边下载边处理数据,从而优化资源使用。

### 2.3.1 流式处理响应数据

流式处理响应数据是处理大规模数据的有效方法。它允许我们逐块处理响应内容,而不是一次性加载整个响应体到内存。

```python

# 流式下载文件

with session.get('***', stream=True) as response:

if response.status_code == 200:

# 以块的方式写入文件

with open('large_file.zip', 'wb') as ***

***

***

***

```

在这个例子中,我们通过`stream=True`参数和`iter_content`方法下载了大型文件,并逐块将其写入到文件系统中。这样做可以显著减少内存使用。

### 2.3.2 响应压缩与解压

为了减少网络传输数据量,服务器有时会对响应内容进行压缩。requests库能够自动解压缩内容,并允许开发者通过header指定自己希望支持的压缩格式。

```python

# 告诉服务器希望接受gzip格式的压缩内容

headers = {'Accept-Encoding': 'gzip, deflate'}

response = session.get('***', headers=headers)

# 获取解压缩后的原始内容

content = response.content

```

在这个例子中,通过在请求头中设置`Accept-Encoding`,服务器将返回gzip压缩的内容,requests库会自动处理解压缩,并提供解压后的响应内容。

通过本章节的介绍,我们深入了解了requests库的高级特性,包括会话管理、请求控制、以及响应数据处理等。掌握这些技巧,无疑将帮助您在实现复杂的网络爬虫时更加游刃有余。

```

# 3. 数据提取的高级技巧

在现代网络爬虫项目中,数据提取是至关重要的一环。除了传统的数据抓取技术,开发者们还需要掌握更加高效和强大的数据提取方法来应对日益复杂的网页结构和数据格式。本章节将深入讲解如何利用正则表达式、BeautifulSoup库以及XPath和CSS选择器来实现高级的数据提取技巧。

## 3.1 使用正则表达式提取信息

正则表达式是数据提取、处理以及文本分析中的重要工具,它提供了一种灵活的方式来匹配和提取字符串中的特定模式。对于结构化数据的提取,正则表达式尤其显示出它的强大功能。

### 3.1.1 正则表达式的构造与应用

正则表达式由一系列字符组成,这些字符定义了搜索的模式。基本构造单元包括字符集、量

0

0