【数值计算误差最小化】:确保速度提升图准确性的误差控制技巧

发布时间: 2024-12-17 05:15:19 订阅数: 3

LMS.rar_lms 收敛_matlab 均方误差_最小均方误差_计算误差

参考资源链接:[FLUENT软件速度矢量图显示详解及其应用](https://wenku.csdn.net/doc/2pmeyqgqj3?spm=1055.2635.3001.10343)

# 1. 数值计算误差的理论基础

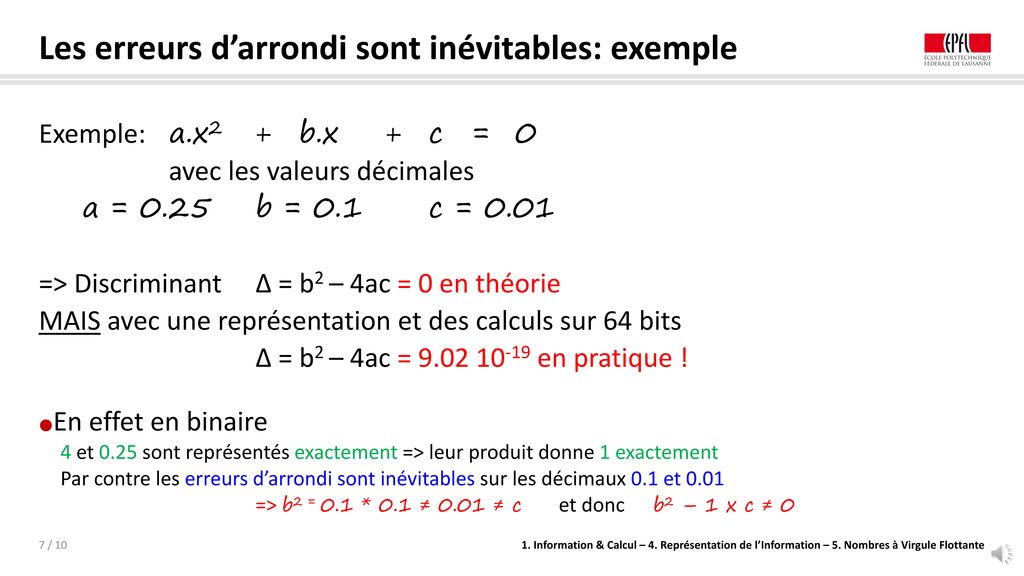

在数值计算领域,误差是不可避免的现象,它会影响计算结果的准确性和可靠性。理解数值计算误差的理论基础是进行任何科学和工程计算的前提。本章节将介绍误差的概念、特点以及它们在数值分析中的重要性。

## 1.1 误差的定义和分类

误差是指计算结果与真实值之间的差异。在数值计算中,误差主要分为两大类:系统误差和随机误差。系统误差是由计算方法或工具的不完善引起的,具有一定的规律性,可以通过改进算法或工具来减小或消除。随机误差是由随机因素引起的,通常是无法完全消除的,但可以通过统计方法进行评估。

## 1.2 误差的来源

数值计算误差的来源多样,包括输入数据的误差、模型简化过程中的误差、计算过程中的舍入误差、以及由硬件限制导致的误差等。理解这些误差的来源是控制误差、提高计算精度的关键。

## 1.3 误差的影响

误差在数值计算中可能导致严重的后果,尤其在需要高精度和高可靠性的应用场合。例如,在金融计算、工程模拟、科学实验等领域,误差可能引起灾难性的后果。因此,研究误差的理论基础、分析误差的影响,并开发有效的误差控制方法,是数值计算领域中的核心任务之一。

# 2. 误差来源分析与控制策略

在计算机进行数值计算时,不可避免地会产生误差。这些误差的来源多种多样,它们可能源自于算法本身的近似,或者是由于计算机硬件和软件在处理信息时的局限性。理解这些误差的来源对于设计能够有效控制误差的数值算法至关重要。

## 2.1 误差的分类

### 2.1.1 截断误差

在数值分析中,截断误差指的是在使用有限步骤或近似方法来逼近一个无限过程时产生的误差。例如,在数值积分中,我们可能使用梯形规则或辛普森规则来近似定积分,这些规则只考虑了函数的有限个点,因此无法完全精确地表示积分的真实值,这种近似引入的误差被称为截断误差。

```mermaid

graph LR

A[连续积分过程] -->|近似| B[数值积分]

B --> C[引入截断误差]

C --> D[梯形规则]

C --> E[辛普森规则]

```

### 2.1.2 舍入误差

在计算机中,由于表示数值的位数有限,我们无法表示无穷多的小数位。因此,每当我们进行计算时,比如加法、乘法或除法,结果都需要四舍五入到计算机能够表示的精度范围。这种由四舍五入引入的误差被称为舍入误差。

```mermaid

graph LR

A[实际数值] --> B[四舍五入]

B --> C[计算机表示数值]

C --> D[舍入误差]

```

## 2.2 数值算法的选择与误差分析

### 2.2.1 算法精度的比较

在选择数值算法时,精度是一个关键的考量因素。精度可以是绝对误差,也可以是相对误差。绝对误差是估计值与真实值之差的绝对值,而相对误差则是绝对误差除以真实值。

```math

绝对误差 = |估计值 - 真实值|

相对误差 = |绝对误差 / 真实值|

```

### 2.2.2 稳定性分析

除了精度,稳定性也是评估数值算法的重要指标。一个数值算法是稳定的,意味着它对于输入数据的微小变化所产生的影响有限。如果一个算法不稳定,那么微小的输入误差可能会被放大,导致最终结果的误差过大。

## 2.3 数值稳定性与误差传播

### 2.3.1 稳定性定义和判断方法

一个数值算法的稳定性通常通过分析算法在处理输入扰动时的反应来判断。如果在输入有轻微变化时,算法输出的变化也很小,那么该算法被认为是稳定的。判断稳定性的方法通常涉及线性化技术或扰动分析。

### 2.3.2 误差传播规律和控制技术

误差的传播规律可以通过误差分析得到。基本思想是从误差的来源出发,分析计算过程中各个步骤如何相互影响。通过掌握这些规律,我们可以设计出有效的控制技术,比如误差校正和误差估计,这些技术能帮助我们在计算过程中实时监控和调整误差,以保持数值计算的准确性。

```markdown

表格:误差控制技术比较

| 技术 | 描述 | 优势 | 劣势 |

|------|------|------|------|

|误差校正| 在计算过程中校正误差,减少误差的积累 | 提高计算结果的准确性 | 实现复杂,可能增加计算量 |

|误差估计| 估计误差的范围,为计算提供参考 | 可以实时反馈误差信息 | 估计的准确性依赖于算法 |

```

在接下来的章节中,我们将进一步探讨如何通过算法实现提高数值计算的准确性,以及如何利用软件工具进行有效的误差管理和分析。

# 3. 提高数值计算准确性的算法实现

提高数值计算准确性是数值分析中的重要课题,对于需要进行精确计算的科学、工程和金融领域来说尤为关键。在实际操作中,算法的选择和实现是决定计算准确性的重要因素。本章将详细介绍几种提高数值计算准确性的算法,并探讨其在实际应用中的实现与优化。

## 3.1 高精度算法的应用

高精度算法是一种能够在计算过程中保持较高精度的方法,它通常涉及到更复杂的数据类型和算法逻辑。高精度算法的实现可以大大减少计算过程中的累积误差。

### 3.1.1 多精度计算方法

多精度计算,也称为任意精度计算,是一种在计算过程中根据需要动态调整数值精度的方法。这种技术可以有效地避免在数值计算中由于固定精度限制而导致的误差。

```c

// 示例:使用GMP库进行多精度计算的C语言代码片段

#include <gmp.h>

#include <stdio.h>

int main() {

mpz_t a, b, c;

mpz_init(a);

mpz_init(b);

mpz_init(c);

// 假设a和b是需要进行高精度运算的两个数

mpz_set_str(a, "12345678901234567890", 10);

mpz_set_str(b, "98765432109876543210", 10);

// 进行高精度乘法计算

mpz_mul(c, a, b);

// 输出结果

gmp_printf("Result: %Zd\n", c);

// 清理资源

mpz_clear(a);

mpz_clear(b);

mpz_clear(c);

return 0;

}

```

在上述代码中,我们首先使用`gmp.h`库中的函数来初始化三个`mpz_t`类型的变量`a`、`b`和`c`。这些变量将用于存储高精度的整数。然后,我们使用`mpz_set_str`函数来为`a`和`b`赋值,这两个函数的第二个参数指明了输入字符串的基数。完成赋值后,使用`mpz_mul`函数进行乘法运算,并将结果存储在`c`中。最后,我们用`gmp_printf`函数输出计算结果,并清理分配的资源。

多精度计算方法的实现涉及到了数据类型的动态选择和算法逻辑的调整,能够有效处理大型数值的精确运算问题。选择合适的库和语言特性对于简化开发过程和提高性能至关重要。

### 3.1.2 自适应精度算法

自适应精度算法是一种智能算法,它根据问题的实际精度需求动态调整计算过程中使用的精度。自适应算法通常结合误差估计和控制技术,当检测到误差超过预设阈值时,算法会自动提升精度以确保计算的准确性。

```python

from decimal import Decimal, getcontext

# 设置初始的精度

getcontext().prec = 10

# 进行初步计算

a = Decima

```

0

0