Paddle Fluid加速技巧:提升训练与推理效率秘籍

发布时间: 2024-12-26 00:32:56 阅读量: 6 订阅数: 9

问题解决:AttributeError: module ‘paddle.fluid’ has no attribute ‘EndStepEvent’

# 摘要

Paddle Fluid是百度开发的深度学习框架,以其灵活的编程模型、高效的性能调优和广泛的生态支持而著称。本文首先介绍了Paddle Fluid的基本概念和环境搭建步骤,随后探讨了深度学习的基础知识以及如何在Paddle Fluid中实现这些理论。文章着重分析了Paddle Fluid的编程模型,包括API设计、动态图与静态图的使用,以及张量、变量、网络层和模型等核心概念。在性能调优方面,本文提供了训练加速技巧和模型推理优化的实战策略,同时讨论了资源管理与监控的方法。进阶应用案例章节详细说明了自定义操作的优化、分布式训练策略以及跨平台部署的解决方案。最后,文章对Paddle Fluid的未来发展进行了展望,分析了其在工业界的应用、生态建设和技术路线图。

# 关键字

Paddle Fluid;深度学习;性能调优;资源监控;分布式训练;生态建设

参考资源链接:[修复错误:AttributeError涉及paddle.fluid的EndStepEvent](https://wenku.csdn.net/doc/6412b663be7fbd1778d468c1?spm=1055.2635.3001.10343)

# 1. Paddle Fluid简介与环境搭建

Paddle Fluid是由百度推出的深度学习平台PaddlePaddle的动态图实现。它允许开发者使用更灵活的编程范式来进行深度学习模型的构建和训练,是深度学习研究与开发的重要工具之一。

## 1.1 Paddle Fluid的特点

Paddle Fluid的动态图设计理念提供了代码编写上的便利性,使研究者能够更直观地理解模型构建过程中的数据流动。同时,它也支持动态图与静态图的转换,实现了灵活性与性能的平衡。

## 1.2 环境搭建步骤

为了使用Paddle Fluid,开发者需要先搭建PaddlePaddle的开发环境。以下是具体步骤:

1. **安装依赖**:确保系统中已安装Python、CUDA(如果需要GPU加速)、cuDNN等。

2. **安装Paddle Fluid**:执行安装命令,如使用`pip install paddlepaddle-fluid`。

3. **验证安装**:通过运行简单的示例代码,检查Paddle Fluid是否正常工作。

```bash

python -c "import paddle.fluid as fluid; fluid.install_check.run_check()"

```

以上流程完成后,你将拥有一个基本的Paddle Fluid开发环境,可以开始探索深度学习模型的构建与训练了。

# 2. 深度学习基础与Paddle Fluid理论

### 2.1 深度学习模型训练基础

#### 2.1.1 前向传播与反向传播算法

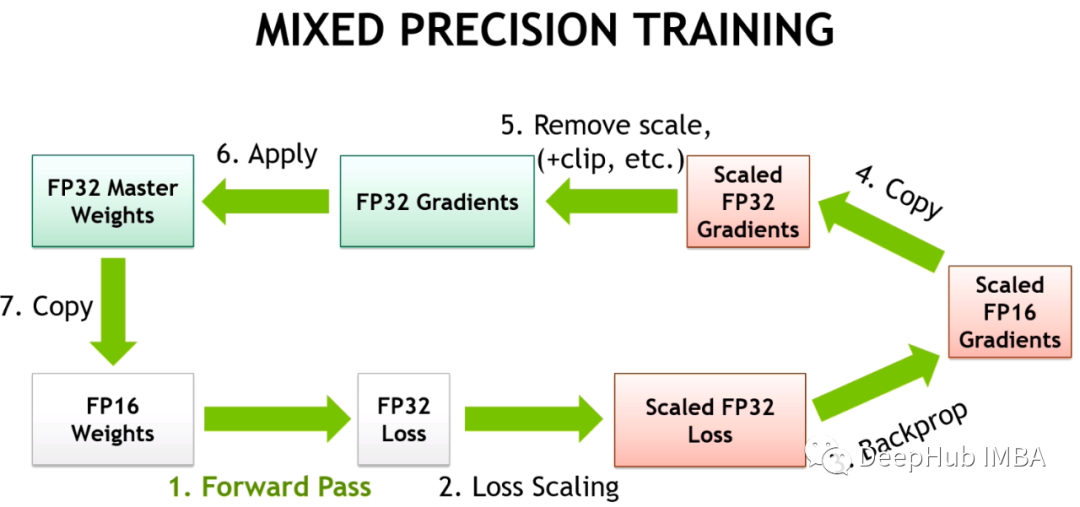

在深度学习的训练过程中,前向传播和反向传播算法是两个核心步骤。前向传播是指数据经过网络层从输入到输出的计算过程。在该过程中,输入数据会通过每一层的线性变换和激活函数,最终得到预测结果。反向传播算法则利用链式法则计算损失函数关于网络参数的梯度,这些梯度是通过误差相对于每个参数的偏导数计算得到的。

反向传播算法的关键步骤包括损失计算、梯度计算和权重更新。在Paddle Fluid中,这些步骤可以自动完成,开发者只需定义好网络结构、损失函数以及优化器,框架会自动处理前向传播和反向传播的过程。

```python

# 伪代码展示Paddle Fluid中的前向传播和反向传播

import paddle.fluid as fluid

# 定义输入数据和标签

x = fluid.data(name='x', shape=[None, 784])

y = fluid.data(name='y', shape=[None, 1], dtype='int64')

# 定义预测模型(例如多层感知机)

prediction = fluid.layers.fc(input=x, size=10, act='softmax')

# 定义损失函数

loss = fluid.layers.cross_entropy(input=prediction, label=y)

avg_loss = fluid.layers.mean(loss)

# 选择优化器

optimizer = fluid.optimizer.SGD(learning_rate=0.01)

# 训练过程

for pass_id in range(num_passes):

# 前向传播

train_reader = paddle.batch(reader=paddle.dataset.mnist.train(), batch_size=64)

for batch_id, data in enumerate(train_reader()):

x_value, y_value = fluid.default_main_program().data_input_handler(data)

# 通过执行前向传播计算损失

loss_value = exe.run(program=fluid.default_main_program(), fetch_list=[avg_loss], feed={'x': x_value, 'y': y_value})

# 反向传播和优化

loss_value = exe.run(program=fluid.default_main_program(), fetch_list=[avg_loss], feed={'x': x_value, 'y': y_value})

print('Pass:%d, Loss:%f' % (pass_id, loss_value))

```

该代码段展示了如何在Paddle Fluid中构建一个简单的多层感知机模型,并通过前向传播与反向传播进行训练。需要注意的是,`exe.run`函数执行了前向传播并返回损失值,在实际训练中,通过多次迭代来不断更新权重,从而最小化损失函数。

### 2.1.2 损失函数与优化器的选择

深度学习模型训练的目标是减少输出与真实标签之间的差异,损失函数(Loss Function)是对这种差异进行量化的函数。选择合适的损失函数对于模型训练至关重要。Paddle Fluid支持多种损失函数,如均方误差(MSE)、交叉熵(Cross Entropy)等。

优化器是负责更新模型参数以最小化损失函数的算法。Paddle Fluid提供了多种优化器,包括SGD、Adam、Adagrad等,每种优化器都有其独特的更新规则,适用于不同的训练场景。

在选择损失函数和优化器时,应考虑任务的类型、数据的分布以及模型的结构等因素。例如,对于多分类问题,通常使用交叉熵作为损失函数;对于回归问题,则多使用MSE。优化器的选择则更多依赖于具体问题,如Adam优化器因其适应性强且容易使用,通常作为默认选择。

### 2.2 Paddle Fluid的编程模型

#### 2.2.1 API设计原则与编程规范

Paddle Fluid的API设计遵循简洁和直观的原则。API设计的目的是让开发者能够快速构建和训练深度学习模型。Fluid API按照从底层到高层的层次提供了一系列接口,从原始的算子操作到高级的模型构建都涵盖在内。

编程规范方面,Paddle Fluid强调代码的可读性和可维护性。它鼓励开发者使用可复用的代码块,并采用模块化的设计方式。此外,Fluid API还支持编程模式的切换,开发者可以根据需要选择动态图或者静态图的编程模式,以适应不同的开发需求。

```python

# 使用动态图进行编程

with fluid.dygraph.guard():

# 构建动态图模型

model = Model()

optimizer = optimizer.SGD(learning_rate=0.01)

for epoch_id in range(num_epochs):

for batch_id, (images, labels) in enumerate(data_loader):

# 动态执行前向传播

outputs = model(images)

loss = loss_fn(outputs, labels)

loss.backward()

optimizer.step()

optimizer.clear_grad()

```

```python

# 使用静态图进行编程

def train():

# 定义静态图

data = fluid.layers.data(name='data', shape=[1, 28, 28])

label = fluid.layers.data(name='label', shape=[1], dtype='int64')

prediction = fluid.layers.fc(input=data, size=10, act='softmax')

loss = fluid.layers.cross_entropy(input=prediction, label=label)

avg_loss = fluid.layers.mean(loss)

return avg_loss

# 创建执行程序

exe = fluid.Executor(fluid.CPUPlace())

# 获取静态图的程序

main_program = fluid.default_main_program()

# 获取训练函数

train_program = fluid.Program()

with fluid.program_guard(train_program):

avg_loss = train()

# 构建静态图

exe.run(train_program)

```

动态图与静态图的代码块展示在Paddle Fluid中如何构建程序。动态图模式提供了Python风格的编程体验,便于调试和快速开发;而静态图模式则对性能进行了优化,适合生产环境。

### 2.2.2 动态图与静态图的理解与应用

在Paddle Fluid中,动态图和静态图是两种编程模式,每种模式都有其优势和适用场景。动态图模式,也被称为动态计算图或命令式编程模式,在此模式下,图是边创建边运行的,使得代码的编写与执行更直观、灵活,易于调试。动态图适合快速原型开发和研究任务。

静态图模式,即静态计算图或声明式编程模式,图的构建和运行是分开的。开发者首先定义整个计算图,然后运行整个图。静态图由于可以进行全局的优化,因此在性能上有优势,尤其适合于大规模模型和生产部署。

```mermaid

graph LR

A[开始构建图] -->|动态图| B[边创建边运行]

A -->|静态图| C[定义完整计算图]

B --> D[直观编程体验]

C --> E[全局优化提高性能]

D --> F[适合研究和原型开发]

E --> G[适合大规模模型部署]

```

在实际应用中,Paddle Fluid允许开发者在两种图之间自由切换,为不同阶段的开发和部署提供了灵活的选择。动态图可以快速进行模型试验和调试,一旦模型确定,可以切换至静态图模式进行性能优化。

### 2.3 Paddle Fluid中的核心概念

#### 2.3.1 张量(Tensor)与变量(Variable)

在深度学习框架中,数据被表示为张量,它们是多维数组,用于存储输入数据、模型参数和中间计算结果。在Paddle Fluid中,张量可以是标量、向量、矩阵或更高维度的数据结构。

变量是用于存储模型参数的张量,如权重和偏置。在训练过程中,变量的值会被优化器更新。Paddle Fluid提供了丰富的API来操作张量,如创建、修改和执行数学运算。

```python

import paddle.fluid as fluid

import numpy as np

# 创建一个张量

tensor = fluid.layers.data(name='tensor', shape=[10], dtype='float32')

# 创建一个变量

var = fluid.layers.create_parameter(

shape=[10],

```

0

0