Python字符串与机器学习:探索字符串在机器学习中的作用,从文本数据中提取特征,提升模型准确性

发布时间: 2024-06-25 09:50:37 阅读量: 103 订阅数: 32

Python字符串学习

# 1. Python字符串基础**

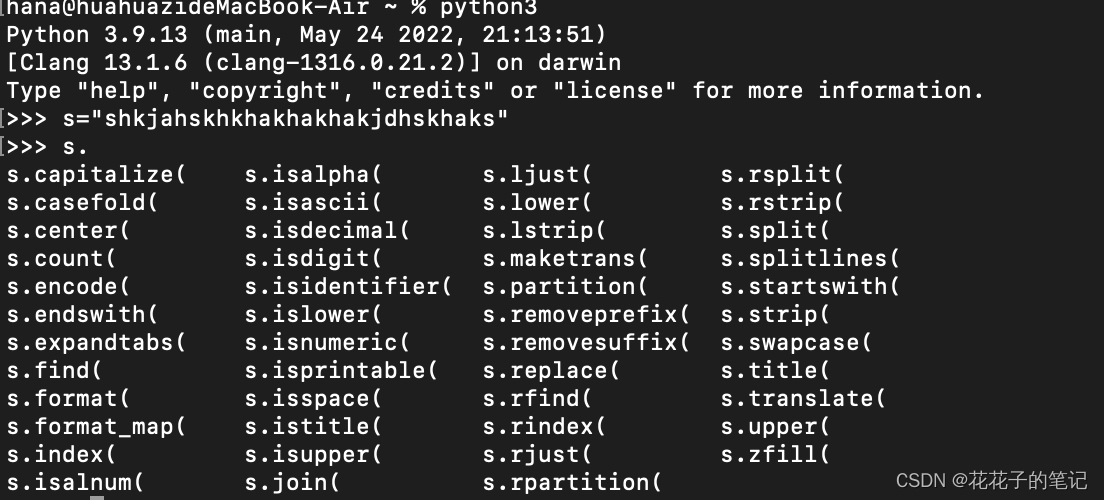

Python字符串是用于表示文本数据的不可变序列。它们由一组字符组成,并使用单引号(')或双引号(")括起来。字符串具有丰富的内置方法和运算符,使您可以轻松地操作和处理文本数据。

字符串的常见操作包括连接(+)、复制(*)、切片([])、查找(find())和替换(replace())。此外,Python还提供正则表达式模块,用于更高级的字符串匹配和操作。

# 2. 字符串在机器学习中的作用

字符串在机器学习中扮演着至关重要的角色,因为它提供了对文本数据的处理和分析能力,而文本数据在许多现实世界应用中无处不在。本章将深入探讨字符串在机器学习中的作用,重点关注字符串预处理和特征提取这两个关键步骤。

### 2.1 字符串预处理

字符串预处理是机器学习管道中至关重要的一步,它涉及将原始文本数据转换为适合机器学习模型处理的形式。主要包括以下两个子步骤:

#### 2.1.1 文本清理和标准化

文本清理和标准化旨在消除文本数据中的噪声和不一致性。常见的技术包括:

- **去除标点符号和特殊字符:**这些字符通常不包含有意义的信息,并且可能干扰模型的训练。

- **转换为小写:**文本中的大小写差异可能会导致模型错误地将相同的单词视为不同的单词。

- **去除空格和换行符:**这些字符会影响文本的结构和模型的特征提取。

- **统一编码:**确保文本使用一致的字符编码,例如 UTF-8,以避免字符乱码问题。

#### 2.1.2 分词和词干化

分词和词干化是将文本分解为其组成部分的过程。

- **分词:**将文本拆分为单词或标记。

- **词干化:**将单词还原为其基本形式,例如将“running”还原为“run”。

分词和词干化有助于减少文本中的冗余,并提高模型对文本语义的理解。

### 2.2 特征提取

特征提取是从预处理后的文本数据中提取有意义的特征的过程,这些特征可用于训练机器学习模型。主要包括以下三个子步骤:

#### 2.2.1 词袋模型

词袋模型是一种简单的特征提取方法,它将文本表示为一个单词的集合,每个单词的出现次数作为特征值。

```python

from sklearn.feature_extraction.text import CountVectorizer

# 创建词袋模型

vectorizer = CountVectorizer()

# 拟合和转换文本数据

X = vectorizer.fit_transform(["This is a sample text", "This is another sample text"])

# 打印特征名称和值

print(vectorizer.get_feature_names_out())

print(X.toarray())

```

**参数说明:**

- `max_features`:限制特征的数量,以减少维度。

- `stop_words`:指定要从文本中去除的停用词列表。

**代码逻辑:**

1. `CountVectorizer`类创建了一个词袋模型,该模型将文本表示为单词的集合。

2. `fit_transform`方法拟合模型并转换文本数据,生成一个稀疏矩阵,其中每个单词的出现次数作为特征值。

3. `get_feature_names_out`方法返回特征名称,即单词。

4. `toarray`方法将稀疏矩阵转换为一个稠密矩阵,便于查看特征值。

#### 2.2.2 TF-IDF

TF-IDF(词频-逆文档频率)是一种更复杂的特征提取方法,它考虑了单词在文档中的频率以及在整个文档集合中的分布。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 创建 TF-IDF 模型

vectorizer = TfidfVectorizer()

# 拟合和转换文本数据

X = vectorizer.fit_transform(["This is a sample text", "This is another sample text"])

# 打印特征名称和值

print(vectorizer.get_feature_names_out())

print(X.toarray())

```

**参数说明:**

- `max_features`:限制特征的数量,以减少维度。

- `stop_words`:指定要从文本中去除的停用词列表。

- `use_idf`:启用逆文档频率加权。

**代码逻辑:**

1. `TfidfVectorizer`类创建了一个 TF-IDF 模型,该模型考虑了单词在文档中的频率和在整个文档集合中的分布。

2. `fit_transform`方法拟合模型并转换文本数据,生成一个稀疏矩阵,其中每个单词的 TF-IDF 值作为特征值。

3. `get_feature_names_out`方法返回特征名称,即单词。

4. `toarray`方法将稀疏矩阵转换为一个稠密矩阵,便于查看特征值。

#### 2.2.3 词嵌入

词嵌入是一种高级特征提取技术,它将单词表示为向量,这些向量捕获了单词的语义和语法关系。

```python

import gensim

# 加载预训练的词嵌入模型

model = gensim.models.KeyedVectors.load_word2vec_format("GoogleNews-vectors-negative300.bin", binary=True)

# 获取单词的词嵌入向量

vector = model["sample"]

# 打印词嵌入向量

print(vector)

```

**参数说明:**

- `model`:预训练的词嵌入模型。

- `word`:要获取词嵌入向量的单词。

**代码逻辑:**

1. `KeyedVectors`类加载预训练的词嵌入模型。

2. `[]`运算符获取指定单词的词嵌入向量。

3. 打印词嵌入向量,它是一个包含单词语义和语法信息的稠密向量。

# 3.1 使用NLTK进行文本预处理

NLTK(自然语言工具包)是一个用于处理自然语言数据的流行Python库。它提供了广泛的工具,包括文本预处理、分词、词干化和停用词去除。

#### 3.1.1 文本分词和词干化

文本分词是将文本分解为单个单词或标记的过程。NLTK提供了`word_tokenize()`函数,它使用正则表达式将文本分成单词。

```python

import nltk

text = "Natural language processing is a subfield of linguistics, computer science, and artificial intelligence concerned with the interactions between computers and human (natural) languages."

tokens = nltk.word_tokenize(text)

print(tokens)

```

输出:

```

['Natural', 'language', 'processing', 'is', 'a', 'subfield', 'of', 'linguistics', ',', 'computer', 'science', ',', 'and', 'artificial', 'intelligence', 'concerned', 'with', 'the', 'interactions', 'between', 'computers', 'and', 'human', '(', 'natural'

```

0

0