MySQL表结构优化:从设计到维护,提升数据库性能

发布时间: 2024-07-25 02:46:21 阅读量: 36 订阅数: 33

# 1. MySQL表结构优化概述

MySQL表结构优化是通过合理设计和维护表结构,以提高数据存储、查询和更新性能的关键技术。表结构优化涉及多个方面,包括:

- **范式化和数据建模:**根据数据关系和业务规则,将数据组织成逻辑结构,以消除冗余和确保数据完整性。

- **数据类型和长度选择:**根据数据特征和存储需求,选择合适的列数据类型和长度,以优化存储空间和查询性能。

- **索引设计和使用:**创建适当的索引,以快速查找和检索数据,从而提高查询效率。

# 2. 表结构设计最佳实践

### 2.1 范式化和数据建模

范式化是一种数据建模技术,它通过消除数据冗余和确保数据一致性来提高数据库的效率和可维护性。

#### 2.1.1 第一范式(1NF)

1NF 要求每个表中的每一行都代表一个唯一的实体,并且表中的每一列都代表该实体的一个属性。换句话说,1NF 消除了重复的数据组。

例如,考虑一个 `Customers` 表,其中包含以下列:

```

| CustomerID | Name | Address | Phone | Email |

```

该表符合 1NF,因为每一行都代表一个唯一的客户,并且每一列都代表该客户的一个属性。

#### 2.1.2 第二范式(2NF)

2NF 要求表中的每一列都与表的主键完全依赖。换句话说,2NF 消除了部分依赖。

考虑以下 `Orders` 表:

```

| OrderID | CustomerID | ProductID | Quantity | Price |

```

该表不符合 2NF,因为 `ProductID` 列部分依赖于 `CustomerID` 列。这意味着我们可以从 `CustomerID` 列推导出 `ProductID` 列,这可能会导致数据冗余和不一致。

为了使该表符合 2NF,我们可以创建以下新表:

```

| OrderID | CustomerID | ProductID | Quantity | Price |

| ProductID | ProductName | Category | Price |

```

现在,`Orders` 表符合 2NF,因为 `ProductID` 列完全依赖于 `OrderID` 列。

#### 2.1.3 第三范式(3NF)

3NF 要求表中的每一列都与表的主键非传递依赖。换句话说,3NF 消除了传递依赖。

考虑以下 `Employees` 表:

```

| EmployeeID | DepartmentID | ManagerID | Salary |

```

该表不符合 3NF,因为 `ManagerID` 列传递依赖于 `DepartmentID` 列。这意味着我们可以从 `DepartmentID` 列推导出 `ManagerID` 列,然后再从 `ManagerID` 列推导出 `Salary` 列。

为了使该表符合 3NF,我们可以创建以下新表:

```

| EmployeeID | DepartmentID | ManagerID | Salary |

| DepartmentID | DepartmentName | ManagerID |

| ManagerID | ManagerName | Salary |

```

现在,`Employees` 表符合 3NF,因为 `ManagerID` 列不再传递依赖于 `DepartmentID` 列。

# 3. 表结构维护和调整

### 3.1 表分区和分片

#### 3.1.1 分区原理和优势

表分区是一种将表中的数据按一定规则划分为多个子集(分区)的技术。每个分区包含表中的一部分数据,并且可以独立于其他分区进行管理和操作。

**优势:**

- **性能优化:** 分区可以将表中的数据分散到多个文件或存储设备上,从而减少单个文件或设备上的 I/O 负载,提高查询性能。

- **管理方便:** 分区允许对不同的数据子集进行单独管理,例如备份、恢复或删除。

- **扩展性:** 分区可以轻松扩展,只需添加新的分区即可。

- **并发性:** 分区可以提高并发性,因为不同的查询可以同时访问不同的分区。

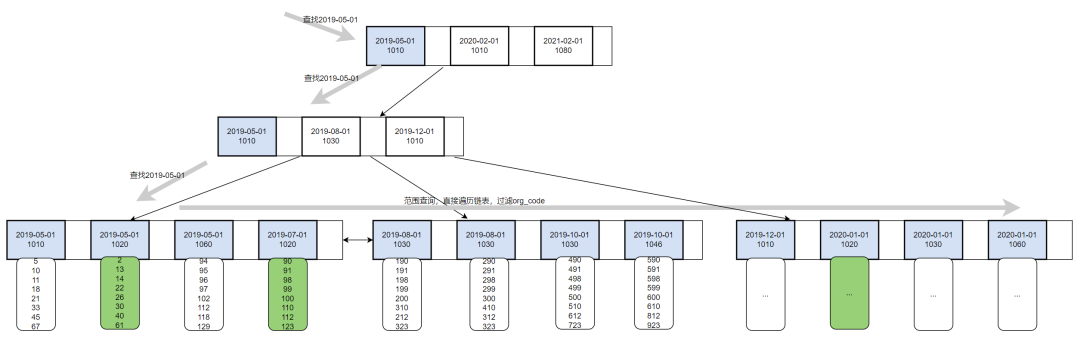

#### 3.1.2 分片策略和实施

分片是一种将表中的数据水平分割为多个子集(分片)的技术。每个分片包含表中的一部分数据,并且存储在不同的数据库实例或服务器上。

**分片策略:**

- **范围分片:** 根据数据范围将数据分配到分片,例如按日期或 ID 范围。

- **哈希分片:** 根据数据的哈希值将数据分配到分片,确保数据均匀分布。

- **复合分片:** 结合范围分片和哈希分片,提高数据分布的均匀性。

**实施:**

- **垂直分片:** 将表中的列拆分为多个分片,每个分片包含不同的列。

- **水平分片:** 将表中的行拆分为多个分片,每个分片包含不同的行。

### 3.2 表数据清理和优化

#### 3.2.1 数据冗余和一致性检查

数据冗余是指表中存在重复的数据。这会浪费存储空间并导致数据不一致。

**检查方法:**

- **主键和唯一索引:** 检查表中是否存在重复的主键或唯一索引值。

- **数据比对:** 使用 DISTINCT 和 COUNT() 函数比较不同列中的数据值。

- **外键约束:** 检查外键约束是否有效,确保数据引用的一致性。

#### 3.2.2 数据压缩和清理策略

数据压缩可以减少表中数据的存储空间,提高查询性能。

**压缩方法:**

- **行内压缩:** 对每一行数据进行压缩。

- **行间压缩:** 对相邻行中的重复数据进行压缩。

- **列存储:** 将表中的列存储在单独的文件中,以便对特定列进行压缩。

**清理策略:**

- **删除重复数据:** 使用 DELETE 或 MERGE 语句删除重复的数据。

- **清理历史数据:** 定期删除不再需要的数据,例如过期的日志或备份。

- **优化数据类型:** 将数据类型更改为更紧凑的类型,例如将 VARCHAR 更改为 CHAR。

### 3.3 表结构变更和迁移

#### 3.3.1 表结构变更的原则和方法

表结构变更是指修改表中的列、索引或其他属性。

**原则:**

- **最小化影响:** 尽量减少变更对现有应用程序和查询的影响。

- **兼容性:** 确保变更与现有数据和应用程序兼容。

- **安全性:** 防止数据丢失或损坏。

**方法:**

- **ALTER TABLE 语句:** 用于添加、删除或修改列、索引和其他表属性。

- **RENAME TABLE 语句:** 用于重命名表。

- **CREATE TABLE...SELECT 语句:** 用于创建新表并从现有表中复制数据。

#### 3.3.2 数据迁移的策略和工具

数据迁移是指将数据从一个表或数据库迁移到另一个。

**策略:**

- **全量迁移:** 一次性将所有数据迁移到新表或数据库。

- **增量迁移:** 仅迁移自上次迁移后更改的数据。

**工具:**

- **MySQL Workbench:** 一个图形化工具,用于设计、管理和迁移数据库。

- **mysqldump 和 mysqlimport:** 命令行工具,用于导出和导入数据。

- **第三方迁移工具:** 提供高级功能,例如并行迁移和数据转换。

# 4. 表结构优化实践案例

### 4.1 电商平台订单表优化

**4.1.1 表结构设计和索引优化**

电商平台的订单表通常包含大量数据,需要进行优化以提高查询和更新性能。以下是一些优化措施:

* **范式化:**将订单表拆分为多个子表,如订单头表和订单明细表,以消除数据冗余和提高数据一致性。

* **数据类型选择:**为不同类型的列选择合适的MySQL数据类型,如使用INT或BIGINT存储订单ID,使用VARCHAR存储产品名称。

* **索引设计:**创建适当的索引以加速查询,如在订单ID和产品ID列上创建索引。

**代码块:**

```sql

CREATE TABLE orders (

order_id INT NOT NULL AUTO_INCREMENT,

customer_id INT NOT NULL,

order_date DATETIME NOT NULL,

total_amount DECIMAL(10, 2) NOT NULL,

PRIMARY KEY (order_id),

INDEX (customer_id)

);

CREATE TABLE order_details (

order_id INT NOT NULL,

product_id INT NOT NULL,

quantity INT NOT NULL,

unit_price DECIMAL(10, 2) NOT NULL,

PRIMARY KEY (order_id, product_id),

INDEX (product_id)

);

```

**逻辑分析:**

* `orders`表存储订单头信息,如订单ID、客户ID、订单日期和总金额。

* `order_details`表存储订单明细信息,如订单ID、产品ID、数量和单价。

* 主键和索引有助于快速查找和检索数据。

### 4.1.2 数据分片和清理策略

**数据分片:**

随着订单数量的增加,订单表会变得非常庞大。为了提高性能,可以将表水平分片为多个更小的子表,每个子表存储特定时间范围内的订单。

**代码块:**

```sql

CREATE TABLE orders_2023 (

order_id INT NOT NULL AUTO_INCREMENT,

customer_id INT NOT NULL,

order_date DATETIME NOT NULL,

total_amount DECIMAL(10, 2) NOT NULL,

PRIMARY KEY (order_id),

INDEX (customer_id)

);

```

**逻辑分析:**

* `orders_2023`表存储2023年的订单数据。

* 通过在表名中包含年份,可以轻松识别和管理不同的分片表。

**数据清理:**

定期清理订单表中的冗余和过时数据,以释放存储空间并提高性能。

**代码块:**

```sql

DELETE FROM orders WHERE order_date < '2022-01-01';

```

**逻辑分析:**

* 该查询删除2022年1月1日之前的订单数据。

* 定期执行此类查询以清理旧数据。

### 4.2 社交媒体用户表优化

**4.2.1 表结构设计和范式化**

社交媒体用户表通常包含大量用户数据,需要进行优化以提高数据访问效率。以下是一些优化措施:

* **范式化:**将用户表拆分为多个子表,如用户基本信息表、用户活动表和用户好友表,以消除数据冗余和提高数据一致性。

* **数据类型选择:**为不同类型的列选择合适的MySQL数据类型,如使用INT存储用户ID,使用VARCHAR存储用户名。

* **索引设计:**创建适当的索引以加速查询,如在用户ID和用户名列上创建索引。

**代码块:**

```sql

CREATE TABLE users (

user_id INT NOT NULL AUTO_INCREMENT,

username VARCHAR(255) NOT NULL,

email VARCHAR(255) NOT NULL,

PRIMARY KEY (user_id),

INDEX (username)

);

CREATE TABLE user_activities (

user_id INT NOT NULL,

activity_type VARCHAR(255) NOT NULL,

activity_date DATETIME NOT NULL,

PRIMARY KEY (user_id, activity_type, activity_date)

);

CREATE TABLE user_friends (

user_id INT NOT NULL,

friend_id INT NOT NULL,

PRIMARY KEY (user_id, friend_id)

);

```

**逻辑分析:**

* `users`表存储用户基本信息,如用户ID、用户名和电子邮件。

* `user_activities`表存储用户活动信息,如用户ID、活动类型和活动日期。

* `user_friends`表存储用户好友关系。

* 主键和索引有助于快速查找和检索数据。

### 4.2.2 索引优化和数据压缩

**索引优化:**

优化索引以提高查询性能,如在经常用于查询的列上创建组合索引。

**代码块:**

```sql

CREATE INDEX idx_user_activity_type_date ON user_activities (activity_type, activity_date);

```

**逻辑分析:**

* 此组合索引可以加速查询,这些查询按活动类型和活动日期过滤用户活动。

**数据压缩:**

压缩用户表中的数据以节省存储空间并提高性能。

**代码块:**

```sql

ALTER TABLE users ROW_FORMAT=COMPRESSED;

```

**逻辑分析:**

* `ROW_FORMAT=COMPRESSED`选项将用户表中的数据压缩,从而减少存储空间。

# 5. MySQL表结构优化总结和展望

### 5.1 表结构优化原则和方法回顾

回顾本文所讨论的表结构优化原则和方法,我们可以总结出以下核心要点:

- **范式化和数据建模:**遵循范式化原则,消除数据冗余和异常,提高数据完整性和一致性。

- **数据类型和长度选择:**根据数据特征选择合适的字段类型和长度,优化存储空间并提高查询效率。

- **索引设计和使用:**建立适当的索引,加速数据查询,减少磁盘IO和CPU消耗。

- **表分区和分片:**对大型表进行分区或分片,分散数据存储和处理,提高并发性和可扩展性。

- **表数据清理和优化:**定期清理冗余数据、压缩数据和优化表结构,保持表结构的健康和性能。

- **表结构变更和迁移:**遵循变更原则,安全高效地进行表结构修改和数据迁移,避免数据丢失或损坏。

### 5.2 未来趋势和研究方向

随着数据量和数据复杂性的不断增长,表结构优化将面临新的挑战和机遇。以下是一些未来趋势和研究方向:

- **自动表结构优化:**利用机器学习和人工智能技术,自动分析和优化表结构,提高优化效率和准确性。

- **云原生表结构优化:**针对云原生数据库和分布式系统,探索新的表结构优化策略和技术,适应云计算的弹性和可扩展性特点。

- **异构数据源表结构优化:**随着数据集成和异构数据源的广泛应用,研究如何优化跨不同数据源的表结构,实现高效的数据访问和处理。

- **实时表结构优化:**探索实时表结构优化技术,应对不断变化的数据特征和业务需求,实现动态调整和优化。

0

0