PFC3D并行处理技术:加速大规模模拟的10大技巧

发布时间: 2024-12-15 18:15:58 阅读量: 2 订阅数: 5

pfc-code.zip_PFC_pfc程序_颗粒_颗粒模拟

参考资源链接:[PFC3D完全命令指南:从入门到精通](https://wenku.csdn.net/doc/ukmar0xni3?spm=1055.2635.3001.10343)

# 1. PFC3D并行处理技术概述

PFC3D(Particle Flow Code in 3 Dimensions)是ITIS(Itasca Consulting Group, Inc)公司开发的一款用于颗粒流数值模拟的软件。它广泛应用于岩土工程、矿山开采和地质力学研究等领域。随着科学计算的复杂性日益增加,对计算资源的需求也随之增长。传统的串行计算方法难以满足大规模和高精度模拟的要求,而并行处理技术以其强大的计算能力成为解决此问题的关键。

并行处理技术的核心在于将计算任务分散到多个处理单元中,从而大幅缩短问题解决的时间。PFC3D软件通过利用多核处理器、GPU加速器或分布式计算集群,能够执行大规模并行计算,提高模拟效率和精确度。在本章中,我们将介绍并行处理技术的基础知识,并对PFC3D并行技术作一个概览,为进一步深入学习并行技术打下基础。

# 2. ```

# 第二章:并行处理的基础理论

## 2.1 并行计算模型

### 2.1.1 分布式与共享内存模型

在并行计算领域,分布式内存模型和共享内存模型是两种主要的计算范式,它们各自具有独特的特点和适用场景。

分布式内存模型(Distributed Memory Model)是通过网络连接的独立计算节点集合,每个节点拥有自己的本地内存。节点间通过发送消息进行通信,常见的应用包括大规模科学计算和分布式数据库。这种模型的优点在于伸缩性好,可以使用廉价的硬件组成计算集群;但其缺点也显而易见,通信开销大,编程复杂度高。

共享内存模型(Shared Memory Model)中,多个处理器通过共享同一块内存来实现数据交换。由于硬件级别的缓存一致性协议(如MESI),共享内存模型的编程相对简单。然而,它在处理大量处理器时可能遭遇内存带宽和延迟的瓶颈。

```mermaid

graph LR

A[开始] --> B[选择计算模型]

B --> C{分布式内存模型?}

C -- 是 --> D[实现消息传递接口MPI]

C -- 否 --> E{共享内存模型?}

E -- 是 --> F[实现多线程或多进程]

E -- 否 --> G[其他模型]

D --> H[结束]

F --> H

```

### 2.1.2 并行算法的基本原理

并行算法设计的核心是将一个大问题拆分成若干小问题,再利用多个处理单元同时执行这些小问题,最后再将结果合并。这里的关键是“拆分”和“合并”的策略。

拆分问题时需要确保各子问题间最小化依赖关系,以减少处理器间的通信开销。此外,负载平衡也是并行算法设计中不可或缺的考虑点,即确保每个处理器的工作负载大致相同,避免出现某些处理器空闲而其他处理器过载的情况。

```markdown

| 并行算法设计原则 | 解释 |

| ---------------- | ---- |

| 细粒度并行 | 任务划分得足够小,增加并行度 |

| 负载平衡 | 各处理器工作量均衡 |

| 最小化通信 | 减少处理单元间的数据交换 |

| 避免竞争条件 | 确保数据一致性 |

| 扩展性 | 支持不同规模的并行系统 |

```

## 2.2 并行计算机架构

### 2.2.1 CPU与GPU的并行架构

中央处理单元(CPU)和图形处理单元(GPU)是两种常见的并行架构。CPU采用多核心的设计,每个核心拥有较复杂的控制逻辑和较长的流水线,适用于执行复杂的顺序任务。相比之下,GPU拥有成百上千个小核心,每个核心专注于处理相对简单的任务,适合高度并行的计算工作,如图形渲染和科学计算。

两者在并行性能上有各自的优势,CPU擅长处理串行部分和协调整个系统的工作,而GPU在执行大量并行任务时显示出更高的效率。

### 2.2.2 多核心处理器的优势与挑战

随着摩尔定律的演进,传统的单核处理器性能提升已遇到瓶颈,多核心处理器成为主流。其优势在于能够显著提高计算性能,尤其适合需要大量数据处理的并行计算任务。

不过,多核心处理器也带来了新的挑战。编程模型需要能够充分利用多核心,这就要求程序员深入理解并行编程并采用合适的算法。此外,内存带宽和功耗控制也是多核心处理器架构设计的重要考虑因素。

## 2.3 并行程序设计范式

### 2.3.1 数据并行与任务并行

数据并行(Data Parallelism)指的是将数据集划分为多个子集,然后对每个子集执行相同的运算。这种范式简化了并行编程的复杂性,常见的实现包括向量处理和矩阵乘法。

任务并行(Task Parallelism)涉及同时执行多个不同的任务,这些任务可能涉及不同的代码路径和数据集。在多核处理器或分布式系统中,任务并行通过并发地执行不同代码段来提高效率。

```mermaid

graph LR

A[开始并行程序设计] --> B[确定并行化策略]

B --> C{数据并行?}

C -- 是 --> D[划分数据集并执行相同操作]

C -- 否 --> E{任务并行?}

E -- 是 --> F[分配独立任务到不同处理器]

E -- 否 --> G[考虑其他并行范式]

D --> H[结束]

F --> H

```

### 2.3.2 并行编程语言和框架

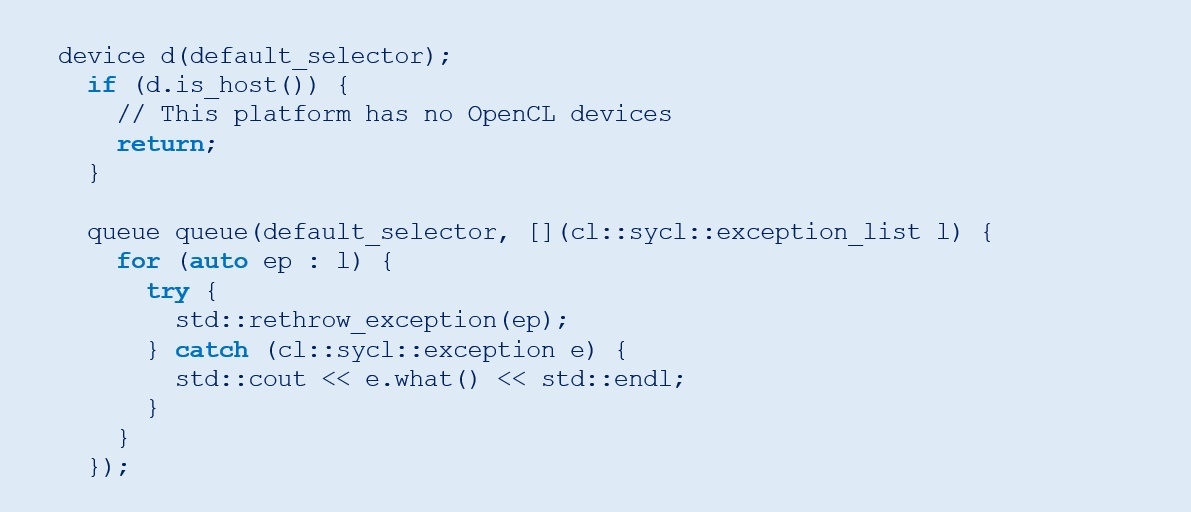

并行编程语言和框架提供了简化并行程序设计的工具和库。例如,OpenMP和MPI是实现共享内存和分布式内存模型的常用库。它们通过提供线程管理和进程间通信的抽象,使得并行编程更加高效和可移植。

随着近年来硬件的发展和并行编程需求的增加,也出现了许多高级并行编程框架,如Apache Spark和TensorFlow,它们提供了更高级的抽象,如大数据处理和机器学习算法的并行实现。

以上内容只是本章的概述,后续章节将深入探讨各个子话题,提供更加详细的分析和应用实例。

```

# 3. PFC3D并行计算技巧详解

### 3.1 网格划分与负载平衡

在进行大规模并行计算时,如何高效地对网格进行划分以及如何在多个处理器间实现负载平衡是核心的优化课题。有效的网格划分能够确保计算资源被充分利用,同时减少处理器间的通信开销。

#### 3.1.1 有效划分网格的方法

在PFC3D中,物理模型通常被划分为多个网格。根据模型的特性和并行计算的需求,划分网格的方法主要有两种:静态划分和动态划分。静态划分在计算开始前完成,适用于计算过程中数据变化不大的场景。而动态划分则允许在计算过程中根据负载情况动态调整网格的分布,这能够更好地适应复杂的模拟需求。

实现静态网格划分的伪代码示例如下:

```python

# 伪代码:静态网格划分

def static_grid_partition(total_grids, num_processors):

partition = []

grids_per_processor = total_grids // num_processors

for i in range(num_processors):

start = i * grids_per_processor

end = (i + 1) * grids_per_processor if i < num_processors - 1 else total_grids

partition.append((start, end))

return partition

```

在这个示例中,`total_grids` 表示网格总数,`num_processors` 表示处理器的数量。函数`static_grid_partition`返回一个列表,其中包含每个处理器应处理的网格范围。

动态网格划分则更为复杂,因为它涉及到实时监控计算负载并根据此调整网格分配。这通常需要一个中心控制器来管理整个网格分配的过程,并且需要更多的通信开销来协调各处理器间的工作。

#### 3.1.2 负载平衡技术的实现

实现负载平衡的方法有很多,包括但不限于:

- **无共享负载平衡**:每个处理器负责其网格的计算,几乎无须共享数据,适用于数据局部性较好的情况。

- **有共享负载平衡**:通过共享内存、消息传递等方法,将计算任务在处理器间进行动态分配,这适用于需要频繁交换数据的并行算法。

在PFC3D中,负载平衡通常通过以下几种方式实现:

- **任务窃取(Work Stealing)**:允许空闲的处理器从忙碌的处理器中窃取一部分任务执行。

- **动态调度(Dynamic Scheduling)**:根据当前各处理器的工作负载动态调整任务分配。

- **预测性调度(Predictive Scheduling)**:基于历史数据和模型预测结果来调整负载平衡策略。

以下是工作窃取方法的简单实现:

```python

# 伪代码:工作窃取实现

def work_stealing(processors_load, max_load):

idle_processors = [i for i, load in enumerate(processors_load) if load < max_load]

busy_processors = [i for i, load in enumerate(processors_load) if load >= max_load]

while idle_processors and busy_processors:

i = idle_processors.pop() # 选择一个空闲的处理器

j = busy_processors.pop() # 选择一个繁忙的处理器

# 从繁忙处理器窃取任务,这里简化为随机窃取一部分任务

stolen_tasks = random.choice(

```

0

0