【性能调优不传秘籍】:大数据框架下的ReduceTask与分区数量调优术

发布时间: 2024-10-31 10:33:04 阅读量: 34 订阅数: 23

# 1. 大数据处理与性能调优概览

在如今这个数据量爆炸的时代,大数据处理已成为企业提升竞争力的核心技术之一。合理利用大数据不仅能为企业提供洞见,还能优化业务流程,提高生产力。然而,随着数据量的增长,如何有效地处理这些数据并从中提取价值成为了新的挑战。这就是性能调优的用武之地。

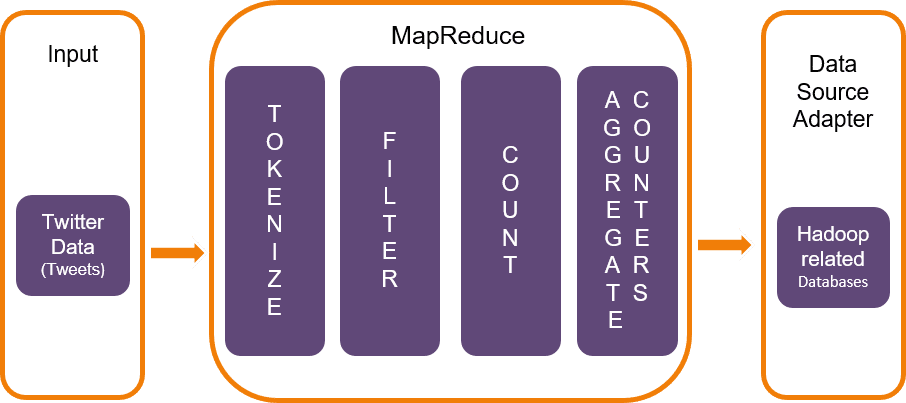

性能调优涉及从硬件资源管理到软件算法优化的方方面面,而大数据处理则是一项复杂的工作,需要对整个数据处理流程有深刻的理解。例如,在Hadoop的MapReduce框架中,数据处理分为Map和Reduce两个主要阶段。有效的性能调优需要考虑数据的读取、处理、输出以及中间结果的存储等多个环节。性能调优不单是提升执行速度,也包括改善系统稳定性、减少资源浪费以及提高成本效益等。

接下来的章节将深入探讨ReduceTask的工作原理、数据分区对性能的影响、优化工具与监控策略,并通过案例研究展示如何在实际中应用这些知识以提升大数据处理的效率。

# 2. ReduceTask的工作原理与性能影响因素

## 2.1 ReduceTask的基本概念和作用

### 2.1.1 MapReduce工作流程中的ReduceTask

ReduceTask是MapReduce框架中不可或缺的一部分,它负责对经过Map阶段处理后的中间数据进行合并和汇总。在MapReduce的处理流程中,Map阶段通常会产生大量的小数据片段,而Reduce阶段的任务则是将这些数据片段按照一定的键值(key)进行合并,执行归纳操作,最终输出结果。

具体来说,MapReduce的执行流程大致如下:

1. 输入数据被分片,分片交由Map任务处理。

2. 每个Map任务处理分片中的数据,并输出中间的键值对。

3. 这些键值对会被传输到Reduce任务中,这个过程中会涉及一个称为“Shuffle”的步骤,这个步骤包括排序和复制。

4. Shuffle完成后,相同键值的键值对会被聚集到一起,并交给ReduceTask。

5. ReduceTask对这些键值对进行归约操作,生成最终结果。

在这个过程中,ReduceTask的工作非常关键,它决定了数据是否能够正确地合并,以及合并的效率如何。因此,了解ReduceTask的工作原理对于优化整个MapReduce作业的性能至关重要。

### 2.1.2 ReduceTask的参数与性能的关系

ReduceTask的性能受到多个参数的影响,这些参数可以在作业提交时通过配置来调整。以下是一些关键的参数及其对性能的影响:

- **`mapreduce.job.reduces`**:这个参数用于指定作业中ReduceTask的数量。增加或减少ReduceTask的数量直接影响到最终的Shuffle阶段的数据传输量和归约操作的负载分配。

- **`mapreduce.reduce.memory.mb`**:这个参数决定了ReduceTask可以使用的内存量。在执行归约操作时,如果内存不足,可能会导致频繁的垃圾回收,影响性能。

- **`mapreduce.reduce.cpu.vcores`**:这个参数用于设置ReduceTask可以使用的CPU核心数。核心数的多少将直接影响到归约操作的并行处理能力。

正确地配置这些参数,需要根据实际的数据量、硬件资源以及作业的特定需求来进行。在后续的章节中,我们将详细介绍如何根据不同的性能影响因素调整这些参数,以及这些调整对整体性能的具体影响。

## 2.2 影响ReduceTask性能的关键因素

### 2.2.1 数据倾斜问题与应对策略

数据倾斜是指在MapReduce作业中,数据分布不均匀,导致部分ReduceTask处理的数据量远大于其他任务。这种情况会导致整个作业的处理时间被拖长,因为所有任务都必须等待数据倾斜的ReduceTask完成。

解决数据倾斜问题有几种常用策略:

1. **预先处理**:在Map阶段就进行数据均衡,通过自定义Partitioner保证键值的分布均匀。

2. **拆分处理**:如果数据倾斜是由某些特定的键值引起的,可以将这些键值单独处理,以减少对其他ReduceTask的影响。

3. **聚合稀疏键**:对于出现频率较低的键值,可以将它们合并到一起处理,以减少倾斜。

具体实现可以通过配置自定义的Partitioner类来实现,例如下面的代码段展示了如何创建一个简单的自定义Partitioner:

```java

import org.apache.hadoop.mapreduce.Partitioner;

import org.apache.hadoop.io.Text;

public class CustomPartitioner extends Partitioner<Text, Text> {

@Override

public int getPartition(Text key, Text value, int numPartitions) {

// 自定义分区逻辑,根据key的哈希值来决定分区

return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

}

}

```

在实现自定义Partitioner后,需要在作业配置中指定它:

```java

job.setPartitionerClass(CustomPartitioner.class);

```

### 2.2.2 Reduce任务数量的调整原则

Reduce任务数量的调整原则需要综合考虑数据量、集群资源和作业特性。理论上,适当的增加Reduce任务数量可以减轻单个任务的处理负担,从而提高并行处理能力。但过多的Reduce任务会带来额外的开销,例如过多的中间数据传输和更多的Shuffle操作。

调整Reduce任务数量的步骤如下:

1. 初始时可以设置一个较为合理的值,该值通常由经验决定,或者参考集群的资源情况。

2. 运行作业后,监控作业执行情况,查看各个Reduce任务的负载是否均匀。

3. 如果发现有任务处理时间远长于其他任务,可能是数据倾斜,或是Reduce任务数量设置不当。

4. 根据观察结果,适当调整Reduce任务数量,并重复执行监控步骤,直到找到最佳值。

### 2.2.3 Reduce内存和CPU资源的合理分配

合理分配Reduce内存和CPU资源是提高ReduceTask性能的关键。在Hadoop和Spark等大数据处理框架中,可以通过调整作业配置参数来实现资源的动态分配。

对于内存资源的分配,可以考虑以下几点:

- **内存大小**:根据Reduce阶段的内存需求来调整。如果处理过程中频繁发生内存溢出(Out of Memory, OOM),则应适当增加内存配置。

- **内存管理和优化**:优化JVM的垃圾回收策略,合理配置内存分配比例,减少内存浪费。

CPU资源分配则关注于:

- **核心数**:合理设置Reduce任务可用的CPU核心数。核心数不宜过多,否则会导致CPU资源竞争;也不宜过少,以免无法充分发挥硬件的并行处理能力。

下面是几个调整资源分配的代码示例:

```java

```

0

0