【GPU加速与Complex-YOLO】:提升检测效率的实用技巧

摘要

GPU加速技术已成为提升深度学习模型性能的关键途径,特别是对于目标检测算法如Complex-YOLO模型的快速处理至关重要。本文首先概述了GPU加速技术的基本原理和优势,随后深入介绍了Complex-YOLO模型的基础知识及其演进过程。针对Complex-YOLO在GPU上的实现,文章详细分析了CUDA编程模型和内存管理策略,并探讨了在算法和框架层面上的优化方法。为了进一步提升性能,本文还讨论了性能基准测试、深度学习加速库的使用,以及模型量化与剪枝技术。通过对实时视频监控和智能交通系统中应用案例的分析,本文展示了Complex-YOLO在实际环境中的应用效果和遇到的挑战。最后,文章展望了Complex-YOLO及GPU加速技术未来的发展方向和趋势,指出了新硬件架构的探索与模型压缩优化技术的研究前景。

关键字

GPU加速;Complex-YOLO模型;CUDA编程;性能优化;深度学习加速库;模型量化与剪枝

参考资源链接:Complex-YOLO:点云实时3D物体检测的革新方案

1. GPU加速技术概述

随着人工智能和深度学习的兴起,GPU加速技术已成为IT行业中的一个热门话题。GPU(图形处理单元)最初为图形渲染和图像处理而设计,但由于其具备大量并行处理能力,它同样适用于计算密集型任务,比如深度学习模型的训练和推理。与CPU相比,GPU拥有成百上千个小核,能够同时处理成千上万个线程,极大地提升了计算性能,尤其在处理矩阵乘法和卷积运算时,表现更为突出。在这一章中,我们将探讨GPU加速技术的基础知识,理解其工作原理,以及它如何被应用在复杂度高的模型如YOLO中,特别是在YOLO的变种之一—Complex-YOLO中。通过本章学习,读者将获得对GPU加速技术的初步认识,为理解后续章节中YOLO模型与GPU的结合打下基础。

2. Complex-YOLO模型基础

2.1 YOLO算法的演进

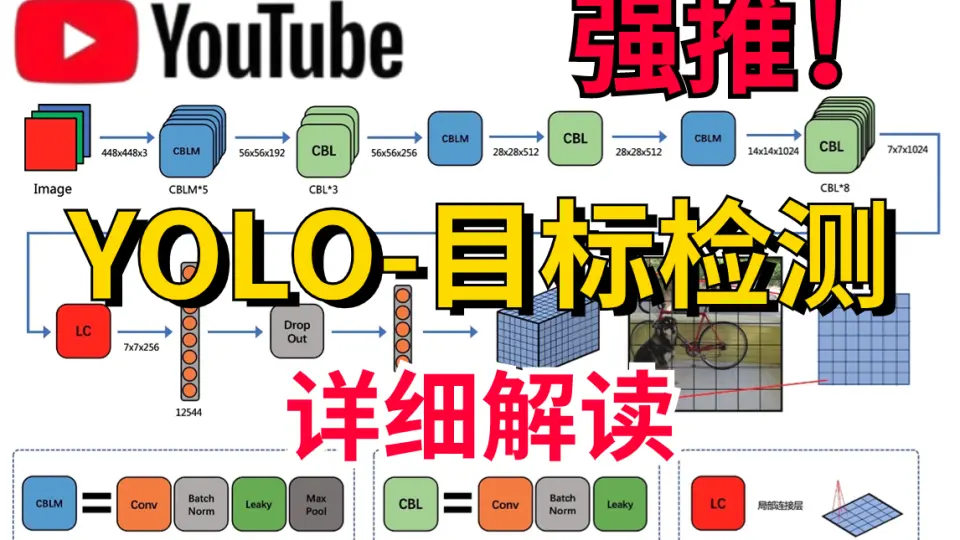

2.1.1 YOLOv1到YOLOv3的变革

YOLO(You Only Look Once)算法自首次发布以来,经历了几个重要的版本升级。YOLOv1作为开山之作,将目标检测任务看作是一个回归问题,它将图像分割成一个个格子,每个格子负责预测边界框和类别概率。YOLOv1在速度上取得了重大突破,每秒处理图像数量可达到45帧,但其检测精度尤其是对小物体的检测效果不佳。为了克服这些问题,YOLOv2引入了多尺度训练、Darknet-19等新技术,提高了定位和分类的精度。到了YOLOv3,算法引入了多标签分类和多尺度预测,使用Darknet-53作为特征提取网络,并在不同的尺度上进行预测,显著提高了小物体的检测精度,同时保持了较高的处理速度。

2.1.2 YOLOv4的关键改进

YOLOv4在YOLOv3的基础上,继续在精度、速度和易用性上进行了提升。YOLOv4引入了更多的深度学习技巧,比如Mish激活函数、自对抗训练和CSPNet架构,这些改进显著提高了模型性能。YOLOv4还集成了多种加速和优化技术,如Scale Pyramid Networks、SAM等,使模型在保持速度的同时,进一步提升了检测的准确性。此外,YOLOv4支持多种后端和头部,为用户提供了更多的配置选择,使得该模型在工业界和学术界都得到了广泛的应用。

2.2 Complex-YOLO的创新点

2.2.1 引入深度可分离卷积

为了进一步提高模型的性能,Complex-YOLO在YOLO系列的基础上引入了深度可分离卷积技术。深度可分离卷积是一种轻量级的卷积操作,它将标准卷积操作分解为深度卷积和逐点卷积两个部分,大大减少了模型的参数量和计算量。这种技术在保持检测精度的同时,显著提升了模型在复杂场景下的处理速度。

2.2.2 容器化网络的设计

Complex-YOLO的另一个创新点在于它的网络架构设计,其采用了容器化网络,将不同类型的卷积层、池化层和激活层等进行有效组合,形成具有特定功能的子网络模块。通过这样的设计,Complex-YOLO能够更好地处理各种尺度和形状的目标,提高了模型对复杂图像的理解和表征能力。这种设计思想为复杂场景下的目标检测提供了强大的支持。

在接下来的章节中,我们将深入探讨Complex-YOLO在GPU上的实现和优化策略,以及如何通过各种实践来提升其性能。这包括CUDA编程模型、内存管理以及针对特定硬件平台的性能基准测试,还有集成深度学习加速库等实践案例。

3. Complex-YOLO的GPU实现

GPU加速技术在深度学习领域发挥着至关重要的作用,尤其是在实时计算机视觉任务,例如目标检测领域。本章节专注于GPU实现的细节,特别是针对Complex-YOLO模型的优化。我们将深入探讨GPU并行计算原理,以及如何将这些原理应用于Complex-YOLO的性能提升。

3.1 GPU并行计算原理

3.1.1 CUDA编程模型

CUDA(Compute Unified Device Architecture)是由NVIDIA推出的并行计算平台和编程模型。它允许开发者使用C语言类似的语法直接在GPU上执行代码,即编写所谓的kernel函数,由GPU中的成百上千个核心并行执行。

- // CUDA kernel函数示例

- __global__ void vectorAdd(float *A, float *B, float *C, int numElements) {

- int i = blockDim.x * blockIdx.x + threadIdx.x;

- if (i < numElements) {

- C[i] = A[i] + B[i];

- }

- }

- // 主机代码调用核函数

- int main() {

- // 分配和初始化主机内存、设备内存

- // ...

- // 调用核函数

- int threadsPerBlock = 256;

- int blocksPerGrid = (numElements + threadsPerBlock - 1) / threadsPerBlock;

- vectorAdd<<<blocksPerGrid, threadsPerBlock>>>(d_A, d_B, d_C, numElements);

- // 同步主机和设备内存

- // ...

- return 0;

- }

在上述代码中,vectorAdd是一个简单的向量加法核函数,它将被分配到GPU执行。blockDim和blockIdx用于计算