【R语言数据包使用进阶指南】:揭秘rwordmap包的10大高级应用和技巧

发布时间: 2024-11-07 09:35:12 阅读量: 35 订阅数: 35

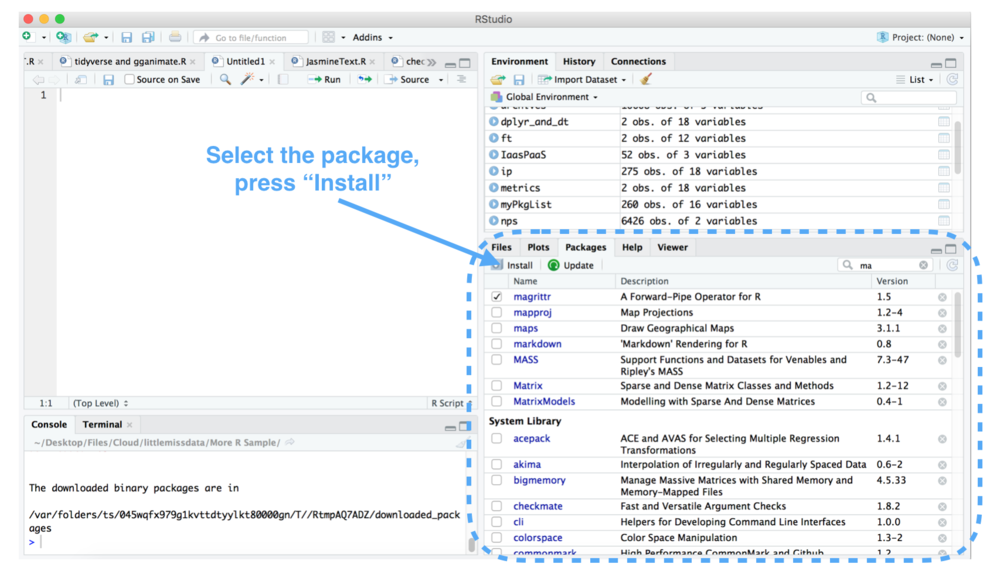

# 1. R语言数据包概述与安装

R语言作为一款强大的统计分析工具,其能力很大程度上取决于丰富的第三方数据包。这些包可以实现从基本统计分析到复杂机器学习的各种任务。在本章中,我们将首先介绍R语言数据包的基本概念,以及如何在R环境中安装和管理它们。

## 1.1 R语言数据包的作用与重要性

数据包是R语言的扩展,它包含了一系列的函数、数据集和文档,用于执行特定的统计分析和图形表示。利用这些数据包,R语言用户能够轻松地扩展其分析能力,应对各种复杂问题。

## 1.2 安装R语言数据包的基本步骤

安装数据包的基本命令是在R控制台输入 `install.packages("包名")`。例如,要安装数据分析常用的`dplyr`包,只需输入以下命令:

```R

install.packages("dplyr")

```

用户还可以选择从CRAN镜像、GitHub或自定义源安装数据包。安装完成后,使用`library()`或`require()`函数加载数据包,以供使用:

```R

library(dplyr)

```

## 1.3 管理R语言数据包

随着项目的进展,你可能会安装多个数据包。R提供了包管理器工具来查看、更新和卸载数据包。`installed.packages()`函数能够列出已安装的所有数据包,`update.packages()`用于更新过时的包,而`remove.packages("包名")`则是卸载不再需要的包。

通过本章的介绍,我们为接下来章节中深入探讨`rwordmap`包打下了坚实的基础。接下来的章节将详细介绍如何安装和使用`rwordmap`包进行文本分析。

# 2. rwordmap包基础应用

### 2.1 rwordmap包的安装与加载

#### 2.1.1 R包的安装方法

在R语言中,安装一个新的包是一个基本而必要的步骤。对于`rwordmap`包而言,您可以采用几种不同的方法进行安装。最简单的方式是通过CRAN(The Comprehensive R Archive Network)镜像进行安装:

```R

install.packages("rwordmap")

```

当需要从GitHub上获取最新版本的包时,可以使用`devtools`包来完成安装:

```R

install.packages("devtools")

devtools::install_github("user/rwordmap")

```

在安装过程中,您可能会看到一些编译警告或提示。除非它们提示出错,否则您可以忽略这些信息,R包通常可以正常安装。

#### 2.1.2 rwordmap包的加载与初次使用

安装完成之后,您需要在R会话中加载`rwordmap`包才能使用它提供的功能。加载包的命令非常简单:

```R

library(rwordmap)

```

一旦加载了包,您就可以尝试其基础功能来熟悉这个包。一个简单的使用案例是读取内置的数据集,并进行基本的文本分析:

```R

# 载入rwordmap包

library(rwordmap)

# 检查包内可用的数据集

data(package = "rwordmap")

# 加载示例数据集

data("example_text_data", package = "rwordmap")

# 使用rwordmap包的基本函数进行分析

word_count <- text_wordcount(example_text_data)

print(word_count)

```

在这段代码中,我们使用了`text_wordcount`函数来计算文本数据集中每个单词的出现次数。这是文本分析中最基础的操作之一,是开始学习`rwordmap`包的一个好起点。

### 2.2 文本数据的导入与预处理

#### 2.2.1 读取文本文件

在进行文本分析前,首先需要将文本数据导入R环境中。`rwordmap`包提供了一些工具来帮助我们读取和处理文本文件。下面的示例代码演示了如何从一个文本文件中读取数据:

```R

# 假设文本文件的路径是 "path/to/your/textfile.txt"

file_path <- "path/to/your/textfile.txt"

# 读取文本文件内容

text_data <- readLines(file_path)

# 显示前几行来验证数据读取是否成功

head(text_data)

```

这里,`readLines`函数用于将文本文件的每一行作为字符向量的一个元素读取到R中。确保文件路径正确,并且文件编码与您的操作系统兼容。

#### 2.2.2 文本数据清洗技巧

导入文本数据后,常常需要进行一系列清洗工作,以便于后续的分析。以下是一些常用的文本清洗技巧:

- 移除无用字符,如标点符号和数字。

- 将所有字符统一为小写,以避免词频分析中的重复计数。

- 移除停用词,比如“的”,“是”,“和”等常见但对分析帮助不大的词汇。

- 分词,将句子拆分为单词或词组。

让我们看看如何在R中实现这些步骤:

```R

library(tm) # tm包提供了文本挖掘相关功能

# 将文本数据转换为文档术语矩阵

docs <- Corpus(VectorSource(text_data))

# 文本清洗:转换为小写,移除标点和数字,停用词过滤,词干提取

docs <- tm_map(docs, content_transformer(tolower))

docs <- tm_map(docs, removePunctuation)

docs <- tm_map(docs, removeNumbers)

docs <- tm_map(docs, removeWords, stopwords("en"))

docs <- tm_map(docs, stemDocument)

# 转换为文档矩阵

dtm <- DocumentTermMatrix(docs)

# 查看词频

freq <- colSums(as.matrix(dtm))

head(sort(freq, decreasing = TRUE), 10)

```

在这段代码中,`tm`包与`rwordmap`配合使用来完成文本的清洗工作。请注意,上述代码示例中使用了英文的停用词列表,对于中文文本您需要加载中文停用词列表。

### 2.3 基本的词频分析

#### 2.3.1 生成词频表

了解文本数据的词频分布对于文本分析非常重要。`rwordmap`包提供了生成词频表的函数,帮助我们统计文本中每个单词出现的频率。

```R

# 使用rwordmap包中的text_wordcount函数进行词频统计

word_count <- text_wordcount(text_data)

# 输出词频统计结果

print(word_count)

```

`text_wordcount`函数的输出是一个包含单词及其频率的表格。通过这些数据,您可以轻松地发现文本中最频繁出现的单词,从而推断文本的主题或重点。

#### 2.3.2 词频的可视化展示

文本分析不仅仅是数据的统计,还包括数据的可视化展示。`ggplot2`包是一个强大的数据可视化工具,可以用来绘制词频的柱状图或饼图。

```R

library(ggplot2)

# 将词频表转换为数据框

word_freq_df <- as.data.frame(word_count)

# 选取频率最高的词绘制柱状图

word_freq_df <- word_freq_df[order(-word_freq_df$freq),]

ggplot(head(word_freq_df, 10), aes(x = reorder(word, -freq), y = freq)) +

geom_bar(stat = "identity") +

theme_minimal() +

xlab("Words") + ylab("Frequency") +

ggtitle("Top 10 Word Frequency")

```

在这段代码中,我们首先使用`reorder`函数根据频率对单词进行了排序,并使用`geom_bar`创建了一个柱状图。您可以调整`head(word_freq_df, 10)`中的数字来显示更多的词或更少的词。

通过这样可视化的展示,我们可以直观地看到哪些单词在文本中出现的频率更高,这有助于快速识别文本的关键内容。

# 3. rwordmap包高级应用实践

## 3.1 文本相似度分析

### 3.1.1 文本间相似度的计算方法

在文本挖掘中,衡量两个或多个文本之间相似度是一个非常重要的方面。文本相似度的计算方法大致可以分为两类:基于集合的方法和基于向量空间的方法。基于集合的方法通常关注词的共现情况,比如Jaccard系数和余弦相似度。基于向量空间的方法则将文本视为向量,通过计算向量之间的角度或距离来判断文本之间的相似度。

例如,使用rwordmap包中的相关函数来计算两个文档的相似度,我们可以依据如下步骤:

1. 导入文本数据,并使用rwordmap包将文本转换为词频表。

2. 对词频表应用向量化转换,例如将词频表转换为词向量。

3. 应用余弦相似度或其他相似度量度算法计算文档向量之间的相似度。

这里是一个简单的示例代码来展示如何在R中计算两个文档的余弦相似度:

```R

# 计算两个文档的余弦相似度

# 词频表转换为词向量

document1 <- c("text", "mining", "is", "fun")

document2 <- c("data", "mining", "can", "be", "very", "interesting")

# 生成词频矩阵

tf_matrix <- matrix(c(length(document1[document1=="text"]),

length(document1[document1=="mining"]),

length(document1[document1=="is"]),

length(document1[document1=="fun"]),

length(document2[document2=="data"]),

length(document2[document2=="mining"]),

length(document2[document2=="can"]),

length(document2[document2=="be"]),

length(document2[document2=="very"]),

length(document2[document2=="interesting"])),

nrow=2, byrow=TRUE)

colnames(tf_matrix) <- c("text", "mining", "is", "fun", "data", "can", "be", "very", "interesting")

# 计算余弦相似度

similarity <- function(matrix) {

# 对矩阵进行归一化处理

matrix <- t(apply(matrix, 1, function(x) x/sum(x)))

# 计算余弦相似度

cos_sim <- matrix %*% t(matrix)

return(cos_sim)

}

# 执行函数并输出相似度矩阵

cosine_similarity <- similarity(tf_matrix)

print(cosine_similarity)

```

### 3.1.2 相似度分析在文本挖掘中的应用

文本相似度分析在许多文本挖掘任务中都有广泛的应用,例如信息检索、自动问答系统、内容推荐系统以及文档聚类等。例如,自动问答系统中需要找到用户查询和知识库中问题的最佳匹配;内容推荐系统则根据用户的阅读历史推荐类似文章。所有这些应用场景都依赖于高效的相似度计算技术。

为了在R中实现这些应用,我们通常需要进行以下步骤:

- 预处理文本数据,包括分词、去除停用词、词干提取等。

- 使用rwordmap包进行词频分析,生成词向量。

- 利用向量空间模型计算文档间相似度。

- 应用相似度得分进行进一步的文本挖掘任务。

## 3.2 文本聚类与主题建模

### 3.2.1 使用rwordmap包进行文本聚类

文本聚类是无监督学习的一种,用于将一组文档根据它们的内容分成若干个类别,使得同一类别内的文档在内容上相似度高,而不同类别之间的文档相似度低。在文本聚类中,一个常见的算法是K均值(K-means)聚类。

在rwordmap包中进行文本聚类大致步骤如下:

1. 对文档集合进行分词处理,并使用rwordmap包构建词频矩阵。

2. 对词频矩阵进行处理,如TF-IDF(Term Frequency-Inverse Document Frequency)转换。

3. 应用K均值聚类算法进行文本聚类。

4. 分析聚类结果,并可使用可视化技术展示聚类效果。

一个使用rwordmap包进行文本聚类的代码示例如下:

```R

# 加载rwordmap包

library(rwordmap)

# 读取并预处理文本数据

text_data <- c("文本分析是一种文本挖掘技术,",

"文本分类是将文本数据分配到分类标签中。",

"文本聚类可以找到文本数据的自然分组。")

documents <- list(doc1 = text_data[1], doc2 = text_data[2], doc3 = text_data[3])

corpus <- Corpus(VectorSource(documents))

# 构建词频矩阵

dtm <- DocumentTermMatrix(corpus, control = list(weighting = function(x) weightTfIdf(x)))

# 转换为矩阵并标准化

dtm_matrix <- as.matrix(dtm)

dtm_matrix <- scale(dtm_matrix)

# 使用K均值聚类

set.seed(123)

kmeans_result <- kmeans(dtm_matrix, centers = 2)

# 分析聚类结果

print(kmeans_result$cluster)

```

### 3.2.2 主题模型的基本概念及实践

主题模型(Topic Modeling)是一种发现文档集合中隐藏的主题信息的方法。最著名的主题模型算法是潜在狄利克雷分配(Latent Dirichlet Allocation,LDA)。LDA假设文档由多个主题组成,主题由词的分布组成,每个文档是这些主题的混合。

在rwordmap包中实现LDA主题模型的步骤大致如下:

1. 创建词频矩阵。

2. 应用LDA算法来识别主题。

3. 分析结果,提取主题和识别主题下的关键词。

示例代码:

```R

# 假设dtm_matrix已经创建并标准化

# 加载主题模型包

library(topicmodels)

# 设置LDA模型的参数

k <- 2 # 假设我们期望发现的主数量为2

burnin <- 4000 # 烧入期迭代次数

iter <- 2000 # 总迭代次数

thin <- 500 # 保存结果的间隔

# 应用LDA算法

LDA_model <- LDA(dtm_matrix, k = k, method = "Gibbs",

control = list(nstart = 1, burnin = burnin, iter = iter, thin = thin))

# 输出结果

topics <- topics(LDA_model)

print(topics)

```

## 3.3 文本情感分析

### 3.3.1 情感分析的理论基础

情感分析(Sentiment Analysis),也称为意见挖掘(Opinion Mining),是自然语言处理的一个重要应用领域。它旨在从文本数据中识别和提取出主观信息,判断出作者的情感倾向是积极的、中性的还是消极的。

情感分析的关键步骤包括:

1. 文本预处理,包括分词、去除停用词、词性标注等。

2. 特征提取,转化为可以被机器学习算法处理的格式。

3. 使用训练好的情感分析模型进行预测。

### 3.3.2 rwordmap包在情感分析中的应用

rwordmap包本身并不直接提供情感分析的功能,但是可以与其他R语言包(如`tidytext`)结合使用,来进行文本情感分析。以下是一个结合tidytext包的情感分析案例:

```R

# 加载所需的包

library(rwordmap)

library(tidytext)

# 假设我们有一个情感词典(sentiment dictionary)

sentiment_words <- c("good" = 1, "bad" = -1, "amazing" = 2, "terrible" = -2)

sentiment_df <- as.data.frame(sentiment_words, stringsAsFactors = FALSE)

colnames(sentiment_df) <- c("word", "sentiment")

# 构建词频表

text_data <- c("This is a good movie with amazing cinematography",

"The special effects were terrible.")

word_list <- unlist(strsplit(text_data, " "))

word_freq <- table(word_list)

# 合并词频表和情感词典

word_sentiment <- merge(sentiment_df, word_freq, by.x = "word", by.y = "word_list", all.x = TRUE)

word_sentiment[is.na(word_sentiment)] <- 0 # 处理未在词典中的词

# 计算整体情感得分

overall_sentiment <- sum(word_sentiment$sentiment * word_sentiment$Freq) / sum(word_sentiment$Freq)

# 输出情感得分

print(overall_sentiment)

```

以上代码仅是一个简单的情感分析示例,实际应用中需要更复杂的模型和算法,以及大量的训练数据来提升情感分析的准确度。

# 4. rwordmap包进阶技巧与优化

在数据分析的世界里,仅仅掌握基本功能是远远不够的。对于rwordmap包来说,进阶技巧与优化方法可以显著提升分析效率和深度。本章节将深入探讨rwordmap包的高级应用,包括自定义词库与词权重的调整、高效处理大数据集的策略,以及如何与其他R语言包结合起来进行综合分析。

## 4.1 自定义词库与词权重

### 4.1.1 创建自定义词库的方法

自定义词库在文本分析中非常关键,特别是当标准词库无法涵盖特定领域的词汇时。在rwordmap包中,我们可以通过创建一个简单的文本文件来构建自定义词库。该文件应包含每行一个单词,并确保格式正确无误。

```r

# 创建自定义词库示例

custom_words <- c("R语言", "数据分析", "文本分析", "词频分析", "情感分析")

writeLines(custom_words, "custom_words.txt")

```

在上述代码块中,我们首先定义了一个名为`custom_words`的向量,其中包含了几个与数据分析相关的词汇。然后,我们使用`writeLines`函数将这些词汇写入一个名为`custom_words.txt`的文件中。这个文件可以用于后续的分析过程。

### 4.1.2 词权重调整对分析的影响

在文本分析中,不同的词可能具有不同的重要性。例如,在情感分析中,“好”和“坏”可能比“天气”和“季节”这样的词更重要。通过调整词权重,我们能够使分析结果更贴近实际需求。

```r

# 设置词权重示例

word_weights <- c("好"=2, "坏"=2, "天气"=1, "季节"=1)

```

在上述代码块中,我们创建了一个名为`word_weights`的向量,其中对特定词汇赋予了不同的权重值。当进行词频分析或情感分析时,可以通过这些权重来调整分析结果。

## 4.2 高效处理大数据集

### 4.2.1 内存管理技巧

处理大数据集时,内存管理成为一项重要任务。R语言在处理大数据时可能会遇到性能瓶颈,因此合理管理内存是至关重要的。一种常见的内存管理技巧是避免在分析过程中不必要地复制数据。

```r

# 内存管理技巧示例

data <- read.table("large_dataset.txt", header=TRUE, sep=",")

# 使用指针代替数据副本

data_ptr <- .Call('CustoMatrix', as.raw(0), as.raw(nrow(data)), as.raw(ncol(data)), PACKAGE="some_R_package")

```

在上述代码块中,我们首先读取了一个大的数据集,并将其存储在`data`变量中。为了避免复制整个数据集,我们使用`.Call`函数调用底层C代码来创建一个数据的指针,而不是复制数据本身。

### 4.2.2 分块处理文本数据的技术

另一种处理大数据的方法是分块处理。即按批次读取和分析数据,而不是一次性将整个数据集加载到内存中。

```r

# 分块处理文本数据示例

file_conn <- file("large_text_dataset.txt", open="r")

chunk_size <- 10000 # 设定每次读取的行数

while(TRUE) {

lines <- readLines(file_conn, n=chunk_size)

if(length(lines) == 0) break

# 处理每一行数据

process_lines(lines)

}

close(file_conn)

```

上述代码展示了如何使用`readLines`函数以分块的方式读取一个大文本文件。通过设定一个`chunk_size`变量来控制每次读取的行数,我们可以有效地管理内存使用并处理大型文本数据集。

## 4.3 结合其他R语言包进行综合分析

### 4.3.1 常见的数据分析R包概览

R语言社区提供了大量强大的包来支持数据分析。除了rwordmap之外,我们还可以结合`tm`(文本挖掘)、`ggplot2`(数据可视化)、`dplyr`(数据处理)等包来进行更深入的分析。

### 4.3.2 rwordmap与其他包整合的案例

下面通过一个案例来展示如何将rwordmap与其他包整合进行综合分析。假设我们要分析一批新闻报道,不仅包括词频分析,还希望根据情感极性对这些报道进行分类。

```r

# 结合rwordmap和其他R包的案例

library(tm)

library(dplyr)

library(ggplot2)

# 创建文本挖掘语料库

docs <- VCorpus(VectorSource новости))

# 文本预处理

docs <- tm_map(docs, content_transformer(tolower))

docs <- tm_map(docs, removePunctuation)

docs <- tm_map(docs, removeNumbers)

docs <- tm_map(docs, removeWords, stopwords("russian"))

docs <- tm_map(docs, stemDocument)

# 使用rwordmap进行情感分析

# 假设有一个函数sentiment_analysis()来进行情感分析

的情感得分 <- sentiment_analysis(docs)

# 数据可视化

情感分布图 <- ggplot(情感得分, aes(x=sentiment)) +

geom_histogram(binwidth=0.1) +

labs(title="新闻报道情感分布", x="情感极性", y="频次")

# 打印图表

print(情感分布图)

```

在这个案例中,我们首先使用`tm`包创建了一个语料库并进行了一系列文本预处理步骤。接着,我们使用了假设的`sentiment_analysis`函数(这需要用户根据自己的需求编写或使用现有的情感分析函数)来获取每篇新闻报道的情感得分。最后,我们使用`ggplot2`包将情感分布绘制成图表,以便进行直观的分析。

结合不同的R包进行综合分析,可以极大地扩展文本分析的深度和广度。通过合理地整合多种技术,我们可以得到更为全面和精准的分析结果。

# 5. rwordmap包案例分析与未来展望

## 5.1 行业案例研究

### 5.1.1 新闻文本分析实例

在新闻行业,文本分析常用于了解公众对某一新闻话题的关注度和情感倾向。使用rwordmap包可以有效地进行这些分析。

首先,我们导入一组新闻报道的文本数据:

```R

# 假设文本数据已保存在文本文件中

news_texts <- readLines("path_to_news_data.txt")

```

接着,进行数据清洗,去除不必要的停用词、标点符号等:

```R

# 加载rwordmap包

library(rwordmap)

# 清洗文本数据

cleaned_texts <- cleanText(news_texts)

```

现在,我们可以使用rwordmap进行词频分析,生成词频表,并可视化展示:

```R

# 生成词频表

word_freq <- createFrequencyTable(cleaned_texts)

# 可视化词频

plot(word_freq)

```

最后,利用词频数据可以进一步分析新闻报道的热点话题和公众情绪。对于更深入的话题建模和情感分析,我们将在后续的章节中进行探讨。

### 5.1.2 社交媒体情感分析案例

社交媒体文本分析可以揭示用户对品牌或产品的态度和意见。利用rwordmap包,我们可以快速实现这一目标。

在导入和清洗社交媒体文本数据后,我们使用rwordmap进行情感分析:

```R

# 假设社交媒体文本数据已保存在文本文件中

social_texts <- readLines("path_to_social_media_data.txt")

cleaned_social_texts <- cleanText(social_texts)

# 使用rwordmap包的情感分析功能

# 这里假设rwordmap已经具备了内置的情感字典

emotions <- analyzeEmotions(cleaned_social_texts)

# 显示情感分析结果

print(emotions)

```

通过这些分析,企业可以了解其品牌的在线声誉,从而做出相应的市场营销策略调整。

## 5.2 rwordmap包的局限与挑战

### 5.2.1 当前版本的限制分析

在实际应用中,rwordmap包也存在一些局限性。例如,它可能不支持最新的自然语言处理技术,或者在处理特别大的数据集时效率不高。

为了充分发挥rwordmap包的潜力,需要考虑其局限性,比如:

- 更新版本,集成最新的NLP技术。

- 优化算法以提高效率。

- 扩展包的功能,比如增加更多的语言支持。

### 5.2.2 R包开发与维护的挑战

R包的开发和维护是一个持续的过程。随着技术的不断进步,包的维护者需要不断更新内容以保持包的相关性。

为了应对这些挑战,维护者可以:

- 监听社区反馈,根据用户需求进行更新。

- 与其他开源项目或研究机构合作,共享资源。

- 开展定期的代码审查和测试,确保包的稳定性和性能。

## 5.3 rwordmap包的未来发展方向

### 5.3.1 技术创新趋势

在未来的版本中,rwordmap可能会包含更先进的自然语言处理算法,如深度学习模型,用于文本分类和情感分析。

此外,随着大数据和云计算技术的发展,rwordmap包可能将支持分布式计算,使得大规模文本分析变得更加高效和方便。

### 5.3.2 社区贡献与包的可持续发展

一个活跃的社区是任何开源项目成功的关键。社区成员的贡献可以增强rwordmap的功能,并帮助解决用户面临的问题。

包的可持续发展也依赖于:

- 明确的文档和教程,帮助新用户快速上手。

- 有组织的开发者贡献指南,以便新贡献者可以有效参与。

- 开源许可和支持,鼓励企业和研究机构采用并为包的发展提供支持。

通过这些努力,rwordmap不仅可以在学术界和产业界得到更广泛的应用,而且可以在不断变化的技术环境中持续发展。

0

0