【JSON解析新境界】:掌握simplejson.scanner流式解析与增量处理

发布时间: 2024-10-12 00:07:59 阅读量: 33 订阅数: 16

simpleJSON:JSON解析库的简单实现

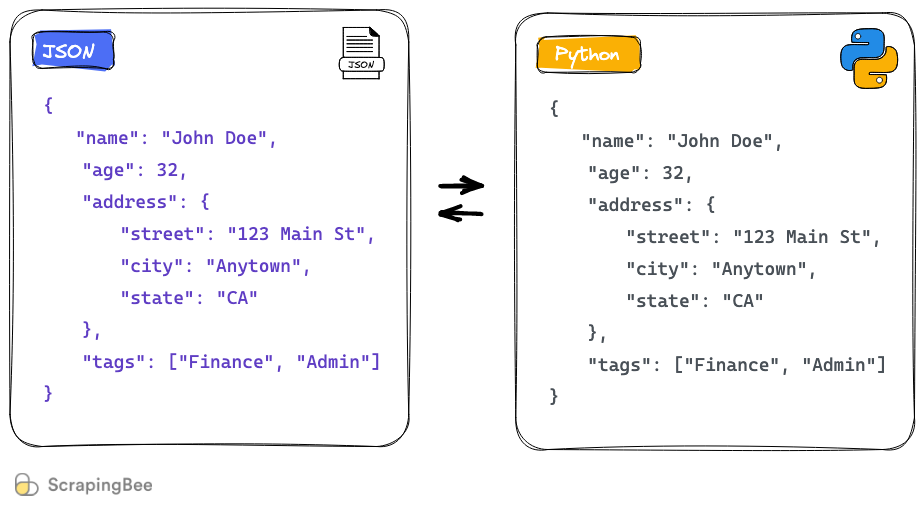

# 1. JSON解析技术概述

JSON(JavaScript Object Notation)作为一种轻量级的数据交换格式,广泛应用于Web开发中。它是基于文本的,易于人们阅读和编写,同时也易于机器解析和生成。JSON的解析技术是数据处理的核心,它将文本数据转换为计算机程序可以操作的数据结构,如字典或列表等。从最初的简单需求到现在复杂的场景,JSON解析技术一直在不断发展以满足日益增长的性能和安全要求。其背后的核心挑战之一是如何高效且准确地解析这种结构化数据,尤其是在处理大规模数据流时。解析技术的好坏直接影响到应用的性能和稳定性。在接下来的章节中,我们将深入探讨simplejson.scanner这一Python库中的关键组件,它在处理JSON解析上展现出的优异性能和灵活性。

# 2. simplejson.scanner的基本概念

## 2.1 simplejson.scanner的定义和应用场景

### 2.1.1 解析技术背景

在计算机科学中,JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。它基于JavaScript的一个子集,但在语言独立性方面得到了很好的定义。随着互联网技术的发展,JSON已经成为了数据交换的主流格式之一。

在处理JSON数据时,尤其是在需要高效率、低内存占用的场合,传统的解析库可能无法满足特定的应用需求。simplejson.scanner,作为simplejson库的一个组件,旨在提供一种简单、高效的方式来扫描和解析JSON数据流,尤其适用于解析大型JSON文件或流式数据。

### 2.1.2 simplejson.scanner的作用和优势

simplejson.scanner的核心优势在于其流式的解析机制。与传统的解析方法不同,流式解析不需要一次性读取整个数据到内存中,而是逐部分地处理数据。这使得simplejson.scanner特别适合于处理大型文件或网络数据流,因为它可以显著减少内存消耗,并提高处理速度。

此外,simplejson.scanner还提供了强大的错误处理机制,使得开发者能够轻松地定位解析过程中的问题,增强了程序的健壮性。同时,其扩展性强,允许开发者根据自己的需求定制解析行为。

## 2.2 simplejson.scanner的工作原理

### 2.2.1 流式解析的概念

流式解析是指在解析JSON数据时,不是一次性将整个数据加载到内存中进行解析,而是逐个字符地读取数据,并逐步构建出数据结构。这种方法特别适合处理大规模的数据流,因为它可以边读取边解析,极大地减少了内存的占用。

与传统的解析方法相比,流式解析避免了需要在内存中存储整个数据结构的开销。这种方法在处理网络数据流或者大型文件时尤为有用,因为它们可能远远超出系统可用内存的大小。

### 2.2.2 增量处理的机制

增量处理是流式解析的核心概念之一,它指的是在解析过程中逐步地处理数据,而不是一次性处理整个数据集。这种机制使得simplejson.scanner可以实时地处理数据,无需等待整个数据集的到达。

这种处理机制允许simplejson.scanner在解析过程中即时地构建出数据结构,对内存的占用较小,并且能够支持连续的数据流输入。因此,对于实时数据处理场景,如服务器日志分析、实时数据监控等应用来说,增量处理显得尤为重要。

```python

import simplejson.scanner

# 示例代码:使用simplejson.scanner解析JSON数据流

def parse_json_stream(stream):

scanner = simplejson.scanner.JSONScanner(stream)

while True:

try:

obj = scanner.scan_once()

if obj is not None:

print("Parsed object:", obj)

else:

break

except ValueError as e:

print("ValueError:", e)

break

# 假设我们有一个数据流stream,可以是文件流,网络流等

parse_json_stream(stream)

```

在上述代码示例中,`simplejson.scanner.JSONScanner`类被用于逐块解析JSON数据流。`scan_once`方法每次被调用时,都会处理数据流中的下一个JSON值。如果读取到了完整的JSON对象,它将返回该对象,否则返回`None`表示没有更多数据可读。如果在解析过程中发生错误,则会抛出`ValueError`异常,可以用来进行错误处理。

通过上述代码的逐行解读,我们可以看到simplejson.scanner在处理数据流方面的灵活性和强大功能。在下一节中,我们将深入探讨simplejson.scanner背后的理论基础。

# 3. simplejson.scanner的理论基础

simplejson.scanner作为一个高效的JSON解析库,在理解其基础理论和架构的同时,我们能更好地掌握其工作原理和优化方向。本章节首先介绍流式解析的理论框架,其次对增量处理的数据流分析进行深入探讨。

## 3.1 流式解析的理论框架

流式解析是一种处理连续数据流的高效方法,它允许我们在数据到达的同时进行解析,而无需等待全部数据都可用。这种解析方式在处理大型数据集时尤其有用,因为它可以减少内存的使用,提高处理速度。

### 3.1.1 分词器(Tokenizer)的工作原理

分词器是流式解析中的第一个组件,它负责将输入的原始JSON数据分解为一系列的标记(tokens)。每一个token代表JSON中的一个最小的语法单位,如数字、字符串、括号等。这种分解过程在编程语言中通常被称为词法分析。

```python

import simplejson.scanner

def tokenize(data):

# 创建分词器实例

tokenizer = simplejson.scanner.JSONTokenizer(data)

for token in tokenizer:

# 处理每一个分词

print(token)

```

在这个代码示例中,`simplejson.scanner.JSONTokenizer`接收一个字符串`data`,然后逐个输出token。这个过程模拟了流式解析的分词阶段,可以让我们更好地理解其工作原理。

### 3.1.2 解析器(Parser)的逻辑结构

解析器接收分词器的输出,并根据JSON的语法规则将这些标记组合成数据结构,通常是字典(dict)或列表(list)。这个过程涉及构建抽象语法树(Abstract Syntax Tree, AST),然后通过遍历AST将数据结构化。

```python

import simplejson.scanner

def parse(data):

# 创建解析器实例

parser = simplejson.scanner.JSONParser(data)

return parser.parse()

```

在这个例子中,`simplejson.scanner.JSONParser`将字符串`data`转化为一个完整的数据结构。

## 3.2 增量处理的数据流分析

增量处理允许数据流逐渐地被处理,这对于大数据量的

0

0