【Python高级编程技巧】:彻底理解filter, map, reduce的魔力

发布时间: 2024-09-18 11:49:23 阅读量: 181 订阅数: 62

Python中的特殊语法:filter、map、reduce、lambda介绍

# 1. Python高级编程技巧概述

在当今快速发展的IT行业中,Python凭借其简洁的语法、强大的库支持以及广泛的社区,成为了开发者的宠儿。高级编程技巧的掌握,不仅能够提高开发者的编码效率,还能在解决复杂问题时提供更加优雅的解决方案。在本章节中,我们将对Python的一些高级编程技巧进行概述,为接下来深入探讨filter、map和reduce函数埋下伏笔。理解这些概念将有助于开发者们构建更加高效、可维护的代码,并在实际项目中应用它们,以实现性能优化和代码简化。

通过本章,读者应能够:

- 理解Python高级编程技巧的定义和重要性。

- 掌握高级编程技巧对代码质量的提升。

- 对后续章节将深入讨论的filter、map、reduce等函数有一个基本了解。

Python高级编程技巧不仅仅局限于语法的高级用法,它还涵盖了设计模式、代码优化、性能调优等多个维度,使得开发者能够从更高的视角审视和编写代码。随着本章内容的展开,我们将为读者们揭示Python编程的深层次秘密,并逐步过渡到更高级的主题,引领读者进入一个高效编程的新境界。

# 2. 深入理解filter, map, reduce函数

## 2.1 filter函数的工作原理与应用

### 2.1.1 filter函数的基本用法

filter函数是Python中的内置函数,它用于过滤序列,过滤掉不符合条件的元素,返回由符合条件元素组成的新列表。filter函数接收两个参数:一个是函数,另一个是序列。函数的返回值决定了序列中的哪些元素会被保留。通常,这个函数会返回True或False。

用法示例:

```python

def is_odd(num):

return num % 2 != 0

numbers = [1, 2, 3, 4, 5, 6, 7, 8, 9]

filtered_numbers = list(filter(is_odd, numbers))

print(filtered_numbers) # 输出: [1, 3, 5, 7, 9]

```

以上代码中,`is_odd` 函数定义了过滤条件,即保留奇数元素。`filter` 函数将这个条件应用于 `numbers` 列表,返回了列表中所有奇数的新列表。

### 2.1.2 filter函数的高级技巧与案例

filter函数可以与lambda表达式结合使用,来实现更简洁的代码。在处理大数据集时,这种方式尤其方便,因为它能够快速筛选出需要的数据子集。

高级技巧示例:

```python

numbers = range(-5, 5)

filtered_numbers = list(filter(lambda x: x > 0, numbers))

print(filtered_numbers) # 输出: [1, 2, 3, 4]

```

在本案例中,使用了lambda匿名函数来直接在filter调用中定义过滤条件,筛选出所有大于0的数字。

表2-1展示了filter函数在一些不同场景下的应用:

| 应用场景 | 函数定义 | 序列示例 | 过滤结果 |

|----------|-----------|------------|------------|

| 筛选偶数 | lambda x: x % 2 == 0 | [1, 2, 3, 4, 5] | [2, 4] |

| 筛选正数 | lambda x: x > 0 | [-3, -1, 0, 2, 4] | [2, 4] |

| 字符串筛选 | lambda s: "e" in s | ["apple", "banana", "cherry"] | ["banana", "cherry"] |

filter函数不仅可以应用于数字列表,还可以用于字符串或其他复杂数据结构的过滤。在处理这些数据时,经常与map和reduce结合使用来达到更复杂的数据处理目标。

## 2.2 map函数的工作原理与应用

### 2.2.1 map函数的基本用法

map函数同样是Python的内置函数,它对可迭代对象中的每个元素应用给定的函数,并返回一个map对象。这个对象是一个迭代器,可以使用list()函数转换成列表。

用法示例:

```python

def square(num):

return num * num

numbers = [1, 2, 3, 4, 5]

squared_numbers = list(map(square, numbers))

print(squared_numbers) # 输出: [1, 4, 9, 16, 25]

```

在这个例子中,`square` 函数被应用到 `numbers` 列表的每个元素上,结果是每个数字都被平方了。

### 2.2.2 map函数的高级技巧与案例

与filter类似,map函数也经常与lambda表达式结合使用,以实现更简洁的代码风格。高级技巧示例:

```python

numbers = [1, 2, 3, 4, 5]

double_numbers = list(map(lambda x: x * 2, numbers))

print(double_numbers) # 输出: [2, 4, 6, 8, 10]

```

这个例子中,使用了lambda表达式来快速定义一个将数字乘以2的函数。map函数将此应用于 `numbers` 列表的每个元素。

表2-2展示了map函数在一些不同场景下的应用:

| 应用场景 | 函数定义 | 序列示例 | 转换结果 |

|----------|-----------|------------|------------|

| 平方数字 | lambda x: x * x | [1, 2, 3, 4, 5] | [1, 4, 9, 16, 25] |

| 字符串长度 | lambda s: len(s) | ["apple", "banana", "cherry"] | [5, 6, 6] |

| 取对数 | lambda x: math.log(x) | [1, math.e, math.e**2] | [0, 1, 2] |

在处理数据转换任务时,map函数通常与filter和reduce函数一起使用,它们可以组合起来执行复杂的操作。

## 2.3 reduce函数的工作原理与应用

### 2.3.1 reduce函数的基本用法

reduce函数位于Python的functools模块中,对序列中的元素进行累积操作。它接收一个函数和一个可迭代对象,然后返回单个值。reduce函数通过反复将前面的结果和下一个元素作为参数传递给函数,从而累积处理整个序列。

基本用法示例:

```python

from functools import reduce

def add(x, y):

return x + y

numbers = [1, 2, 3, 4, 5]

sum_result = reduce(add, numbers)

print(sum_result) # 输出: 15

```

在这个例子中,`add` 函数被用作累积函数,reduce函数计算了列表中所有数字的总和。

### 2.3.2 reduce函数的高级技巧与案例

reduce函数可以用来执行更复杂的累积操作,例如计算最大公约数、计算列表中元素的乘积等。当使用lambda表达式时,可以进一步简化代码。

高级技巧示例:

```python

from functools import reduce

numbers = [1, 2, 3, 4, 5]

product_result = reduce(lambda x, y: x * y, numbers)

print(product_result) # 输出: 120

```

在本示例中,使用了一个lambda表达式来计算列表元素的乘积。

表2-3展示了reduce函数在一些不同场景下的应用:

| 应用场景 | 函数定义 | 序列示例 | 结果 |

|----------|-----------|------------|------------|

| 计算总和 | lambda x, y: x + y | [1, 2, 3, 4, 5] | 15 |

| 计算乘积 | lambda x, y: x * y | [1, 2, 3, 4, 5] | 120 |

| 字符串连接 | lambda x, y: x + y | ["ab", "cd", "ef"] | "abcdef" |

通过累积处理序列元素,reduce函数在数据聚合、统计分析等领域有广泛应用。在实际应用中,经常与filter和map函数结合使用,来完成更多功能强大的数据处理任务。

# 3. filter, map, reduce在数据处理中的实践

## 3.1 数据清洗与过滤

### 3.1.1 使用filter进行条件过滤

数据清洗是数据预处理的重要环节,它包括去除无意义或错误的数据,确保数据集的质量。在Python中,filter函数提供了一种方便的方式来实现条件过滤。Filter函数接受一个函数和一个序列,返回一个迭代器,迭代器中的元素是使得函数返回True的序列中的元素。

```python

# 示例:使用filter过滤奇数

numbers = range(-5, 5)

filtered_numbers = filter(lambda x: x % 2 != 0, numbers)

print(list(filtered_numbers)) # 输出:[-5, -3, -1, 1, 3]

```

在这个例子中,lambda函数`x: x % 2 != 0`定义了过滤条件,即选择序列中的奇数。filter函数根据这个条件返回一个迭代器,我们可以将迭代器转换为列表以查看结果。

使用filter进行数据清洗时,可以将复杂的条件逻辑封装在lambda函数或自定义函数中。这种方式让数据过滤条件清晰且易于维护。结合列表推导式,可以更直观地看到过滤条件和数据集之间的关系,例如:

```python

# 列表推导式实现相同功能

filtered_numbers = [x for x in numbers if x % 2 != 0]

```

### 3.1.2 结合map进行数据转换

数据清洗往往不是孤立的,它通常伴随着数据转换,以满足后续处理或分析的需求。Map函数可以用于这一过程。Map函数对序列中的每个元素执行定义的函数,并返回一个包含结果的迭代器。

```python

# 示例:对过滤后的奇数进行求平方处理

squared_numbers = map(lambda x: x ** 2, filtered_numbers)

print(list(squared_numbers)) # 输出:[25, 9, 1, 1, 9]

```

在这个例子中,map函数接受一个lambda函数`x: x ** 2`和之前filter函数得到的奇数迭代器`filtered_numbers`,返回一个新的迭代器,其中包含对原序列中每个奇数求平方后的结果。

结合filter和map,我们可以创建一个数据处理的流程,首先过滤,然后转换。这对于构建复杂的数据处理管道特别有用。

```python

# 结合filter和map的数据处理流程

def process_numbers(seq):

# 定义转换函数

transform = lambda x: x ** 2

# 过滤和转换

return list(map(transform, filter(lambda x: x % 2 != 0, seq)))

# 处理整个数据集

data = range(-5, 5)

processed_data = process_numbers(data)

print(processed_data) # 输出:[25, 9, 1, 1, 9]

```

这样的处理流程可以在数据预处理阶段被广泛应用,比如对数据集中的数值进行标准化处理、对文本数据进行编码转换等。

## 3.2 高级数据聚合

### 3.2.1 使用reduce进行复杂计算

虽然数据清洗和转换通常是数据处理的第一步,但为了深入理解数据集的特征,我们往往需要执行更复杂的聚合计算,如求和、求最大值、最小值等。在Python中,可以使用reduce函数来实现这些复杂的聚合操作。

```python

# 示例:使用reduce计算数列的总和

from functools import reduce

total_sum = reduce(lambda x, y: x + y, numbers)

print(total_sum) # 输出:0

```

在这个例子中,reduce函数接受一个lambda函数作为累加器,以及一个数值序列。它将累加器函数应用于序列的元素,按序归约整个序列到单一的值。虽然在实际应用中,我们通常使用内置函数如sum来代替reduce,但reduce在某些特定场景下提供了更大的灵活性。

### 3.2.2 利用map和reduce处理分组聚合

在数据处理中,分组聚合也是一个常见任务,比如按类别计算销售总额、按月份计算平均温度等。通过结合map和reduce,我们可以实现这样的分组聚合逻辑。

```python

# 示例:使用map和reduce进行分组聚合计算

from collections import defaultdict

# 假设有一组数据,包含产品ID和对应的销售量

product_sales = [

('product1', 10),

('product2', 15),

('product1', 5),

('product3', 20),

('product2', 12)

]

# 使用defaultdict来创建一个默认为list的字典

grouped_sales = defaultdict(list)

# 使用map函数对数据进行分组

for product, quantity in product_sales:

grouped_sales[product].append(quantity)

# 使用reduce函数计算每个产品的总销量

total_sales_by_product = {product: reduce(lambda x, y: x + y, sales)

for product, sales in grouped_sales.items()}

print(total_sales_by_product) # 输出:{'product1': 15, 'product2': 27, 'product3': 20}

```

在这个例子中,我们首先使用map函数将产品销售数据按产品ID分组。然后,我们对每个分组使用reduce函数计算总销量。这个过程展示了如何利用map和reduce来处理复杂的数据聚合逻辑。

通过组合filter、map和reduce,我们不仅能够构建强大的数据处理流程,还能够灵活应对各种数据清洗和聚合任务。这些工具为数据科学、机器学习、统计分析等领域提供了坚实的基础。在接下来的章节中,我们将探索这些函数的替代方案,以及在真实世界案例中的高级应用。

# 4. 探索filter, map, reduce的替代方案

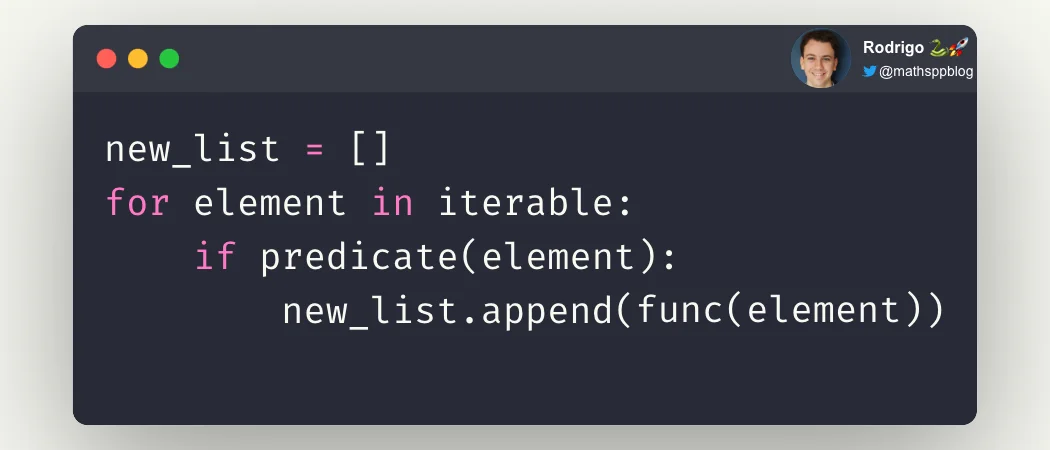

## 4.1 列表推导式与filter的对比

### 4.1.1 列表推导式的效率和可读性分析

列表推导式是Python中一种简洁且高效的构建列表的方法。与filter函数相比,列表推导式通常在性能上更优,因为它在内部实现上进行了优化。同时,列表推导式在代码的可读性方面也更胜一筹,因为它不需要额外的函数调用,且更符合Python的语法规则。

```python

# 使用列表推导式进行过滤

filtered_list = [x for x in range(10) if x % 2 == 0]

```

在上述代码中,列表推导式简洁地完成了一个过滤奇数并保留偶数的任务。其可读性远高于使用filter函数,因为不需要定义额外的函数来实现过滤逻辑。

### 4.1.2 实际案例对比使用

在实际开发中,列表推导式和filter函数可以根据不同的需求和场景进行选择。例如,在需要构建一个复杂的过滤条件时,可能需要使用filter函数结合lambda表达式,但在简单过滤时,列表推导式更为直接和方便。

```python

# 使用filter和lambda进行过滤

filtered_list_with_filter = list(filter(lambda x: x % 2 == 0, range(10)))

```

在上述代码中,filter函数与lambda表达式结合使用,其功能与列表推导式相同,但是代码的直观性和简洁性稍逊一筹。在性能测试中,列表推导式通常更快,特别是在处理大数据集时,性能差异可能更加明显。

## 4.2 函数式编程替代方案

### 4.2.1 使用functools模块增强函数式编程能力

Python中的functools模块提供了一些工具,可以用来增强函数式编程的能力。特别是其中的partial函数,可以用来创建一个新的函数,这个新函数是将原函数的某些参数固定下来。

```python

from functools import partial

def multiply(x, y):

return x * y

# 使用partial固定参数

double = partial(multiply, 2)

# 使用新的函数进行计算

result = double(5) # 等同于 multiply(2, 5)

```

在上述代码中,partial函数被用来创建了一个新的函数double,它固定了multiply函数的第一个参数为2。这样,你就可以用这个新的函数来快速地计算任何数的两倍。

### 4.2.2 探索itertools模块的高级迭代器功能

itertools模块是Python提供的一个用于创建复杂迭代器的工具库。其中的多个函数可以帮助我们在数据处理中实现各种复杂的迭代操作,如groupby、cycle和combinations等。

```python

import itertools

# 使用itertools.groupby进行分组

data = [(1, 'a'), (1, 'b'), (2, 'a'), (2, 'b')]

for key, group in itertools.groupby(data, lambda x: x[0]):

print(f"Key: {key}")

for item in group:

print(f" Item: {item}")

```

在上述代码中,itertools.groupby被用来根据元组的第一个元素进行分组。每个分组被作为一个迭代器返回,并且可以通过循环来遍历分组内的元素。这对于处理需要分组聚合的数据处理任务特别有效。

### *.*.*.* 使用itertools的高级迭代器进行数据处理

使用itertools模块可以简化许多复杂的数据处理任务。例如,处理生成连续整数序列的数据流,可以使用itertools.count函数。

```python

from itertools import count, islice

# 生成一个从1开始的无限序列

counter = count(1)

# 取序列的前5个元素

first_five = list(islice(counter, 5))

print(first_five)

```

在上述代码中,count函数生成了一个无限的整数序列,然后通过islice函数来取出序列中的前五个元素。这是一个非常实用的模式,可以用来替代一些特定的循环结构,使代码更加简洁。

### *.*.*.* 结合使用itertools解决实际问题

itertools模块的函数可以灵活组合使用,解决实际问题。例如,可以通过结合使用permutations和product函数来处理需要生成排列和组合的复杂数据处理任务。

```python

from itertools import permutations, product

# 生成所有可能的两个数字的排列

perms = permutations([1, 2], 2)

print(list(perms))

# 生成两个列表的笛卡尔积

prod = product('ab', 'xy')

print(list(prod))

```

在上述代码中,permutations函数用来生成所有可能的数字排列,而product函数则用来生成两个列表的笛卡尔积。这类函数在数据处理和算法设计中经常用到,可以大幅提高编码效率。

### *.*.*.* 利用itertools提高数据处理效率

在数据处理场景中,尤其是需要高效迭代处理大量数据时,itertools可以提供巨大的帮助。例如,可以使用takewhile函数来处理一个基于条件的迭代器,这在需要处理无限数据流时非常有用。

```python

from itertools import takewhile

# 只取小于10的元素

data = [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]

filtered_data = list(takewhile(lambda x: x < 10, data))

print(filtered_data)

```

在上述代码中,takewhile函数创建了一个迭代器,它会一直返回元素直到某个条件不再满足。这可以用于处理数据流,直到满足特定条件为止,从而提高数据处理的效率。

# 5. 结合真实世界案例的高级应用

## 5.1 处理大规模数据集

在大数据时代,处理和分析大规模数据集已成为常态。Python作为一种解释型语言,在处理大规模数据时需要特别注意性能和效率的问题。幸运的是,Python的标准库提供了filter, map, reduce这三个函数,它们在处理大规模数据集时发挥着重要的作用。

### 5.1.1 在大数据背景下应用filter, map, reduce

在大数据处理中,往往需要从庞大的数据集中提取、转换和聚合信息。filter, map, reduce的组合能够有效地执行这些任务,且通常与并行或分布式计算框架(如Hadoop或Spark)结合使用,以处理PB级别的数据集。

#### 使用filter进行数据筛选

对于大规模数据集,首先需要进行的是数据筛选。filter函数能根据给定的条件,快速筛选出符合条件的数据项。例如,在日志数据分析中,可以通过filter快速筛选出含有特定错误代码的日志条目。

```python

from pyspark import SparkContext

sc = SparkContext()

# 假设logs是一个包含日志条目的RDD

filtered_logs = logs.filter(lambda log: "ERROR" in log["level"])

```

这里,我们创建了一个SparkContext实例`sc`,然后使用filter函数筛选出所有日志级别为"ERROR"的条目。注意,这里的`lambda`函数定义了筛选条件。

#### 使用map进行数据转换

在筛选数据之后,通常需要对数据进行转换。map函数可以根据提供的函数,将每个元素转换成新的形式。在处理文本数据时,map可用于清洗和格式化文本。

```python

def format_log(log):

return f"{log['timestamp']},{log['level']},{log['message']}"

formatted_logs = filtered_logs.map(format_log)

```

在这个例子中,`format_log`函数被用来将每个日志条目格式化为一个简单的CSV格式的字符串。这一步骤对于后续的数据存储或进一步的分析是很有帮助的。

#### 使用reduce进行数据聚合

一旦数据经过筛选和转换,下一步通常是进行数据聚合。reduce函数可以用来对数据进行归纳操作,比如求和、求平均、或实现更复杂的自定义聚合逻辑。

```python

from operator import add

# 假设我们想计算所有错误日志的数量

def error_counter(log1, log2):

return log1 + 1 if "ERROR" in log2["level"] else log1

total_errors = logs.map(lambda log: 1 if "ERROR" in log["level"] else 0).reduce(add)

```

这里,我们定义了一个辅助函数`error_counter`,它用于在reduce过程中累计错误日志的数量。在实际应用中,我们创建了一个映射每个日志条目的值为1或0的RDD,然后使用reduce函数进行累加操作。

### 5.1.2 性能优化与并发处理策略

在处理大规模数据集时,性能优化是不可避免的话题。由于Python的全局解释器锁(GIL),Python的线程在执行CPU密集型任务时可能不会得到预期的性能提升。因此,在进行数据密集型处理时,通常会采用进程级别的并发。

#### 使用进程池优化

Python的`multiprocessing`模块提供了进程池(Pool)的概念,可以用来管理多个进程,有效地分配任务。

```python

from multiprocessing import Pool

def process_log(log):

# 这里是对日志条目的处理逻辑

pass

if __name__ == '__main__':

with Pool(4) as p:

# 将日志数据集分配给进程池进行处理

results = p.map(process_log, logs)

```

在这段代码中,我们创建了一个包含4个进程的池,然后通过`map`方法分配`process_log`函数来处理每个日志条目。这使得程序能够利用多核处理器的优势,提高数据处理速度。

#### 并发框架的使用

除了自己管理进程池,也可以使用高级的并发框架如`concurrent.futures`,它提供了更简单的接口来实现异步执行。

```python

from concurrent.futures import ProcessPoolExecutor

def process_log(log):

# 这里是对日志条目的处理逻辑

pass

with ProcessPoolExecutor() as executor:

# 使用进程池执行器提交任务

results = list(executor.map(process_log, logs))

```

通过使用`ProcessPoolExecutor`,代码更加简洁,且框架内部自动处理了进程创建和任务分配的细节。

## 5.2 结合Web开发的数据处理

在Web开发中,filter, map, reduce这三个函数同样可以发挥作用,尤其是在处理HTTP请求的数据或者进行前后端的数据交互时。

### 5.2.1 在Flask/Django中使用filter, map, reduce

在Flask和Django这样的Web框架中,经常会用到filter, map, reduce来处理HTTP请求中的数据,例如对查询参数的处理或者对数据库查询结果的转换和聚合。

#### 使用Flask进行数据过滤和转换

```python

from flask import Flask, request

app = Flask(__name__)

@app.route('/api/filter', methods=['GET'])

def filter_data():

# 假设有一个JSON格式的查询参数

data = request.args.get('data', type=str)

# 使用filter和map进行数据处理

filtered_data = list(map(lambda x: x.upper(), filter(lambda x: x.isalpha(), data)))

return filtered_data

if __name__ == '__main__':

app.run(debug=True)

```

在上述Flask应用的示例中,我们创建了一个路由`/api/filter`,它接受GET请求并从查询参数中获取数据。然后使用`filter`函数过滤掉非字母字符,并使用`map`将剩余的字母转换为大写。

#### 使用Django进行复杂的数据聚合

在Django中,可以利用reduce函数和ORM的强大功能来实现复杂的数据聚合操作。

```python

from django.db.models import Count

from functools import reduce

def complex_aggregation():

# 假设有一个QuerySet包含文章数据

articles = Article.objects.all()

# 使用reduce和Count进行聚合操作

result = reduce(

lambda x, y: x.update(y) or x,

[{'category__name': category, 'count': Count('category')} for category in articles.values_list('category__name', flat=True).distinct()]

)

return result

# 这个函数可以被其他视图调用或者被绑定到特定的URL路径

```

在这个例子中,我们定义了一个`complex_aggregation`函数,它通过在Article对象的QuerySet上执行聚合操作来统计每个类别的文章数量。

### 5.2.2 实现API中的高效数据处理流程

在构建API时,高效的数据处理流程至关重要。使用filter, map, reduce可以在不牺牲代码可读性的前提下实现高效的数据处理。

#### 使用filter, map, reduce优化数据流

```python

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/api/transform', methods=['POST'])

def transform_data():

data = request.json

# 使用map和filter进行数据处理

transformed_data = list(map(

lambda x: {**x, 'transformed': True},

filter(lambda x: x.get('value') % 2 == 0, data)

))

return jsonify(transformed_data)

if __name__ == '__main__':

app.run(debug=True)

```

这个例子展示了如何在Flask中使用filter和map处理传入的JSON数据。它接收一个包含多个条目的POST请求,然后过滤出偶数值的条目,并在每个条目中添加一个标记。

通过这些实践,filter, map, reduce的组合不仅在数据科学中发挥作用,也能在Web开发领域,特别是在实现高效的数据处理流程中扮演关键角色。

# 6. filter, map, reduce在其他编程语言中的应用

在现代软件开发中,函数式编程的思想正变得越来越流行。Python中的filter, map, reduce这些高阶函数,虽然在Python中有特定的实现,但其背后的概念在其他编程语言中也有类似或等效的构造。本章我们将探索这些高阶函数在JavaScript、Haskell和Erlang等语言中的应用。

## 6.1 JavaScript中的高阶函数探索

JavaScript作为一门在前端开发中几乎无处不在的语言,其函数式编程特性也备受关注。数组对象中的filter, map, reduce方法提供了一种简洁的方式来处理集合。

### 6.1.1 JavaScript中的filter, map, reduce实现

JavaScript中的filter, map, reduce方法与Python中的功能类似,但使用了不同的语法。

```javascript

// JavaScript中的filter用法示例

const numbers = [1, 2, 3, 4, 5];

const evens = numbers.filter(num => num % 2 === 0);

// JavaScript中的map用法示例

const doubled = numbers.map(num => num * 2);

// JavaScript中的reduce用法示例

const sum = numbers.reduce((acc, num) => acc + num, 0);

```

### 6.1.2 实践案例与比较分析

实践中,JavaScript的这些方法在处理数组时非常高效,特别是当涉及到异步操作时,它们可以与Promise对象和async/await语法相结合使用。

```javascript

// 使用async/await结合map处理异步操作

async function fetchUserIds() {

const users = await Promise.all(numbers.map(async num => {

const response = await fetch(`***${num}`);

return response.json();

}));

return users;

}

```

比较分析中可以看出,JavaScript虽然在语法上与Python有所不同,但提供了类似的功能,而且在处理异步事件时提供了额外的便利。

## 6.2 探究函数式编程语言中的类似构造

函数式编程语言如Haskell和Erlang,它们将函数式编程的原则作为其设计的核心。在这些语言中,虽然没有直接的filter, map, reduce等函数,但它们提供了强大的函数式编程特性,能够实现类似的功能。

### 6.2.1 Haskell或Erlang中的对应机制

在Haskell中,列表推导式是处理集合的常用方法,而Erlang则使用列表操作函数,如filter和lists:map/2。

**Haskell:**

```haskell

-- Haskell中使用列表推导式来实现过滤

evens = [ x | x <- [1..10], even x]

-- 使用map实现元素的加倍

doubled = map (*2) [1..10]

-- reduce操作通常通过fold函数来实现

sum = foldl (+) 0 [1..10]

```

**Erlang:**

```erlang

% Erlang中的filter和map实现

Evens = [ X || X <- lists:seq(1, 10), X rem 2 == 0].

Doubled = lists:map(fun(X) -> X * 2 end, lists:seq(1, 10)).

% Erlang中的foldl函数用法

Sum = lists:foldl(fun(X, Acc) -> X + Acc end, 0, lists:seq(1, 10)).

```

### 6.2.2 函数式编程范式的优势与挑战

函数式编程范式的优点在于它的不可变性和纯函数的使用,这使得程序更容易推理和测试。但同时也带来了挑战,如递归的过度使用可能导致性能问题,且对于习惯了命令式编程的开发者来说,理解函数式概念可能需要一段时间。

在本章中,我们探讨了filter, map, reduce在其他编程语言中的对应实现。这些高级编程技巧不仅仅局限于Python,它们在函数式编程语言以及现代JavaScript中都有广泛的应用和体现。通过学习和应用这些概念,开发者可以构建更高效、更可维护的代码。在下一章中,我们将转向在真实世界案例中如何利用这些高级编程技巧来处理大规模数据集和在Web开发中实现高效数据处理。

0

0