Go并发控制:信号量与互斥锁的抉择指南

发布时间: 2024-10-21 00:03:49 阅读量: 21 订阅数: 25

C语言并发控制:信号量与互斥锁的实现与应用

# 1. Go并发模型基础

并发编程是现代软件开发的核心部分,特别是在高性能和高响应性的系统中。Go语言以其简洁的语法和高效的并发模型,成为并发编程的热门选择之一。本章将探讨Go的并发模型基础,为后面深入理解信号量和互斥锁打下坚实的基础。

## 1.1 Go并发模型概述

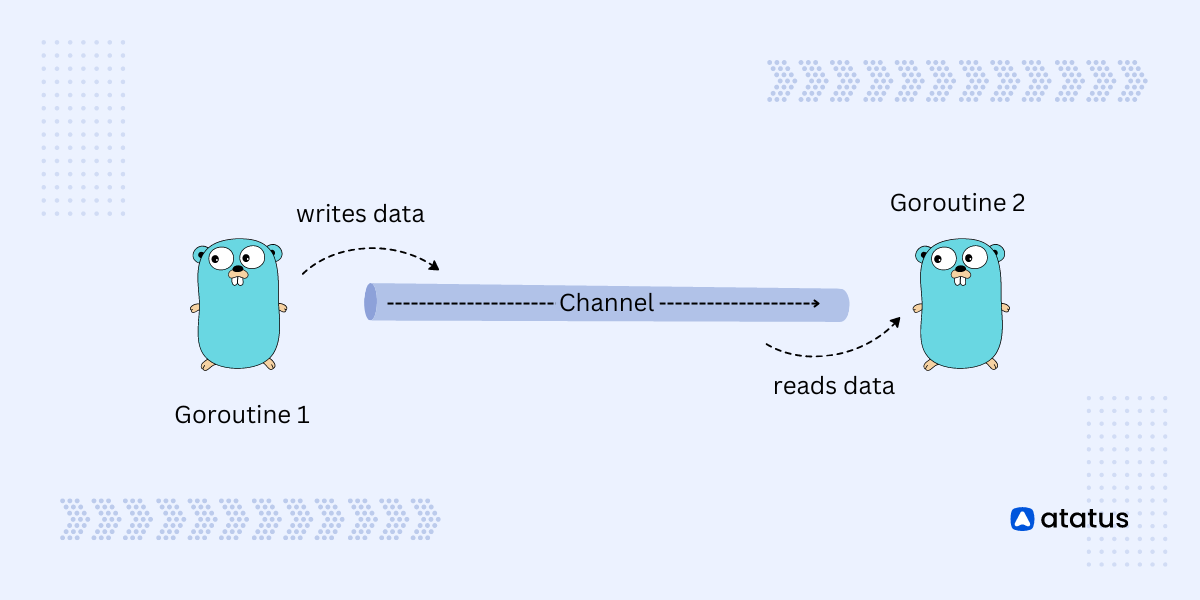

Go并发模型的核心是基于`goroutine`和`channel`的概念。`goroutine`类似于线程,但比线程更轻量级,更易于创建和管理。`channel`则是goroutine之间的通信机制,用于安全地在并发实体间传递数据。

```go

func main() {

go sayHello() // 启动一个新的goroutine

fmt.Println("Hello, World!")

}

func sayHello() {

fmt.Println("Hello from another goroutine!")

}

```

## 1.2 Goroutine的工作原理

Goroutine允许开发者以非常低的开销创建成千上万个并发任务。Go运行时采用M:N调度模型,将多个goroutine映射到少量操作系统的线程上。这种模型减少了线程频繁创建和销毁的开销,也使得CPU的上下文切换开销变小。

在Go中,启动goroutine非常简单,只需在函数调用前加上`go`关键字即可。然而,管理成千上万的goroutine,特别是它们之间的同步和通信,需要更深入的理解和实践,这将在后续章节中详细探讨。

通过本章的学习,读者将对Go并发模型有一个基本的理解,为后面更深入的学习信号量和互斥锁打下坚实的基础。

# 2. 理解信号量机制

### 2.1 信号量的定义与原理

#### 2.1.1 信号量的基本概念

信号量是一个同步原语,用于控制对共享资源的访问。它由荷兰计算机科学家Edsger W. Dijkstra首次提出,广泛应用于操作系统中,特别是在并发程序设计领域。信号量可以被看作是一个计数器,用于记录可供并发进程访问的资源数量。当进程进入临界区时,信号量减1;当进程离开临界区时,信号量加1。

#### 2.1.2 信号量的工作机制

信号量机制通常包含两种操作:P(等待,proberen)和V(释放,verhogen)。P操作会检查信号量的值,如果信号量大于0,则将信号量减1并允许进程进入临界区。如果信号量等于0,则进程被阻塞,直到信号量的值变为正数。V操作将信号量加1,如果有进程被该信号量阻塞,它将被唤醒。

### 2.2 Go中的信号量实现

#### 2.2.1 标准库中的信号量工具

Go语言的标准库中并没有直接提供信号量的实现,但可以通过`sync`包中的`WaitGroup`来间接实现信号量的P/V操作。`WaitGroup`用于等待一组操作的完成,它可以确保信号量的值不会小于0。当信号量需要减少时,可以调用`Wait()`方法,当增加时,可以调用`Done()`方法。当`WaitGroup`的计数器归零时,所有等待的`Wait()`方法会返回。

#### 2.2.2 自定义信号量的实现

在Go中,可以通过创建一个结构体来封装信号量的计数器,并提供P和V操作的接口。下面是一个简单的自定义信号量的实现示例:

```go

type Semaphore struct {

counter int

mu sync.Mutex

}

func NewSemaphore(value int) *Semaphore {

return &Semaphore{counter: value}

}

func (s *Semaphore) P() {

s.mu.Lock()

defer s.mu.Unlock()

for s.counter <= 0 {

// 信号量值为0时,阻塞等待

}

s.counter--

}

func (s *Semaphore) V() {

s.mu.Lock()

defer s.mu.Unlock()

s.counter++

// 释放资源后,唤醒等待该信号量的goroutine

}

```

### 2.3 信号量在Go并发控制中的应用案例

#### 2.3.1 限制并发请求的场景分析

在高并发场景下,如网络服务请求的处理,常常需要限制同时进行的请求数量以避免系统过载。通过信号量可以控制同时执行的goroutine数量,保证系统资源不会因为并发度过高而耗尽。

#### 2.3.2 实际代码示例与解释

以下是一个使用自定义信号量来限制并发处理HTTP请求的例子:

```go

func fetchUrl(url string, sem *Semaphore) {

sem.P() // 请求信号量

defer sem.V() // 处理完成释放信号量

resp, err := http.Get(url)

if err != nil {

// 处理错误

}

defer resp.Body.Close()

// 处理响应内容...

}

func main() {

sem := NewSemaphore(10) // 同时只允许10个并发请求

urls := []string{"***", "***", ...}

var wg sync.WaitGroup

for _, url := range urls {

wg.Add(1)

go func(u string) {

defer wg.Done()

fetchUrl(u, &sem)

}(url)

}

wg.Wait() // 等待所有goroutine完成

}

```

在这个代码中,`semaphore`限制了同时进行的goroutine数量,而`WaitGroup`用于确保所有goroutine完成后主线程才退出。通过信号量限制并发请求的数量,可以有效地控制系统资源的使用,避免过载。

# 3. 掌握互斥锁的使用

互斥锁是并发编程中用于确保线程安全的重要工具。它能够帮助我们解决多个goroutine同时访问临界区时出现的竞态条件问题。通过互斥锁,可以保证在任何时刻,只有一个goroutine能够执行某个特定的代码段,从而避免数据不一致和资源竞争问题。

## 3.1 互斥锁的概念与特点

### 3.1.1 互斥锁的定义

互斥锁(Mutex)是一种同步机制,用于控制多个goroutine对共享资源的互斥访问。在Go语言中,互斥锁是在`sync`标准库包中的`Mutex`结构体实现的。使用互斥锁可以保护代码段,在同一时间只允许一个goroutine进入该段代码,从而实现对共享资源的安全访问。

### 3.1.2 互斥锁与竞态条件

竞态条件发生在多个goroutine并发访问和修改共享资源时,导致资源的状态处于不确定状态。互斥锁通过锁定和解锁机制,确保同一时间只有一个goroutine能够对共享资源进行读写操作,避免了竞态条件的发生。

### 3.1.3 互斥锁的实现

在Go中,互斥锁的实现基于一个简单的二元状态:锁定或未锁定。当一个goroutine想要访问共享资源时,它必须先对互斥锁进行锁定。如果互斥锁已被其他goroutine锁定,那么该goroutine将被阻塞,直到互斥锁被解锁为止。

## 3.2 Go中的互斥锁实现

### 3.2.1 sync.Mutex的使用方法

在Go语言中,使用`sync.Mutex`结构体提供的方法来实现互斥锁。通过调用`Lock()`方法来锁定互斥锁,调用`Unlo

0

0